AI Agent的认知架构与元认知能力构建

随着人工智能技术的飞速发展,AI Agent在各个领域的应用日益广泛。然而,当前的AI Agent大多缺乏真正的认知能力和元认知能力,无法像人类一样灵活地理解和应对复杂的环境。本文的目的在于深入探讨AI Agent的认知架构与元认知能力构建,旨在为开发具有更高智能水平的AI Agent提供理论支持和实践指导。本文的范围涵盖了AI Agent认知架构的基本原理、元认知能力的概念和构建方法,通过数学模

AI Agent的认知架构与元认知能力构建

关键词:AI Agent、认知架构、元认知能力、智能系统、认知计算、机器学习、人工智能

摘要:本文聚焦于AI Agent的认知架构与元认知能力构建。首先介绍了相关背景,包括目的范围、预期读者等。接着阐述了核心概念及其联系,分析了认知架构的原理和架构,以及元认知能力的内涵。详细讲解了核心算法原理,结合Python代码进行说明,并给出了相关数学模型和公式。通过项目实战展示了如何实现AI Agent的认知架构与元认知能力。探讨了其实际应用场景,推荐了学习资源、开发工具框架和相关论文著作。最后总结了未来发展趋势与挑战,解答了常见问题并提供了扩展阅读和参考资料,旨在为深入理解和研究AI Agent的认知架构与元认知能力提供全面且系统的指导。

1. 背景介绍

1.1 目的和范围

随着人工智能技术的飞速发展,AI Agent在各个领域的应用日益广泛。然而,当前的AI Agent大多缺乏真正的认知能力和元认知能力,无法像人类一样灵活地理解和应对复杂的环境。本文的目的在于深入探讨AI Agent的认知架构与元认知能力构建,旨在为开发具有更高智能水平的AI Agent提供理论支持和实践指导。

本文的范围涵盖了AI Agent认知架构的基本原理、元认知能力的概念和构建方法,通过数学模型、算法原理、代码实现等多个方面进行详细阐述,并结合实际应用场景进行分析。同时,提供了相关的学习资源、开发工具和研究论文,以帮助读者全面深入地了解和掌握这一领域的知识。

1.2 预期读者

本文预期读者包括人工智能领域的研究人员、开发者、学生,以及对AI Agent技术感兴趣的专业人士。对于研究人员,本文可以提供新的研究思路和方法;对于开发者,能够帮助他们在实际项目中构建更智能的AI Agent;对于学生,有助于他们系统地学习AI Agent的认知架构和元认知能力相关知识。

1.3 文档结构概述

本文共分为十个部分。第一部分为背景介绍,包括目的范围、预期读者、文档结构概述和术语表;第二部分阐述核心概念与联系,介绍认知架构和元认知能力的原理和架构,并给出相应的示意图和流程图;第三部分讲解核心算法原理和具体操作步骤,结合Python代码进行详细说明;第四部分介绍数学模型和公式,并举例说明;第五部分进行项目实战,包括开发环境搭建、源代码实现和代码解读;第六部分探讨实际应用场景;第七部分推荐学习资源、开发工具框架和相关论文著作;第八部分总结未来发展趋势与挑战;第九部分为附录,解答常见问题;第十部分提供扩展阅读和参考资料。

1.4 术语表

1.4.1 核心术语定义

- AI Agent:人工智能代理,是一种能够感知环境、自主决策并采取行动以实现特定目标的智能实体。

- 认知架构:指AI Agent内部用于处理信息、理解环境和做出决策的组织结构和工作机制。

- 元认知能力:是指AI Agent对自身认知过程的认识和监控能力,包括对自身知识、能力、思维方式的理解和调整。

1.4.2 相关概念解释

- 感知:AI Agent通过传感器获取环境信息的过程。

- 决策:根据感知到的信息和内部的知识,AI Agent选择合适的行动方案的过程。

- 行动:AI Agent根据决策结果对环境产生影响的操作。

1.4.3 缩略词列表

- ML:Machine Learning,机器学习

- DL:Deep Learning,深度学习

- RL:Reinforcement Learning,强化学习

2. 核心概念与联系

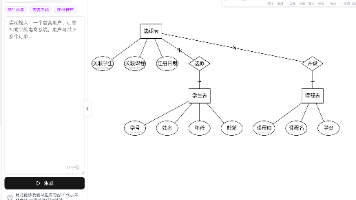

2.1 认知架构原理和架构

认知架构是AI Agent实现智能行为的基础,它决定了AI Agent如何感知环境、处理信息和做出决策。一个典型的认知架构通常包括感知模块、知识表示模块、推理模块和决策模块。

感知模块负责从环境中获取信息,例如图像、声音、文本等。这些信息通过传感器输入到AI Agent中,并经过预处理和特征提取,转化为可用于后续处理的形式。

知识表示模块用于存储和管理AI Agent的知识。知识可以是显式的,如规则、事实等,也可以是隐式的,如神经网络中的权重。知识表示的方式会影响到AI Agent的推理和决策能力。

推理模块根据感知到的信息和存储的知识,进行逻辑推理和问题求解。它可以采用不同的推理方法,如基于规则的推理、基于案例的推理等。

决策模块根据推理结果,选择合适的行动方案。决策过程通常会考虑到目标、约束条件和风险等因素。

下面是认知架构的文本示意图:

+-----------------+

| 感知模块 |

+-----------------+

|

v

+-----------------+

| 知识表示模块 |

+-----------------+

|

v

+-----------------+

| 推理模块 |

+-----------------+

|

v

+-----------------+

| 决策模块 |

+-----------------+

|

v

+-----------------+

| 行动模块 |

+-----------------+

2.2 元认知能力内涵

元认知能力是AI Agent的高级智能特征之一,它使AI Agent能够对自身的认知过程进行反思和调整。元认知能力包括以下几个方面:

- 自我认知:AI Agent能够了解自己的知识、能力和局限性。例如,它可以知道自己在哪些领域有丰富的知识,在哪些方面还需要进一步学习。

- 认知监控:AI Agent能够实时监控自己的认知过程,如推理的准确性、决策的合理性等。当发现问题时,能够及时进行调整。

- 认知调节:根据认知监控的结果,AI Agent能够主动调整自己的认知策略和行为。例如,当发现推理过程出现错误时,它可以尝试采用不同的推理方法。

2.3 认知架构与元认知能力的联系

认知架构为元认知能力的实现提供了基础。元认知能力需要在认知架构的各个模块中进行体现和实现。例如,自我认知可以通过对知识表示模块中的知识进行分析来实现;认知监控可以在推理模块和决策模块中进行实时监测;认知调节可以通过调整推理策略和决策规则来实现。

反之,元认知能力的提升也可以促进认知架构的优化和改进。通过对自身认知过程的反思和调整,AI Agent可以不断完善自己的知识表示、推理方法和决策策略,从而提高整体的智能水平。

2.4 Mermaid流程图

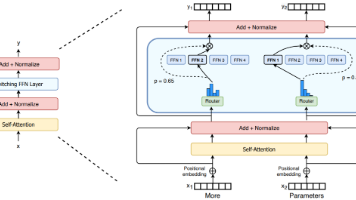

3. 核心算法原理 & 具体操作步骤

3.1 核心算法原理

在构建AI Agent的认知架构和元认知能力时,涉及到多种算法。下面以强化学习算法为例,介绍核心算法原理。

强化学习是一种通过智能体与环境进行交互,以最大化累积奖励的学习方法。智能体在环境中采取行动,环境会根据智能体的行动给出相应的奖励信号。智能体的目标是学习到一个最优的策略,使得在长期的交互过程中获得的累积奖励最大。

强化学习的基本要素包括状态空间 SSS、动作空间 AAA、奖励函数 RRR 和策略 π\piπ。状态空间 SSS 表示环境的所有可能状态;动作空间 AAA 表示智能体可以采取的所有可能动作;奖励函数 RRR 定义了在某个状态下采取某个动作后,环境给予的即时奖励;策略 π\piπ 是一个从状态到动作的映射,表示在每个状态下智能体应该采取的动作。

强化学习的目标是找到一个最优策略 π∗\pi^*π∗,使得累积奖励的期望值最大。常用的强化学习算法有Q-learning、Deep Q-Network (DQN) 等。

3.2 Python代码实现

下面是一个简单的Q-learning算法的Python代码示例:

import numpy as np

# 定义环境参数

num_states = 5

num_actions = 2

gamma = 0.9 # 折扣因子

alpha = 0.1 # 学习率

# 初始化Q表

Q = np.zeros((num_states, num_actions))

# 定义奖励函数

rewards = np.array([[0, 1], [0, 0], [0, 0], [0, 0], [0, 1]])

# Q-learning算法

def q_learning(num_episodes):

for episode in range(num_episodes):

state = 0 # 初始状态

done = False

while not done:

# 选择动作

if np.random.uniform(0, 1) < 0.1: # 探索率

action = np.random.choice(num_actions)

else:

action = np.argmax(Q[state, :])

# 执行动作,获取奖励和下一个状态

next_state = state + 1 if action == 1 else state

reward = rewards[state, action]

# 更新Q表

Q[state, action] = Q[state, action] + alpha * (reward + gamma * np.max(Q[next_state, :]) - Q[state, action])

# 判断是否结束

if next_state == num_states - 1:

done = True

else:

state = next_state

return Q

# 训练模型

Q = q_learning(1000)

print("Final Q table:")

print(Q)

3.3 具体操作步骤

- 定义环境参数:包括状态空间、动作空间、折扣因子和学习率等。

- 初始化Q表:Q表是一个二维数组,用于存储每个状态下每个动作的Q值。

- 定义奖励函数:根据环境的具体情况,定义每个状态下每个动作的奖励。

- Q-learning算法迭代:在每个回合中,智能体根据当前状态选择动作,执行动作并获取奖励和下一个状态,然后更新Q表。

- 训练模型:重复执行多个回合,直到Q表收敛。

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 强化学习的数学模型

强化学习的数学模型可以用马尔可夫决策过程 (Markov Decision Process, MDP) 来描述。一个MDP可以表示为一个五元组 (S,A,P,R,γ)(S, A, P, R, \gamma)(S,A,P,R,γ),其中:

- SSS 是有限的状态集合。

- AAA 是有限的动作集合。

- P:S×A×S→[0,1]P: S \times A \times S \rightarrow [0, 1]P:S×A×S→[0,1] 是状态转移概率函数,表示在状态 sss 下采取动作 aaa 后转移到状态 s′s's′ 的概率。

- R:S×A→RR: S \times A \rightarrow \mathbb{R}R:S×A→R 是奖励函数,表示在状态 sss 下采取动作 aaa 后获得的即时奖励。

- γ∈[0,1]\gamma \in [0, 1]γ∈[0,1] 是折扣因子,用于衡量未来奖励的重要性。

4.2 Q-learning公式

Q-learning算法的核心是更新Q表。Q表中的每个元素 Q(s,a)Q(s, a)Q(s,a) 表示在状态 sss 下采取动作 aaa 的Q值。Q值的更新公式如下:

Q(s,a)←Q(s,a)+α[R(s,a)+γmaxa′Q(s′,a′)−Q(s,a)] Q(s, a) \leftarrow Q(s, a) + \alpha [R(s, a) + \gamma \max_{a'} Q(s', a') - Q(s, a)] Q(s,a)←Q(s,a)+α[R(s,a)+γa′maxQ(s′,a′)−Q(s,a)]

其中:

- α\alphaα 是学习率,控制每次更新的步长。

- R(s,a)R(s, a)R(s,a) 是在状态 sss 下采取动作 aaa 后获得的即时奖励。

- γ\gammaγ 是折扣因子。

- s′s's′ 是采取动作 aaa 后转移到的下一个状态。

- maxa′Q(s′,a′)\max_{a'} Q(s', a')maxa′Q(s′,a′) 表示在下一个状态 s′s's′ 下所有可能动作中最大的Q值。

4.3 举例说明

假设我们有一个简单的迷宫环境,智能体的目标是从起点到达终点。迷宫的状态可以用智能体的位置表示,动作可以是上下左右移动。奖励函数可以定义为:到达终点获得正奖励,撞到墙壁获得负奖励,每走一步获得一个小的负奖励。

在某个状态 sss 下,智能体选择了动作 aaa,并转移到了下一个状态 s′s's′,获得了奖励 R(s,a)R(s, a)R(s,a)。根据Q-learning公式,我们可以更新 Q(s,a)Q(s, a)Q(s,a) 的值。例如,假设当前 Q(s,a)=10Q(s, a) = 10Q(s,a)=10,R(s,a)=5R(s, a) = 5R(s,a)=5,γ=0.9\gamma = 0.9γ=0.9,maxa′Q(s′,a′)=15\max_{a'} Q(s', a') = 15maxa′Q(s′,a′)=15,α=0.1\alpha = 0.1α=0.1,则更新后的 Q(s,a)Q(s, a)Q(s,a) 为:

Q(s,a)←10+0.1[5+0.9×15−10]=10+0.1[5+13.5−10]=10+0.1×8.5=10+0.85=10.85 \begin{align*} Q(s, a) &\leftarrow 10 + 0.1 [5 + 0.9 \times 15 - 10] \\ &= 10 + 0.1 [5 + 13.5 - 10] \\ &= 10 + 0.1 \times 8.5 \\ &= 10 + 0.85 \\ &= 10.85 \end{align*} Q(s,a)←10+0.1[5+0.9×15−10]=10+0.1[5+13.5−10]=10+0.1×8.5=10+0.85=10.85

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

为了实现AI Agent的认知架构和元认知能力,我们需要搭建相应的开发环境。以下是具体步骤:

- 安装Python:建议使用Python 3.7及以上版本。可以从Python官方网站 (https://www.python.org/downloads/) 下载并安装。

- 安装必要的库:我们需要安装一些常用的机器学习和深度学习库,如NumPy、Pandas、TensorFlow、PyTorch等。可以使用pip命令进行安装:

pip install numpy pandas tensorflow torch

- 选择开发工具:可以选择使用Jupyter Notebook、PyCharm等开发工具。Jupyter Notebook适合进行交互式开发和实验,PyCharm适合进行大型项目的开发和调试。

5.2 源代码详细实现和代码解读

下面我们实现一个简单的AI Agent,该Agent具有基本的认知架构和元认知能力。我们以一个简单的问答系统为例。

import numpy as np

# 定义知识表示模块

knowledge_base = {

"苹果": "一种常见的水果,富含维生素C。",

"香蕉": "一种热带水果,富含钾元素。",

"西瓜": "夏季常见的水果,水分含量高。"

}

# 定义感知模块

def perception(input_text):

return input_text

# 定义推理模块

def reasoning(question):

if question in knowledge_base:

answer = knowledge_base[question]

else:

answer = "我不知道。"

return answer

# 定义决策模块

def decision(answer):

return answer

# 定义元认知监控模块

def metacognitive_monitoring(question, answer):

if answer == "我不知道。":

print("元认知监控:当前问题超出知识范围,需要学习。")

return False

else:

return True

# 定义元认知调节模块

def metacognitive_adjustment(question):

# 这里可以实现学习新知识的逻辑,例如调用外部API获取答案

print(f"元认知调节:正在学习关于 {question} 的知识。")

new_knowledge = "新学习到的关于 " + question + " 的知识。"

knowledge_base[question] = new_knowledge

print("元认知调节:知识已更新。")

# 主函数

def main():

while True:

input_text = input("请输入问题(输入q退出):")

if input_text == 'q':

break

question = perception(input_text)

answer = reasoning(question)

response = decision(answer)

print("回答:", response)

is_valid = metacognitive_monitoring(question, answer)

if not is_valid:

metacognitive_adjustment(question)

if __name__ == "__main__":

main()

5.3 代码解读与分析

- 知识表示模块:使用字典

knowledge_base存储知识,每个键表示一个问题,对应的值表示答案。 - 感知模块:

perception函数简单地将输入文本返回,作为感知到的信息。 - 推理模块:

reasoning函数根据输入的问题在知识表示模块中查找答案,如果找到则返回答案,否则返回“我不知道。”。 - 决策模块:

decision函数直接返回推理得到的答案。 - 元认知监控模块:

metacognitive_monitoring函数检查答案是否有效,如果答案为“我不知道。”,则认为当前问题超出知识范围,需要学习。 - 元认知调节模块:

metacognitive_adjustment函数模拟学习新知识的过程,将新学习到的知识添加到知识表示模块中。 - 主函数:通过循环不断接收用户输入的问题,调用各个模块进行处理,并根据元认知监控结果进行调节。

6. 实际应用场景

6.1 智能客服

在智能客服领域,AI Agent可以利用认知架构和元认知能力更好地理解用户的问题,提供准确的答案。当遇到超出知识范围的问题时,元认知能力可以促使AI Agent主动学习新知识,提高服务质量。例如,当用户询问一些专业领域的问题时,AI Agent可以通过元认知调节模块从外部知识库获取相关知识,并及时更新自己的知识表示。

6.2 自动驾驶

在自动驾驶中,AI Agent需要对复杂的交通环境进行感知、推理和决策。认知架构可以帮助AI Agent有效地处理各种传感器数据,做出合理的驾驶决策。元认知能力可以让AI Agent监控自己的决策过程,当发现决策可能存在风险时,及时进行调整。例如,当遇到异常天气或道路状况时,AI Agent可以通过元认知监控发现问题,并调整驾驶策略。

6.3 医疗诊断

在医疗诊断领域,AI Agent可以利用认知架构和元认知能力辅助医生进行诊断。通过对患者的症状、病历等信息进行感知和推理,AI Agent可以提供可能的诊断结果。元认知能力可以让AI Agent对自己的诊断结果进行评估,当发现诊断结果不确定或存在疑问时,主动寻求更多的信息或与其他专家进行交流。

6.4 教育领域

在教育领域,AI Agent可以作为智能辅导系统,帮助学生学习。认知架构可以让AI Agent理解学生的学习情况和问题,提供个性化的学习建议。元认知能力可以让AI Agent监控学生的学习进度和效果,当发现学生学习困难时,调整教学策略和方法。例如,当学生在某个知识点上多次出现错误时,AI Agent可以通过元认知调节模块提供更多的练习和讲解。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《人工智能:一种现代方法》(Artificial Intelligence: A Modern Approach):这是一本经典的人工智能教材,全面介绍了人工智能的各个领域,包括搜索算法、知识表示、推理、机器学习等。

- 《强化学习:原理与Python实现》:详细介绍了强化学习的基本原理和算法,并通过Python代码进行实现和讲解。

- 《深度学习》(Deep Learning):由深度学习领域的三位顶尖专家撰写,系统地介绍了深度学习的理论和实践。

7.1.2 在线课程

- Coursera上的“人工智能基础”课程:由知名教授授课,涵盖了人工智能的基本概念、算法和应用。

- edX上的“强化学习”课程:深入讲解了强化学习的原理和算法,提供了丰富的实践项目。

- 吴恩达的“深度学习专项课程”:在深度学习领域具有很高的声誉,通过视频教程和编程作业帮助学习者掌握深度学习的核心知识。

7.1.3 技术博客和网站

- Medium上的人工智能相关博客:有很多优秀的人工智能博主分享最新的研究成果和实践经验。

- arXiv.org:是一个预印本平台,提供了大量的人工智能研究论文。

- AI开源社区:如GitHub上的人工智能项目,有很多开源的代码和项目可供学习和参考。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm:是一款专业的Python集成开发环境,具有强大的代码编辑、调试和项目管理功能。

- Jupyter Notebook:适合进行交互式开发和实验,支持多种编程语言,方便展示代码和结果。

- Visual Studio Code:是一款轻量级的代码编辑器,支持多种编程语言和插件,具有丰富的扩展功能。

7.2.2 调试和性能分析工具

- TensorBoard:是TensorFlow的可视化工具,可以帮助开发者监控模型的训练过程、可视化模型结构和分析性能指标。

- Py-Spy:是一个Python性能分析工具,可以帮助开发者找出代码中的性能瓶颈。

- PDB:是Python的内置调试器,可以帮助开发者调试代码中的错误。

7.2.3 相关框架和库

- TensorFlow:是一个开源的深度学习框架,提供了丰富的工具和库,支持多种深度学习模型的开发和训练。

- PyTorch:是另一个流行的深度学习框架,具有动态图机制,方便开发者进行模型的快速迭代和调试。

- OpenAI Gym:是一个用于开发和比较强化学习算法的工具包,提供了多种环境和任务供开发者进行实验。

7.3 相关论文著作推荐

7.3.1 经典论文

- “Playing Atari with Deep Reinforcement Learning”:这篇论文提出了Deep Q-Network (DQN) 算法,开启了深度强化学习的时代。

- “Attention Is All You Need”:提出了Transformer架构,在自然语言处理领域取得了巨大的成功。

- “Learning Representations by Back-propagating Errors”:介绍了反向传播算法,是神经网络训练的核心算法之一。

7.3.2 最新研究成果

- 关注NeurIPS、ICML、CVPR等顶级人工智能会议的论文,了解最新的研究动态和成果。

- 阅读顶级学术期刊如Journal of Artificial Intelligence Research (JAIR)、Artificial Intelligence等上的文章。

7.3.3 应用案例分析

- 研究一些知名公司的AI应用案例,如谷歌的AlphaGo、特斯拉的自动驾驶系统等,了解如何将AI技术应用到实际场景中。

8. 总结:未来发展趋势与挑战

8.1 未来发展趋势

- 更加智能化:未来的AI Agent将具有更高的智能水平,能够更好地理解和应对复杂的环境。元认知能力将得到进一步提升,使AI Agent能够更加自主地学习和改进。

- 多模态融合:AI Agent将不仅能够处理单一模态的信息,如文本、图像、声音等,还能够实现多模态信息的融合,从而提供更加全面和准确的服务。

- 跨领域应用:AI Agent将在更多的领域得到应用,如金融、农业、工业等,为各个行业带来变革和创新。

- 人机协作:AI Agent将与人类更加紧密地协作,发挥各自的优势,共同完成复杂的任务。例如,在医疗领域,AI Agent可以辅助医生进行诊断,提高诊断的准确性和效率。

8.2 挑战

- 数据隐私和安全:随着AI Agent的广泛应用,大量的数据被收集和处理,数据隐私和安全问题变得尤为重要。如何保护用户的数据不被泄露和滥用,是一个亟待解决的问题。

- 可解释性:当前的AI Agent大多是基于深度学习模型,这些模型往往是黑盒模型,难以解释其决策过程和结果。在一些关键领域,如医疗、金融等,可解释性是非常重要的,需要开发可解释的AI技术。

- 伦理和法律问题:AI Agent的发展也带来了一系列的伦理和法律问题,如责任归属、算法偏见等。需要建立相应的伦理和法律框架,规范AI Agent的开发和应用。

- 计算资源需求:训练和运行复杂的AI Agent需要大量的计算资源,这对于硬件设备和能源消耗提出了挑战。如何降低计算资源的需求,提高AI Agent的效率,是一个重要的研究方向。

9. 附录:常见问题与解答

9.1 什么是AI Agent的认知架构?

AI Agent的认知架构是指AI Agent内部用于处理信息、理解环境和做出决策的组织结构和工作机制。它通常包括感知模块、知识表示模块、推理模块和决策模块等。

9.2 元认知能力对AI Agent有什么重要性?

元认知能力可以使AI Agent对自身的认知过程进行反思和调整,提高其智能水平和适应性。具体来说,元认知能力可以帮助AI Agent更好地了解自己的知识和能力,监控自己的决策过程,当发现问题时及时进行调整,从而提高决策的准确性和效率。

9.3 如何实现AI Agent的元认知能力?

实现AI Agent的元认知能力可以从以下几个方面入手:

- 自我认知:通过对知识表示模块中的知识进行分析,了解自己的知识范围和能力边界。

- 认知监控:在推理和决策过程中,实时监测自己的认知状态,如推理的准确性、决策的合理性等。

- 认知调节:根据认知监控的结果,主动调整自己的认知策略和行为,如采用不同的推理方法、更新知识表示等。

9.4 AI Agent的认知架构和元认知能力在实际应用中有哪些挑战?

在实际应用中,AI Agent的认知架构和元认知能力面临以下挑战:

- 数据质量和数量:认知架构和元认知能力的实现需要大量高质量的数据,数据的质量和数量会影响到AI Agent的性能。

- 计算资源需求:训练和运行复杂的认知架构和元认知模型需要大量的计算资源,这对于硬件设备和能源消耗提出了挑战。

- 可解释性:当前的AI模型大多是黑盒模型,难以解释其决策过程和结果,在一些关键领域,可解释性是非常重要的。

- 伦理和法律问题:AI Agent的发展也带来了一系列的伦理和法律问题,如责任归属、算法偏见等。

10. 扩展阅读 & 参考资料

10.1 扩展阅读

- 《思考,快与慢》(Thinking, Fast and Slow):这本书介绍了人类的两种思维模式,对于理解AI Agent的认知架构和元认知能力有一定的启发。

- 《超级智能:路线图、危险性与应对策略》(Superintelligence: Paths, Dangers, Strategies):探讨了超级智能AI的发展和影响,对于思考AI Agent的未来发展有重要的参考价值。

10.2 参考资料

- 《人工智能:一种现代方法》(Artificial Intelligence: A Modern Approach)

- “Playing Atari with Deep Reinforcement Learning”

- “Attention Is All You Need”

- “Learning Representations by Back-propagating Errors”

- 相关的学术期刊和会议论文

通过以上内容,我们全面深入地探讨了AI Agent的认知架构与元认知能力构建,从理论原理到实际应用,再到未来发展趋势和挑战,希望能够为读者提供有价值的参考和指导。

更多推荐

已为社区贡献155条内容

已为社区贡献155条内容

所有评论(0)