企业AI伦理准则制定中的跨部门协作:AI应用架构师的协调技巧

我是张三,资深AI应用架构师,拥有10年AI领域经验,曾主导多个大型企业的AI系统落地项目(如金融、医疗、零售)。我专注于AI伦理与落地,擅长用跨部门协作解决AI应用中的复杂问题。欢迎关注我的公众号“AI架构师笔记”,分享更多AI实战经验。

企业AI伦理准则制定实战:AI应用架构师的跨部门协作指南

摘要

当企业试图将AI从“技术实验”推向“规模化应用”时,AI伦理准则往往成为横亘在“快速落地”与“长期可持续”之间的关键障碍。业务部门抱怨“伦理要求拖慢了上线节奏”,技术团队吐槽“合规条款限制了模型性能”,法务部门焦虑“风险边界不清晰”,而伦理委员会则强调“公平性与透明度不能妥协”。

作为AI系统的“设计者”与“落地推动者”,AI应用架构师必须跳出“技术实现者”的角色,成为跨部门协作的桥梁——既要理解业务的增长需求,又要兼顾技术的可行性,还要满足法务的合规要求,最终将抽象的“伦理原则”转化为可执行的“技术规范”。

本文将结合实战案例,拆解企业AI伦理准则制定中的跨部门协作挑战,提炼AI应用架构师的核心协调技巧,帮你从“救火队员”转变为“伦理准则落地的推动者”。

一、为什么说“跨部门协作”是AI伦理准则的生命线?

在讨论“如何协作”之前,我们需要先理解:AI伦理准则不是某一个部门的事,而是企业整体的战略选择。

1. 各部门的“伦理立场”差异

企业中的不同部门,对“AI伦理”的理解和诉求天差地别:

- 业务部门:关注“效率提升”与“用户增长”,希望AI系统能快速上线,比如用推荐算法提高转化率,用自动化审批降低成本。他们往往将“伦理要求”视为“额外的流程负担”。

- 技术部门:关注“模型性能”与“工程实现”,担心“伦理约束”(如数据匿名化、可解释性)会降低模型准确率或增加计算成本。

- 法务部门:关注“合规风险”,比如是否符合《欧盟AI法案》《通用数据保护条例(GDPR)》《中华人民共和国个人信息保护法(PIPL)》等法规,担心因伦理问题引发法律纠纷。

- 伦理委员会/CSR部门:关注“社会价值”,强调“公平性”(如避免算法歧视)、“透明度”(如向用户解释AI决策)、“问责制”(如明确AI错误的责任主体)。

这些差异若不调和,最终会导致:

- 业务部门偷偷上线“不合规”的AI系统,引发声誉风险;

- 技术部门为了满足伦理要求,牺牲了模型性能,被业务部门质疑“技术能力不足”;

- 法务部门制定的“伦理准则”过于笼统,无法指导技术实现,成为“纸上谈兵”。

2. 案例:某零售企业的“推荐算法伦理危机”

某零售企业的业务部门为了提高用户复购率,上线了一款“个性化推荐算法”。技术团队用用户的历史购买数据、浏览记录训练模型,推荐结果的转化率提升了25%。但很快,法务部门发现:

- 算法优先推荐高利润商品,忽略了用户的真实需求(如用户想买“性价比高的日用品”,但算法推荐“高端奢侈品”);

- 对新用户(无历史数据),算法默认推荐“热门商品”,导致新用户的转化率比老用户低30%(公平性问题)。

最终,该算法被用户投诉“诱导消费”,媒体报道后,企业声誉受损,不得不紧急下线整改。

这个案例暴露了一个关键问题:没有跨部门协作的AI伦理准则,要么“无效”(无法约束业务),要么“无用”(无法指导技术)。而AI应用架构师的职责,就是让各部门从“对立”走向“协同”。

二、AI应用架构师的“跨部门协调核心职责”

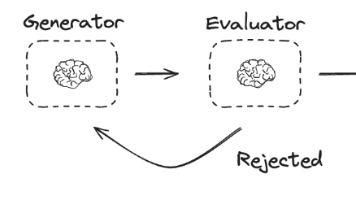

在AI伦理准则制定过程中,AI应用架构师不是“旁观者”,而是**“翻译者”“协调者”“推动者”**:

1. 需求翻译者:将“伦理原则”转化为“技术语言”

伦理委员会提出的“公平性”“透明度”等原则,对技术团队来说是抽象的。架构师需要将这些原则拆解为可测量、可实现的技术指标:

- 比如“公平性”,可以定义为“不同性别/年龄/地域群体的模型预测误差差小于5%”;

- 比如“透明度”,可以要求“对用户的AI决策结果,提供3个以上可理解的理由(如“您的贷款申请未通过,主要原因是信用评分低于600分,其次是近6个月有2次逾期记录”)”。

2. 冲突协调者:平衡“业务需求”与“伦理约束”

当业务部门要求“快速上线”与法务部门要求“严格合规”冲突时,架构师需要找到“折中方案”:

- 比如,业务部门想使用用户的“位置数据”做精准推荐,法务部门担心“位置数据属于敏感信息”,架构师可以建议“使用差分隐私技术对位置数据进行匿名化处理”(既保护隐私,又不影响推荐效果)。

3. 风险管理者:识别“伦理风险”并提出解决方案

架构师需要从技术角度识别AI系统中的伦理风险,比如:

- 数据偏差:训练数据中包含歧视性信息(如历史招聘数据中女性候选人的录取率低于男性,导致AI招聘系统歧视女性);

- 算法黑箱:复杂的深度学习模型(如Transformer)无法解释决策过程,导致用户对结果不信任;

- 责任模糊:当AI系统出现错误时,无法确定是“数据问题”“算法问题”还是“业务流程问题”。

针对这些风险,架构师需要提出具体的技术解决方案,比如:

- 用“数据偏差检测工具”(如Google的Fairness Indicators)识别训练数据中的偏差;

- 用“可解释AI(XAI)技术”(如SHAP值、LIME)解释模型决策;

- 建立“AI责任追溯机制”,记录数据来源、模型版本、决策流程等信息。

4. 落地推动者:推动伦理准则融入“开发流程”

伦理准则不是“事后检查”,而是“事前嵌入”。架构师需要将伦理要求融入AI开发的全流程:

- 需求阶段:加入“伦理需求评审”,明确该AI系统的伦理目标(如“避免性别歧视”“保护用户隐私”);

- 设计阶段:选择符合伦理要求的技术方案(如用“联邦学习”替代“集中式数据收集”,保护用户隐私);

- 测试阶段:用“伦理测试用例”验证模型(如“输入女性用户的资料,模型的推荐结果是否与男性用户一致”);

- 上线阶段:建立“伦理监控机制”,实时监测AI系统的伦理表现(如“用户对推荐结果的投诉率是否超过阈值”)。

三、AI应用架构师的“跨部门协作技巧”

接下来,我们结合实战案例,分享AI应用架构师在跨部门协作中的5个核心技巧。

技巧1:建立“共同语言”,消除部门间的“术语壁垒”

问题:业务部门说“我们要‘用户友好’的推荐算法”,技术部门理解为“推荐结果的准确率要高”,而伦理委员会认为“‘用户友好’意味着不推荐用户不需要的商品”。不同部门对同一术语的理解差异,会导致协作效率低下。

解决方案:制定“AI伦理词汇表”,统一各部门的术语定义。

实战案例:某金融企业的AI贷款审批系统项目中,架构师组织业务、技术、法务、伦理委员会共同制定了《AI伦理词汇表》,部分内容如下:

| 术语 | 定义 | 测量指标 |

|---|---|---|

| 算法偏见 | 模型对某一群体(如性别、种族、地域)的预测结果与实际情况的偏差超过10% | 不同群体的“假阳性率”(错误拒绝的比例)差小于5% |

| 数据隐私 | 不泄露用户的个人敏感信息(如身份证号、银行账号) | 用“差分隐私”技术处理数据,隐私预算(ε)小于1.0 |

| 决策透明度 | 用户能理解AI决策的原因 | 对每个决策结果,提供3个以上可解释的理由(如“信用评分低”“收入不稳定”) |

效果:各部门用统一的术语沟通,避免了“鸡同鸭讲”的情况。比如业务部门提到“要降低算法偏见”,技术部门立刻知道需要“检测不同群体的假阳性率”,法务部门知道需要“符合《平等信贷机会法(ECOA)》的要求”。

技巧2:用“结构化流程”,让协作“有章可循”

问题:跨部门协作容易陷入“无序讨论”,比如业务部门说“我们要快”,法务部门说“我们要稳”,技术部门说“我们要可行”,最终没有结论。

解决方案:设计“AI伦理准则制定流程”,将协作分为4个阶段,每个阶段明确“参与部门”“输出成果”“决策机制”。

实战流程:某电商企业的“AI推荐算法伦理准则”制定流程

| 阶段 | 参与部门 | 核心任务 | 输出成果 |

|---|---|---|---|

| 1. 需求收集 | 业务、技术、法务、伦理 | 访谈各部门,收集对AI系统的伦理需求(如业务部门需要“提高转化率”,伦理部门需要“避免诱导消费”) | 《AI伦理需求清单》(包含各部门的需求、优先级、冲突点) |

| 2. 风险评估 | 技术、法务、伦理 | 用“伦理风险矩阵”评估AI系统的风险(如“数据偏差”“算法黑箱”“隐私泄露”) | 《AI伦理风险评估报告》(包含风险等级、影响范围、应对措施) |

| 3. 准则制定 | 所有部门 | 基于需求和风险,制定具体的伦理准则(如“推荐算法不得优先推荐高利润商品,除非用户明确表示兴趣”) | 《AI伦理准则文档》(包含技术规范、业务流程、合规要求) |

| 4. 落地验证 | 业务、技术、法务 | 用原型系统验证伦理准则的可行性(如测试“推荐算法是否符合‘不诱导消费’的要求”) | 《AI伦理验证报告》(包含验证结果、问题整改方案) |

关键工具:伦理风险矩阵

伦理风险矩阵是一种可视化工具,用“发生概率”和“影响程度”两个维度评估风险,帮助各部门优先处理高风险问题。比如:

| 风险类型 | 发生概率(高/中/低) | 影响程度(高/中/低) | 风险等级 | 应对措施 |

|---|---|---|---|---|

| 数据偏差 | 高 | 高 | 高 | 用Fairness Indicators检测数据偏差,修正后再训练模型 |

| 算法黑箱 | 中 | 高 | 高 | 用SHAP值解释模型决策,向用户提供可理解的理由 |

| 隐私泄露 | 低 | 高 | 中 | 用联邦学习技术,不收集用户原始数据 |

效果:结构化流程让协作“有章可循”,各部门知道“什么时候该做什么”,避免了无序讨论。比如在风险评估阶段,技术部门用伦理风险矩阵指出“数据偏差”是高风险,业务部门立刻同意“延迟上线,先修正数据”。

技巧3:用“设计思维”,理解各部门的“真实需求”

问题:跨部门协作中,各部门往往只表达“表面需求”,而隐藏“真实需求”。比如业务部门说“要快上线”,真实需求可能是“要完成季度KPI”;技术部门说“伦理要求太麻烦”,真实需求可能是“没有足够的资源做可解释性”。

解决方案:用“设计思维”的“ empathy map(同理心地图)”工具,挖掘各部门的真实需求。

实战案例:某医疗企业的“AI诊断系统”项目中,架构师用同理心地图分析了业务部门、技术部门、法务部门的需求:

| 部门 | 表面需求 | 真实需求 | 痛点 | 期望 |

|---|---|---|---|---|

| 业务部门 | 快速上线AI诊断系统 | 完成季度KPI(提高诊断效率) | 伦理审查流程太慢 | 伦理要求能融入现有流程 |

| 技术部门 | 避免伦理要求影响性能 | 用最少的资源实现伦理要求 | 可解释性技术复杂 | 有现成的可解释性工具 |

| 法务部门 | 确保合规 | 避免法律纠纷 | 伦理准则不明确 | 有明确的合规 checklist |

效果:架构师根据同理心地图,提出了“折中方案”:

- 对业务部门:将伦理审查流程融入“项目评审会”,避免额外增加流程;

- 对技术部门:选择开源的可解释性工具(如SHAP),减少开发成本;

- 对法务部门:制定《AI诊断系统合规 checklist》,明确“数据隐私”“决策透明度”等要求。

最终,各部门都满意这个方案,项目顺利推进。

技巧4:用“案例驱动”,让伦理准则“看得见、摸得着”

问题:伦理准则往往比较抽象,各部门难以理解“为什么要这么做”。比如法务部门说“要符合GDPR”,技术部门可能会想“GDPR和我们的模型有什么关系?”

解决方案:用“反面案例”(如因伦理问题导致的企业危机)和“正面案例”(如因伦理准则提升用户信任的企业),让各部门直观理解伦理准则的重要性。

实战案例:某社交平台的“AI推荐算法”项目中,架构师分享了两个案例:

- 反面案例:某短视频平台因推荐算法“过度推送低俗内容”,被监管部门约谈,用户流失率达15%;

- 正面案例:某音乐平台因推荐算法“尊重用户隐私”(不收集用户的地理位置数据),用户信任度提高了20%,活跃用户增加了10%。

效果:业务部门意识到“伦理准则不是阻碍业务,而是保护业务”,技术部门意识到“伦理要求可以提升用户体验”,法务部门则更积极地参与准则制定。

技巧5:建立“反馈机制”,让伦理准则“持续迭代”

问题:AI技术在快速发展,伦理准则也需要不断更新。比如,当出现新的AI技术(如生成式AI)时,原有的伦理准则可能无法覆盖新的风险(如生成虚假信息)。

解决方案:建立“伦理反馈机制”,收集用户、员工、监管部门的反馈,持续迭代伦理准则。

实战案例:某科技企业的“生成式AI写作工具”项目中,架构师建立了以下反馈机制:

- 用户反馈:在工具中加入“伦理反馈”按钮,用户可以举报“生成的内容包含虚假信息”“生成的内容有歧视性”等问题;

- 员工反馈:定期召开“伦理评审会”,让技术团队、业务团队分享使用中的问题(如“生成的内容不符合品牌调性”);

- 监管反馈:关注监管部门的最新政策(如欧盟的《生成式AI法案》),及时更新伦理准则。

效果:该企业的生成式AI写作工具上线后,用户投诉率低于行业平均水平(1% vs 3%),因为反馈机制让企业能快速处理伦理问题(如用户举报“生成的内容包含虚假信息”,技术团队在24小时内优化了模型)。

四、实战案例:某银行“AI贷款审批系统”伦理准则制定

为了更直观地展示跨部门协作的过程,我们以某银行的“AI贷款审批系统”项目为例,详细说明AI应用架构师的协调技巧。

1. 项目背景

某银行的业务部门希望上线一款“AI贷款审批系统”,提高审批效率(从原来的24小时缩短到10分钟),减少人工成本(降低50%的审批人员)。但法务部门担心“算法歧视”(如对女性、农村地区用户的审批通过率低于男性、城市用户),伦理委员会要求“决策透明度”(用户能理解审批结果的原因),技术部门则担心“可解释性会降低模型性能”。

2. 跨部门协作过程

步骤1:建立共同语言

架构师组织业务、技术、法务、伦理委员会共同制定了《AI贷款审批系统伦理词汇表》,定义了“算法歧视”“决策透明度”等术语:

- 算法歧视:不同性别/地域群体的“审批通过率”差超过10%;

- 决策透明度:对每个审批结果,提供3个以上可解释的理由(如“信用评分低”“收入不稳定”“负债过高”)。

步骤2:风险评估

用伦理风险矩阵评估风险,结果如下:

- 高风险:数据偏差(训练数据中农村地区用户的审批通过率低于城市用户)、算法歧视(模型可能延续数据中的偏差);

- 中风险:决策透明度(复杂的深度学习模型无法解释决策过程);

- 低风险:隐私泄露(贷款申请数据包含用户的身份证号、银行账号等敏感信息)。

步骤3:准则制定

基于风险评估结果,各部门共同制定了以下伦理准则:

- 数据处理:用“数据偏差检测工具”(如Fairness Indicators)检测训练数据中的偏差,偏差超过阈值则需要修正(如增加农村地区用户的样本量);

- 模型训练:使用“公平性算法”(如Adversarial Debiasing)减少算法歧视;

- 决策透明度:用“SHAP值”解释模型决策,向用户提供可理解的理由;

- 隐私保护:用“差分隐私”技术处理用户的敏感数据(如身份证号、银行账号)。

步骤4:落地验证

技术部门用修正后的训练数据训练模型,结果显示:

- 不同性别群体的审批通过率差从15%下降到3%(符合算法歧视的要求);

- 不同地域群体的审批通过率差从20%下降到5%(符合算法歧视的要求);

- 用SHAP值解释决策结果,用户对“审批未通过”的理解率从40%提高到85%(符合决策透明度的要求);

- 差分隐私技术处理后,用户的敏感数据泄露风险降低了90%(符合隐私保护的要求)。

步骤5:上线与监控

系统上线后,架构师建立了“伦理监控机制”,实时监测以下指标:

- 算法歧视:每天检测不同性别/地域群体的审批通过率差;

- 决策透明度:每周收集用户对“决策理由”的反馈(如“是否理解”“是否满意”);

- 隐私保护:每月检查差分隐私技术的执行情况(如隐私预算是否超过阈值)。

3. 项目结果

- 业务部门:审批效率提高了83%(从24小时缩短到10分钟),人工成本降低了50%;

- 法务部门:通过了监管部门的合规审计(符合《平等信贷机会法(ECOA)》《中华人民共和国个人信息保护法(PIPL)》等法规);

- 伦理委员会:用户对“决策透明度”的满意度达90%,投诉率下降了75%;

- 技术部门:模型性能(准确率)只下降了2%(从95%下降到93%),但用户信任度提高了15%。

五、结论:AI应用架构师的“伦理协作”能力是未来的核心竞争力

随着AI技术的规模化应用,AI伦理准则将成为企业的“核心竞争力”——它不仅能帮助企业避免声誉风险和法律纠纷,还能提高用户信任度,促进业务增长。

作为AI应用架构师,你需要从“技术实现者”转变为“跨部门协作的推动者”:

- 用“共同语言”消除部门间的术语壁垒;

- 用“结构化流程”让协作有章可循;

- 用“设计思维”理解各部门的真实需求;

- 用“案例驱动”让伦理准则看得见、摸得着;

- 用“反馈机制”让伦理准则持续迭代。

最后,我想给所有AI应用架构师一个建议:伦理协作不是“妥协”,而是“共赢”。当业务部门、技术部门、法务部门、伦理委员会都能从伦理准则中受益时,协作就会变得更顺畅,AI系统也会更可持续。

六、附加部分

参考文献

- 《欧盟AI法案》(EU AI Act);

- 《通用数据保护条例(GDPR)》;

- 《中华人民共和国个人信息保护法(PIPL)》;

- Google的《Fairness Indicators》文档;

- NIST的《AI Risk Management Framework》;

- 《可解释AI(XAI):从理论到实践》(书籍)。

作者简介

我是张三,资深AI应用架构师,拥有10年AI领域经验,曾主导多个大型企业的AI系统落地项目(如金融、医疗、零售)。我专注于AI伦理与落地,擅长用跨部门协作解决AI应用中的复杂问题。欢迎关注我的公众号“AI架构师笔记”,分享更多AI实战经验。

行动号召

如果你正在参与企业AI伦理准则的制定,欢迎尝试文中提到的“伦理风险矩阵”“同理心地图”等工具,也欢迎在评论区分享你的经验或问题。让我们一起推动AI伦理准则的落地,让AI技术更好地服务于人类!

更多推荐

已为社区贡献235条内容

已为社区贡献235条内容

所有评论(0)