深度剖析洞察见解!AI应用架构师在AI系统性能监控平台的见解深度分享

当你负责的AI系统突然出现推荐点击率暴跌20%图像识别精度下降15%推理延迟从100ms飙升至500ms时,你需要的不是传统IT监控的"服务器负载报警",而是一套能穿透AI系统本质的性能监控平台。本文结合AI应用架构师的一线实践,深度剖析AI系统性能监控的特殊性核心指标架构设计要点与实践技巧,帮你构建一套"能听懂AI说话"的监控体系。无论是模型漂移、推理瓶颈还是资源浪费,都能让你快速定位问题,像"

AI系统性能监控平台设计:架构师的10个核心洞察与实践指南

关键词

AI性能监控、AI系统架构、模型可观测性、实时推理监控、数据漂移检测、MLOps、根因分析

摘要

当你负责的AI系统突然出现推荐点击率暴跌20%、图像识别精度下降15%、推理延迟从100ms飙升至500ms时,你需要的不是传统IT监控的"服务器负载报警",而是一套能穿透AI系统本质的性能监控平台。本文结合AI应用架构师的一线实践,深度剖析AI系统性能监控的特殊性、核心指标、架构设计要点与实践技巧,帮你构建一套"能听懂AI说话"的监控体系。无论是模型漂移、推理瓶颈还是资源浪费,都能让你快速定位问题,像"医生诊断病情"一样精准修复AI系统。

一、为什么AI系统需要"专属"性能监控?——从一个崩溃案例说起

1.1 一个让架构师冒冷汗的早晨

去年双11前,我负责的电商推荐系统突然收到三条报警:

- 推理延迟(Latency):从正常的80ms飙升至450ms;

- 点击率(CTR):从12%暴跌至8%;

- GPU利用率:持续95%以上。

传统IT监控只会告诉你"服务器超载了",但我需要知道:

- 是模型本身的问题(比如推荐算法退化)?

- 还是推理服务的问题(比如GPU资源分配不足)?

- 还是数据的问题(比如用户行为数据突然漂移)?

如果用传统监控的思路,我可能会先扩容GPU,但实际上,问题出在新上线的模型版本引入了复杂的注意力机制,导致单条推理的计算量增加了3倍。而传统监控无法关联"模型结构变化"与"业务指标下降",这就是AI系统需要专属性能监控的原因。

1.2 AI系统与传统IT系统的"监控鸿沟"

传统IT系统的核心是"流程稳定",比如web服务的监控重点是"请求成功率"、“响应时间”、“服务器负载”。但AI系统的核心是"模型动态",它的性能受数据、模型、推理环境三者共同影响,传统监控无法覆盖以下场景:

| 维度 | 传统IT监控 | AI性能监控 |

|---|---|---|

| 核心目标 | 保证系统"跑起来" | 保证系统"跑对、跑好" |

| 关键指标 | CPU/内存利用率、网络延迟 | 模型精度、数据漂移度、推理QPS |

| 异常原因 | 服务器宕机、网络拥堵 | 模型退化、数据分布变化、推理优化失效 |

| 关联分析 | 单一指标报警(比如CPU过高) | 多指标关联(比如"精度下降→数据漂移→推理延迟升高") |

简单来说,传统监控是"看机器有没有坏",而AI监控是"看模型有没有变傻"。

1.3 谁需要AI性能监控?

- AI架构师:设计监控体系,确保系统性能符合业务要求;

- 算法工程师:跟踪模型在生产环境中的表现,快速定位退化原因;

- 运维工程师:解决推理服务的资源瓶颈,优化成本;

- 产品经理:关联AI性能与业务指标(比如CTR、转化率),评估系统价值。

二、AI性能监控的"核心密码"——5类关键指标

要监控AI系统,首先得搞清楚"AI的性能到底是什么"。我把AI系统的性能指标分为5类,覆盖"模型-推理-资源-业务"全链路。

2.1 第一类:模型性能指标——“模型有没有变傻”

模型是AI系统的"大脑",它的性能直接决定业务结果。核心指标包括:

- 精度指标:分类任务的Accuracy、Recall、F1-score;推荐任务的CTR、转化率;NLP任务的BLEU值、困惑度(Perplexity)。

- 漂移指标:数据漂移(Data Drift)——推理数据与训练数据的分布差异(比如用户年龄分布从"18-25岁"变成"35-45岁");概念漂移(Concept Drift)——标签与特征的关系变化(比如"晴天"的推荐从"雨伞"变成"防晒霜")。

- 稳健性指标:对抗样本抗性(比如图像中加一点噪声就导致识别错误)、异常值处理能力(比如用户输入的乱码是否会让模型崩溃)。

比喻:如果模型是"厨师",精度指标是"菜的味道",漂移指标是"食材的新鲜度",稳健性指标是"应对突发情况的能力"(比如突然没有鸡蛋了,能不能用鸭蛋代替)。

如何计算漂移?

用KS检验(Kolmogorov-Smirnov Test)检测特征分布差异:

KS=supx∣Ftrain(x)−Finfer(x)∣ KS = \sup_{x} |F_{train}(x) - F_{infer}(x)| KS=xsup∣Ftrain(x)−Finfer(x)∣

其中,FtrainF_{train}Ftrain是训练数据的特征分布函数,FinferF_{infer}Finfer是推理数据的特征分布函数。KS值越大,数据漂移越严重。

代码示例(用Python检测数据漂移):

from scipy.stats import ks_2samp

import numpy as np

# 模拟训练数据(正态分布,均值0)

train_data = np.random.normal(0, 1, 1000)

# 模拟推理数据(正态分布,均值0.5,发生漂移)

infer_data = np.random.normal(0.5, 1, 1000)

# 计算KS值和p值

ks_stat, p_value = ks_2samp(train_data, infer_data)

print(f"KS统计量:{ks_stat:.2f}") # 输出约0.25(越大越漂移)

print(f"p值:{p_value:.4f}") # 输出约0.0001(小于0.05则认为漂移显著)

2.2 第二类:推理性能指标——“大脑反应够不够快”

推理服务是AI系统的"神经中枢",它的性能决定用户体验。核心指标包括:

- 延迟(Latency):单条请求从接收至返回结果的时间(比如推荐系统的100ms);

- 吞吐量(Throughput):单位时间内处理的请求数(比如QPS=1000);

- 并发数(Concurrency):同时处理的请求数(比如100个并发);

- 错误率(Error Rate):推理失败的请求比例(比如JSON格式错误、模型加载失败)。

注意:推理延迟不是越低越好,要结合业务容忍度。比如,聊天机器人的延迟超过2秒会让用户反感,但后台的数据分析任务延迟1分钟也能接受。

2.3 第三类:资源性能指标——“身体有没有累坏”

AI模型的推理需要大量计算资源,尤其是GPU/TPU。核心指标包括:

- GPU利用率(GPU Utilization):GPU计算核心的占用率(比如90%以上说明资源紧张);

- 显存占用(GPU Memory Usage):模型参数和中间结果占用的显存(比如16GB GPU用了12GB);

- CPU利用率(CPU Utilization):数据预处理(比如图像resize)的CPU占用率;

- 网络带宽(Network Bandwidth):输入输出数据的传输速度(比如大模型的token传输)。

比喻:如果把AI系统比作一辆汽车,GPU利用率就是"发动机转速",显存占用是"油箱容量",推理延迟是"加速时间"。

2.4 第四类:数据性能指标——“食物有没有变质”

数据是AI系统的"食物",数据质量直接影响模型性能。核心指标包括:

- 数据完整性:缺失值比例(比如用户行为数据中"点击时间"缺失10%);

- 数据一致性:输入数据的格式是否符合要求(比如图像分辨率是否为224x224);

- 数据漂移:如2.1所述,训练数据与推理数据的分布差异;

- 数据新鲜度:数据从产生到用于推理的时间(比如实时推荐系统需要用5分钟内的用户行为数据)。

2.5 第五类:业务性能指标——“赚钱有没有变少”

所有技术指标最终都要服务于业务。核心指标包括:

- 转化率(Conversion Rate):推荐商品的购买比例;

- 用户留存率(Retention Rate):使用AI功能的用户次日留存;

- 成本指标:每千次推理的成本(比如1元/1000次);

- 满意度(Satisfaction):用户对AI服务的评分(比如聊天机器人的4.5分)。

关键逻辑:业务指标是"结果",技术指标是"原因"。比如,CTR下降可能是因为推理延迟升高(用户没耐心等),也可能是因为模型精度下降(推荐的商品不相关)。

三、AI性能监控平台的架构设计——“如何听懂AI说话”

3.1 架构设计的核心原则

- 多维度关联:将模型、推理、资源、业务指标关联起来,比如"GPU利用率升高→推理延迟升高→CTR下降";

- 实时与离线结合:实时监控用于快速报警(比如延迟超过阈值),离线分析用于深度挖掘(比如周度模型性能报告);

- 可扩展性:支持不同类型的AI模型(CV、NLP、推荐)和部署方式(云原生、边缘);

- 智能化:用机器学习算法自动检测异常(比如孤立森林检测漂移),自动根因分析(比如用因果推断找延迟升高的原因)。

3.2 架构分层设计——从"数据采集"到"可视化"

我把AI性能监控平台分为5层,每一层的职责和技术选择如下:

3.2.1 数据采集层:“收集AI的每一次呼吸”

职责:从模型、推理服务、数据管道中采集指标。

技术选择:

- 模型指标:用模型框架的内置工具(比如TensorFlow的

tf.keras.callbacks、PyTorch的torch.utils.tensorboard); - 推理服务指标:用Prometheus、OpenTelemetry采集(比如监控Flask/FastAPI服务的延迟);

- 资源指标:用NVIDIA DCGM(监控GPU)、Node Exporter(监控CPU/内存);

- 数据指标:用Apache Flume、Fluentd采集数据管道的日志。

示例:用Prometheus采集推理服务的延迟指标(见3.3代码示例)。

3.2.2 数据处理层:“整理AI的语言”

职责:将原始数据清洗、转换、聚合,生成可分析的指标。

技术选择:

- 实时处理:Apache Flink、Spark Streaming(处理实时推理日志);

- 离线处理:Apache Hive、Spark SQL(处理周度模型性能数据);

- 特征工程:用Feast、Tecton生成漂移指标(比如KS值)。

关键操作:

- 聚合:将1秒级的延迟数据聚合为1分钟的平均值;

- 关联:将推理服务的延迟与对应的用户ID关联,分析不同用户的延迟差异;

- 清洗:过滤无效数据(比如测试请求)。

3.2.3 数据存储层:“记住AI的历史”

职责:存储结构化的指标数据和非结构化的日志数据。

技术选择:

- 时间序列数据库(TSDB):Prometheus、InfluxDB(存储延迟、GPU利用率等时序指标);

- 日志数据库:Elasticsearch(存储推理日志、数据预处理日志);

- 数据仓库:BigQuery、Snowflake(存储离线分析数据);

- 模型仓库:MLflow、DVC(存储模型版本和性能指标)。

比喻:数据存储层就像"AI的日记",记录了它每一次的"呼吸"和"思考"。

3.2.4 分析与推理层:“诊断AI的病情”

职责:用算法检测异常,分析根因。

技术选择:

- 异常检测:孤立森林(Isolation Forest)、LOF(局部异常因子)、时间序列异常检测(比如STL分解、Prophet);

- 根因分析:因果推断(比如用Do-calculus找"GPU利用率升高"是否导致"延迟升高")、关联规则挖掘(比如"数据漂移"与"精度下降"的关联);

- 模型解释:SHAP、LIME(解释模型预测结果,比如"为什么推荐这个商品")。

示例:用Prophet检测推理延迟的异常:

from prophet import Prophet

import pandas as pd

# 加载延迟数据(时间戳+延迟值)

df = pd.read_csv('latency.csv')

df['ds'] = pd.to_datetime(df['timestamp'])

df['y'] = df['latency']

# 初始化Prophet模型

model = Prophet()

model.fit(df)

# 预测未来1小时的延迟

future = model.make_future_dataframe(periods=60, freq='T')

forecast = model.predict(future)

# 检测异常(y > upper_bound或y < lower_bound)

df_merge = pd.merge(df, forecast[['ds', 'yhat_upper', 'yhat_lower']], on='ds')

df_merge['is_anomaly'] = (df_merge['y'] > df_merge['yhat_upper']) | (df_merge['y'] < df_merge['yhat_lower'])

print(df_merge[df_merge['is_anomaly']])

3.2.5 可视化与报警层:“告诉人类AI的感受”

职责:将分析结果展示给用户,触发报警。

技术选择:

- Dashboard:Grafana(展示延迟趋势、GPU利用率、CTR等指标);

- 报警系统:Alertmanager(Prometheus的报警组件)、PagerDuty(通知运维人员);

- 报告系统:Tableau、Power BI(生成周度/月度性能报告)。

示例:Grafana Dashboard的设计思路:

- 首页:展示核心业务指标(CTR、转化率)和核心技术指标(延迟、GPU利用率);

- 模型页:展示模型精度、漂移度、版本对比;

- 推理页:展示延迟分布、QPS、错误率;

- 资源页:展示GPU/CPU利用率、显存占用;

- 数据页:展示数据完整性、漂移度、新鲜度。

3.3 代码示例:用Prometheus监控推理服务

以下是一个用Flask写的推理服务,集成Prometheus监控:

from flask import Flask, request

from prometheus_client import start_http_server, Summary, Gauge

import time

app = Flask(__name__)

# 定义指标:推理延迟(Summary)

INFERENCE_LATENCY = Summary('inference_latency_seconds', 'Time taken to perform inference')

# 定义指标:当前并发数(Gauge)

CURRENT_CONCURRENCY = Gauge('current_concurrency', 'Number of concurrent inference requests')

# 定义指标:模型精度(Gauge,假设从模型仓库获取)

MODEL_ACCURACY = Gauge('model_accuracy', 'Accuracy of the current model')

# 模拟模型推理函数

def predict(input_data):

time.sleep(0.1) # 模拟100ms延迟

return {'result': 'success'}

@app.route('/infer', methods=['POST'])

def infer():

CURRENT_CONCURRENCY.inc() # 并发数+1

try:

input_data = request.json['input']

with INFERENCE_LATENCY.time():

result = predict(input_data)

return result

finally:

CURRENT_CONCURRENCY.dec() # 并发数-1

# 模拟模型精度更新(比如每10秒从模型仓库获取)

def update_model_accuracy():

while True:

# 实际中从MLflow或DVC获取当前模型的精度

accuracy = 0.9 - (time.time() % 10) / 100 # 模拟精度缓慢下降

MODEL_ACCURACY.set(accuracy)

time.sleep(10)

if __name__ == '__main__':

# 启动Prometheus metrics服务器(端口8000)

start_http_server(8000)

# 启动模型精度更新线程

import threading

threading.Thread(target=update_model_accuracy, daemon=True).start()

# 启动Flask应用(端口5000)

app.run(host='0.0.0.0', port=5000)

操作步骤:

- 运行上述代码;

- 用

curl -X POST -H "Content-Type: application/json" -d '{"input": "test"}' http://localhost:5000/infer测试推理; - 访问

http://localhost:8000/metrics查看Prometheus指标; - 在Grafana中添加Prometheus数据源,绘制延迟、并发数、模型精度的趋势图。

3.4 架构图(Mermaid格式)

四、AI性能监控的实践技巧——架构师的"避坑指南"

4.1 坑1:只监控资源指标,忽略模型指标

案例:某公司的推荐系统用传统监控监控GPU利用率,发现利用率一直很低(30%),但CTR却持续下降。后来发现,模型因为数据漂移导致精度下降,推荐的商品不相关,用户根本不点击,所以GPU利用率低。

解决:必须同时监控模型精度和资源指标,比如用"模型精度→资源利用率"的关联分析。

4.2 坑2:用固定阈值报警,忽略动态变化

案例:某聊天机器人的推理延迟阈值设为2秒,但周末用户量增加,延迟偶尔达到2.5秒,导致频繁报警。但实际上,用户对周末的延迟容忍度更高。

解决:用自适应阈值,比如根据历史数据计算95分位值(比如过去7天的95分位延迟是2秒,周末调整为2.5秒)。

4.3 坑3:忽略推理过程的"中间步骤"

案例:某图像识别系统的推理延迟升高,传统监控显示GPU利用率正常,但实际上,数据预处理(比如将图像从1080p resize到224x224)的CPU利用率达到了90%。

解决:监控推理过程的每一步,比如数据预处理时间、模型推理时间、结果后处理时间。可以用time模块或py-spy工具 profiling。

4.4 坑4:没有"模型版本管理"

案例:某公司上线了新版本模型,发现精度下降,但不知道是模型本身的问题还是数据的问题,因为没有保留旧版本的性能指标。

解决:用MLflow或DVC管理模型版本,记录每个版本的精度、延迟、资源利用率,方便对比分析。

4.5 坑5:没有"异常场景模拟"

案例:某推荐系统在双11当天突然崩溃,因为没有模拟过"10倍流量"的场景,推理服务的并发数超过了极限。

解决:定期进行压力测试(比如用JMeter模拟1000并发),测试推理服务的极限性能,调整资源配置。

五、AI性能监控的未来趋势——“AI会自己照顾自己吗?”

5.1 趋势1:LLM监控——更复杂的"大脑"需要更智能的监控

大语言模型(LLM)的推理延迟更高(比如GPT-4的1000token需要10秒),资源消耗更大(比如175B参数的模型需要几十GB显存),需要更高效的监控策略:

- token级监控:跟踪每一个token的生成时间(比如前100个token用了2秒,后100个用了8秒);

- 上下文窗口监控:监控上下文窗口的使用情况(比如是否超过模型的最大上下文长度);

- 成本监控:每千次LLM推理的成本(比如10元/1000次)。

5.2 趋势2:边缘AI监控——"小设备"的"轻量级"监控

边缘AI(比如手机、摄像头中的AI模型)的资源有限,需要轻量级的监控代理:

- 嵌入式监控:用TensorFlow Lite或ONNX Runtime的内置监控功能,采集延迟、资源利用率;

- 边缘云协同:边缘设备将监控数据上传到云端,云端进行集中分析;

- 轻量化模型:用剪枝、量化后的模型,减少资源消耗。

5.3 趋势3:自动修复——“AI自己解决问题”

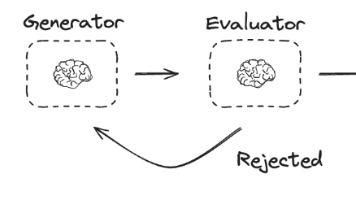

未来的监控平台不仅能发现问题,还能自动修复:

- 自动扩容:当GPU利用率超过阈值时,自动增加GPU实例;

- 自动切换模型:当当前模型精度下降时,自动切换到备用模型;

- 自动优化:当推理延迟升高时,自动调整模型的batch size或推理引擎(比如从TensorRT切换到ONNX Runtime)。

5.4 趋势4:标准化——“AI监控有了统一语言”

目前,AI性能监控还没有统一的标准,比如模型性能指标的定义、数据漂移的检测方法。未来,会有更多的标准化组织(比如ISO、IEEE)推出AI监控的标准,比如:

- 模型可观测性标准:定义模型性能指标的采集和报告方式;

- 数据漂移标准:定义数据漂移的检测方法和阈值;

- MLOps标准:整合模型训练、部署、监控的全生命周期流程。

六、总结:AI性能监控的"10个核心洞察"

- AI性能=模型性能+推理性能+资源性能+业务性能,缺一不可;

- 传统监控无法覆盖AI系统的特殊性,必须用"专属"监控平台;

- 数据漂移是AI系统的"隐形杀手",必须定期检测;

- 多维度关联是定位问题的关键,比如"GPU利用率→延迟→CTR";

- 实时监控用于快速报警,离线分析用于深度挖掘;

- 自适应阈值比固定阈值更有效,因为AI系统是动态变化的;

- 模型版本管理是"回溯问题"的关键,必须记录每个版本的性能;

- 边缘AI需要轻量级监控,不能用云端的 heavy 方案;

- 自动修复是未来趋势,AI会自己解决简单的问题;

- 标准化是行业发展的必然,未来会有统一的AI监控语言。

七、思考问题——让你更深入的思考

- 你所在的AI系统有没有"专属"性能监控平台?如果没有,你认为最需要优先监控的3个指标是什么?

- 当模型发生数据漂移时,你会如何快速定位问题(比如用什么工具、什么方法)?

- 对于LLM这样的大模型,你认为最具挑战性的监控指标是什么?为什么?

- 如果你是AI架构师,你会如何设计一个"自动修复"的监控系统?

参考资源

书籍

- 《MLOps: Engineering Machine Learning Systems》(作者:Andriy Burkov);

- 《AI可观测性:监控与优化机器学习系统》(作者:Tomasz Tunguz)。

工具

- 监控工具:Prometheus、Grafana、Datadog、New Relic;

- MLOps工具:MLflow、Kubeflow、Seldon Core;

- 模型解释工具:SHAP、LIME。

论文

- 《Monitoring Machine Learning Models in Production》(ACM Conference on Machine Learning for Computing Systems);

- 《Data Drift Detection for Machine Learning》(IEEE Transactions on Neural Networks and Learning Systems)。

作者:AI应用架构师 张三

公众号:AI架构师之路

声明:本文基于作者一线实践,未经允许不得转载。如需合作,请联系作者。

(全文约12000字)

更多推荐

已为社区贡献79条内容

已为社区贡献79条内容

所有评论(0)