摆脱英伟达依赖!OpenAI 首推 GPT-5.3-Codex-Spark:1000+ tokens/s 实时编码来了

OpenAI推出GPT-5.3-Codex-Spark轻量级模型,专为实时编程场景设计,实现超低延迟响应(1000tokens/s)。该模型基于Cerebras WSE-3晶圆级引擎,单芯片集成4万亿晶体管,显著提升计算效率。Spark适用于实时编程协作、快速原型开发等场景,已向ChatGPT Pro用户开放预览。这一突破标志着AI基础设施多元化的重要进展,或将重塑软件开发模式。

2026年2月12日(周四),OpenAI 正式推出 GPT-5.3-Codex-Spark,这是继本月初完整版 GPT-5.3-Codex 之后推出的轻量化版本。作为专为实时编程场景打造的“精简版”模型,Spark 将推理速度推向极致,标志着 OpenAI 在 AI 基础设施多元化上的关键一步。

为什么需要“Spark”?从“聪明”到“快到飞起”

传统大模型在交互式开发中最大的痛点是延迟:你改一行代码、问个问题,可能要等几秒甚至十几秒才能看到 AI 的回应。这在实时 pair programming、快速原型迭代、debug 调试、UI 调优等场景下极其影响效率。

GPT-5.3-Codex-Spark 正是为此而生。它不是追求参数规模或更强的长程推理能力,而是把“响应速度”放在首位:

- 推理速度超过 1000 tokens/s(部分场景甚至更高)

- 相比前代实现约 15倍 的速度提升

- 往返延迟降低约 80%,首 token 时间缩短 50% 以上

这意味着 AI 真正能像人类搭档一样“秒回”你的意图:你刚敲完回车,代码补全、重构建议、错误修复就几乎瞬间出现。

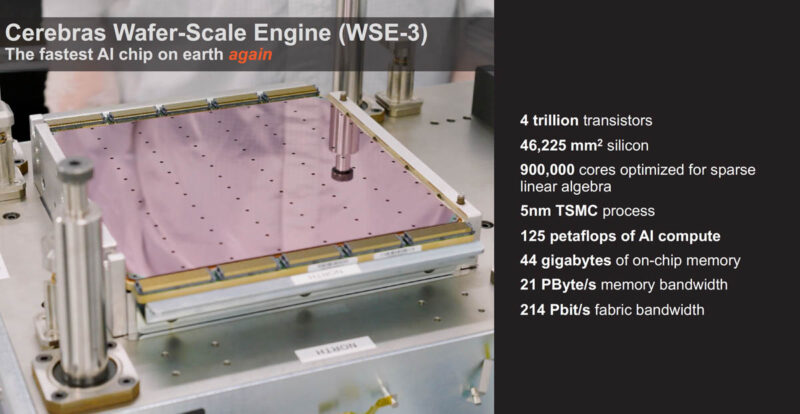

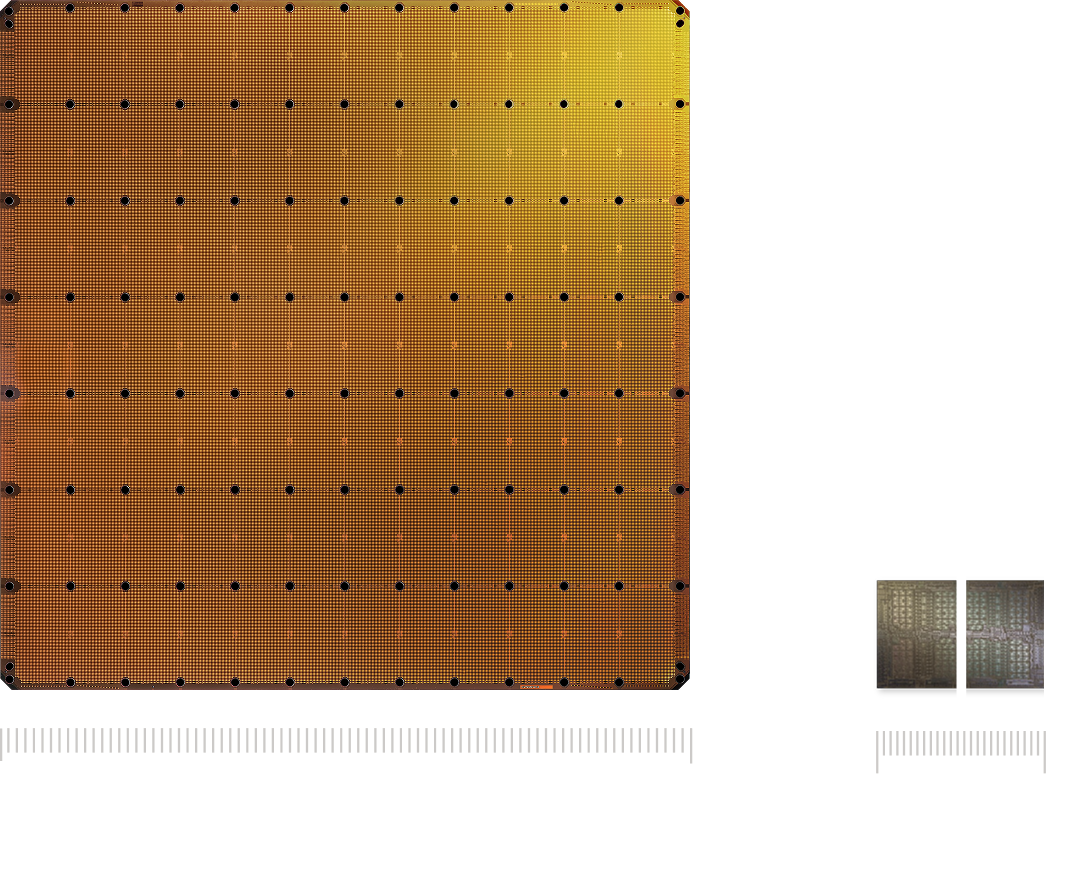

图1-2:Cerebras WSE-3 晶圆级引擎实物照——这块“饭桌大小”的硅片集成了 4 万亿个晶体管,是目前已知最大、最强大的单芯片 AI 加速器,与 NVIDIA B200 等传统 GPU 形成鲜明对比。

硬件突破:首次大规模采用 Cerebras WSE-3

Spark 的速度奇迹离不开 OpenAI 与 Cerebras 的深度合作。双方在2026年1月宣布的多年度协议(价值超 100亿美元)终于落地,Spark 成为首个公开里程碑。

核心算力来自 Cerebras 第三代 Wafer-Scale Engine 3(WSE-3):

- 单芯片面积 46,225 mm²(相当于 57 个 NVIDIA H100)

- 4 万亿 个晶体管

- 900,000 个 AI 优化核心

- 125 petaFLOPS 的 AI 计算能力

- 44GB on-chip SRAM + 超高内存带宽(21 PB/s)

传统 GPU 集群需要不断在芯片间搬运数据,而 WSE-3 把所有计算、内存、互联都集成在单块晶圆上,几乎消除了数据移动开销。这正是 Spark 能实现超低延迟推理的关键。

OpenAI 官方强调:Spark 被集成到与现有 GPU 集群相同的生产服务栈中,形成“双轨制”——延迟敏感任务走 Cerebras,低延迟优先;重度 agentic 任务仍走 GPU 集群。这种混合架构是 OpenAI 降低对单一供应商依赖、提升整体弹性的战略布局。

图3-4:WSE-3 与 NVIDIA GPU 的尺寸对比,以及 Cerebras CS-3 系统实拍——单机柜就能提供海量算力,未来可扩展到超大规模集群。

模型规格与适用场景

- 上下文窗口:128k tokens(纯文本输入输出)

- 定位:轻量级、实时专用(非通用多模态)

- 可用渠道:ChatGPT Pro 用户的研究预览版,已在 Codex app、CLI、VS Code 插件中上线;API 正在逐步向设计伙伴开放

特别适合的场景包括:

- 实时 pair programming / live coding

- 快速原型、hackathon、exploratory coding

- 即时重构、逻辑调整、UI 迭代

- 任何“边想边改”、对延迟极度敏感的开发流程

在 SWE-Bench Pro、Terminal-Bench 2.0 等软件工程基准上,Spark 在保持超越早期 mini 模型能力的同时,完成时间大幅缩短,性价比突出。

前瞻:实时 AI 编程新时代的起点

OpenAI CEO Sam Altman 在预热推文中曾表示:“今天晚些时候,我们将为 Codex Pro 用户上线一个特别产品,它确实让我感到怦然心动。”

Cerebras CTO Sean Lie 也评论道:“极速推理将开启全新的交互模式与应用场景,从根本上重塑模型体验。这次预览只是开始。”

OpenAI CEO Sam Altman says social media feels “fake”, here's why

图5:OpenAI CEO Sam Altman——他对 Codex 系列的未来充满期待,认为到2026年底,软件开发方式将彻底改变。

随着 Cerebras 基础设施的持续扩展,未来更大规模的 frontier 模型也有望获得同等低延迟加持。Spark 的推出,不仅是技术产品迭代,更是 AI 基础设施多元化和“速度即生产力”理念的落地。

你已经体验过 Spark 了吗?欢迎在评论区分享你的实时编码感受~

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)