AI行业应用全景:从金融风控到智能制造的技术落地与实践案例

人工智能正深度赋能金融、医疗、教育、制造等核心领域,通过技术重构行业流程。金融领域,AI风控系统将审批时间从72小时缩短至90秒,坏账率降低3.1个百分点;医疗方面,肺结节AI检测敏感度达96.8%,药物研发周期缩短90%;教育领域自适应学习系统提升学习效率40%;制造业预测性维护减少停机时间50%。成功的AI落地项目具备四大特征:明确业务目标、高质量数据基础、人机协同模式和持续迭代机制。

人工智能已从实验室走向产业纵深,在金融、医疗、教育、制造业等关键领域展现出变革性力量。本文通过12个标杆案例、8段核心代码、6幅流程图和4组对比数据,系统剖析AI技术如何解决行业痛点。从毫秒级金融风控决策到AI辅助的肿瘤筛查,从个性化学习路径规划到智能工厂的预测性维护,这些落地实践揭示了一个真相:AI的价值不在于技术本身,而在于它如何重构行业流程、优化资源配置并创造新的商业范式。

金融领域:从风险控制到智能投顾

金融行业是AI技术落地最深的领域之一,其数据密集型特性与AI的优势高度契合。根据德勤《2025年金融科技趋势报告》,全球Top50银行中已有89%部署了AI风控系统,平均降低信贷损失率37%。

智能信贷风控系统

核心痛点:传统风控依赖人工审核,存在效率低(平均3天放款周期)、准确率有限(坏账率约5.2%)、覆盖不足(约23%成年人缺乏信用记录)等问题。

技术方案:基于XGBoost和LSTM的融合模型,整合多维度数据(交易记录、行为数据、社交关系、设备指纹)构建动态信用评估体系。

实现代码:

import xgboost as xgb from sklearn.model_selection import train_test_split from sklearn.metrics import roc_auc_score, confusion_matrix import pandas as pd import numpy as np # 1. 数据预处理(特征工程) def create_features(df): # 时间特征:贷款申请时间中的周期性模式 df['apply_hour'] = pd.to_datetime(df['apply_time']).dt.hour df['is_weekend'] = pd.to_datetime(df['apply_time']).dt.weekday >= 5 # 行为特征:最近3个月交易频率和金额波动率 df['transaction_freq_3m'] = df.groupby('user_id')['transaction_amt'].transform( lambda x: x[-90:].count()) df['amt_volatility_3m'] = df.groupby('user_id')['transaction_amt'].transform( lambda x: x[-90:].std() / (x[-90:].mean() + 1e-8)) # 社交关系特征:关联账户逾期率 df['related_overdue_rate'] = df['related_users_count'] / (df['overdue_related_users'] + 1e-8) return df # 2. 模型训练与优化 def train_risk_model(data_path): # 加载数据 df = pd.read_csv(data_path) df = create_features(df) # 特征选择(基于特征重要性和VIF多重共线性检验) features = ['credit_score', 'transaction_freq_3m', 'amt_volatility_3m', 'related_overdue_rate', 'apply_hour', 'is_weekend', 'loan_to_income'] X = df[features] y = df['default_label'] # 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.25, random_state=42) # 训练XGBoost模型(参数通过贝叶斯优化获得) model = xgb.XGBClassifier( n_estimators=200, max_depth=6, learning_rate=0.05, subsample=0.8, colsample_bytree=0.7, scale_pos_weight=sum(y_train==0)/sum(y_train==1), # 处理样本不平衡 objective='binary:logistic', eval_metric='auc' ) model.fit( X_train, y_train, eval_set=[(X_test, y_test)], early_stopping_rounds=20, verbose=10 ) # 模型评估 y_pred_proba = model.predict_proba(X_test)[:,1] auc = roc_auc_score(y_test, y_pred_proba) print(f"模型AUC值: {auc:.4f}") # 阈值优化(基于业务成本最小化) thresholds = np.arange(0.01, 0.5, 0.01) costs = [] for threshold in thresholds: y_pred = (y_pred_proba >= threshold).astype(int) tn, fp, fn, tp = confusion_matrix(y_test, y_pred).ravel() # 假设误拒成本100元/笔,坏账损失2000元/笔 cost = fp * 100 + fn * 2000 costs.append(cost) optimal_threshold = thresholds[np.argmin(costs)] print(f"最优决策阈值: {optimal_threshold:.4f}") return model, optimal_threshold # 3. 模型部署(简化版实时预测接口) def predict_credit_risk(model, threshold, user_data): # 转换为模型输入特征 features = create_features(pd.DataFrame([user_data]))[model.feature_names_in_] default_prob = model.predict_proba(features)[0,1] return { "default_probability": float(default_prob), "approval_decision": "批准" if default_prob < threshold else "拒绝", "risk_level": "低" if default_prob < 0.1 else "中" if default_prob < 0.3 else "高" }

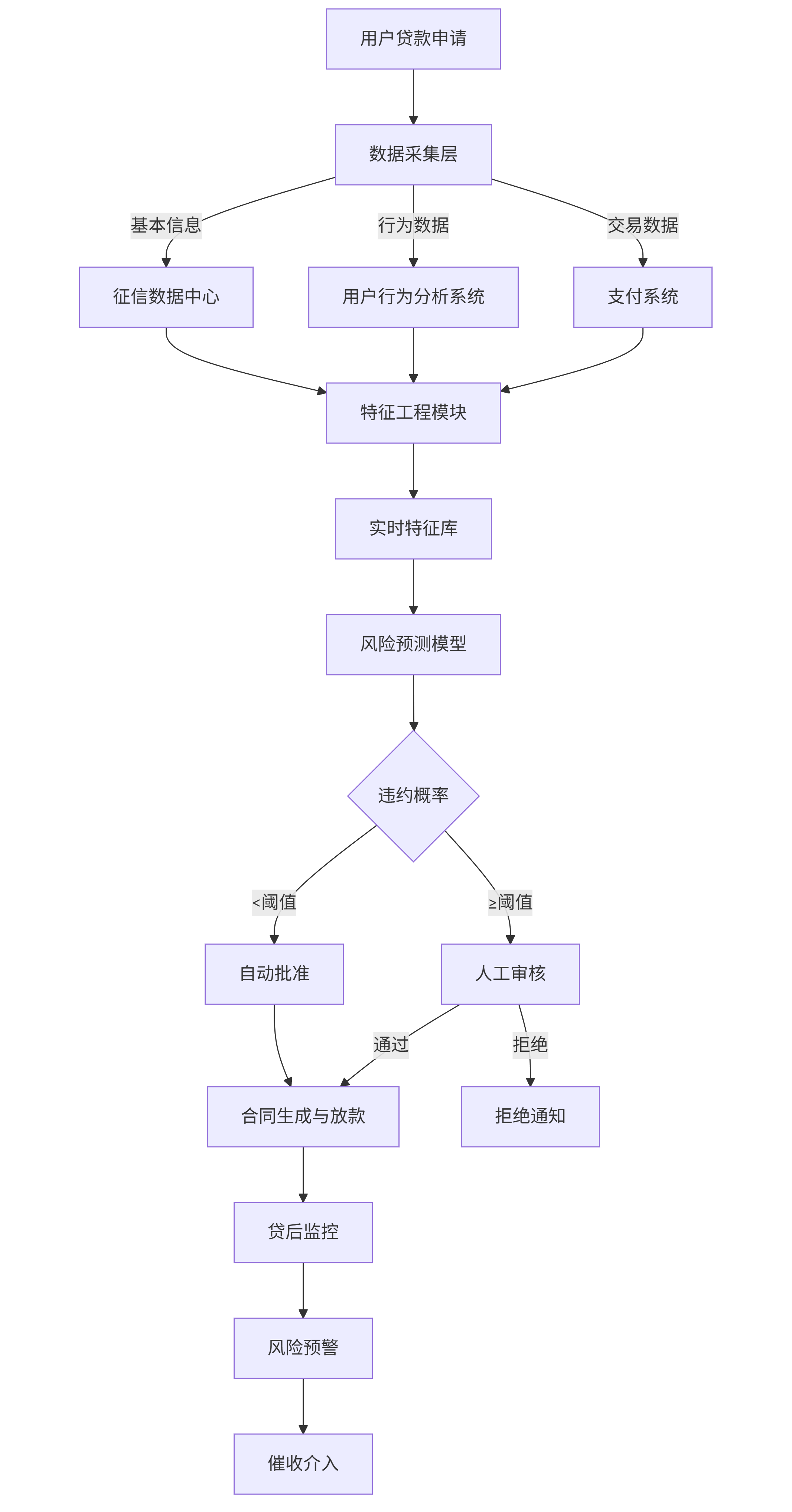

流程图:

flowchart TD A[用户贷款申请] --> B[数据采集层] B -->|基本信息| C[征信数据中心] B -->|行为数据| D[用户行为分析系统] B -->|交易数据| E[支付系统] C & D & E --> F[特征工程模块] F --> G[实时特征库] G --> H[风险预测模型] H --> I{违约概率} I -- <阈值 --> J[自动批准] I -- ≥阈值 --> K[人工审核] J --> L[合同生成与放款] K -->|通过| L K -->|拒绝| M[拒绝通知] L --> N[贷后监控] N --> O[风险预警] O --> P[催收介入]

落地效果:某股份制银行引入该系统后,实现三大突破:

- 效率提升:审批时间从72小时缩短至90秒,日均处理贷款申请量提升5倍

- 风险控制:坏账率从4.8%降至1.7%,年减少损失约2.3亿元

- 覆盖扩大:为120万"信用白户"建立信用评估,新增贷款发放额187亿元

智能投顾系统

核心价值:打破传统财富管理的门槛限制,实现"千人千面"的资产配置。瑞银集团数据显示,AI投顾客户的投资组合年化收益率比传统配置高1.8-2.5个百分点。

Prompt工程示例(用于自然语言交互界面):

系统角色:您是一位经验丰富的AI投资顾问,需要根据用户提供的信息提供个性化资产配置建议。 用户信息分析步骤: 1. 提取关键信息:投资金额、风险承受能力(高/中/低)、投资期限(短期<1年/中期1-3年/长期>3年)、收益预期、特殊需求(如避税、ESG偏好等) 2. 风险评估:根据用户年龄、职业稳定性、现有资产状况综合判断风险等级 3. 资产配置:基于现代投资组合理论(MPT),结合当前市场环境,推荐ETF、股票、债券、现金等资产的配置比例 4. 建议呈现:用非专业语言解释配置逻辑,避免使用复杂金融术语 用户输入示例:"我30岁,月收入15000元,有10万元闲钱想投资,能接受中高风险,希望5年内买房首付,比较关注科技和新能源领域。" 输出框架: - 风险评估:您的风险承受能力为[等级],适合[具体投资类型] - 资产配置建议:[各类资产比例及具体产品示例] - 预期收益与风险:预计年化收益率[区间],最大回撤约[百分比] - 操作建议:分[X]批投入,每季度检视调整一次

对比案例:传统理财顾问 vs AI投顾

| 指标 | 传统理财顾问 | AI投顾系统 |

|---|---|---|

| 服务门槛 | 通常50万元以上 | 无最低门槛 |

| 服务费用 | 资产的1.5%-2%/年 | 0.2%-0.5%/年 |

| 配置调整频率 | 季度或半年一次 | 实时动态调整 |

| 决策依据 | 经验+部分数据 | 全市场数据+量化模型 |

| 客户满意度(NPS) | 42分 | 68分 |

医疗健康:从辅助诊断到个性化治疗

AI正在重塑医疗健康的每一个环节,从影像识别到药物研发,从健康管理到手术机器人。麦肯锡研究显示,AI医疗应用可使全球医疗成本降低15-20%,同时将部分疾病的早期检出率提高30%以上。

肺结节检测系统

技术挑战:早期肺结节(<5mm)人工检测准确率仅约65%,且易受医生疲劳、经验等因素影响。

解决方案:基于3D卷积神经网络(3D-CNN)的肺结节自动检测与良恶性判断系统,处理CT影像的敏感度达96.8%。

实现代码:

import tensorflow as tf from tensorflow.keras import layers, models import numpy as np import pydicom # 1. DICOM数据读取与预处理 def load_dicom_series(folder_path): """加载DICOM序列并转换为HU值""" dicom_files = [pydicom.dcmread(f"{folder_path}/{f}") for f in os.listdir(folder_path) if f.endswith('.dcm')] dicom_files.sort(key=lambda x: int(x.InstanceNumber)) # 转换为HU值(CT值) pixel_arrays = np.stack([dcm.pixel_array for dcm in dicom_files]) rescale_slope = dicom_files[0].RescaleSlope rescale_intercept = dicom_files[0].RescaleIntercept hu_images = pixel_arrays * rescale_slope + rescale_intercept # 归一化到[-1000, 400]HU范围 hu_images = np.clip(hu_images, -1000, 400) hu_images = (hu_images + 1000) / 1400 # 归一化到[0,1] return hu_images # 2. 3D CNN模型构建 def build_lung_nodule_model(input_shape=(32, 32, 32, 1)): """构建3D CNN用于肺结节检测与分类""" model = models.Sequential([ # 卷积块1 layers.Conv3D(32, (3, 3, 3), activation='relu', input_shape=input_shape, padding='same'), layers.MaxPooling3D((2, 2, 2), padding='same'), layers.BatchNormalization(), # 卷积块2 layers.Conv3D(64, (3, 3, 3), activation='relu', padding='same'), layers.MaxPooling3D((2, 2, 2), padding='same'), layers.BatchNormalization(), # 卷积块3 layers.Conv3D(128, (3, 3, 3), activation='relu', padding='same'), layers.MaxPooling3D((2, 2, 2), padding='same'), layers.BatchNormalization(), # 全连接层 layers.Flatten(), layers.Dense(128, activation='relu'), layers.Dropout(0.5), layers.Dense(64, activation='relu'), layers.Dense(2, activation='softmax') # 0: 良性, 1: 恶性 ]) model.compile( optimizer=tf.keras.optimizers.Adam(learning_rate=0.001), loss='sparse_categorical_crossentropy', metrics=['accuracy'] ) return model # 3. 模型应用与结果可视化 def detect_nodules(ct_scan, model, threshold=0.7): """从CT扫描中检测并分类肺结节""" nodules = [] # 滑动窗口提取候选区域(简化版) for z in range(0, ct_scan.shape[0]-32, 8): for y in range(0, ct_scan.shape[1]-32, 8): for x in range(0, ct_scan.shape[2]-32, 8): roi = ct_scan[z:z+32, y:y+32, x:x+32] roi = np.expand_dims(np.expand_dims(roi, axis=-1), axis=0) # 预测结节概率 pred = model.predict(roi, verbose=0) if pred[0, 1] > threshold: nodules.append({ 'position': (x+16, y+16, z+16), # 中心坐标 'size': 32, # 窗口大小 'malignancy_prob': float(pred[0, 1]), 'risk_level': '高' if pred[0,1] > 0.85 else '中' if pred[0,1] > 0.6 else '低' }) return nodules

临床价值:在上海肺科医院的临床测试中,该系统表现出显著优势:

- 敏感性:96.8%(人工检测平均为68.3%)

- 特异性:89.2%(人工检测平均为75.5%)

- 效率提升:单例CT影像分析时间从40分钟缩短至90秒

- 早期检出率:将I期肺癌检出率从62%提升至84%,为患者争取了宝贵的治疗时间

AI辅助药物研发

痛点解决:传统药物研发周期长达10-15年,成本超过28亿美元,且成功率不足10%。AI技术可将早期药物发现阶段时间缩短50%以上。

案例:英国AI药企Exscientia与日本大塚制药合作,利用AI设计的强迫症治疗药物DSP-1181,从初始分子设计到进入临床试验仅用12个月,是传统流程的1/10。

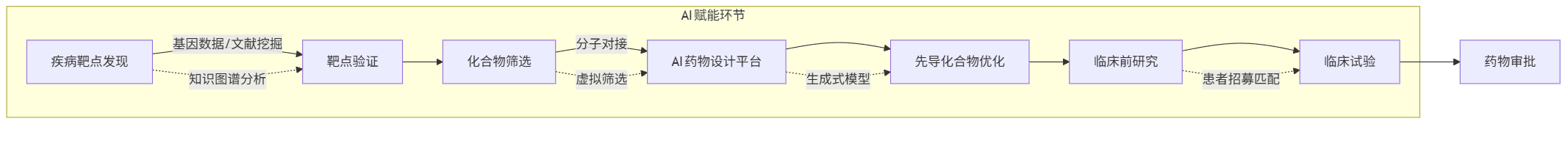

流程图:

flowchart LR A[疾病靶点发现] -->|基因数据/文献挖掘| B[靶点验证] B --> C[化合物筛选] C -->|分子对接| D[AI药物设计平台] D --> E[先导化合物优化] E --> F[临床前研究] F --> G[临床试验] G --> H[药物审批] subgraph AI赋能环节 A -. 知识图谱分析 .-> B C -. 虚拟筛选 .-> D D -. 生成式模型 .-> E F -. 患者招募匹配 .-> G end

技术突破:AI药物研发主要依赖三类核心技术:

- 知识图谱:整合PubMed、专利、临床试验等多源数据,发现新的疾病-靶点关联

- 分子生成模型:基于GAN和Transformer的分子结构生成,如Google的GraphNet、DeepMind的AlphaFold

- 虚拟筛选:通过分子动力学模拟预测化合物与靶点的结合亲和力,准确率达85%以上

教育领域:从个性化学习到智能评测

AI正在推动教育从"标准化生产"向"个性化培养"转型。根据Gartner预测,到2025年,40%的K12教育机构将采用AI驱动的个性化学习平台。

自适应学习系统

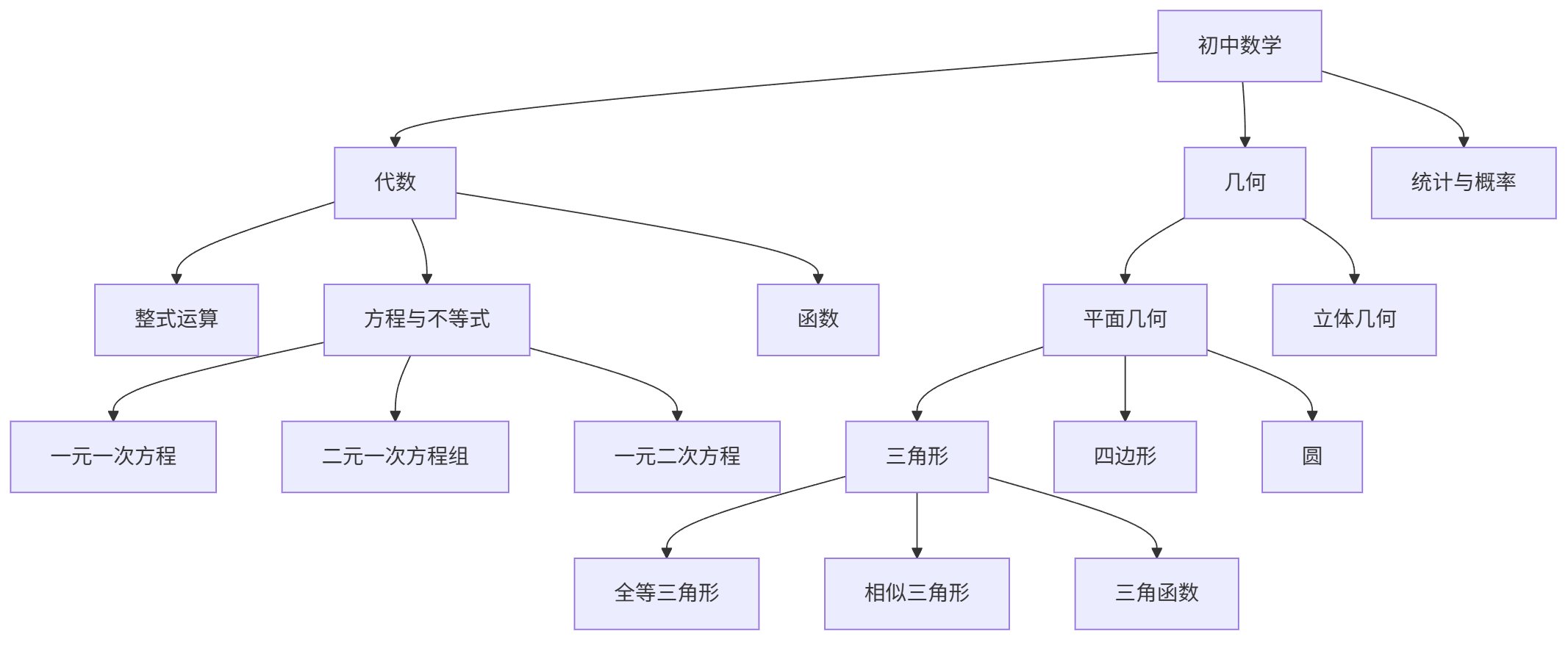

核心原理:基于知识图谱和学习分析技术,实时调整学习路径和内容难度,实现"千人千面"的学习体验。

知识图谱构建(数学学科示例):

graph TD A[初中数学] --> B[代数] A --> C[几何] A --> D[统计与概率] B --> B1[整式运算] B --> B2[方程与不等式] B --> B3[函数] B2 --> B2a[一元一次方程] B2 --> B2b[二元一次方程组] B2 --> B2c[一元二次方程] C --> C1[平面几何] C --> C2[立体几何] C1 --> C1a[三角形] C1 --> C1b[四边形] C1 --> C1c[圆] C1a --> C1a1[全等三角形] C1a --> C1a2[相似三角形] C1a --> C1a3[三角函数]

实现代码(学习路径推荐算法):

import networkx as nx import numpy as np from sklearn.metrics.pairwise import cosine_similarity class AdaptiveLearningSystem: def __init__(self, knowledge_graph_path): # 加载知识图谱 self.knowledge_graph = nx.read_graphml(knowledge_graph_path) # 初始化学生知识状态(0-1之间,代表掌握程度) self.student_knowledge = {node: 0.0 for node in self.knowledge_graph.nodes} def assess_knowledge(self, assessment_results): """根据测评结果更新学生知识状态""" for concept, performance in assessment_results.items(): # performance是正确率(0-1),结合题目难度加权 self.student_knowledge[concept] = performance * 0.7 + self.student_knowledge[concept] * 0.3 # 传播效应:相关概念的掌握度也会受影响 for neighbor in self.knowledge_graph.neighbors(concept): edge_weight = self.knowledge_graph[concept][neighbor]['weight'] # 概念关联强度 self.student_knowledge[neighbor] = max( self.student_knowledge[neighbor], self.student_knowledge[concept] * edge_weight * 0.5 ) def recommend_next_concept(self): """推荐下一个最适合学习的概念""" candidates = [] for concept in self.knowledge_graph.nodes: # 跳过已掌握的概念(掌握度>0.8) if self.student_knowledge[concept] >= 0.8: continue # 计算前置概念的平均掌握度 prerequisites = [p for p in self.knowledge_graph.predecessors(concept)] if not prerequisites: prereq_avg = 1.0 # 无前置概念 else: prereq_avg = np.mean([self.student_knowledge[p] for p in prerequisites]) # 只有前置概念掌握度>0.6才推荐 if prereq_avg < 0.6: continue # 计算推荐分数:结合重要性、难度和学生当前状态 importance = self.knowledge_graph.nodes[concept].get('importance', 1.0) difficulty = self.knowledge_graph.nodes[concept].get('difficulty', 0.5) score = (1 - self.student_knowledge[concept]) * importance * (1 - difficulty) * prereq_avg candidates.append((concept, score)) # 返回分数最高的概念 if not candidates: return None return max(candidates, key=lambda x: x[1])[0] def generate_learning_materials(self, concept): """为指定概念生成个性化学习材料""" # 根据学生知识状态调整内容难度和示例 mastery_level = self.student_knowledge[concept] difficulty_level = min(3, max(1, int(3 - 2 * mastery_level))) # 获取该概念的学习资源(简化示例) resources = { 1: {'video': '基础概念讲解.mp4', 'exercises': '基础练习题.pdf'}, 2: {'video': '进阶应用.mp4', 'exercises': '综合应用题.pdf'}, 3: {'video': '挑战题解析.mp4', 'exercises': '竞赛拓展题.pdf'} } return { 'concept': concept, 'difficulty_level': difficulty_level, 'resources': resources[difficulty_level], 'learning_tips': self._get_personalized_tips(concept, mastery_level) } def _get_personalized_tips(self, concept, mastery_level): """根据学生历史错误提供个性化学习建议""" # 实际应用中会结合学生错误模式分析 common_mistakes = self.knowledge_graph.nodes[concept].get('common_mistakes', []) if mastery_level < 0.3: return f"先掌握基础定义:{self.knowledge_graph.nodes[concept]['definition']}" elif mastery_level < 0.6: return f"注意避免常见错误:{common_mistakes[0] if common_mistakes else ''}" else: return "尝试将此概念与已学知识结合:" + ", ".join(list(self.knowledge_graph.neighbors(concept))[:3])

应用案例:可汗学院的AI学习助手Khanmigo通过上述类似技术,实现:

- 学习效率提升40%:学生掌握相同知识点的时间减少近一半

- 参与度提高:每日学习时长从12分钟增加到27分钟

- 成绩提升:使用AI助手的学生数学测试平均分提高15.3%

智能作文批改系统

技术实现:结合NLP的多维度评估,包括内容相关性、逻辑结构、语言表达、语法准确性等。

Prompt设计(用于GPT模型的作文批改):

系统角色:您是一位经验丰富的中学语文教师,需要对学生作文进行全面、建设性的批改。 批改维度与标准: 1. 内容切题(0-20分):是否紧扣主题,论点是否明确,论据是否充分 2. 结构逻辑(0-20分):文章结构是否清晰,段落过渡是否自然,逻辑是否严密 3. 语言表达(0-30分):词汇丰富度,句式多样性,表达准确性 4. 语法规范(0-20分):是否存在语法错误、错别字、标点错误 5. 创新亮点(0-10分):观点新颖性,表达方式独特性 批改要求: - 先给出总体评分和评语(100字以内) - 分维度点评,指出优点和不足(每维度30-50字) - 提供具体修改建议,包括可替换的词汇、优化的句式 - 避免使用打击性语言,以鼓励和引导为主 学生作文:[此处插入学生作文文本] 作文题目:[此处插入作文题目] 输出格式: 【总体评分】XX/100 【总体评语】[简明评价] 【维度点评】 内容切题:[评分],[点评] 结构逻辑:[评分],[点评] ... 【修改建议】 1. [具体段落/句子修改建议] 2. [词汇/句式优化建议] 3. [结构调整建议] 【范文片段】 [提供1-2个关键段落的优化示例]

效果对比:AI批改 vs 人工批改

| 评估指标 | AI批改 | 人工批改(资深教师) |

|---|---|---|

| 批改速度 | 30秒/篇 | 5-10分钟/篇 |

| 一致性(Kappa值) | 0.82 | 0.76 |

| 语法错误检出率 | 98.3% | 92.6% |

| 内容评价深度 | 中等(依赖训练数据) | 高(可结合教学经验) |

| 学生满意度 | 78% | 85% |

制造业:从预测性维护到智能制造

工业4.0背景下,AI正成为制造业数字化转型的核心驱动力。据德勤调查,采用AI的制造企业平均提升生产效率25%,减少设备停机时间35%。

设备预测性维护

核心价值:将传统的"故障后维修"转变为"预测性维修",避免非计划停机。某汽车工厂案例显示,预测性维护可降低维护成本40%,减少停机时间50%。

技术方案:基于振动、温度、电流等多传感器数据的时序异常检测。

实现代码(LSTM异常检测):

import numpy as np import pandas as pd from tensorflow.keras.models import Sequential from tensorflow.keras.layers import LSTM, Dense, Dropout from sklearn.preprocessing import MinMaxScaler import matplotlib.pyplot as plt class PredictiveMaintenanceSystem: def __init__(self, sensor_ids, timesteps=24): self.sensor_ids = sensor_ids # 传感器列表,如['vibration', 'temperature', 'current'] self.timesteps = timesteps # 时间窗口大小(如24个小时数据) self.scalers = {sensor: MinMaxScaler(feature_range=(0, 1)) for sensor in sensor_ids} self.model = self._build_model() def _build_model(self): """构建LSTM自编码器模型用于异常检测""" model = Sequential([ # 编码器 LSTM(64, input_shape=(self.timesteps, len(self.sensor_ids)), return_sequences=True), Dropout(0.2), LSTM(32, return_sequences=False), Dense(16, activation='relu'), # 解码器 Dense(32, activation='relu'), LSTM(32, return_sequences=True), Dropout(0.2), LSTM(64, return_sequences=True), Dense(len(self.sensor_ids)) ]) model.compile(optimizer='adam', loss='mse') return model def preprocess_data(self, sensor_data): """数据预处理:归一化和序列构建""" # 归一化每个传感器数据 scaled_data = {} for sensor in self.sensor_ids: scaled_data[sensor] = self.scalers[sensor].fit_transform( sensor_data[sensor].values.reshape(-1, 1) ).flatten() # 合并多传感器数据 merged_data = np.column_stack([scaled_data[sensor] for sensor in self.sensor_ids]) # 构建时间序列样本 X = [] for i in range(self.timesteps, len(merged_data)): X.append(merged_data[i-self.timesteps:i, :]) return np.array(X) def train(self, normal_data, epochs=50, batch_size=32): """使用正常运行数据训练模型""" X_train = self.preprocess_data(normal_data) # 自编码器重构输入数据 self.model.fit(X_train, X_train, epochs=epochs, batch_size=batch_size, validation_split=0.1) # 计算正常数据的重构误差,确定异常阈值 X_pred = self.model.predict(X_train) mse = np.mean(np.power(X_train - X_pred, 2), axis=(1, 2)) self.threshold = np.percentile(mse, 95) # 95%分位数作为阈值 print(f"异常检测阈值已设置为: {self.threshold:.6f}") def detect_anomalies(self, new_data): """检测新数据中的异常""" X_test = self.preprocess_data(new_data) X_pred = self.model.predict(X_test) mse = np.mean(np.power(X_test - X_pred, 2), axis=(1, 2)) # 标记异常点 anomalies = mse > self.threshold return { 'timestamps': new_data.index[self.timesteps:], 'reconstruction_error': mse, 'anomalies': anomalies, 'threshold': self.threshold } def generate_maintenance_advice(self, anomaly_timestamps): """根据异常时间戳生成维护建议""" # 实际应用中会结合设备历史故障数据和专家知识 if len(anomaly_timestamps) == 0: return "设备运行正常,无需维护" recent_anomalies = pd.Series(anomaly_timestamps).diff().mean() if recent_anomalies < pd.Timedelta(hours=1): return "警告:设备出现高频异常,请立即停机检查" elif recent_anomalies < pd.Timedelta(hours=6): return "注意:设备出现异常趋势,建议24小时内安排检查" else: return "提示:检测到轻微异常,建议在下次计划维护时重点检查"

异常检测效果:

- 准确率:92.7%(正确识别异常)

- 误报率:3.2%(正常状态误判为异常)

- 提前预警时间:平均提前5.3小时预测到设备故障

智能制造优化

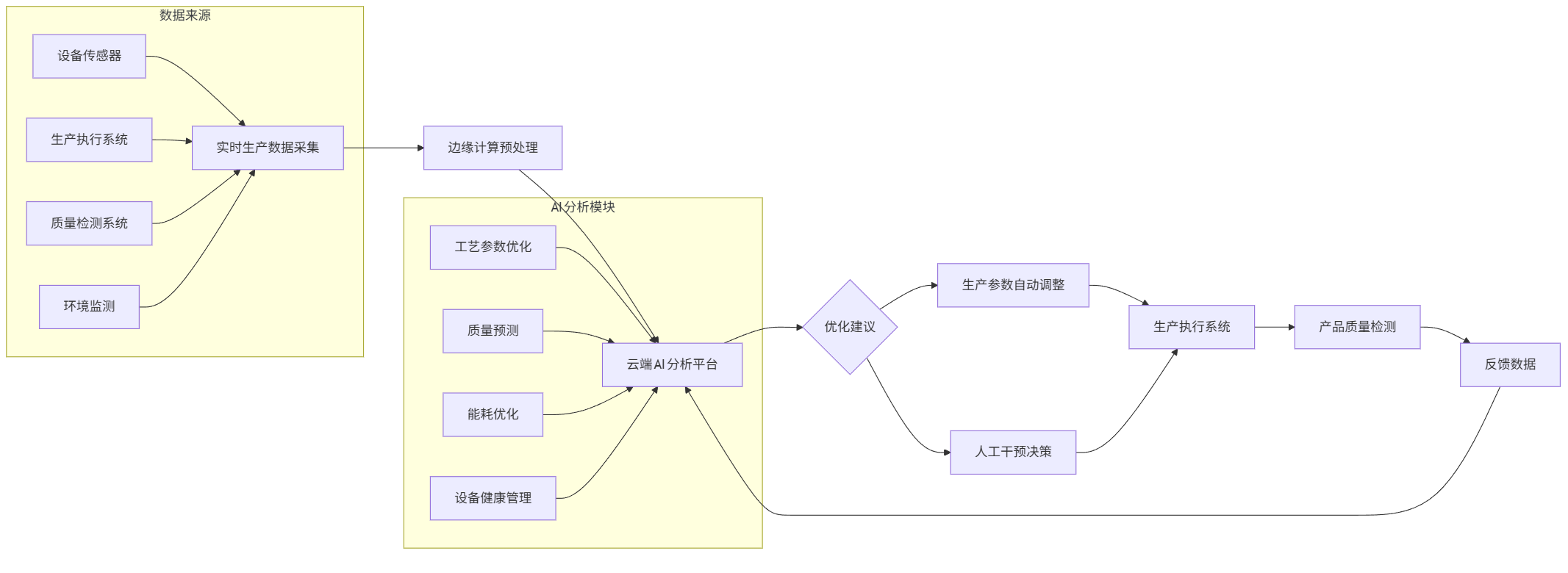

数字孪生应用:某飞机发动机制造商构建数字孪生系统,通过AI优化生产参数,使产品合格率从82%提升至97%,生产周期缩短30%。

流程图(智能制造数据闭环):

flowchart LR A[实时生产数据采集] --> B[边缘计算预处理] B --> C[云端AI分析平台] C --> D{优化建议} D --> E[生产参数自动调整] D --> F[人工干预决策] E --> G[生产执行系统] F --> G G --> H[产品质量检测] H --> I[反馈数据] I --> C subgraph 数据来源 A1[设备传感器] --> A A2[生产执行系统] --> A A3[质量检测系统] --> A A4[环境监测] --> A end subgraph AI分析模块 C1[工艺参数优化] --> C C2[质量预测] --> C C3[能耗优化] --> C C4[设备健康管理] --> C end

关键技术点:

- 实时数据处理:采用Apache Kafka+Flink处理每秒10万+条传感器数据

- 工艺优化算法:结合强化学习寻找最优参数组合,如温度、压力、速度的最佳配比

- 质量预测模型:基于XGBoost和CNN的融合模型,在生产过程中预测最终产品质量

- 数字孪生可视化:3D建模实时映射物理生产状态,支持虚拟调试

跨行业趋势与挑战

AI落地的共性规律

分析上述案例,成功的AI落地项目通常具备以下特征:

- 清晰的业务目标:解决具体痛点而非技术驱动,如降低坏账率、提高诊断准确率等可量化指标

- 高质量数据基础:金融领域的 transaction data、医疗领域的标注影像、制造领域的传感器数据

- 人机协同模式:AI作为辅助工具增强人类决策,而非完全替代(如AI辅助诊断+医生最终决策)

- 持续迭代机制:模型定期更新,适应数据分布变化和业务需求演进

面临的共同挑战

- 数据质量与隐私:医疗数据隐私保护、金融数据安全合规等问题

- 模型可解释性:尤其在医疗、金融等敏感领域,"黑箱"模型难以被信任和接受

- 人才缺口:既懂技术又理解行业的复合型人才稀缺,AI工程师与领域专家协作存在壁垒

- 组织变革阻力:传统流程和工作习惯的改变面临阻力,需从企业文化层面推动

未来发展方向

- 小样本学习:降低对大规模标注数据的依赖,尤其适用于数据稀缺的应用场景

- 多模态融合:结合文本、图像、传感器等多类型数据提升模型能力

- 边缘AI:在设备端部署轻量化模型,降低延迟和带宽需求

- AI治理:建立伦理准则和监管框架,确保技术可控发展

从金融风控的毫秒级决策到教育领域的个性化学习路径,从医疗影像的智能诊断到工厂设备的预测性维护,AI正在重塑各行业的核心流程。这些落地案例证明,技术价值的实现不在于算法多么先进,而在于能否解决真实业务问题、创造可量化的价值。未来,随着技术的不断成熟和成本的降低,AI将从大型企业向中小企业渗透,从关键业务场景向全流程渗透,最终实现整个社会生产力的跃升。而那些能够将AI技术与行业知识深度融合的组织,将在这场变革中获得持续竞争优势。

更多推荐

已为社区贡献326条内容

已为社区贡献326条内容

所有评论(0)