高通跃龙QCS9100平台运行声纹识别模型: 从SpeechBrain模型导出到异构计算优化全攻略

摘要: 高通QCS9100工业级边缘计算平台凭借其异构计算架构(100 TOPS AI算力、专用音频DSP及硬件加密)为声纹识别提供了理想的部署环境。报告详细分析了基于SpeechBrain的ECAPA-TDNN模型在QCS9100上的优化路径,包括ONNX转换、INT8量化及异构任务分配,实现端侧50ms低延迟识别。该方案通过TEE安全存储和边缘计算特性,满足工业场景对隐私保护、断网可用及-40

💡 前言

随着人工智能(AI)与物联网(IoT)的深度融合,边缘计算已成为推动智能终端进化的核心动力。在人机交互领域,语音作为最自然、最高效的媒介,其安全性与个性化需求日益凸显。声纹识别(Voiceprint Recognition)作为一种生物识别技术,通过分析个体语音中的生理和行为特征,实现身份验证与识别,已广泛应用于智能座舱、智能家居、工业安全及金融支付等领域。

高通跃龙QCS9100平台作为其最新推出的工业级高性能边缘计算平台,集成了先进的 AI 加速引擎与音频处理技术,为复杂声纹识别算法的端侧部署提供了坚实的硬件基础 。本报告旨在探讨基于 QCS9100 平台的声纹识别技术实现路径及其在工业、商用领域的应用前景。

一、高通 QCS9100 平台架构分析

高通 QCS9100 是 IQ9 系列高端工业级(-40~105℃)平台,车载、工控、室外设备都能扛,其设计旨在满足最苛刻的边缘 AI 计算需求,为边缘AI而生。

1、硬件规格与 AI 性能

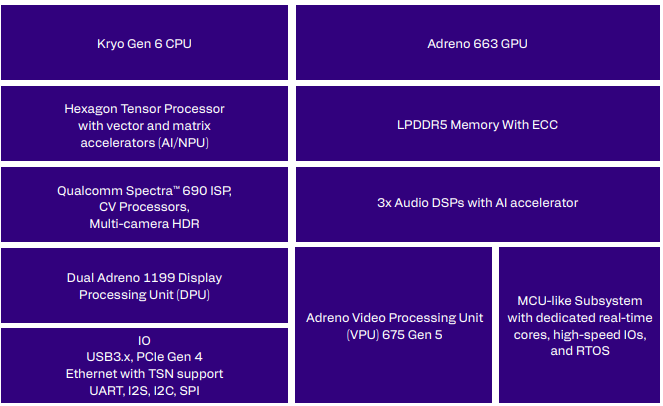

QCS9100 其异构计算架构为声纹识别的各个阶段(从信号处理到模型推理)提供了差异化的算力支持 。

| 核心组件 | 技术特性 | 在声纹识别中的角色 |

|---|---|---|

| Qualcomm Hexagon HTP | 100 TOPS AI 算力,支持 INT8/FP16 | 执行 ECAPA-TDNN 等深度神经网络推理 |

| LPASS音频子系统 | 独立DSP,功耗极低 | 始终在线的音频采集、降噪及特征提取 |

| Sensing Hub | 微功耗感知中心 | 极低功耗VAD,过滤静音帧 |

| TEE+Secure Boot | 硬件加密 | 声纹模板防物理攻击 |

| ** Adreno GPU** | 高性能并行图形与计算单元 | 辅助大规模声纹库的相似度检索 |

| Kryo CPU | 8 核高性能架构 | 运行操作系统、VAD 逻辑及业务流程控制 |

最关键的是,QCS9100是工业级(-40~105℃),车载、工控、室外设备都能扛。

2、 低功耗音频子系统 (LPASS)

QCS9100 配备了专门的音频 DSP 和 AI 加速器,支持始终在线(Always-on)的语音唤醒与环境感知。LPASS 能够以极低的功耗处理原始音频信号,包括回声消除(AEC)、降噪(NS)及特征提取,从而减轻主处理器的负担 。

二、声纹识别核心技术方案

声纹识别通常分为说话人辨认(Speaker Identification)和说话人确认(Speaker Verification)。

1、主流算法模型

目前,基于深度学习的嵌入码(Embedding)提取是主流方案 。

- x-vector:基于时延神经网络(TDNN)的统计池化模型,是工业界的标杆 。

- ECAPA-TDNN:在 x-vector 基础上引入了通道注意力机制(SE-Block)和多尺度特征聚合,显著提升了在噪声环境下的鲁棒性 。

2、 技术流程

- 预处理:包括语音增强、端点检测(VAD)及特征提取(如 Fbank 或 MFCC)。

- 特征提取:通过深度神经网络将变长语音序列映射为定长的声纹特征向量。

- 相似度度量:利用余弦相似度或概率线性判别分析(PLDA)对比注册声纹与实时声纹。

三、SpeechBrain 在 QCS9100 上的部署与优化

SpeechBrain 作为一个开源的全能语音工具包,其预训练的 ECAPA-TDNN 模型是声纹识别的首选。在高通 QCS9100 上部署 SpeechBrain 模型需要经过模型导出、量化、转换及异构调度四个核心阶段。

1、 模型导出与简化 (SpeechBrain to ONNX)

由于高通 QNN/SNPE 无法直接解析 PyTorch 的 .ckpt 文件,首先需要将 SpeechBrain 模型导出为标准的 ONNX 格式。

- 追踪(Tracing):使用

torch.jit.trace捕获 SpeechBrain 模型的计算图。注意需固定输入维度(如 [1, 16000] 对应 1 秒音频)。 - 算子对齐:SpeechBrain 中的某些自定义算子(如动态卷积)可能不直接支持 ONNX。需通过

onnx-simplifier进行图简化,并确保所有算子在 ONNX 算子集(Opset 11+)范围内。 - 静态图转换:确保模型中不含动态分支,以适配 NPU 的静态执行特性。

2、 高通 QNN 转换与 INT8 量化

利用 Qualcomm AI Stack 中的 QNN SDK,将 ONNX 模型转换为针对 Hexagon HTP 优化的二进制格式。

- 模型量化 (Quantization):QCS9100 的 HTP 在处理 INT8 数据时效率最高。通过

qnn-onnx-converter配合校准数据集(从 VoxCeleb 等数据集中选取典型样本),对模型权重和激活值进行量化。 - 精度补偿:针对声纹识别对特征精度敏感的特点,可采用 混合精度量化,将敏感层(如最后一层 Embedding 提取层)保留为 FP16,其余层量化为 INT8。

- 算子融合:QNN 转换器会自动执行 BatchNorm 融合、卷积+激活函数融合,减少内存访问次数。

3、 异构计算分配策略

QCS9100 的异构架构允许将声纹识别流水线分解到不同的计算单元:

| 阶段 | 执行单元 | 耗时 | 优化技巧 |

|---|---|---|---|

| 音频采集 | LPASS DSP | 几乎为0(始终在线) | 使用硬件加速的 FFT 执行 Fbank 提取,确保音频流处理不丢包。 |

| VAD | Sensing Hub | <1mW | 极低功耗过滤静音段,仅在检测到人声时唤醒主推理。 |

| 神经网络推理 | Hexagon HTP | 8~12ms | 利用 100 TOPS 算力执行 ECAPA-TDNN,实现毫秒级 Embedding 提取。 |

| 声纹比对(余弦/PLDA) | Kryo CPU | 2~5ms | 运行复杂的概率统计逻辑,利用多核加速大规模声纹库检索。 |

4、 内存与功耗优化

- ION 内存共享:通过高通共享内存机制,避免音频特征在 CPU、DSP 和 NPU 之间进行物理拷贝,降低系统总线负载。

- 动态频率调节 (DCVS):根据音频输入频率动态调整 NPU 的主频,在低负载时降低功耗。

四、 技术优势与安全性保障

1、 边缘计算的优势

- 隐私与合规性:声纹作为敏感的生物识别数据,在 QCS9100 端侧完成提取与比对,避免了云端传输带来的泄露风险,符合 GDPR 等数据保护法规。

- 极低延迟:得益于 HTP 的高效推理,识别过程可在 50ms 内完成,满足实时交互需求。

- 断网可用性:不依赖网络连接,确保在工业边远地区或地下设施中的稳定运行。

2、 硬件级安全防护

QCS9100 支持 可信执行环境 (TEE) 和 安全启动 (Secure Boot)。声纹模板可存储在硬件加密隔离区,确保即使操作系统受损,攻击者也无法获取原始声纹特征数据。

五、开发生态与工具链支持

高通为 QCS9100 提供了完善的软件开发工具链,降低了声纹识别算法的迁移门槛 :

- Qualcomm AI Stack:统一的 AI 软件组合,支持从云端训练到端侧部署的全流程。

- Qualcomm Neural Network (QNN) SDK:提供针对 Hexagon HTP 优化的算子库,支持开发者自定义算子。

- Audio Reach™ 开发套件:简化了音频处理链路的配置,支持图形化调整音频算法参数。

六、未来展望

1、 多模态融合

未来,声纹识别将与人脸识别、手势识别等多模态生物识别技术深度结合,在 QCS9100 强大的算力支持下,实现更高维度的身份安全验证。

2、 生成式 AI 的结合

随着大语言模型(LLM)向边缘端迁移,声纹识别将成为个性化 AI 助手的关键入口。通过识别不同用户的身份,AI 助手能够提供差异化的回复与服务,实现真正的“千人千面”。

3、 工业级安全性

在工业 IoT 场景下,声纹识别可用于设备巡检员的身份确认及危险操作授权,结合 QCS9100 的工业级可靠性,进一步提升生产安全性。

📢参考资料

更多推荐

已为社区贡献74条内容

已为社区贡献74条内容

所有评论(0)