在高通跃龙 RB5 平台上部署 OpenClaw:打造您的本地 AI 智能体

💡 前言

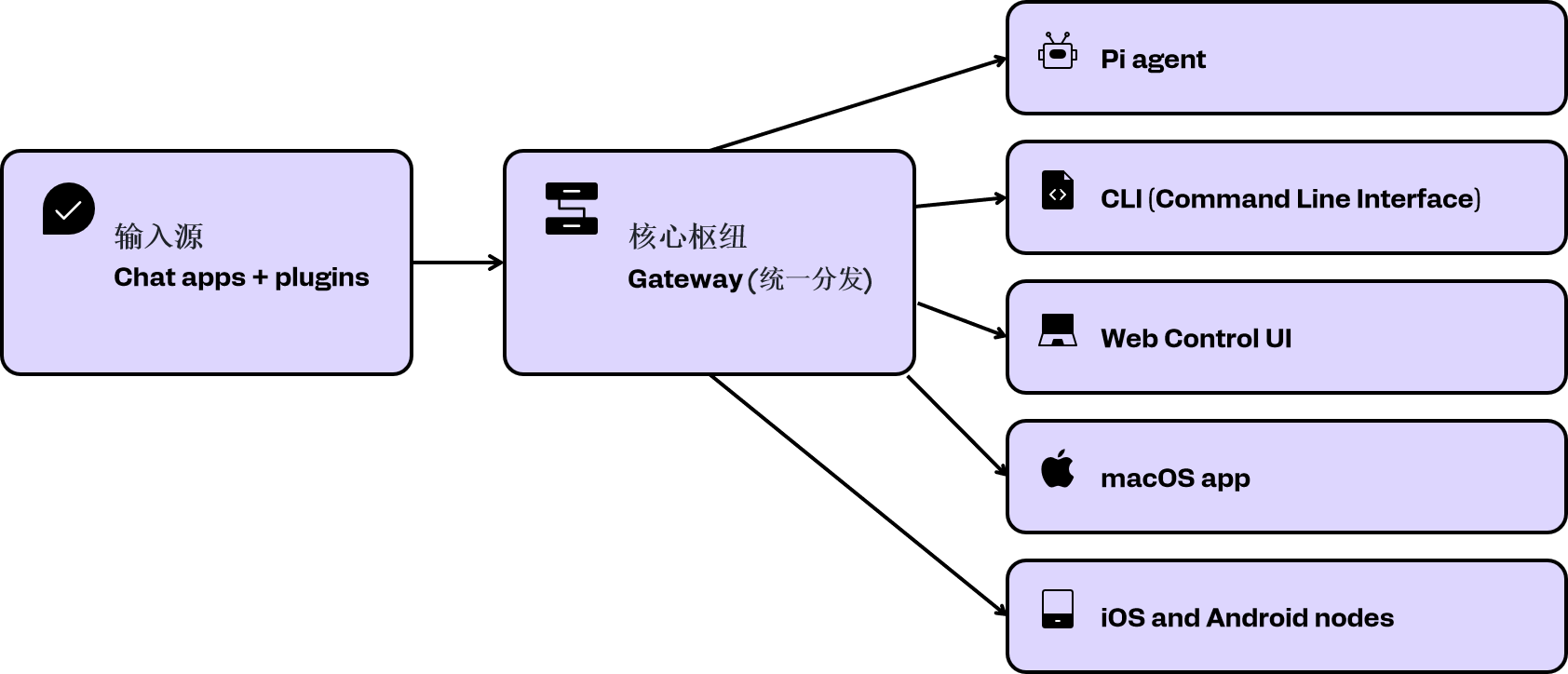

随着人工智能技术的飞速发展,个人 AI 智能体正逐渐成为我们数字生活中不可或缺的一部分。OpenClaw,作为一个开源、自托管的个人 AI 代理网关,以其“本地优先、隐私可控”的设计理念,迅速在开发者社区中获得了广泛关注。它不仅能够接入多种消息平台,还能深度整合大语言模型(LLM)与智能体能力,实现任务自动化。与此同时,高通机器人 RB5(Qualcomm Robotics RB5)开发板凭借其强大的异构计算能力和对 AI 工作负载的优化,为在边缘设备上运行复杂的 AI 应用提供了理想的硬件平台。本文将详细介绍 OpenClaw 的核心概念,并提供一份在高通 RB5 开发板上部署 OpenClaw 的详细指南,帮助您构建专属的本地 AI 智能体。

![[图片]](https://i-blog.csdnimg.cn/direct/199bf21a991a4a15baf0d125fc1e50b7.png)

一、什么是 OpenClaw?

OpenClaw (1)是一款创新的开源项目,旨在为用户提供一个可自托管的个人 AI 代理网关。其核心思想是让用户能够完全掌控自己的 AI 助手,确保数据隐私和本地化运行。与传统的云端 AI 服务不同,OpenClaw 允许用户在自己的设备上运行 AI 智能体,从而避免了数据泄露的风险,并提供了更低的延迟和更高的定制性。

二、OpenClaw 的主要特性包括:

- 多平台集成:OpenClaw 能够无缝对接包括 WhatsApp、Telegram、Slack、Discord、微信、飞书等在内的十多个主流消息平台,使用户可以通过熟悉的聊天界面与 AI 智能体进行交互。

- LLM 深度整合:它支持与各种大语言模型(如 OpenAI、Claude、本地部署的 Ollama 等)进行集成,为智能体提供强大的语言理解和生成能力。

- 智能体(Agent)框架:OpenClaw 的核心是一个强大的智能体框架,允许开发者创建和部署能够执行特定任务的 AI 智能体。这些智能体可以根据自然语言指令,主动执行如信息检索、日程管理、自动化工作流等复杂任务。

- 丰富的技能生态:OpenClaw 拥有一个活跃的社区,提供了超过 700 种社区构建的技能(Skills),极大地扩展了其功能和应用场景。

- 本地优先与隐私保护:所有数据和 AI 模型的运行都可以在本地设备上完成,确保用户数据的隐私和安全。

三、高通 RB5 平台简介

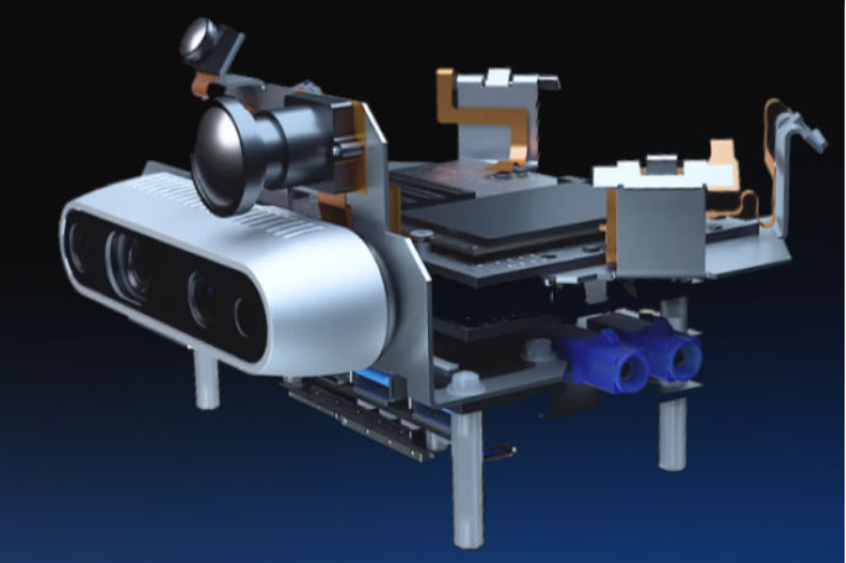

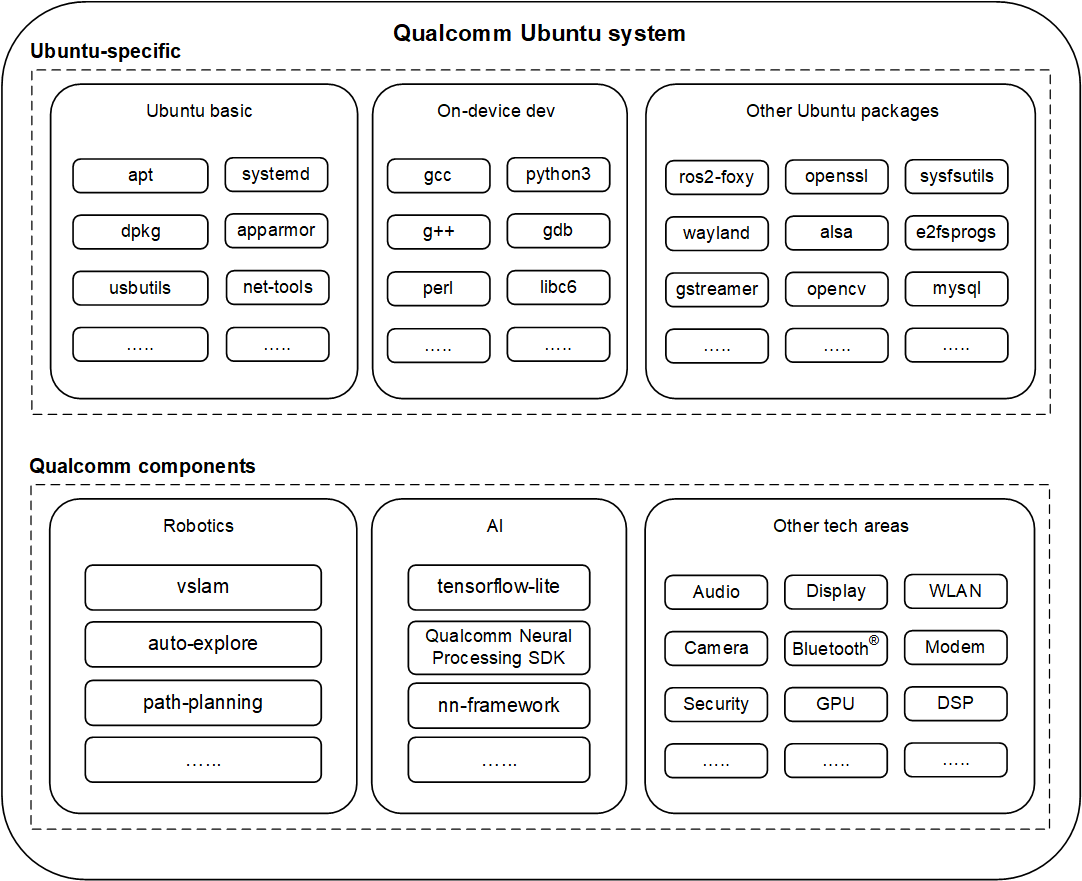

高通 RB5 平台(Qualcomm Robotics RB5 Platform)[2] 是专为机器人和无人机等边缘 AI 应用设计的高性能开发套件。它搭载了高通 QRB5165 处理器,该处理器集成了 Kryo 585 CPU、Adreno 650 GPU 和 Hexagon 698 DSP,提供了强大的异构计算能力,特别适合处理复杂的 AI 和机器学习工作负载。RB5 平台支持多种操作系统,其中基于 Ubuntu (如下图)的 Linux 发行版是其常用的开发环境。

RB5 平台的关键优势在于其卓越的 AI 性能和边缘计算能力,使其成为部署 OpenClaw 等本地 AI 智能体的理想选择。其强大的 DSP 和 GPU 可以为未来的 AI 模型推理提供硬件加速,进一步提升 OpenClaw 的响应速度和效率。

四、在高通 RB5 上部署 OpenClaw

本节将指导您完成在高通 RB5 开发板上部署 OpenClaw 的详细步骤。部署前,请确保您的 RB5 开发板已正确安装基于 Ubuntu 的操作系统,并具备稳定的网络连接。

1. 环境准备

首先,我们需要更新系统并安装必要的工具和依赖项。

sudo apt update

sudo apt upgrade -y

sudo apt install -y curl git build-essential

2. 安装 Node.js (推荐使用 NVM)

OpenClaw 要求 Node.js 版本为 22 或更高 [4]。为了方便管理 Node.js 版本,我们推荐使用 Node Version Manager (NVM) 进行安装。

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh | bash

安装完成后,关闭并重新打开终端,或运行 source ~/.bashrc (或 ~/.zshrc,取决于您的 shell) 以加载 NVM。然后,安装最新版本的 Node.js:

nvm install 22

nvm use 22

nvm alias default 22

node -v # 验证 Node.js 版本是否为 v22.x.x

npm -v # 验证 npm 版本

3. 安装 OpenClaw

Node.js 环境准备就绪后,您可以通过 npm 或 pnpm 全局安装 OpenClaw。

npm install -g openclaw@latest

# 或者使用 pnpm (如果已安装)

# pnpm add -g openclaw@latest

4. 初始化与运行 OpenClaw Gateway

安装完成后,需要初始化 OpenClaw 并启动其网关服务。onboard --install-daemon 命令会安装一个守护进程,确保 OpenClaw 服务在系统启动时自动运行。

openclaw onboard --install-daemon

openclaw gateway --port 18789 --verbose

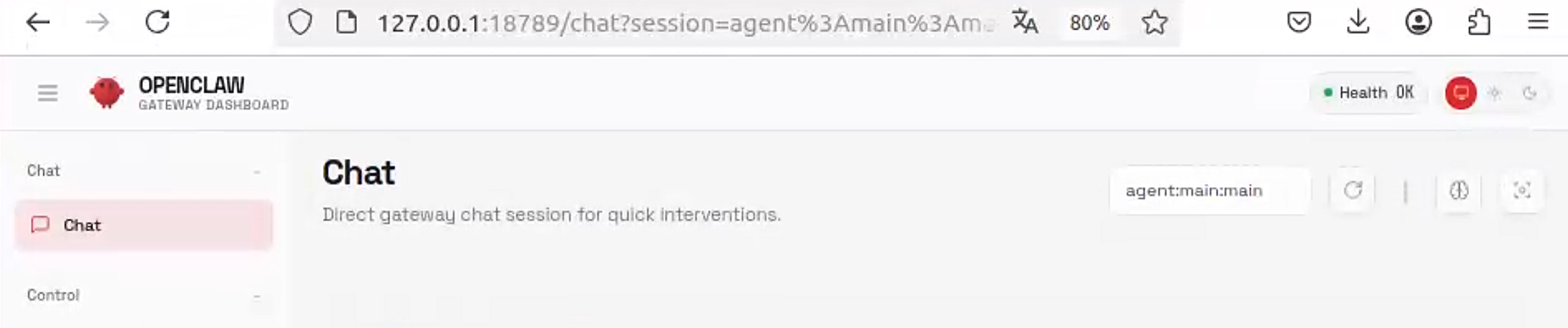

openclaw gateway --port 18789 --verbose 命令将启动 OpenClaw 网关服务,并监听 18789 端口。--verbose 参数将输出详细的运行日志,便于调试。此时,您可以通过浏览器访问 http://<RB5_IP_ADDRESS>:18789 来访问 OpenClaw 的 Web 界面进行进一步配置。

5. 配置与使用 OpenClaw

OpenClaw 启动后,您可以通过其 Web 界面或命令行工具进行配置。以下是一些常见的配置和使用场景:

- LLM 配置:在 Web 界面中,您可以配置接入不同的大语言模型。例如,您可以输入 OpenAI API Key,或配置本地 Ollama 服务的地址。

- 消息通道集成:根据您的需求,集成 WhatsApp、Telegram 等消息通道。这通常涉及到创建 Bot 并在 OpenClaw 中配置相应的 Token 或 Webhook。

- 创建和管理智能体:利用 OpenClaw 的智能体框架,您可以创建自定义智能体,并为其分配特定的技能和任务。

- 发送消息与交互:

# 发送一条消息

openclaw message send --to +1234567890 --message "Hello from OpenClaw"

# 与智能体对话

openclaw agent --message "帮我总结一下今天的邮件" --thinking high

五、总结与展望

通过本文的指导,您已成功在高通 RB5 开发板上部署了 OpenClaw,并初步了解了其强大的功能。将 OpenClaw 部署在边缘设备上,不仅提升了数据隐私和安全性,还为个人 AI 智能体的本地化运行开辟了新的可能性。未来,随着 OpenClaw 社区的不断壮大和 RB5 平台 AI 硬件加速能力的进一步开发,我们可以期待更多创新的应用场景,例如:

- 本地化 AI 助手:利用 RB5 的低功耗特性,打造全天候运行的本地 AI 助手,实现智能家居控制、个人数据管理等功能。

- 边缘 AI 推理:结合 RB5 的 DSP 和 GPU,将更复杂的 AI 模型部署到本地,实现更快速、更高效的推理。

- 机器人智能体:将 OpenClaw 智能体与 RB5 驱动的机器人相结合,赋予机器人更高级的自主决策和交互能力。

OpenClaw 与高通 RB5 的结合,为个人 AI 智能体的未来发展描绘了一个激动人心的蓝图。我们鼓励您深入探索 OpenClaw 的功能,并利用 RB5 平台的强大性能,创造出更多富有想象力的应用。

参考文献

[1] OpenClaw GitHub Repository

[2] 高通RB5平台介绍Qualcomm Robotics RB5 Platform Software Build Guide.

[3] OpenClaw System Requirements: OS, Node, and Hardware

更多推荐

已为社区贡献74条内容

已为社区贡献74条内容

所有评论(0)