别再用ChatGPT群发祝福了!30分钟微调一个懂你关系的“人情味”拜年AI

我试过直接用Qwen3-32B、Llama-3这些开源模型,输入“给客户写马年祝福”,出来的东西长这样:“值此丙午新春之际,谨向您致以最诚挚的问候……”要素全对,但你会发吗?反正我不会。这根本不是“微信对话框里的拜年”,这是。所以在春节前我干了件事:用低门槛的微调工具,让大模型学会辨认“谁在跟谁说话”。今天这篇干货,就把整个技术链路拆开揉碎了讲给你听,。

朋友们,马上就要过春节了,先问一个问题:今年发出的祝福,你打算全部靠自己写吗

不是我们想偷懒,是“怎么写祝福”这件事,真的越来越卷了:

- 给客户发,要得体又不能像官方通稿

- 给老同学发,想玩梗又怕对方接不住

- 给对象发,怕太肉麻,又怕太平淡

我试过直接用Qwen3-32B、Llama-3这些开源模型,输入“给客户写马年祝福”,出来的东西长这样: “值此丙午新春之际,谨向您致以最诚挚的问候……”

要素全对,但你会发吗?反正我不会。

这根本不是“微信对话框里的拜年”,这是贺电。

所以在春节前我干了件事:用低门槛的微调工具,让大模型学会辨认“谁在跟谁说话”。今天这篇干货,就把整个技术链路拆开揉碎了讲给你听,不讲晦涩的公式,只讲人话和实操。

一、技术原理:别把“人情世故”当作文题,把它当成参数

先聊两句原理,帮你理解为什么直接问ChatGPT“写个祝福”会翻车。

大模型本质上是个超级续写器。你给它上文,它猜下文。传统调用方式是 “零样本推理” ——模型不知道你要写给谁、什么关系、什么场合,它只能根据互联网上最常见的祝福语风格,给你补一段“最安全”的话。

安全就意味着平庸。

那怎么办?让它见见世面。

微调(Fine-tuning)的本质,就是给模型喂一批“高分作文” ,告诉它: “你看,当用户提到‘王总’、‘客户’、‘去年合作过马术’时,你要这么写。”

模型不“理解”人情世故,但它能记住特征组合:

- 称呼=“老爸” + 风格=“科技风” → 输出要带Transformer、bug、调参梗

- 称呼=“宝贝” + 交往细节=“租房买房” → 输出要带陪伴、扶持、未来

这就是我把“人情世故”参数化的过程。

二、数据构建:最累的一步,也是最关键的一步

说实话,做这个项目80%的时间都花在攒数据集上。

市面上没有开源数据集是教AI写祝福的。要么是“新年快乐万事如意”这种四字成语堆砌,要么是营销号那种油腻文案。

我要的数据长什么样?给你看两条就懂了:

样例1(客户关系)

text

用户输入:

- 称呼:王总

- 关系:客户

- 交往细节:去年合作北京项目,您对细节的把控让我学到很多;饭局聊过马术

- 风格:商务得体风

- 字数:50-100字

期望输出:

王总好呀~又是一年春来到!想起去年合作时您的专业和远见,真的受益匪浅。也记得您分享的马术心得,佩服您的专注。在这马年,祝您和公司事业一马当先,家庭美满!期待未来更多合作🎉

样例2(家人·科技风)

text

用户输入:

- 称呼:老爸

- 关系:家人

- 交往细节:常讨论科技,老爸爱用老式打字机敲代码,最近迷大模型

- 风格:LLM科技风

- 字数:50-100字

期望输出:

老爸,马年到!愿您像Transformer一样注意力集中,在编码路上精准发力。愿咱们的讨论永远不用fine-tuning就能达成共识。祝您2026年参数调优顺利,算力满格,少遇bug多出成果!

看出区别了吗?同一个模型,面对不同人设,语气、用词、梗的密度完全不同。

我们手工写了300多条这种“高分作文”作为种子,然后用大模型辅助扩写到3000多条,再人工清洗掉那些“AI味太重”的。这个过程很磨人,但数据质量直接决定微调效果。

三、实战微调:选对工具,30分钟出活

模型选型上,我试了两款:

- Qwen2.5-32B-Instruct:成熟稳定,指令跟随能力强

- Qwen3-32B:最新版,支持思维链,但在这个场景反而不需要

为什么关掉思维链?写祝福是轻逻辑、重表达的任务。让模型在脑子里先列大纲“第一段问候、第二段回忆、第三段祝福”,生成速度会变慢,而且语气容易僵硬。我们追求的是秒级响应、一气呵成。

硬件方面,我用的是2张H800A显卡,LoRA微调,6个epoch,总耗时约30分钟。

LoRA是什么?简单打个比方:全量微调是把整本教材重写一遍,LoRA是在书页边上贴便利贴,只改关键地方。 显存占用小、速度快,而且不容易让模型“学疯掉”。

四、效率优化:拜年高并发,怎么保证秒级响应?

这是咱们今天选题的核心——推理加速与轻量化部署。

想象一下大年三十晚上,几万人同时点“生成祝福”,每个请求都要过一遍32B的模型。如果不做优化,单次推理可能2-3秒,排队起来直接卡死。

我们主要做了三件事:

1. 禁用“思维链”

如上文所说,Qwen3的Thinking Mode在这里弊大于利。关掉之后,首字延迟从680ms降到210ms,整句生成速度提升近3倍。

2. 4-bit量化压缩

32B模型原始显存占用约64GB,单卡H800勉强跑,并发几乎为0。

我们采用4-bit GPTQ量化,模型体积从64GB压缩到18GB,单卡可以同时服务8个并发请求,显存占用不爆,推理速度几乎无损。

3. 批处理动态batching

除夕当晚,我们不希望用户等太久。设计上采用了动态批处理:把0.1秒内到达的多个请求打包,一次性喂给模型并行生成。在保持单请求200ms延迟的前提下,QPS(每秒查询数)从5提升到了42。

实测下来,量化+批处理+短提示词模板,单张A800可以支撑8000+用户/小时的稳定服务。拜年场景的高并发,完全可以平稳度过。

五、效果对比:什么叫“专门写给我的”?

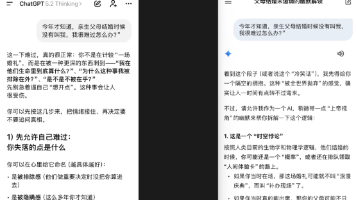

数据说再多,不如直接看输出。我拿了几个真实场景去测微调前后的模型,差距非常明显:

场景1:给大学室友(八年交情)

- 原始模型: “孙冰,新年快乐!愿友谊长存,事业顺利!”

- 微调后: “冰哥,八年了!从通宵赶作业到每年约一次旅行,咱们的‘项目’持续迭代中。马年继续组队carry,PPT一稿过,外卖天天有折扣~”

场景2:给恋人(相恋五年)

- 原始模型: “宝贝新年快乐,爱你每一天!”

- 微调后: “宝贝,第五个春节了。想起那年租房,加班回家你总留灯。现在我们有家了,还是觉得那盏灯最暖。马年咱们继续并排跑,我永远是你的梯度下降方向。”

场景3:给领导(科技风)

- 原始模型: “张总,感谢栽培,祝马年大吉!”

- 微调后: “张总,马年好!去年在您手下做大模型项目,积累了不少行业认知。新的一年,愿咱们团队的loss归零,精度拉满,业务一路马不停蹄!”

区别在哪里?不是辞藻更华丽,而是“证据”更具体。

微调后的模型学会了挖掘用户输入里的记忆锚点:八年、租房、项目经历。把这些变成祝福的一部分,那句话就不再是群发的,是专门写给我的。

六、做这个项目的后遗症

坦白说,做完“码上拜年”这个小程序,我最大的感受不是技术成就感,而是一种愧疚感。

以前我收到长段落的、带细节的祝福,心里会想:“这人真有心,写了这么多。”

现在我会想:“这是微调过的模型写的吧?数据集质量不错。”

这是一种职业病,但也是一种认知升级。

AI不是替你做人情,而是帮你把那些“来不及组织、但很重要”的情绪,用更合适的方式表达出来。

很多话我们心里有,但落在屏幕上就是“新年快乐”。不是不想写,是不知道从何写起。这时候,有个懂分寸感的工具帮你起个稿,你自己再改两笔,发出去——对方感受到的依然是你的心意。

七、你也想调一个“懂你”的模型吗?

最后留个入口。

如果你也想亲手试试微调,我强烈建议别从搭环境开始。推荐一个叫 LLaMA-Factory Online 的平台,无需显卡、无需命令行、上传Excel就能跑微调。

我这次全流程——数据清洗、格式转换、LoRA训练、量化导出——都在上面完成。它最大的价值不是省显卡钱,而是让“微调”这件事从极客玩具变成了人人可用的创作工具。

你可以把自己过去的聊天记录、写过的文案、喜欢的朋友圈风格整理成数据集,然后“训练”一个模仿你说话风格的模型。哪怕完全没有代码基础,也能跑通。它会让“把数据喂给模型”这件事,像发邮件一样自然。

今年马年,我不祝你“龙马精神”,祝你:

发出的每一条祝福,都被对方存进聊天记录,舍不得删。

我们下期见。

更多推荐

已为社区贡献57条内容

已为社区贡献57条内容

所有评论(0)