[论文阅读] AI + 软件工程 | 谁是最佳AI编码助手?5款主流工具的任务分层实证研究揭晓

AI编码助手的快速普及正在重塑软件工程实践,但不同代理在不同任务类型和时间维度的有效性对比仍较为缺乏。本文通过分析AIDev数据集中7156个拉取请求(PR),对OpenAI Codex、GitHub Copilot、Devin、Cursor和Claude Code五款主流代理开展实证研究。时间趋势分析显示代理演变模式存在异质性:Devin是唯一呈现PR接受率持续正向增长的代理(32周内每周+0.

谁是最佳AI编码助手?5款主流工具的任务分层实证研究揭晓

论文信息

- 原标题:Comparing AI Coding Agents: A Task-Stratified Analysis of Pull Request Acceptance

- 主要作者及研究机构:Giovanni Pinna(意大利特里埃斯特大学)、Jingzhi Gong(英国伦敦国王学院)、David Williams(英国伦敦大学学院)、Federica Sarro(英国伦敦大学学院)

- 引文格式(GB/T 7714):Pinna G,Gong J,Williams D,et al. Comparing AI Coding Agents: A Task-Stratified Analysis of Pull Request Acceptance[C]//23rd International Conference on Mining Software Repositories (MSR ’26). Rio de Janeiro: ACM,2026.

- 发表会议:2026年第23届挖掘软件仓库国际会议(MSR ’26)

一段话总结

这篇发表于MSR ’26的实证研究分析了AIDev数据集中5款主流AI编码代理(OpenAI Codex、GitHub Copilot、Devin、Cursor、Claude Code)的7156个拉取请求(PR),通过时间趋势分析、任务分层对比探究其PR接受率表现,发现Devin是唯一呈现持续正向性能趋势的代理(32周内每周接受率提升0.77%),任务类型是影响PR接受率的主导因素(不同任务间接受率差距达29个百分点,文档类82.1%远高于新功能类66.1%),且无单一代理在所有任务类型中表现最优:OpenAI Codex在各任务中接受率均保持较高水平(59.6%–88.6%),Claude Code在文档和新功能任务中领先,Cursor则在修复类任务中表现突出;研究还指出全局性能指标易受任务分布混杂影响,任务分层对比应成为AI编码代理评估的标准方法,同时PR接受率无法完全代表代码质量,需结合其他指标综合评价。

研究背景

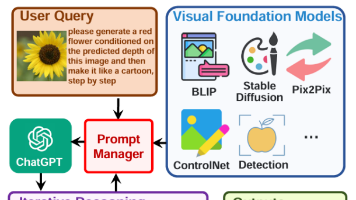

AI编码助手的爆发式发展正在重构软件工程的工作模式,从最初的GitHub Copilot代码补全,到Devin、Cursor这类能自主生成函数、修复Bug、创建拉取请求(PR)的自治代理,软件工程正式迈入了“SE 3.0”时代——AI成为只需少量人类监督就能完成复杂开发任务的自治队友。

但在行业快速发展的背后,核心评估问题始终悬而未决:不同AI编码代理在实际开发流程中的效果到底如何对比?哪些因素会影响它们的性能?性能是否会随时间发生变化?

更关键的是,传统的全局性能指标(如整体PR接受率)存在严重的评估误区。举个例子,若A代理主要处理高接受率的文档编写任务,B代理专注于复杂的新功能开发,仅看全局指标会误以为A远优于B,却忽略了二者的任务难度差异。这种因任务分布混杂导致的评估偏差,让开发者选工具、研究者做评估、工具商做优化都缺乏可靠依据,这也是该领域亟待解决的核心痛点。

创新点

- 时间维度的长期追踪:首次对5款主流AI编码代理进行了跨周期的性能演变分析,最长观测窗口达32周,揭示了不同代理的性能时间变化规律。

- 任务分层的评估方法:提出并实践了任务分层对比法,打破传统全局指标的评估误区,控制任务分布混杂的干扰,让不同代理的性能对比更客观。

- 多维度的实证分析:结合PR接受率、评审频率、任务分布偏移等多维度指标,不仅对比了代理性能,还探究了性能差异的核心影响因素,为领域研究提供了可复用的实证框架。

- 大样本的真实场景验证:基于7156个来自真实高星GitHub仓库的AI生成PR展开分析,样本覆盖5款代理、12类开发任务,研究结论更贴近工业界实际应用场景。

研究方法和思路

本次研究围绕3个核心研究问题(RQ) 展开,通过数据筛选-指标定义-统计分析-结果验证的四步思路完成实证研究,整体方法可拆解为以下关键步骤:

步骤1:数据集选取与预处理

选用AIDev数据集的高星仓库子集(AIDev-POP,仓库星数≥100),原始数据包含33596个AI生成PR,通过3条质量标准筛选出7156个有效PR:

- 仅保留已关闭的PR,排除未处理的无效样本;

- 仅选取采用MIT/Apache-2.0宽松许可证的仓库,保证数据可用性;

- 要求每个PR在关闭前至少有1条非创建者的评审/评论,确保PR经过了实际人工评估。

最终样本覆盖5款主流AI编码代理,各代理的观测窗口、PR数量等基础信息如下:

| 代理 | 观测起始时间 | 有效PR数 | 活跃周数 | 周均PR数 | 整体PR接受率 |

|---|---|---|---|---|---|

| Devin | 2024-12-24 | 2252 | 32 | 70.4 | 61.6% |

| OpenAI Codex | 2025-05-16 | 2002 | 12 | 166.8 | 77.9% |

| GitHub Copilot | 2025-05-19 | 2194 | 11 | 199.5 | 68.0% |

| Cursor | 2025-05-01 | 569 | 13 | 43.8 | 74.5% |

| Claude Code | 2025-02-24 | 139 | 19 | 7.3 | 71.9% |

步骤2:核心指标与统计方法定义

- 核心评估指标:以PR接受率(合并PR占已关闭PR的比例)为核心成功指标,同时引入评审频率(单PR的人工评审次数)、任务分层观测(代理-任务-周的唯一组合)为辅助指标;

- 时间趋势分析:用线性回归拟合代理每周PR接受率的变化,通过R²衡量拟合度,同时用LOESS局部平滑法捕捉非线性趋势;

- 代理对比分析:采用分层卡方检验做代理间两两对比,对小样本场景用Fisher精确检验,通过Bonferroni校正控制多重检验误差,用phi系数衡量性能差异的效应大小;

- 敏感性验证:为解决不同代理观测窗口不一致的问题,选取所有代理的11周共同观测窗口重复分析,验证结果的稳定性。

步骤3:分研究问题开展分析

针对3个核心研究问题,分别设计针对性分析方案:

- RQ1(性能时间演变):拟合各代理的PR接受率时间趋势,对比线性变化斜率与稳定性;

- RQ2(性能影响因素):统计12类任务的PR接受率,分析任务类型的影响,同时探究评审频率与接受率的相关性;

- RQ3(代理性能对比):先分析各代理的任务分布差异,再通过任务分层法对比不同代理在同类任务中的性能,筛选出统计上显著的性能差异。

主要成果和贡献

本次研究通过对7156个有效PR的全面分析,明确回答了3个核心研究问题,同时为AI编码代理的评估、选择和优化提供了可落地的实证结论,核心成果和领域贡献如下:

一、3大研究问题的核心结论

| 研究问题 | 核心分析内容 | 直白结论 |

|---|---|---|

| RQ1:AI编码代理性能是否随时间演变? | 拟合32周内各代理PR接受率的时间趋势,分析斜率与稳定性 | 仅Devin呈现持续正向性能演变(每周接受率+0.77%,从60%升至80%),其余4款代理性能全程保持稳定,无明显上升/下降趋势 |

| RQ2:哪些因素与代理性能相关? | 统计12类任务的PR接受率,分析任务分布、评审频率的影响 | 任务类型是主导因素(不同任务接受率差距达29个百分点),评审频率与接受率存在关联但无因果;全局指标易受任务分布混杂,评估偏差大 |

| RQ3:不同代理性能如何对比? | 任务分层下的代理两两对比,筛选统计显著的性能差异 | 无单一代理在所有任务中最优,各代理有专属任务优势;性能差异在修复、新功能等核心开发任务中最显著 |

二、研究的核心发现

- 任务类型的影响远超代理差异:不同开发任务的PR接受率差距达29个百分点,杂项类(84.0%)、文档类(82.1%)接受率最高,性能优化类(55.4%)最低;文档类比新功能类接受率高16个百分点,该差距超过了大多数任务中代理间的性能差异。

- 各代理的任务专属优势明确:任务分层下,无“全能型”代理,各工具的核心优势场景清晰:

- OpenAI Codex:综合性能最稳定,9类任务接受率均在59.6%-88.6%,在修复(83.0%)、重构(74.3%)任务中领先;

- Claude Code:在文档(92.3%)、新功能(72.6%)任务中表现最佳(注:样本量较小,需谨慎解读);

- Cursor:在修复(80.4%)、测试(77.8%)任务中优势显著;

- Devin/GitHub Copilot:无明显优势任务,Devin在修复任务中存在明显短板。

- Devin的性能提升被低估:Devin在观测期内逐步向更复杂的新功能任务倾斜(占比+9.8个百分点),但其接受率仍持续提升,说明其实际能力增长比观测结果更显著。

- 性能差异的核心场景聚焦:代理间的统计显著性能差异,5/6集中在修复任务,1/6在新功能任务,说明在核心开发活动中,代理的选择对结果影响更大。

三、对领域的实实在在的价值

1. 对开发者/企业:工具选择的精准指南

- 修复、测试任务:优先选择OpenAI Codex或Cursor,二者接受率远高于其他代理;

- 文档、新功能开发:可考虑Claude Code,发挥其专项优势;

- 文档类任务:代理间差异极小(接受率均>79%),可根据团队使用习惯选择,无需刻意对比;

- 长期项目:可关注Devin,其性能呈持续提升趋势,未来潜力值得期待。

2. 对工具开发者:优化方向的明确参考

- Devin:需重点优化修复任务的能力,弥补核心短板;

- GitHub Copilot:可降低PR的人工评审频率,提升开发效率;

- 所有工具:可针对性能优化、测试等低接受率任务做专项模型优化,提升核心场景表现。

3. 对研究者:评估方法的范式革新

- 提出任务分层对比法,成为AI编码代理评估的标准方法,解决了全局指标的评估误区;

- 验证了“PR接受率+代码质量+维护成本”的多指标评估思路,为后续研究提供了可复用的框架;

- 公开了大样本实证数据,为领域的后续研究提供了基础支撑。

四、开源资源

本次研究的所有数据、分析脚本、实验结果及补充材料均已开源,地址:https://github.com/giovannipinna96/Comparing_AI_Coding_Agents

详细总结

本研究是发表于2026年第23届挖掘软件仓库国际会议(MSR ’26)的实证研究,由多所高校学者联合开展,核心围绕5款主流AI编码代理的性能展开任务分层与时间维度的对比分析,旨在解决AI编码代理在实际软件工程流程中性能对比、影响因素及演变规律的核心问题,以下为详细研究内容与结论:

一、研究背景与核心问题

- 行业现状:AI编码助手(如GitHub Copilot、Devin)推动软件工程进入“SE 3.0”时代,可自主完成代码生成、bug修复、创建PR等工作,但缺乏跨任务、跨时间的系统性能对比,且全局性能指标易受任务分布混杂,导致评估结果失真。

- 研究意义:为从业者选工具、开发者优化产品、研究者设计评估方法提供实证依据。

- 核心研究问题(RQ):

- RQ1:AI编码代理的性能是否随时间发生可测量的变化?

- RQ2:哪些因素(任务类型、评审频率等)与PR接受率相关,任务分布是否会混淆全局对比?

- RQ3:不同AI编码代理在任务分层下的性能差异如何?

二、研究方法

-

数据集与预处理

- 采用AIDev数据集的高星仓库子集(AIDev-POP),原始33596个PR,经筛选后保留7156个有效PR(闭源PR、MIT/Apache-2.0许可证、经非创建者评审/评论)。

- 涉及5款代理,各代理的PR分布、观测窗口及整体接受率如下表:

| Agent | 起始时间 | PR数量 | 活跃周数 | 周均PR | 整体接受率 |

|-------|----------|--------|----------|--------|------------|

| Devin | 12/24/24 | 2252 | 32 | 70.4 | 61.6% |

| OpenAI Codex | 05/16/25 | 2002 | 12 | 166.8 | 77.9% |

| GitHub Copilot | 05/19/25 | 2194 | 11 | 199.5 | 68.0% |

| Cursor | 05/01/25 | 569 | 13 | 43.8 | 74.5% |

| Claude Code | 02/24/25 | 139 | 19 | 7.3 | 71.9% |

| 总计 | - | 7156 | 87 | - | 69.3% |

-

评估指标

- 核心指标:PR接受率(合并PR占闭源PR的比例);

- 辅助指标:任务分层观测、评审频率(每个PR的评审次数)。

-

统计方法

- 时间趋势:线性回归(拟合每周接受率变化)、LOESS平滑(捕捉非线性趋势);

- 因素分析:任务级接受率统计、评审频率相关性分析;

- 代理对比:分层卡方检验、Fisher精确检验(小样本)、Bonferroni校正(控制多重检验),并通过phi系数衡量效应量。

三、核心研究结果

(一)RQ1:性能随时间的演变——仅Devin持续正向提升

- Devin:32周内呈现显著的正向线性趋势,每周接受率提升0.77%(R²=0.34),接受率从约60%升至80%,但周度方差较大,性能仍不稳定;

- 其余代理(OpenAI Codex、GitHub Copilot、Cursor、Claude Code):自观测初期起接受率便趋于平稳,无明显上升/下降趋势。

(二)RQ2:性能的影响因素——任务类型是主导因素

- 任务类型的核心影响:不同任务类型的PR接受率差距达29个百分点,远超过代理间的方差,各任务接受率如下表:

| 任务类型 | chore(杂项) | docs(文档) | style(样式) | ci(持续集成) | build(构建) | refactor(重构) | feat(新功能) | fix(修复) | test(测试) | perf(性能) |

|----------|---------------|--------------|---------------|----------------|---------------|-----------------|---------------|-------------|--------------|--------------|

| 平均接受率 | 84.0% | 82.1% | 78.1% | 75.0% | 72.5% | 71.2% | 66.1% | 66.0% | 61.5% | 55.4% |

- 关键差距:文档类任务(82.1%)比新功能类(66.1%)高16个百分点,结构清晰的任务接受率显著更高。

- 评审频率的关联:GitHub Copilot的PR评审频率最高(4.94次/PR),接受率却较低(68.0%);OpenAI Codex评审频率最低(1.39次/PR),接受率最高(77.9%),但二者无明确因果关系,或受任务复杂度、仓库评审政策影响。

(三)RQ3:任务分层的代理对比——无单一最优代理,各有专属优势

- 任务分布混杂全局指标:各代理的核心处理任务差异显著(如GitHub Copilot41.6%为修复任务,Claude Code52.5%为新功能任务),直接全局对比会产生误导,任务分层是必要前提。

- 各代理的任务专属优势:

- OpenAI Codex:全9类任务接受率均处于59.6%–88.6% 的高位,在修复(83.0%)、重构(74.3%)任务中领先;

- Claude Code:在文档(92.3%)、新功能(72.6%)任务中表现最佳(注:样本量较小,结果需谨慎解读);

- Cursor:在修复任务(80.4%)、测试任务(77.8%)中突出;

- Devin:无明显优势任务,在修复任务中接受率偏低,是其性能短板。

- 统计显著性:64次分层检验中仅6次通过Bonferroni校正(α≈0.00078),且5次集中在修复任务,说明代理间的性能差异在核心开发活动(修复、新功能) 中最易检测。

四、讨论与分析

- 敏感性分析:对齐所有代理的11周共同观测窗口后,结果与原分析一致,OpenAI Codex仍为接受率最高(79.9%),Devin与GitHub Copilot均为68.0%。

- 任务分布偏移:部分代理随时间向更复杂的任务倾斜(如Devin新功能任务占比+9.8pp),其接受率的提升或低估了实际能力增长。

- 实践与研究启示

- 从业者:按任务类型选择/组合代理,修复、测试任务需重点考量代理性能,文档任务代理间差异极小;

- 研究者:任务分层应成为AI编码代理评估的标准方法,需同时报告任务分布与全局指标;PR接受率无法代表代码质量,需补充静态分析、代码复杂度、维护成本等指标。

- 研究局限性

- 内部效度:无法确定性能趋势的因果(模型更新/用户学习/任务偏移);

- 外部效度:仅覆盖高星仓库,难以推广至小型项目;

- 构念效度:PR接受率≠代码质量,AI生成代码可能存在安全漏洞;

- 数据局限:Claude Code样本量仅139个PR,部分代理观测窗口不均。

五、研究结论

- 任务类型是影响PR接受率的主导因素,不同任务间29个百分点的差距远超代理间方差,任务分层对比是避免评估失真的关键;

- 无单一AI编码代理在所有任务中表现最优,OpenAI Codex的综合性能最稳定,Claude Code、Cursor则在特定任务中具备显著优势;

- 仅Devin呈现持续的正向性能演变(32周每周+0.77%),其余代理性能自观测初期便趋于平稳;

- PR接受率作为单一评估指标存在缺陷,未来研究需结合代码质量、静态分析、维护负担等指标进行综合评价。

关键问题

问题1(侧重研究核心发现):该研究中影响AI编码代理PR接受率的最关键因素是什么,其具体影响程度如何?

答案:任务类型是影响PR接受率的主导因素,不同任务类型间的PR接受率差距达29个百分点,远超过代理间的方差;其中杂项类任务接受率最高(84.0%),性能优化类最低(55.4%),高-volume任务中文档类(82.1%)比新功能类(66.1%)高16个百分点,且该差距超过了大多数任务中代理间的性能差异,是导致PR接受率差异的核心原因。

问题2(侧重代理性能特征):5款主流AI编码代理在性能演变和任务表现上的核心差异是什么,是否存在综合性能最优的代理?

答案:性能演变上,Devin是唯一呈现持续正向趋势的代理(32周每周接受率+0.77%),其余代理均保持性能稳定;任务表现上,无单一综合性能最优的代理,各代理有专属优势:OpenAI Codex全任务接受率均处于59.6%–88.6%的高位,综合最稳定;Claude Code在文档、新功能任务中领先;Cursor在修复、测试任务中突出;GitHub Copilot与Devin无明显优势任务,且Devin在修复任务中存在性能短板。

问题3(侧重研究方法与行业启示):该研究指出传统全局指标评估AI编码代理存在缺陷,其核心问题是什么,对应的解决方案和行业启示有哪些?

答案:核心问题是全局性能指标易受代理的任务分布混杂,若某代理主要处理高接受率的简单任务(如文档),另一代理处理低接受率的复杂任务(如新功能),直接全局对比会误导对代理实际能力的判断。对应的解决方案是将任务分层对比作为AI编码代理评估的标准方法,同时报告任务分布与全局指标,并结合代码质量、静态分析、维护成本等指标补充评估。行业启示方面,从业者应根据具体任务类型选择或组合代理,修复、测试等核心开发任务需重点考量代理性能;工具开发者可针对代理的任务短板进行能力优化;研究者需在评估中引入分层方法,避免单一指标和全局对比的局限性。

研究总结

本研究是首项针对5款主流AI编码代理的任务分层+时间维度的大样本实证研究,通过对7156个来自真实高星仓库的AI生成PR的分析,明确了AI编码代理性能的核心影响因素和演变规律。研究发现,任务类型是影响PR接受率的主导因素,其影响远超过代理间的固有差异,传统全局指标因受任务分布混杂影响,存在严重评估偏差;同时,仅Devin呈现持续的正向性能演变,其余代理性能保持稳定,且无单一代理在所有任务中表现最优,各代理均有其专属的任务优势场景。

该研究的最大价值,不仅是揭晓了5款主流AI编码代理的性能差异,更重要的是突破了AI编码代理的传统评估误区,提出的任务分层对比法为领域建立了更科学的评估范式,同时为开发者选工具、工具商做优化、研究者做评估提供了全面且可落地的实证依据。未来,AI编码代理的评估需结合任务场景、时间演变、代码质量等多维度指标,才能更客观地反映其实际能力。

更多推荐

已为社区贡献108条内容

已为社区贡献108条内容

所有评论(0)