烧了 2 万美金让 16 个 AI 写编译器,Claude Agent Teams 到底在证明什么

Anthropic近期实验显示,16个Claude Opus 4.6 AI代理协作两周、花费约2万美元,成功开发出10万行Rust代码的C编译器。该编译器能编译Linux内核等复杂项目,支持多架构,并通过大部分C标准测试。实验证明AI可完成系统级工程任务,且成本已接近商业可行范围(相比人类工程师半年10万美元成本)。尽管编译质量、优化能力和维护性仍有待验证,但该实验标志着AI编程从单任务辅助迈向团

Anthropic 在发布 Opus 4.6 的时候,附带公布了一个内部实验的结果:他们用 16 个 Claude Opus 4.6 Agent 组成一个团队,从零写出了一个 10 万行的 C 编译器。

用 Rust 写的。能编译 Linux Kernel。花了接近 2 万美元。

The Register 的报道标题很直白:“Anthropic’s Claude Opus 4.6 spends $20K trying to write a C compiler”。

这件事在开发者社区引发了不少讨论。有人觉得这是 AI 编程的里程碑,有人觉得这就是烧钱搞噱头。我两边都能理解,但仔细看了技术细节之后,觉得这件事比表面看起来要有意思得多。

实验的具体数据

先把数字摆出来:

| 指标 | 数值 |

|---|---|

| Agent 数量 | 16 个 |

| 运行时间 | 约 2 周 |

| 输入 token | 20 亿 |

| 输出 token | 1.4 亿 |

| 总成本 | ~$20,000 |

| 代码行数 | ~100,000 行 Rust |

| Claude Code 会话数 | ~2,000 次 |

这个编译器不是玩具项目。它能编译的东西包括:

- Linux Kernel 6.9

- QEMU

- SQLite

- Redis

- Doom(是的,那个 Doom)

支持多种 CPU 架构。能通过大部分 C 标准的合规测试。

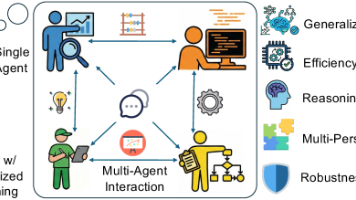

Agent Teams 怎么分工

16 个 Agent 不是各写各的。它们有明确的分工。

有的 Agent 负责实现编译器的前端(词法分析、语法解析)。有的负责中间表示和优化 pass。有的负责后端代码生成。还有 Agent 专门写测试,专门做 code review,专门处理 Git 合并冲突。

对,AI 也要处理 Git 冲突。16 个 Agent 同时往一个仓库提交代码,冲突是必然的。Anthropic 的解决方案是让一个 Agent 专门扮演"合并工程师"的角色,负责协调各方的代码变更。

这个分工方式和人类工程团队几乎一样。区别在于,人类团队 16 个人写 10 万行代码大概需要几个月到半年。这群 Agent 用了两周。

2 万美元贵不贵

我帮 Anthropic 算了一笔账。

Opus 4.6 的定价是输入 $5/百万 token,输出 $25/百万 token。

20 亿输入 token × $5/百万 = $10,000

1.4 亿输出 token × $25/百万 = $3,500

总计约 $13,500。和报道中的"接近 $20,000"有差距,可能是因为用了 Extended Thinking 模式(thinking token 按输出价格计费),或者有重试和失败的会话没计入有效 token。

但不管是 1.35 万还是 2 万,关键问题是:这个成本合理吗?

如果雇一个高级 Rust 工程师从零写一个 C 编译器,年薪按 $200K 算,写半年就是 $100K。Agent 花了 $20K,完成了 80% 以上的工作(后续可能还需要人类做精调和修 corner case)。

纯从成本角度看,$20K 买 10 万行能用的编译器代码,不贵。

但这么比有个问题:编译器工程师的薪资那么高,一部分原因是能写编译器的人很少。如果 AI 能写了,需求端和供给端都会变。这笔经济账会越来越复杂。

编译器质量到底怎么样

能编译 Linux Kernel 说明基本功扎实——Linux Kernel 的 C 代码用了大量 GCC 扩展和奇怪的宏技巧,对编译器的兼容性要求很高。

但能编译不代表编译得好。几个我关心的问题:

优化能力。 一个编译器能不能用,不只看能不能编译通过,还要看生成的代码跑得快不快。文章没有提到和 GCC/Clang 的性能对比数据。如果生成的代码比 GCC -O2 慢 5 倍,那实用性就大打折扣。

错误信息质量。 好的编译器在你写错的时候会告诉你错在哪、为什么错。Clang 在这方面做得很好。AI 写的编译器在 error reporting 上大概率不如 Clang——因为好的错误信息需要对开发者心理模型的理解,这不是纯工程能力能解决的。

维护性。 10 万行代码写出来了,谁来维护?AI 写的代码,人类读起来顺不顺畅?如果后续需要修 bug 或者加新特性,人类工程师能接手吗?这些问题在发布的材料里都没提到。

这个实验真正在证明的事

如果只看"AI 写了个编译器"这个结论,确实像噱头。编译器已经有 GCC 和 Clang 了,没人需要 AI 再写一个。

但 Anthropic 想证明的不是"AI 能写编译器",而是三件事:

第一,Agent 协作是可行的。 16 个 Agent 能在同一个代码库上并行工作,处理分支、冲突、Code Review,跑完一个完整的软件工程流程。这在之前没有人做到过。

第二,AI 能处理大规模工程任务。 之前 AI 编程的上限是"帮你写个函数"或者"帮你修个 bug"。100 行、1000 行的任务。这次是 10 万行,是系统级别的工程。量变到质变。

第三,成本已经到了商业可行的区间。 $20K 写 10 万行代码。按每行 $0.20 算,比外包便宜,比雇全职更便宜。如果推理成本继续下降(过去一年降了 80%),这个数字会越来越小。

对普通开发者意味着什么

坦白说,短期内不意味着什么。

你不会明天就被 16 个 Agent 替代。大部分公司的项目不需要从零写编译器级别的代码。日常业务开发中,AI 的角色在很长一段时间内还是"助手"而不是"团队"。

但中期来看,值得思考几个变化:

项目启动成本会下降。 以前从零搭一个新系统,光是脚手架和基础设施代码就要写几周。如果 Agent Teams 能把这些重复性的系统级代码自动生成,开发者可以直接从业务逻辑开始写。

代码审查会变得更重要。 当 AI 能产出大量代码的时候,瓶颈就不在"写"上了,而在"审"上。能快速阅读、理解、评估 AI 生成代码的人会更值钱。

架构能力比编码能力更值钱。 AI 擅长的是"按照规范实现功能"。它不擅长的是"决定应该做什么、不应该做什么"。系统设计、技术选型、权衡取舍,这些依然需要人来做。

一个让我有点不安的问题

2000 次 Claude Code 会话,两周时间,16 个 Agent。这个规模的自动化开发,如果哪个步骤出了问题——比如某个 Agent 写出了有安全漏洞的代码,或者两个 Agent 的代码合并后产生了微妙的逻辑错误——谁来负责?

人类团队也会犯错,但人类有动机去减少错误(你写了 bug,你来修)。Agent 没有这个激励。它完成了任务就完成了,至于代码里埋了什么坑,它不在乎。

现在这只是一个内部实验。但如果这种工作方式推广开来,代码审计和质量保证的重要性会大幅提升。

写代码越来越容易了。确保代码是对的,才是难的部分。

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)