深度强化学习电气工程复现文章 关键词:能源管理系统 多主体强化学习 需求侧响应 智能电网 编程语言

深度强化学习电气工程复现文章关键词:能源管理系统 多主体强化学习 需求侧响应 智能电网编程语言:python平台主题:可扩展的多代理强化学习用于分布式控制住宅能源灵活性内容简介:摘要—针对分布式住宅能源,提出了一种新的可扩展的基于多智能体强化学习的协调方法。协作主体学习在一个部分可观测的随机环境中控制电动汽车、空间加热和柔性负载提供的灵活性。在标准独立 Q- 学习方法中,随机环境中局部可观测智能体

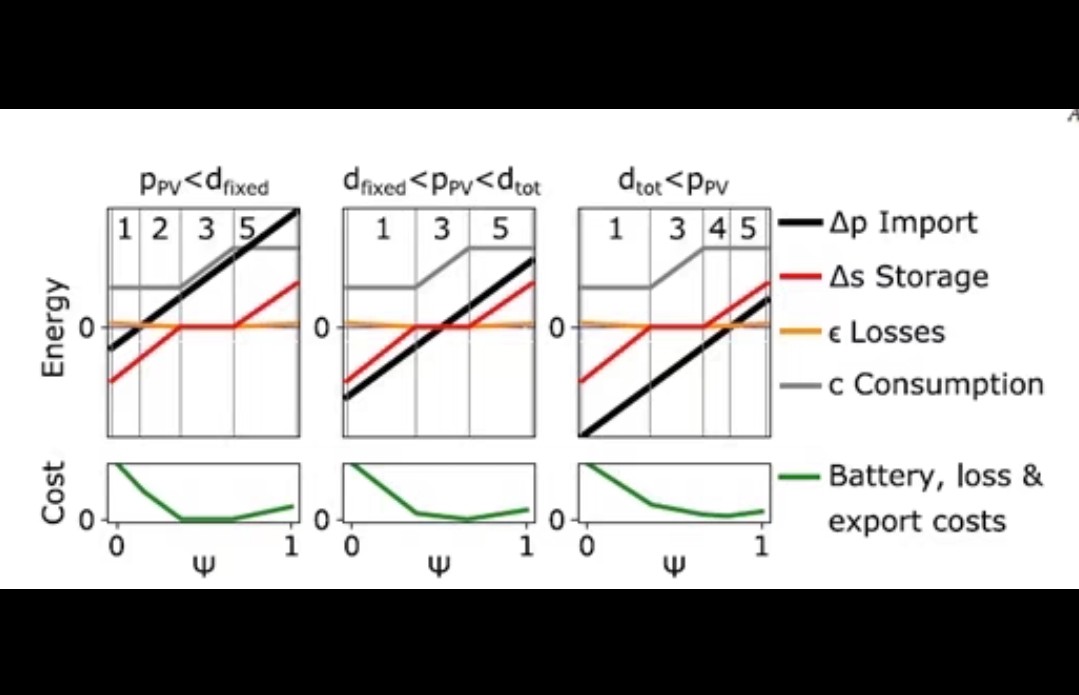

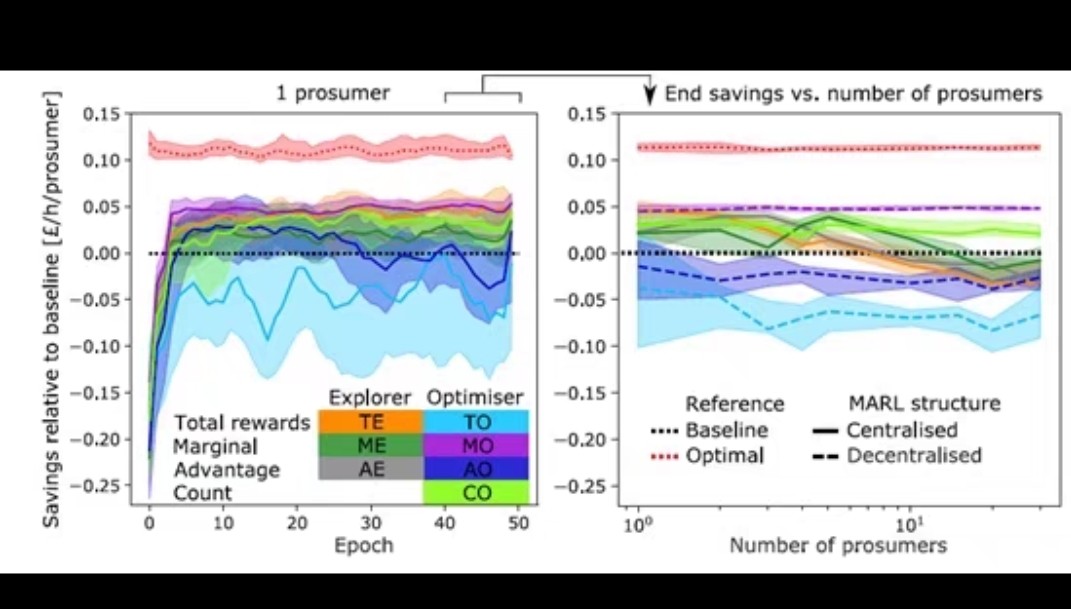

深度强化学习电气工程复现文章 关键词:能源管理系统 多主体强化学习 需求侧响应 智能电网 编程语言:python平台 主题:可扩展的多代理强化学习用于分布式控制住宅能源灵活性 内容简介: 摘要—针对分布式住宅能源,提出了一种新的可扩展的基于多智能体强化学习的协调方法。 协作主体学习在一个部分可观测的随机环境中控制电动汽车、空间加热和柔性负载提供的灵活性。 在标准独立 Q- 学习方法中,随机环境中局部可观测智能体的协调性能随尺度的变化而下降。 在这里,从历史数据的离线凸优化学习和隔离边际贡献的奖励信号总回报的新组合增加稳定性和表现的规模。 使用固定大小的 Q 表,消费者能够评估他们对整个系统目标的边际影响,而无需彼此或与中央协调员共享个人数据。 案例研究用于评估探索资源、奖励定义和多主体学习框架的不同组合的适应性。 结果表明,由于能源进口成本、损失、配送拥塞控制、电池折旧和温室气体排放的降低,拟议的战略在个人和系统层面创造了价值。 复现论文截图:

在智能电网的背景下,如何有效地管理分布式住宅能源成为一个热门话题。最近,我读了一篇关于使用多智能体强化学习(MARL)来协调控制住宅能源灵活性的论文,觉得特别有意思。这篇论文提出了一种新的方法,通过多智能体协作来优化电动汽车、空间加热和柔性负载的管理,从而提高能源系统的整体效率。

多智能体强化学习的基本概念

首先,我们得明白什么是多智能体强化学习。简单来说,它是在强化学习的基础上,引入了多个智能体,这些智能体可以相互协作或竞争,以达到共同或各自的目标。在能源管理系统中,每个住宅可以看作一个智能体,它们需要根据局部观测到的信息来做出决策,同时这些决策又会影响整个电网的稳定性。

论文的核心方法

论文提出了一种新的方法,通过结合历史数据的离线凸优化学习和隔离边际贡献的奖励信号,来增加系统的稳定性和表现。这种方法的一个亮点是,它使用固定大小的Q表,使得消费者能够评估他们对整个系统目标的边际影响,而无需彼此或与中央协调员共享个人数据。

代码实现与分析

让我们来看看如何用Python实现这个方法的简化版本。首先,我们需要定义每个智能体的Q表和学习算法。

import numpy as np

class Agent:

def __init__(self, state_size, action_size):

self.state_size = state_size

self.action_size = action_size

self.Q = np.zeros((state_size, action_size))

self.alpha = 0.1 # 学习率

self.gamma = 0.9 # 折扣因子

def choose_action(self, state):

return np.argmax(self.Q[state, :])

def learn(self, state, action, reward, next_state):

predict = self.Q[state, action]

target = reward + self.gamma * np.max(self.Q[next_state, :])

self.Q[state, action] += self.alpha * (target - predict)在这个代码中,我们定义了一个Agent类,每个智能体都有自己的Q表。choose_action方法用于根据当前状态选择动作,learn方法则用于更新Q表。

案例研究

论文中还提到了一个案例研究,评估了不同资源探索、奖励定义和多主体学习框架组合的适应性。结果表明,提出的策略在个人和系统层面都创造了价值,包括降低了能源进口成本、损失、配送拥塞控制、电池折旧和温室气体排放。

结论

通过这篇论文的复现,我深刻体会到多智能体强化学习在分布式能源管理中的潜力。这种方法不仅提高了系统的整体效率,还保护了用户的隐私,因为它不需要共享个人数据。当然,实际应用中还需要考虑更多的细节和挑战,但无疑这是一个非常有前景的研究方向。

深度强化学习电气工程复现文章 关键词:能源管理系统 多主体强化学习 需求侧响应 智能电网 编程语言:python平台 主题:可扩展的多代理强化学习用于分布式控制住宅能源灵活性 内容简介: 摘要—针对分布式住宅能源,提出了一种新的可扩展的基于多智能体强化学习的协调方法。 协作主体学习在一个部分可观测的随机环境中控制电动汽车、空间加热和柔性负载提供的灵活性。 在标准独立 Q- 学习方法中,随机环境中局部可观测智能体的协调性能随尺度的变化而下降。 在这里,从历史数据的离线凸优化学习和隔离边际贡献的奖励信号总回报的新组合增加稳定性和表现的规模。 使用固定大小的 Q 表,消费者能够评估他们对整个系统目标的边际影响,而无需彼此或与中央协调员共享个人数据。 案例研究用于评估探索资源、奖励定义和多主体学习框架的不同组合的适应性。 结果表明,由于能源进口成本、损失、配送拥塞控制、电池折旧和温室气体排放的降低,拟议的战略在个人和系统层面创造了价值。 复现论文截图:

如果你也对智能电网和强化学习感兴趣,不妨试试自己动手实现一下这个算法,相信会有更多的收获!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)