2026年维普AIGC查重率高?DeepSeek+豆包+Kimi组合降AI实测

实测用DeepSeek、豆包、Kimi三个AI组合写论文,维普AIGC查重率反而飙到87.3%的原因分析。详解三个AI各自的语言指纹特征以及为什么混合使用会被检测引擎三重命中。分享正确的多AI协作降AI流程和指令模板,以及嘎嘎降AI等四款专业工具的实测效果对比,帮助同学们找到高效降低维普AIGC检测率的方法。

用了三个AI写论文,维普查重直接飙到87%

上周五晚上十一点半,我室友老张抱着笔记本电脑冲进宿舍,脸都绿了。他花了整整一周,用DeepSeek写大纲、豆包扩写段落、Kimi润色语言,自以为搞了个天衣无缝的"AI接力"方案。结果维普AIGC检测一出来:87.3%。整篇论文几乎被标红了,离答辩只剩不到两周。

我当时也懵了。之前网上不是都说多个AI混着用能降低查重吗?怎么反而更高了?后来花了三天时间反复测试,才搞明白这里面的门道。今天就把这些实测经验全部分享出来,帮大家少走弯路。

DeepSeek+豆包+Kimi组合为什么翻车了

先说结论:不是多个AI混用就能骗过检测系统,反而可能更容易被抓。

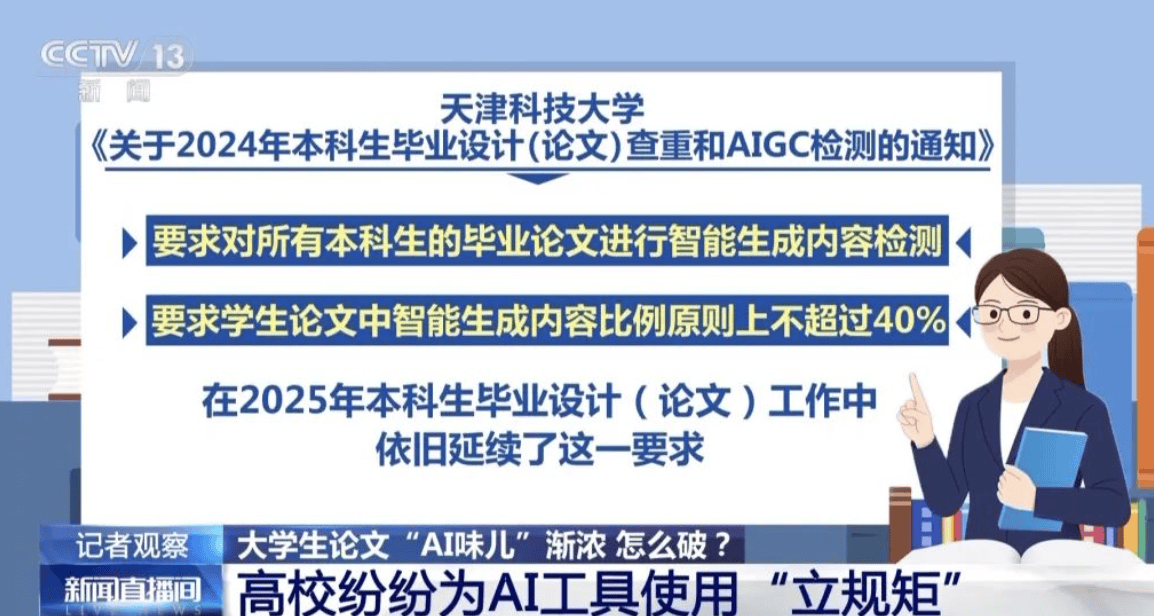

维普的AIGC检测引擎在2025年底做了一次重大升级。它不再只看单一AI的语言特征,而是建立了一套"多模型指纹库"。DeepSeek的句式偏好、豆包的衔接习惯、Kimi的修辞风格,全部在数据库里。你用三个AI拼凑出来的文本,等于同时命中了三个模型的特征库,查重率不高才怪。

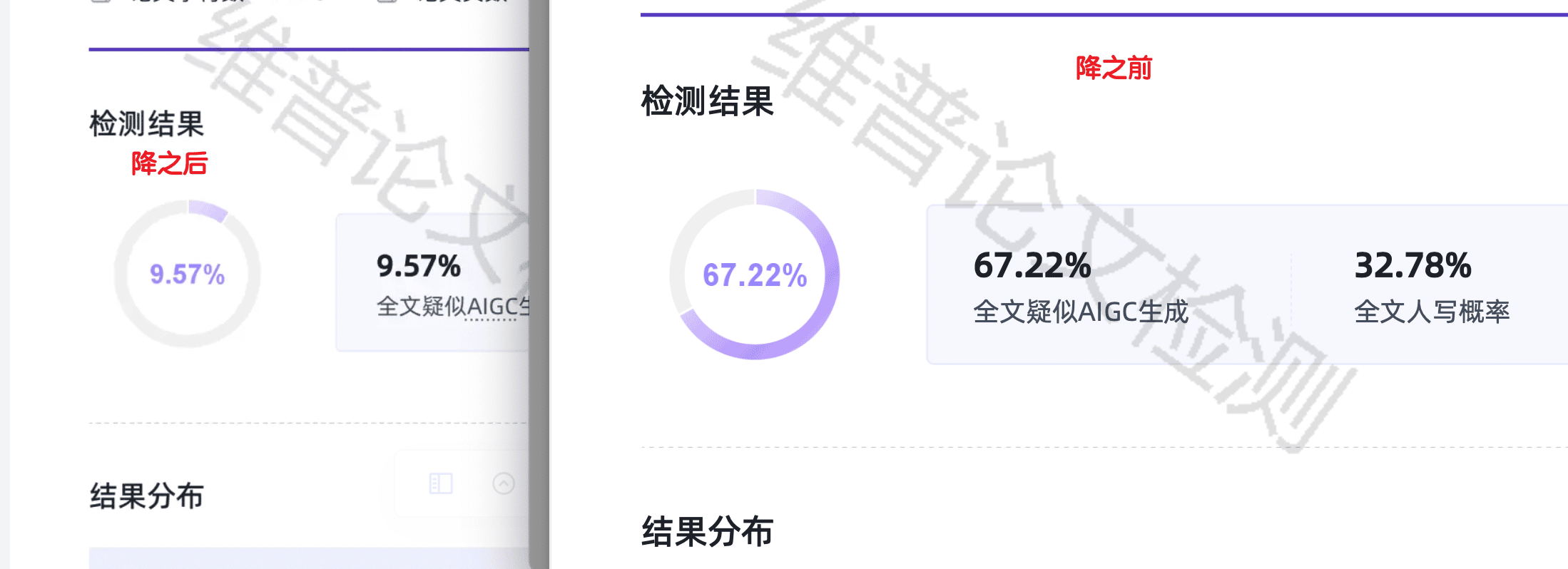

我做了个对比实验。同一个题目"企业数字化转型策略研究",分别用三种方式生成:纯DeepSeek生成维普AIGC检测率71.2%,纯豆包生成68.5%,DeepSeek+豆包+Kimi混合生成87.3%。你看,混合反而最高。因为检测系统把三个模型的特征都匹配上了,相当于三重打击。

三个AI各自的"指纹"长什么样

DeepSeek特别喜欢用"因此"“从而"做因果衔接,段落结构几乎都是"背景-分析-结论"三段式。豆包则偏爱"值得注意的是”"需要指出"这类学术腔,而且特别喜欢在段尾做总结。Kimi的特点是用词精准但句式单一,长短句比例非常稳定,基本维持在1:1.2左右。

维普的检测算法就是抓这些规律。你把三个模型的文本拼在一起,不同段落呈现出不同但各自稳定的语言模式,反而比单一AI更容易被识别。这就好比你穿了三个人的衣服拼在一起,不是更难认出来,而是更显眼。

正确的多AI协作降AI流程(实测有效)

搞清楚翻车原因之后,我设计了一套真正有效的多AI协作流程。核心思路是:AI负责提供思路和素材,但最终文本必须经过深度改写。

四步流程拆解

第一步,用DeepSeek搭框架,但别直接让它写正文。给DeepSeek的指令要具体,比如"请给我列出5个可以展开的研究角度,每个角度提供2个国内企业的真实案例和对应的数据来源"。只要角度和素材,不要成文的段落。DeepSeek在信息检索方面确实强,但生成的正文AI痕迹太重。

第二步,用豆包做文献梳理和论据补充。把DeepSeek给的研究角度丢给豆包,让它找相关的学术观点和理论支撑。同样,只要素材不要成文。

第三步,用Kimi检查逻辑漏洞。把你自己写好的初稿丢给Kimi,让它找逻辑上的问题。Kimi在逻辑分析方面做得不错,但它给的修改建议你需要用自己的话重新表达。

第四步也是最关键的一步,手动改写。前面三步收集到的所有素材和建议,最终都要经过你自己的手来写。怎么写得不像AI?句子长短要随机,AI文本基本在15到25字之间波动很小,你写的时候要故意制造差异。多用口语化的衔接词,比如"说白了"“换句话说”“打个比方”。适当加入你自己的观察和体验,哪怕只是"我在实习期间注意到"这样一句话,都能大幅降低AI检测率。

手动改写的具体技巧

句子长短要随机。AI生成的文本句子长度波动很小,基本在15到25字之间。你写的时候要故意制造差异,有的句子只有6个字,有的可以拉到40字以上。

多用口语化的衔接词,比如"说白了"“换句话说”“打个比方”,这些都是AI不太会用的表达。适当加入你自己的观察和体验,哪怕只是"我在实习期间注意到"这样一句话,都能大幅降低AI检测率。另外特别注意要避免"综上所述""由此可见"这类AI最爱用的总结句。

手动改完还是高?专业降AI工具实测

老实说,手动改写效果因人而异。有的同学语言功底不错,改完能降到20%以下。但也有不少人改了半天,维普AIGC还是显示40%、50%。这时候就需要专业工具帮忙了。

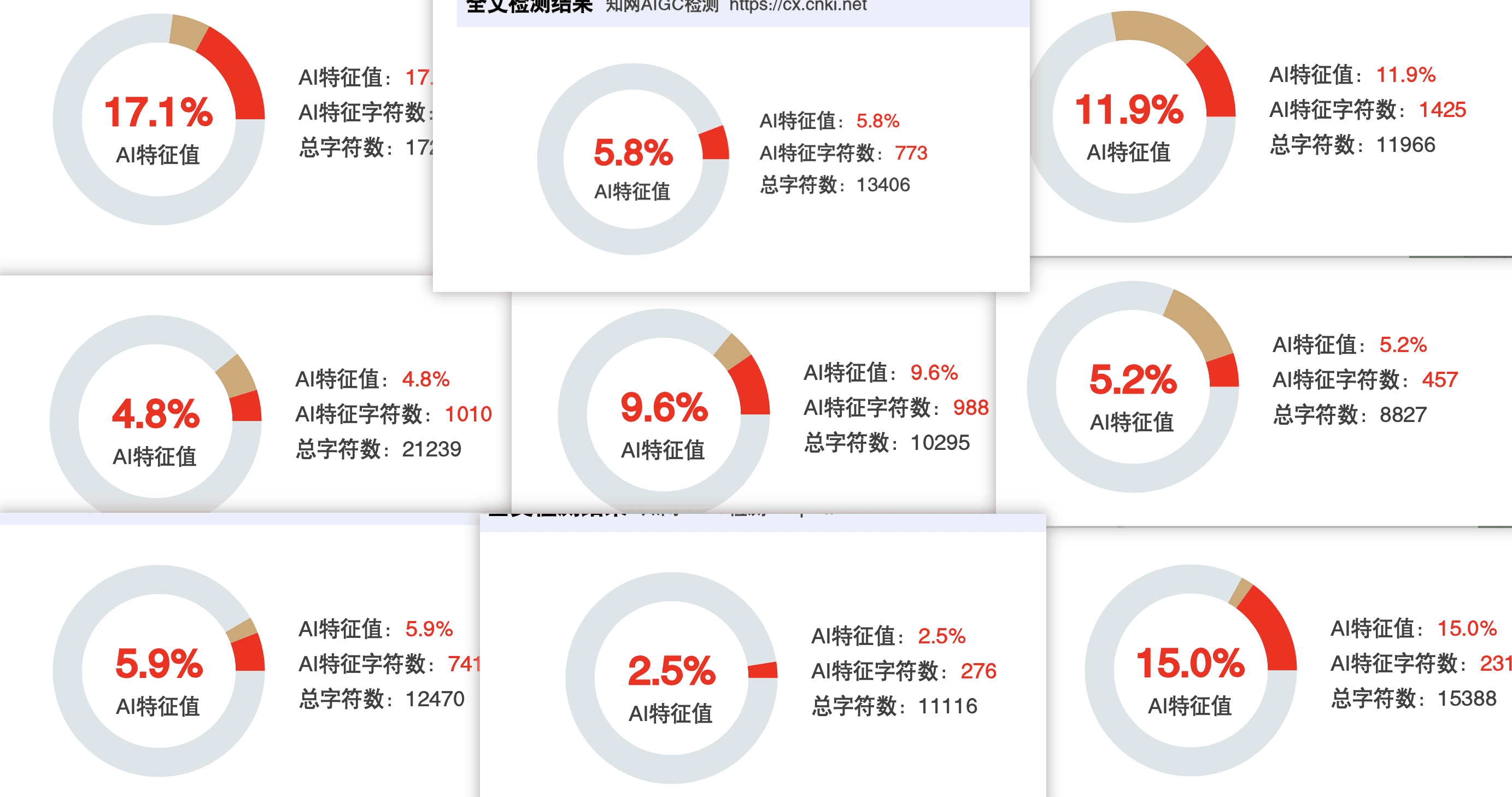

我测了市面上几款主流的降AI工具,直接上数据:

| 工具名称 | 价格 | 达标率 | 核心技术 | 特色功能 | 官网 |

|---|---|---|---|---|---|

| 嘎嘎降AI | 4.8元/千字 | 99.26% | 语义同位素分析+风格迁移网络 | 9大平台验证,不达标退款 | www.aigcleaner.com |

| 比话降AI | 8元/千字 | 99% | Pallas引擎 | 不收录不公开,全额退款 | www.bihuapass.com |

| 率降 | 4.2元/千字 | 97% | 智能改写 | 7天无限修改 | www.oailv.com |

| PaperRR | 6元/千字 | 97% | 学术改写引擎 | 术语保护,学术级品质 | www.paperrr.com |

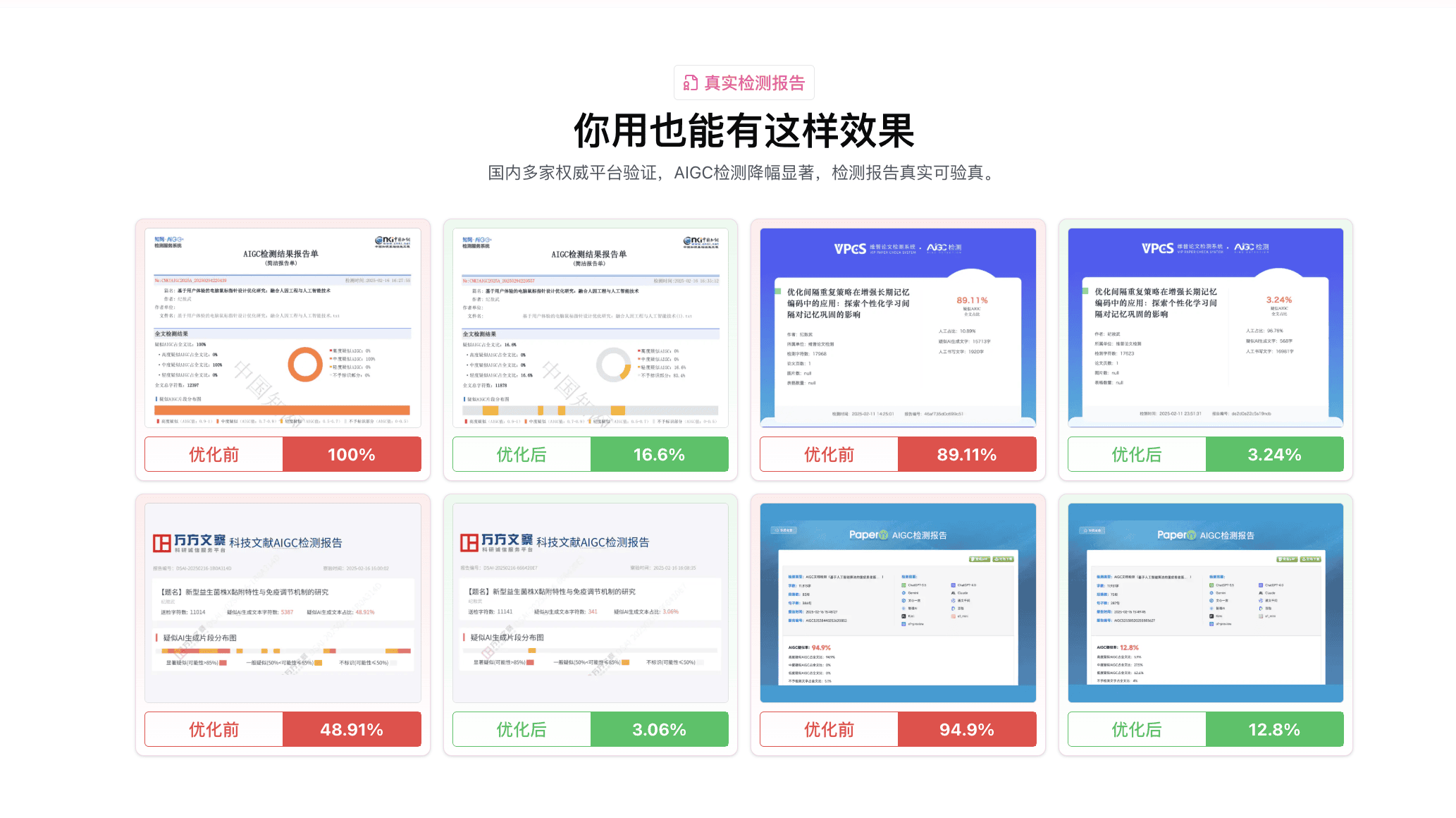

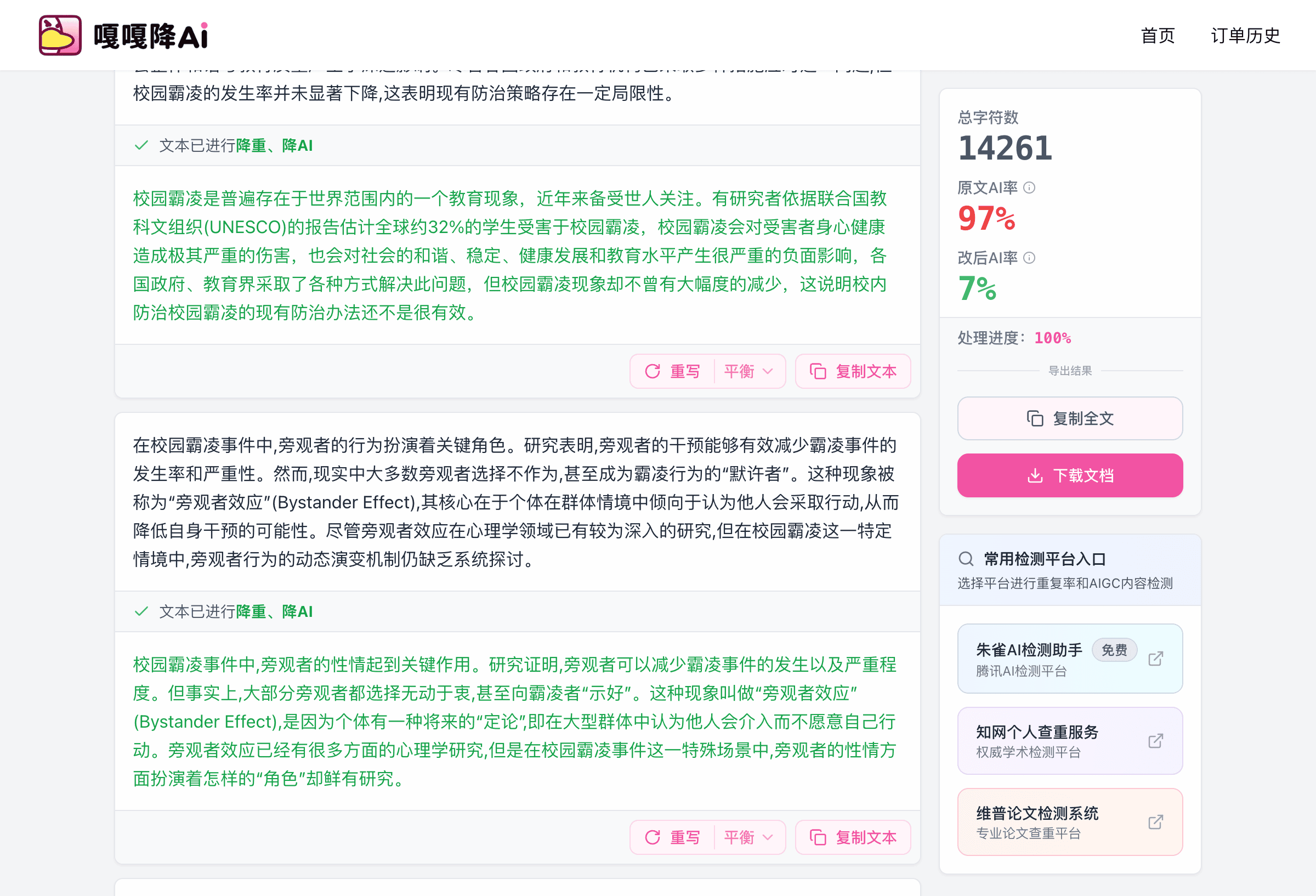

我用老张那篇87.3%的论文直接丢进嘎嘎降AI(www.aigcleaner.com),处理完再用维普查,降到了6.2%。4.8元一千字,一篇一万字的论文也就48块钱。关键是它用的双引擎技术,语义同位素分析负责理解原文含义,风格迁移网络负责把AI风格转成人类写作风格。处理后的文本读起来确实更自然,不是那种简单的同义词替换。而且嘎嘎降AI支持9大主流检测平台的验证,维普、知网、万方都能搞定。最让人放心的是不达标直接退款。

如果你特别在意论文隐私,比话降AI(www.bihuapass.com)是个好选择。8元一千字贵一点,但承诺不收录不公开你的论文,用的Pallas引擎达标率99%,不满意全额退款。手头实在紧的话,率降(www.oailv.com)4.2元一千字是最便宜的,达标率97%,提供7天无限修改。论文专业术语多的同学考虑PaperRR(www.paperrr.com),6元一千字,有术语保护功能。

降AI指令的正确写法(模板直接用)

很多人在用AI的时候,指令写得太随意,导致生成的文本AI特征特别明显。这里分享几个我反复测试过的降AI指令模板。

三个AI的专属指令模板

给DeepSeek的指令模板:"你现在是一个有15年经验的[你的专业]领域研究者。请用第一人称,以学术论文的口吻,围绕[你的论点]展开论述。要求:每段话的句子长度不要太一致;适当使用’事实上’‘不难发现’等衔接词;在论述中穿插一个你在实际研究中遇到的小例子;避免使用’综上所述’'因此我们可以得出’这类总结句。"这个指令模板的核心是打破AI的默认输出模式。

给豆包的文献梳理指令:"请帮我查找关于[研究主题]的中文文献,筛选标准:2020年以后发表的、被引用次数超过50次的核心期刊论文。只需要提供论文标题、作者、发表年份和核心观点(用一句话概括),不需要展开论述。"最后那句"不需要展开论述"很关键,一旦让AI展开,它的语言特征就会暴露。

给Kimi的逻辑检查指令:"请阅读以下段落,仅指出其中的逻辑漏洞或论证不够充分的地方。只需要列出问题,不需要给出修改后的文本。问题描述请用简短的话,不超过两句。"同样,限制它只做分析不做生成。一旦让它生成替代文本,AI痕迹就跑不掉了。

实测数据对比和最终建议

最后放一组完整的实测数据。我用同一篇1.2万字的经济学论文(原始维普AIGC检测率87.3%)做了测试。

纯手动改写花了大概14个小时,维普AIGC降到了31.5%。说实话还是偏高,因为我手动改写的能力有限,很多学术表达实在想不到更好的替代方式。用DeepSeek+豆包+Kimi的指令模板重新生成再手动微调,花了6个小时,维普AIGC降到了22.8%。比纯手动好一些,但依然超过很多学校20%的红线。最后用嘎嘎降AI处理,5分钟搞定,维普AIGC降到了6.2%。又用知网AIGC查了一下只有4.7%,9大平台全部过关,花了57.6块钱,省了十几个小时的时间。

如果你也在被维普AIGC查重率高的问题折磨,我的建议是:先试试手动改写和指令优化的方法,如果效果不理想果断上工具。时间和精力也是成本,别在这件事上过度消耗自己。

根据实测经验给不同情况的同学做个推荐:预算充裕且追求稳妥的首选嘎嘎降AI(www.aigcleaner.com),对隐私有要求的选比话降AI(www.bihuapass.com),预算紧张的选率降(www.oailv.com),论文术语多的考虑PaperRR(www.paperrr.com)。不管用什么方法降AI,处理完之后一定要自己通读一遍。祝大家都能顺利通过查重。

更多推荐

已为社区贡献2948条内容

已为社区贡献2948条内容

所有评论(0)