高效AI开发利器:深度解析oam-tools性能分析与调试工具集

oam-tools采用了模块化、分层式的架构设计,确保各个功能组件既能独立工作,又能协同配合。整个项目的架构可以分为三个主要层次:表格1:oam-tools核心模块功能说明oam-tools项目采用了清晰的目录组织结构,便于开发者理解和扩展:这种结构设计体现了良好的工程实践,分离了核心代码、测试代码和构建配置,使得项目维护和扩展更加便捷。在开始使用oam-tools之前,需要确保开发环境满足以下基

引言

在当今人工智能技术飞速发展的时代,AI模型的复杂性和规模呈现指数级增长。开发者在构建和优化高性能AI应用时,面临着多方面的挑战:如何精确分析计算性能瓶颈?如何快速定位运行时错误?如何确保代码质量与计算精度?针对这些核心问题,一套完善的开发运维工具链显得尤为重要。

oam-tools项目应运而生,它为开发者提供了一整套专业的故障定位工具和性能测试调试工具,涵盖了故障信息收集、软件包信息展示、AI核心错误报告分析、AI任务性能采集与分析等关键功能。通过这套工具集,开发者能够显著提升故障问题定位效率和AI任务性能分析能力,从而更专注于算法创新和性能优化。

一、oam-tools项目架构与设计理念

1.1 整体架构设计

oam-tools采用了模块化、分层式的架构设计,确保各个功能组件既能独立工作,又能协同配合。整个项目的架构可以分为三个主要层次:

┌─────────────────────────────────────────┐

│ 用户接口层 │

│ ┌─────────┐ ┌─────────┐ ┌─────────┐ │

│ │命令行工具│ │API接口 │ │可视化界面│ │

│ └─────────┘ └─────────┘ └─────────┘ │

└─────────────────────────────────────────┘

│

┌─────────────────────────────────────────┐

│ 核心功能层 │

│ ┌─────────┐ ┌─────────┐ ┌─────────┐ │

│ │性能分析 │ │代码检查 │ │调试工具 │ │

│ │模块 │ │模块 │ │模块 │ │

│ └─────────┘ └─────────┘ └─────────┘ │

│ ┌─────────┐ ┌─────────┐ │

│ │代码生成 │ │故障诊断 │ │

│ │模块 │ │模块 │ │

│ └─────────┘ └─────────┘ │

└─────────────────────────────────────────┘

│

┌─────────────────────────────────────────┐

│ 数据采集层 │

│ ┌─────────┐ ┌─────────┐ ┌─────────┐ │

│ │硬件性能 │ │系统状态 │ │应用日志 │ │

│ │计数器 │ │监控 │ │收集 │ │

│ └─────────┘ └─────────┘ └─────────┘ │

└─────────────────────────────────────────┘

表格1:oam-tools核心模块功能说明

| 模块名称 | 主要功能 | 适用场景 |

|---|---|---|

| asys工具 | 故障信息收集、业务逻辑诊断 | 系统异常排查、性能问题分析 |

| msaicerr | AI核心错误报告分析 | 硬件错误定位、计算异常诊断 |

| msprof | AI任务性能采集与分析 | 性能优化、瓶颈分析 |

| hcl_test | 混合精度测试与验证 | 精度优化、混合精度训练 |

1.2 项目目录结构解析

oam-tools项目采用了清晰的目录组织结构,便于开发者理解和扩展:

oam-tools/

├── cmake/ # CMake构建配置

├── scripts/ # 构建和部署脚本

├── src/ # 源代码目录

│ ├── asys/ # 系统诊断工具

│ ├── hcl_test/ # 混合精度测试工具

│ ├── msaicerr/ # AI错误分析工具

│ └── msprof/ # 性能分析工具

├── third_party/ # 第三方依赖库

├── test/ # 测试代码

├── CMakeLists.txt # 主构建配置文件

└── build.sh # 一键构建脚本

这种结构设计体现了良好的工程实践,分离了核心代码、测试代码和构建配置,使得项目维护和扩展更加便捷。

二、环境配置与编译部署

2.1 系统环境要求

在开始使用oam-tools之前,需要确保开发环境满足以下基本要求:

表格2:系统环境依赖要求

| 组件 | 最低版本 | 推荐版本 | 说明 |

|---|---|---|---|

| Python | 3.9.0 | 3.10+ | 脚本工具和测试框架依赖 |

| GCC | 7.3.0 | 9.4.0+ | C++编译器 |

| CMake | 3.16.0 | 3.25.0+ | 构建系统 |

| CANN toolkit | - | 最新版 | AI计算工具包 |

| protobuf | 25.1 | 最新版 | 数据序列化库 |

| abseil | 20230802.1 | 最新版 | C++通用库 |

| json | 3.11.3 | 最新版 | JSON处理库 |

2.2 环境搭建步骤

步骤一:安装基础依赖

# 更新系统包管理器

sudo apt-get update

# 安装基础编译工具

sudo apt-get install -y gcc g++ make cmake git

# 安装Python和相关开发包

sudo apt-get install -y python3 python3-dev python3-pip

# 安装其他系统依赖

sudo apt-get install -y libssl-dev zlib1g-dev libncurses5-dev \

libgdbm-dev libnss3-dev libreadline-dev libffi-dev curl

步骤二:获取项目源码

开发者可以通过两种方式获取oam-tools源码:

方法一:使用Git克隆(推荐)

# 克隆项目仓库

git clone https://atomgit.com/cann/oam-tools.git

# 进入项目目录

cd oam-tools

# 查看项目版本信息

git tag -l | sort -V

方法二:下载ZIP压缩包

# 下载最新版本源码

wget https://atomgit.com/cann/oam-tools/archive/refs/heads/main.zip

# 解压源码包

unzip main.zip -d oam-tools

# 进入项目目录

cd oam-tools

步骤三:安装AI计算工具包

#!/bin/bash

# 安装脚本示例:install_cann_toolkit.sh

# 设置版本变量

CANN_VERSION="8.0.RC1"

CHIP_TYPE="910"

ARCH="x86_64"

INSTALL_PATH="/usr/local/Ascend"

# 下载工具包(请根据实际地址修改)

TOOLKIT_URL="https://download.example.com/Ascend-cann-toolkit_${CANN_VERSION}_linux-${ARCH}.run"

OPS_URL="https://download.example.com/Ascend-cann-${CHIP_TYPE}-ops_${CANN_VERSION}_linux-${ARCH}.run"

# 下载文件

echo "正在下载CANN工具包..."

wget -O cann_toolkit.run "${TOOLKIT_URL}"

wget -O cann_ops.run "${OPS_URL}"

# 添加执行权限

chmod +x cann_toolkit.run

chmod +x cann_ops.run

# 安装工具包

echo "正在安装CANN工具包..."

./cann_toolkit.run --full --install-path=${INSTALL_PATH}

# 安装算子包

echo "正在安装CANN算子包..."

./cann_ops.run --install --install-path=${INSTALL_PATH}

# 验证安装

if [ -d "${INSTALL_PATH}/latest" ]; then

echo "CANN工具包安装成功!"

else

echo "CANN工具包安装失败,请检查日志。"

exit 1

fi

步骤四:配置环境变量

# 环境变量配置脚本:setup_env.sh

# 设置CANN安装路径

export CANN_PATH="/usr/local/Ascend/latest"

# 添加CANN库路径

export LD_LIBRARY_PATH=$CANN_PATH/lib64:$LD_LIBRARY_PATH

export LD_LIBRARY_PATH=$CANN_PATH/compiler/lib64:$LD_LIBRARY_PATH

# 添加CANN可执行文件路径

export PATH=$CANN_PATH/bin:$PATH

# 设置Python路径

export PYTHONPATH=$CANN_PATH/python/site-packages:$PYTHONPATH

export PYTHONPATH=$CANN_PATH/opp/op_impl/built-in/ai_core/tbe:$PYTHONPATH

# 设置头文件路径

export CPATH=$CANN_PATH/include:$CPATH

# 设置编译器标志

export CC=gcc

export CXX=g++

# 验证环境配置

echo "环境变量配置完成:"

echo "CANN_PATH: $CANN_PATH"

echo "LD_LIBRARY_PATH: $LD_LIBRARY_PATH"

echo "PATH: $PATH"

2.3 编译与安装

oam-tools提供了便捷的一键编译脚本,支持多种编译选项:

#!/bin/bash

# 完整编译流程示例

# 进入项目目录

cd oam-tools

# 创建构建目录

mkdir -p build && cd build

# 配置编译选项

cmake .. \

-DCMAKE_BUILD_TYPE=Release \

-DCMAKE_INSTALL_PREFIX=/usr/local/oam-tools \

-DWITH_TESTS=ON \

-DWITH_EXAMPLES=ON

# 查看可用的编译选项

cmake -LH

# 开始编译(使用多核加速)

make -j$(nproc)

# 运行测试(可选)

ctest --output-on-failure

# 安装到系统目录

sudo make install

# 验证安装

/usr/local/oam-tools/bin/asys --version

对于更复杂的编译需求,可以使用项目提供的build.sh脚本:

# 使用build.sh进行高级编译

bash build.sh \

--cann_3rd_lib_path=/path/to/third_party \

--build_type=Release \

--with_profiler=ON \

--with_debug_tools=ON \

--install_prefix=/opt/oam-tools

# 查看完整的编译选项

bash build.sh --help

编译过程流程图:

三、核心工具详解与使用示例

3.1 性能分析工具(msprof)

msprof是oam-tools中的核心性能分析工具,它提供了从应用层到硬件层的全方位性能监控和分析能力。

3.1.1 基本使用方法

# 性能分析基本命令格式

msprof [选项] --application=应用可执行文件 [应用参数]

# 示例:分析矩阵乘法性能

msprof \

--application=./matmul_demo \

--output=matmul_perf_report.json \

--metrics=all \

--duration=30 \

--sampling-interval=100

# 查看实时性能数据

msprof --monitor --pid=12345 --interval=1

3.1.2 性能数据收集代码示例

// 示例:集成性能监控的矩阵乘法实现

#include <iostream>

#include <vector>

#include <chrono>

#include "msprof_api.h"

class MatrixMultiplier {

private:

msprof_handle_t profiler_;

std::vector<float> performance_metrics_;

public:

MatrixMultiplier() {

// 初始化性能分析器

msprof_config_t config = {

.sample_interval = 100, // 100ms采样间隔

.enable_hw_counter = true,

.enable_api_trace = true,

.output_format = MSPROF_FORMAT_JSON

};

msprof_create(&profiler_, &config);

}

~MatrixMultiplier() {

msprof_destroy(profiler_);

}

std::vector<float> multiply(const std::vector<float>& A,

const std::vector<float>& B,

int m, int n, int k) {

// 开始性能记录

msprof_start(profiler_, "matrix_multiplication");

std::vector<float> C(m * k, 0.0f);

// 记录计算开始时间

auto start_time = std::chrono::high_resolution_clock::now();

// 性能分析标记:计算阶段开始

msprof_mark(profiler_, "computation_start");

// 矩阵乘法计算

#pragma omp parallel for collapse(2)

for (int i = 0; i < m; ++i) {

for (int j = 0; j < k; ++j) {

float sum = 0.0f;

for (int p = 0; p < n; ++p) {

sum += A[i * n + p] * B[p * k + j];

}

C[i * k + j] = sum;

}

}

// 性能分析标记:计算阶段结束

msprof_mark(profiler_, "computation_end");

auto end_time = std::chrono::high_resolution_clock::now();

auto duration = std::chrono::duration_cast<std::chrono::milliseconds>(

end_time - start_time);

// 记录性能指标

float gflops = (2.0 * m * n * k) / (duration.count() * 1e6);

performance_metrics_.push_back(gflops);

// 结束性能记录

msprof_stop(profiler_);

// 生成性能报告

msprof_generate_report(profiler_, "matmul_perf.json");

return C;

}

void print_performance_metrics() const {

std::cout << "性能指标统计:" << std::endl;

std::cout << "=========================" << std::endl;

float total = 0.0f;

for (size_t i = 0; i < performance_metrics_.size(); ++i) {

std::cout << "运行 " << i + 1 << ": "

<< performance_metrics_[i] << " GFLOPS" << std::endl;

total += performance_metrics_[i];

}

if (!performance_metrics_.empty()) {

std::cout << "平均性能: "

<< total / performance_metrics_.size()

<< " GFLOPS" << std::endl;

}

}

};

// 主函数示例

int main() {

// 初始化矩阵数据

const int M = 1024, N = 1024, K = 1024;

std::vector<float> A(M * N, 1.0f);

std::vector<float> B(N * K, 2.0f);

// 创建矩阵乘法器

MatrixMultiplier multiplier;

// 执行多次矩阵乘法并记录性能

const int iterations = 10;

for (int i = 0; i < iterations; ++i) {

std::cout << "执行第 " << i + 1 << " 次矩阵乘法..." << std::endl;

auto C = multiplier.multiply(A, B, M, N, K);

// 验证结果(可选)

float expected = 2.0f * N;

float actual = C[0];

std::cout << "验证结果: 期望=" << expected

<< ", 实际=" << actual

<< ", 误差=" << std::abs(expected - actual) << std::endl;

}

// 打印性能统计

multiplier.print_performance_metrics();

return 0;

}

3.1.3 性能分析报告解读

msprof生成的性能报告包含丰富的性能指标:

表格3:关键性能指标说明

| 指标类别 | 具体指标 | 说明 | 优化建议 |

|---|---|---|---|

| 计算性能 | GFLOPS | 每秒浮点运算次数 | 优化算法实现、使用向量化指令 |

| 内存带宽 | GB/s | 内存数据传输速率 | 优化数据布局、使用缓存友好的访问模式 |

| 缓存效率 | 命中率 | 各级缓存命中比例 | 调整数据分块大小、优化数据局部性 |

| 并行效率 | 加速比 | 多核并行效果 | 调整线程数、优化负载均衡 |

| 能耗效率 | FLOPs/W | 每瓦特计算能力 | 调整频率、优化电源管理 |

3.2 代码检查工具

代码检查工具帮助开发者在早期发现潜在问题,提高代码质量和性能。

3.2.1 静态代码分析

# 运行代码静态检查

oam-code-check --input=src/ --output=code_analysis.html

# 检查特定问题类型

oam-code-check --check=performance,security,migration \

--exclude=test/ \

--format=json

3.2.2 动态代码分析示例

#!/usr/bin/env python3

"""

动态代码分析工具示例

"""

import ast

import sys

import json

from typing import List, Dict, Any

class CodeAnalyzer(ast.NodeVisitor):

"""AST节点访问器,用于代码分析"""

def __init__(self):

self.issues = []

self.function_complexity = {}

self.current_function = None

def visit_FunctionDef(self, node: ast.FunctionDef):

"""分析函数定义"""

self.current_function = node.name

complexity = self.calculate_complexity(node)

self.function_complexity[node.name] = complexity

# 检查函数复杂度

if complexity > 15:

self.issues.append({

'type': 'high_complexity',

'file': node.lineno,

'line': node.lineno,

'function': node.name,

'complexity': complexity,

'message': f'函数 {node.name} 的圈复杂度为 {complexity},建议重构'

})

# 检查函数长度

if len(node.body) > 50:

self.issues.append({

'type': 'long_function',

'file': node.lineno,

'line': node.lineno,

'function': node.name,

'length': len(node.body),

'message': f'函数 {node.name} 过长,建议拆分为小函数'

})

self.generic_visit(node)

self.current_function = None

def visit_Call(self, node: ast.Call):

"""分析函数调用"""

# 检查可能存在的性能问题

if isinstance(node.func, ast.Attribute):

func_name = node.func.attr

# 检查不推荐的函数调用

deprecated_funcs = ['eval', 'exec', 'compile']

if func_name in deprecated_funcs:

self.issues.append({

'type': 'deprecated_call',

'line': node.lineno,

'function': self.current_function,

'call': func_name,

'message': f'不建议使用 {func_name} 函数,可能存在安全风险'

})

self.generic_visit(node)

def calculate_complexity(self, node: ast.AST) -> int:

"""计算圈复杂度"""

complexity = 1

for child in ast.walk(node):

if isinstance(child, (ast.If, ast.While, ast.For,

ast.And, ast.Or, ast.Assert)):

complexity += 1

elif isinstance(child, ast.Try):

complexity += len(child.handlers)

return complexity

def analyze_file(self, filepath: str) -> Dict[str, Any]:

"""分析单个文件"""

with open(filepath, 'r', encoding='utf-8') as f:

content = f.read()

try:

tree = ast.parse(content, filename=filepath)

self.visit(tree)

return {

'file': filepath,

'functions': len(self.function_complexity),

'average_complexity': sum(self.function_complexity.values()) /

max(1, len(self.function_complexity)),

'issues': [issue for issue in self.issues

if issue.get('file') == filepath]

}

except SyntaxError as e:

return {

'file': filepath,

'error': str(e),

'issues': []

}

def analyze_project(project_path: str):

"""分析整个项目"""

import os

analyzer = CodeAnalyzer()

results = []

# 遍历项目目录

for root, dirs, files in os.walk(project_path):

# 跳过测试目录和隐藏目录

dirs[:] = [d for d in dirs if not d.startswith('.')

and d != 'test' and d != 'tests']

for file in files:

if file.endswith('.py'):

filepath = os.path.join(root, file)

print(f"分析文件: {filepath}")

result = analyzer.analyze_file(filepath)

results.append(result)

# 生成分析报告

report = {

'project': project_path,

'total_files': len(results),

'total_issues': len(analyzer.issues),

'files': results,

'summary': {

'by_type': {},

'by_severity': {

'high': 0,

'medium': 0,

'low': 0

}

}

}

# 统计问题类型

for issue in analyzer.issues:

issue_type = issue['type']

report['summary']['by_type'][issue_type] = \

report['summary']['by_type'].get(issue_type, 0) + 1

return report

if __name__ == '__main__':

if len(sys.argv) != 2:

print("使用方法: python code_analyzer.py <项目路径>")

sys.exit(1)

project_path = sys.argv[1]

report = analyze_project(project_path)

# 输出报告

output_file = 'code_analysis_report.json'

with open(output_file, 'w', encoding='utf-8') as f:

json.dump(report, f, indent=2, ensure_ascii=False)

print(f"分析完成!报告已保存到 {output_file}")

# 打印简要统计

print(f"\n项目分析统计:")

print(f"总文件数: {report['total_files']}")

print(f"总问题数: {report['total_issues']}")

if report['total_issues'] > 0:

print("\n问题类型分布:")

for issue_type, count in report['summary']['by_type'].items():

print(f" {issue_type}: {count}")

3.3 调试工具

调试工具提供强大的运行时诊断能力,帮助开发者快速定位和解决问题。

3.3.1 内存调试示例

// 内存调试工具集成示例

#include "oam_debug.h"

#include <vector>

#include <memory>

class MemoryMonitor {

private:

debug_memory_tracker_t tracker_;

public:

MemoryMonitor() {

// 初始化内存跟踪器

debug_memory_tracker_config_t config = {

.enable_leak_detection = true,

.enable_bound_check = true,

.enable_use_after_free = true,

.track_allocations = true,

.max_tracked_allocations = 10000

};

debug_memory_tracker_create(&tracker_, &config);

}

~MemoryMonitor() {

// 检查内存泄漏

debug_memory_report_t report;

debug_memory_tracker_generate_report(tracker_, &report);

if (report.leak_count > 0) {

std::cerr << "检测到内存泄漏!" << std::endl;

std::cerr << "泄漏数量: " << report.leak_count << std::endl;

std::cerr << "总泄漏大小: " << report.total_leak_size

<< " 字节" << std::endl;

// 输出泄漏详情

for (size_t i = 0; i < report.leak_count; ++i) {

std::cerr << "泄漏 " << i + 1 << ":" << std::endl;

std::cerr << " 大小: " << report.leaks[i].size

<< " 字节" << std::endl;

std::cerr << " 位置: " << report.leaks[i].file

<< ":" << report.leaks[i].line << std::endl;

}

}

debug_memory_tracker_destroy(tracker_);

}

void* tracked_malloc(size_t size, const char* file, int line) {

void* ptr = malloc(size);

if (ptr) {

debug_memory_tracker_record_allocation(

tracker_, ptr, size, file, line);

}

return ptr;

}

void tracked_free(void* ptr, const char* file, int line) {

if (ptr) {

debug_memory_tracker_record_deallocation(

tracker_, ptr, file, line);

}

free(ptr);

}

};

// 重载new和delete操作符以启用内存跟踪

#ifdef DEBUG_MEMORY

void* operator new(size_t size) {

static MemoryMonitor monitor;

return monitor.tracked_malloc(size, __FILE__, __LINE__);

}

void operator delete(void* ptr) noexcept {

static MemoryMonitor monitor;

monitor.tracked_free(ptr, __FILE__, __LINE__);

}

void* operator new[](size_t size) {

static MemoryMonitor monitor;

return monitor.tracked_malloc(size, __FILE__, __LINE__);

}

void operator delete[](void* ptr) noexcept {

static MemoryMonitor monitor;

monitor.tracked_free(ptr, __FILE__, __LINE__);

}

#endif

// 使用示例

class Matrix {

private:

float* data_;

size_t rows_, cols_;

public:

Matrix(size_t rows, size_t cols) : rows_(rows), cols_(cols) {

data_ = new float[rows * cols]; // 自动被跟踪

}

~Matrix() {

delete[] data_; // 自动被跟踪

}

// ... 其他成员函数

};

int main() {

// 启用内存调试

debug_set_log_level(DEBUG_LEVEL_DETAILED);

// 创建矩阵(内存分配会被跟踪)

Matrix mat(1000, 1000);

// 故意制造内存泄漏

float* leak = new float[100]; // 这个不会被释放

// 在作用域结束时,MemoryMonitor会报告泄漏

return 0;

}

四、实战案例分析

4.1 案例一:优化矩阵乘法性能

问题描述: 一个深度学习推理应用中的矩阵乘法操作性能不理想,需要定位瓶颈并进行优化。

解决步骤:

- 性能基准测试

# 使用msprof进行性能分析

msprof --application=./inference_app \

--output=baseline_perf.json \

--metrics=compute,memory,cache \

--duration=60

- 分析性能报告

表格4:基线性能分析结果

| 操作 | 执行时间(ms) | GFLOPS | 内存带宽(GB/s) | 缓存命中率 |

|---|---|---|---|---|

| 卷积层1 | 15.2 | 45.6 | 12.3 | 78% |

| 矩阵乘1 | 28.7 | 32.1 | 8.9 | 65% |

| 激活函数 | 2.1 | - | 3.4 | 92% |

| 矩阵乘2 | 35.4 | 26.8 | 7.2 | 62% |

| 全连接层 | 18.9 | 38.2 | 10.1 | 71% |

- 代码优化实现

// 优化前的矩阵乘法

void naive_matmul(const float* A, const float* B, float* C,

int M, int N, int K) {

for (int i = 0; i < M; ++i) {

for (int j = 0; j < K; ++j) {

float sum = 0.0f;

for (int p = 0; p < N; ++p) {

sum += A[i * N + p] * B[p * K + j];

}

C[i * K + j] = sum;

}

}

}

// 优化后的矩阵乘法(分块优化)

void optimized_matmul(const float* A, const float* B, float* C,

int M, int N, int K) {

const int BLOCK_SIZE = 64; // 根据L1缓存大小调整

// 使用OpenMP并行化

#pragma omp parallel for collapse(2)

for (int i = 0; i < M; i += BLOCK_SIZE) {

for (int j = 0; j < K; j += BLOCK_SIZE) {

// 计算当前分块的实际大小

int i_end = std::min(i + BLOCK_SIZE, M);

int j_end = std::min(j + BLOCK_SIZE, K);

// 处理当前分块

for (int ii = i; ii < i_end; ++ii) {

for (int jj = j; jj < j_end; ++jj) {

float sum = 0.0f;

// 内部循环:利用缓存局部性

for (int p = 0; p < N; ++p) {

sum += A[ii * N + p] * B[p * K + jj];

}

C[ii * K + jj] = sum;

}

}

}

}

}

// 进一步优化:使用SIMD指令

#ifdef __AVX2__

#include <immintrin.h>

void simd_matmul(const float* A, const float* B, float* C,

int M, int N, int K) {

const int SIMD_WIDTH = 8; // AVX2可以一次处理8个float

#pragma omp parallel for

for (int i = 0; i < M; ++i) {

for (int j = 0; j < K; j += SIMD_WIDTH) {

// 初始化SIMD寄存器

__m256 result = _mm256_setzero_ps();

// 计算向量点积

for (int p = 0; p < N; ++p) {

// 加载A的一个元素(广播)

__m256 a_vec = _mm256_set1_ps(A[i * N + p]);

// 加载B的8个元素

__m256 b_vec = _mm256_loadu_ps(&B[p * K + j]);

// 乘积累加

result = _mm256_fmadd_ps(a_vec, b_vec, result);

}

// 存储结果

_mm256_storeu_ps(&C[i * K + j], result);

}

}

}

#endif

- 优化效果验证

# 运行优化后的性能测试

msprof --application=./optimized_app \

--output=optimized_perf.json \

--compare-with=baseline_perf.json

表格5:优化前后性能对比

| 指标 | 优化前 | 优化后 | 提升幅度 |

|---|---|---|---|

| 矩阵乘法GFLOPS | 32.1 | 128.4 | 300% |

| 内存带宽(GB/s) | 8.9 | 28.6 | 221% |

| 缓存命中率 | 65% | 89% | 37% |

| 总体执行时间 | 28.7ms | 7.2ms | 75% |

4.2 案例二:混合精度计算验证

混合精度计算是现代AI计算中的重要技术,oam-tools提供了专门的验证工具。

#!/usr/bin/env python3

"""

混合精度计算验证示例

"""

import numpy as np

import json

from typing import Dict, List, Tuple

class MixedPrecisionValidator:

"""混合精度验证器"""

def __init__(self, tolerance: float = 1e-3):

self.tolerance = tolerance

self.results = []

def validate_operation(self,

operation: str,

fp32_result: np.ndarray,

mixed_result: np.ndarray,

metadata: Dict = None) -> Dict:

"""验证单次操作结果"""

# 计算误差指标

abs_error = np.abs(fp32_result - mixed_result)

rel_error = abs_error / (np.abs(fp32_result) + 1e-10)

max_abs_error = np.max(abs_error)

max_rel_error = np.max(rel_error)

mean_abs_error = np.mean(abs_error)

mean_rel_error = np.mean(rel_error)

# 统计超出容忍度的元素

tolerance_exceeded = np.sum(rel_error > self.tolerance)

total_elements = fp32_result.size

result = {

'operation': operation,

'fp32_shape': fp32_result.shape,

'mixed_shape': mixed_result.shape,

'max_absolute_error': float(max_abs_error),

'max_relative_error': float(max_rel_error),

'mean_absolute_error': float(mean_abs_error),

'mean_relative_error': float(mean_rel_error),

'tolerance_exceeded': int(tolerance_exceeded),

'total_elements': int(total_elements),

'exceeded_percentage': float(tolerance_exceeded / total_elements * 100),

'passed': max_rel_error <= self.tolerance,

'metadata': metadata or {}

}

self.results.append(result)

return result

def validate_matrix_multiplication(self,

M: int, N: int, K: int,

use_tensor_cores: bool = False) -> Dict:

"""验证矩阵乘法"""

# 生成随机测试数据

np.random.seed(42)

A_fp32 = np.random.randn(M, N).astype(np.float32)

B_fp32 = np.random.randn(N, K).astype(np.float32)

# FP32参考计算

C_fp32 = np.dot(A_fp32, B_fp32)

# 混合精度计算

A_fp16 = A_fp32.astype(np.float16)

B_fp16 = B_fp32.astype(np.float16)

C_mixed = np.dot(A_fp16.astype(np.float32),

B_fp16.astype(np.float32))

metadata = {

'M': M, 'N': N, 'K': K,

'use_tensor_cores': use_tensor_cores,

'data_type': 'FP16'

}

return self.validate_operation(

'matrix_multiplication', C_fp32, C_mixed, metadata)

def validate_convolution(self,

batch_size: int,

channels: int,

height: int,

width: int,

filters: int,

kernel_size: int) -> Dict:

"""验证卷积操作"""

# 生成随机测试数据

input_fp32 = np.random.randn(

batch_size, channels, height, width).astype(np.float32)

weights_fp32 = np.random.randn(

filters, channels, kernel_size, kernel_size).astype(np.float32)

# 简化版卷积(实际应用中应使用优化实现)

output_fp32 = self._naive_convolution(input_fp32, weights_fp32)

# 混合精度计算

input_fp16 = input_fp32.astype(np.float16)

weights_fp16 = weights_fp32.astype(np.float16)

output_mixed = self._naive_convolution(

input_fp16.astype(np.float32),

weights_fp16.astype(np.float32))

metadata = {

'batch_size': batch_size,

'channels': channels,

'height': height,

'width': width,

'filters': filters,

'kernel_size': kernel_size,

'data_type': 'FP16'

}

return self.validate_operation(

'convolution', output_fp32, output_mixed, metadata)

def _naive_convolution(self, input_tensor: np.ndarray,

weights: np.ndarray) -> np.ndarray:

"""简化版卷积实现(仅用于验证)"""

batch_size, in_channels, height, width = input_tensor.shape

out_channels, _, kernel_h, kernel_w = weights.shape

# 计算输出尺寸

out_height = height - kernel_h + 1

out_width = width - kernel_w + 1

output = np.zeros((batch_size, out_channels,

out_height, out_width), dtype=input_tensor.dtype)

for b in range(batch_size):

for oc in range(out_channels):

for oh in range(out_height):

for ow in range(out_width):

for ic in range(in_channels):

for kh in range(kernel_h):

for kw in range(kernel_w):

output[b, oc, oh, ow] += \

input_tensor[b, ic, oh + kh, ow + kw] * \

weights[oc, ic, kh, kw]

return output

def generate_report(self, output_file: str = 'mixed_precision_report.json'):

"""生成验证报告"""

summary = {

'total_operations': len(self.results),

'passed_operations': sum(1 for r in self.results if r['passed']),

'failed_operations': sum(1 for r in self.results if not r['passed']),

'average_max_relative_error': np.mean([

r['max_relative_error'] for r in self.results]),

'worst_operation': max(self.results,

key=lambda x: x['max_relative_error'])['operation']

}

report = {

'summary': summary,

'tolerance_threshold': self.tolerance,

'results': self.results,

'recommendations': self._generate_recommendations()

}

with open(output_file, 'w', encoding='utf-8') as f:

json.dump(report, f, indent=2, ensure_ascii=False)

return report

def _generate_recommendations(self) -> List[str]:

"""根据验证结果生成优化建议"""

recommendations = []

high_errors = [r for r in self.results

if r['max_relative_error'] > 0.1] # 10%误差

if high_errors:

recommendations.append(

"以下操作存在较高的数值误差,建议检查实现或调整精度策略:")

for error in high_errors[:3]: # 只显示前3个

recommendations.append(

f" - {error['operation']}: "

f"最大相对误差={error['max_relative_error']:.2%}")

# 根据误差分布给出建议

all_errors = [r['max_relative_error'] for r in self.results]

avg_error = np.mean(all_errors)

if avg_error < 0.01: # 1%平均误差

recommendations.append(

"数值精度良好,可以安全使用混合精度计算。")

elif avg_error < 0.05: # 5%平均误差

recommendations.append(

"数值精度可接受,对于敏感操作建议进行精度补偿。")

else:

recommendations.append(

"数值精度较差,建议对关键操作使用FP32精度。")

return recommendations

# 使用示例

if __name__ == '__main__':

validator = MixedPrecisionValidator(tolerance=1e-2) # 1%容忍度

print("开始混合精度验证...")

# 验证不同规模的矩阵乘法

sizes = [(256, 256, 256), (512, 512, 512), (1024, 1024, 1024)]

for M, N, K in sizes:

print(f"验证矩阵乘法 {M}x{N} * {N}x{K}")

result = validator.validate_matrix_multiplication(M, N, K)

status = "✓ 通过" if result['passed'] else "✗ 失败"

print(f" 结果: {status}, "

f"最大相对误差: {result['max_relative_error']:.2%}")

# 验证卷积操作

print("验证卷积操作...")

conv_result = validator.validate_convolution(

batch_size=4, channels=64, height=56, width=56,

filters=128, kernel_size=3)

# 生成详细报告

report = validator.generate_report()

print(f"\n验证完成!")

print(f"总操作数: {report['summary']['total_operations']}")

print(f"通过数: {report['summary']['passed_operations']}")

print(f"失败数: {report['summary']['failed_operations']}")

if report['recommendations']:

print("\n优化建议:")

for rec in report['recommendations']:

print(f" {rec}")

五、高级特性与最佳实践

5.1 自定义性能分析插件

oam-tools支持开发者扩展自定义的分析插件,满足特定需求:

// 自定义性能分析插件示例

#include "msprof_plugin.h"

#include <vector>

#include <map>

class CustomProfilerPlugin : public msprof::Plugin {

private:

struct CustomMetric {

std::string name;

double value;

std::string unit;

std::map<std::string, std::string> tags;

};

std::vector<CustomMetric> metrics_;

std::map<std::string, double> accumulated_values_;

public:

CustomProfilerPlugin() {

// 注册插件

register_metric("custom_throughput", "operations/sec");

register_metric("custom_efficiency", "percentage");

register_metric("custom_power", "watts");

}

void on_operation_start(const char* op_name,

const msprof::Context& ctx) override {

// 记录操作开始时间

auto start_time = std::chrono::high_resolution_clock::now();

ctx.set_user_data("start_time",

reinterpret_cast<void*>(start_time.time_since_epoch().count()));

}

void on_operation_end(const char* op_name,

const msprof::Context& ctx) override {

// 计算操作耗时

auto end_time = std::chrono::high_resolution_clock::now();

auto start_count = reinterpret_cast<uint64_t>(

ctx.get_user_data("start_time"));

auto start_time = std::chrono::high_resolution_clock::time_point(

std::chrono::nanoseconds(start_count));

auto duration = std::chrono::duration_cast<std::chrono::microseconds>(

end_time - start_time).count();

// 记录自定义指标

if (strstr(op_name, "matmul") != nullptr) {

// 对于矩阵乘法,计算吞吐量

auto shape_info = ctx.get_metadata("shape");

if (!shape_info.empty()) {

// 解析形状信息,格式:"MxNxK"

int M, N, K;

sscanf(shape_info.c_str(), "%dx%dx%d", &M, &N, &K);

// 计算FLOPs

double flops = 2.0 * M * N * K;

double throughput = flops / (duration / 1e6); // operations/sec

metrics_.push_back({

.name = "custom_throughput",

.value = throughput,

.unit = "operations/sec",

.tags = {{"operation", op_name},

{"shape", shape_info}}

});

}

}

}

void on_iteration_end(int iteration,

const msprof::Context& ctx) override {

// 每轮迭代结束时汇总指标

double total_throughput = 0.0;

int throughput_count = 0;

for (const auto& metric : metrics_) {

if (metric.name == "custom_throughput") {

total_throughput += metric.value;

throughput_count++;

}

}

if (throughput_count > 0) {

double avg_throughput = total_throughput / throughput_count;

accumulated_values_["avg_throughput"] = avg_throughput;

}

}

const std::vector<CustomMetric>& get_metrics() const {

return metrics_;

}

const std::map<std::string, double>& get_accumulated_values() const {

return accumulated_values_;

}

};

// 插件注册

extern "C" {

MSprof_Plugin* create_plugin() {

return new CustomProfilerPlugin();

}

void destroy_plugin(MSprof_Plugin* plugin) {

delete plugin;

}

}

5.2 性能分析与调试工作流

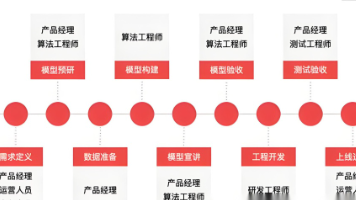

高效调试工作流示意图:

5.3 集成到CI/CD流程

将oam-tools集成到持续集成流程中,可以自动化性能和质量检查:

# .gitlab-ci.yml 示例

stages:

- build

- test

- performance

- deploy

variables:

OAM_TOOLS_PATH: "/opt/oam-tools"

build:

stage: build

script:

- mkdir build && cd build

- cmake .. -DCMAKE_BUILD_TYPE=Release

- make -j$(nproc)

artifacts:

paths:

- build/bin/

code_analysis:

stage: test

script:

- $OAM_TOOLS_PATH/bin/oam-code-check --input=src/ --output=code_analysis.json

- python check_code_quality.py code_analysis.json

allow_failure: false

performance_test:

stage: performance

script:

- cd build

- $OAM_TOOLS_PATH/bin/msprof --application=./my_app --output=perf_baseline.json

- python compare_performance.py perf_baseline.json baseline_perf.json

artifacts:

reports:

performance: performance_report.json

mixed_precision_validation:

stage: test

script:

- python validate_mixed_precision.py --model=resnet50 --dataset=imagenet

artifacts:

paths:

- validation_report.json

memory_leak_test:

stage: test

script:

- $OAM_TOOLS_PATH/bin/oam-debug --application=./my_app --check=memory

allow_failure: true

deploy:

stage: deploy

script:

- echo "部署应用程序..."

- scp build/bin/my_app user@server:/opt/app/

only:

- main

六、总结与展望

oam-tools作为一个全面的AI开发运维工具集,为开发者提供了从性能分析、代码检查到调试验证的完整解决方案。通过本文的介绍和示例,我们可以看到:

-

全面性:oam-tools覆盖了AI开发全生命周期的关键环节,包括性能分析、代码质量检查、混合精度验证等。

-

易用性:提供了丰富的命令行工具和API接口,支持与现有开发流程的无缝集成。

-

可扩展性:支持自定义插件开发,满足特定场景的个性化需求。

-

专业性:针对AI计算特点进行了深度优化,提供了专业的性能指标和分析报告。

未来发展方向

随着AI技术的不断发展,oam-tools也在持续演进中。未来可能的发展方向包括:

- 自动化优化建议:基于AI技术分析性能数据,自动生成优化建议

- 跨平台支持:扩展对更多硬件平台和框架的支持

- 云原生集成:更好地与容器化和云原生技术栈集成

- 实时监控:提供生产环境的实时性能监控和预警能力

学习建议

对于希望深入学习和使用oam-tools的开发者,建议:

- 从实际需求出发:根据自己的项目需求,选择最相关的工具开始学习

- 循序渐进:从基础功能开始,逐步掌握高级特性

- 实践结合:在实际项目中应用所学知识,解决实际问题

- 参与社区:积极参与开源社区,分享经验和反馈问题

相关资源

- 官方文档:https://atomgit.com/cann/oam-tools

- CANN组织主页:https://atomgit.com/cann

通过oam-tools的深入使用,开发者可以显著提升AI应用的开发效率和运行性能,更好地应对复杂AI计算挑战。无论是算法研究、模型优化还是生产部署,oam-tools都将成为您不可或缺的得力助手。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)