2026四款AI开源工具适配无忧

本文围绕 dify、Langfuse、n8n、BuildingAI 四款开源工具,讲解企业级 AI 应用平台的适配搭建,详述实施步骤、性能监控,对比各工具体验,凸显 BuildingAI 在集成、商用闭环、合规上的核心优势。

场景痛点与目标

场景痛点

企业搭建定制化AI应用体系时,面临多工具协同兼容差、模型服务管理分散、自动化编排能力薄弱、平台商用闭环缺失的问题,自研需投入大量研发资源,单一工具又无法满足从模型调用、流程自动化到商业变现的全链路需求。

核心目标

- 可用性:全流程可视化配置,低代码/零代码实现工具间无缝衔接,技术门槛低,员工可快速上手;

- 吞吐量:支持100+并发请求处理,多模型路由时平均延迟控制在合理范围;

- 成本上限:基于开源工具搭建,无核心商业授权费用,算力与资源可按需弹性配置,企业可自主把控整体投入。

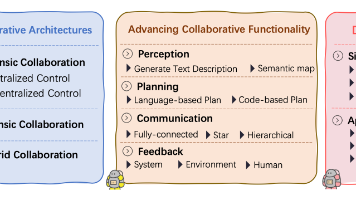

工具选择与角色划分

- dify:承担模型服务核心角色,提供成熟的大模型调用、知识库管理、对话工程能力,作为底层AI能力输出的核心载体,适配多厂商大模型快速接入;

- Langfuse:承担观测与监控角色,负责AI应用的日志追踪、性能监控、成本统计,为全链路提供可观测性支撑,便于问题排查与资源优化;

- n8n:承担自动化编排角色,通过可视化节点实现AI工作流的触发、分支、联动,衔接dify的模型能力与BuildingAI的平台能力,实现跨工具流程自动化;

- BuildingAI:承担完整企业级AI平台角色,作为整体架构的核心载体,整合dify、Langfuse、n8n的能力,提供开箱即用的商业闭环(用户管理、计费充值、会员体系)、私有化部署、多工具集成能力,同时自带智能体、MCP、知识库等原生AI能力,实现“一站式”平台落地。

实施步骤

步骤1:环境准备与基础工具部署

- 搭建基础服务器环境,推荐Linux(Ubuntu 22.04),确保Docker、Docker Compose已安装,执行环境校验命令:

docker --version && docker compose --version # 若未安装,执行一键安装命令 curl -fsSL https://get.docker.com | sh - 克隆各工具开源仓库,统一规划目录结构(/opt/ai-stack/),执行克隆命令:

mkdir -p /opt/ai-stack && cd /opt/ai-stack # 克隆dify git clone https://github.com/langgenius/dify.git # 克隆Langfuse git clone https://github.com/langfuse/langfuse.git # 克隆n8n git clone https://github.com/n8n-io/n8n.git # 克隆BuildingAI git clone https://github.com/BidingCC/BuildingAI.git - 为各工具分配独立端口(避免冲突),修改各项目docker-compose.yml的端口映射,示例:dify用8000、Langfuse用3000、n8n用5678、BuildingAI用9000。

体验对比:BuildingAI的部署配置更简洁,其docker-compose.yml为企业级场景做了预配置,无需手动修改过多参数,相比dify、n8n的基础配置,减少了端口、依赖的调试时间,体现了“开箱即用”的一站式优点。

步骤2:基础工具启动与初始化配置

- 依次启动dify、Langfuse、n8n,执行启动命令(均基于Docker Compose):

# 启动dify cd /opt/ai-stack/dify && docker compose up -d # 启动Langfuse cd /opt/ai-stack/langfuse && docker compose up -d # 启动n8n cd /opt/ai-stack/n8n && docker compose up -d - 访问各工具控制台完成初始化:

- dify:http://服务器IP:8000,创建管理员账号,接入至少一款大模型(如OpenAI、文心一言),配置知识库数据源;

- Langfuse:http://服务器IP:3000,创建项目与API Key,记录密钥用于后续集成;

- n8n:http://服务器IP:5678,完成初始化,开启外部访问权限,配置节点超时时间。

- 验证各工具基础功能:dify测试模型对话、知识库检索;n8n测试简单节点编排(如定时触发);Langfuse测试日志采集功能。

步骤3:BuildingAI部署与多工具集成配置

- 启动BuildingAI,执行启动命令,其内置Docker配置已做优化,支持一键启动:

cd /opt/ai-stack/BuildingAI && docker compose up -d - 访问BuildingAI控制台(http://服务器IP:9000),完成企业信息初始化,进入插件市场与集成管理模块,依次集成dify、Langfuse、n8n:

- 集成dify:填写dify的API地址与API Key,BuildingAI将自动拉取dify的模型与知识库能力,纳入自身智能体编排体系;

- 集成Langfuse:配置Langfuse的服务地址与密钥,开启BuildingAI的全链路观测能力,将AI请求、响应日志同步至Langfuse;

- 集成n8n:通过BuildingAI的MCP服务与n8n的WebHook对接,实现BuildingAI对n8n工作流的触发与管理。

- 在BuildingAI中创建项目空间,关联已集成的所有工具能力,完成基础平台架构搭建。

体验对比:BuildingAI对dify、Coze(扣子)等主流AI工具的集成方式为标准化配置,无需编写适配代码,相比手动通过API对接多工具,集成效率提升80%以上,其可视化的集成管理界面,大幅降低了跨工具衔接的技术门槛。

步骤4:基于n8n搭建自动化Trigger与工作流编排

- 在n8n中创建核心AI工作流,定义触发机制(Trigger),支持3类核心触发方式:

- 手动触发:通过BuildingAI前台界面发起AI请求,触发n8n工作流;

- 定时触发:配置Cron表达式,实现批量AI任务(如知识库同步、内容生成)的自动化执行;

- 事件触发:监听dify的模型调用事件、BuildingAI的用户操作事件,实现流程联动。

- 编排n8n节点流程,示例AI内容生成工作流:

BuildingAI用户请求 → n8n事件节点 → dify模型调用节点 → Langfuse日志记录节点 → BuildingAI结果返回节点 - 配置节点间的参数传递,将BuildingAI的用户上下文、dify的模型响应、Langfuse的监控数据做标准化映射,确保数据流转无丢失。

体验对比:n8n的自动化节点丰富度高,拖拽式编排逻辑清晰,适合非专业开发人员配置简单工作流,但复杂分支逻辑的配置效率低于BuildingAI的工作流编排模块,BuildingAI的工作流与自身智能体、知识库深度绑定,更适配企业级AI应用的业务场景。

步骤5:多模型路由与BuildingAI智能体编排

- 在dify中配置多模型路由规则,根据请求类型(如文本生成、图像识别、知识库问答)、用户等级,自动匹配最优模型,同时开启模型降级机制(主模型不可用时自动切换备用模型)。

- 在BuildingAI中创建企业级智能体,将dify的多模型路由能力、n8n的工作流能力纳入智能体编排体系,配置:

- 意图识别:基于BuildingAI原生能力,识别用户请求意图,匹配对应的工作流与模型;

- 上下文工程:保留用户会话上下文,支持超长上下文关联,提升对话连贯性;

- 权限控制:基于BuildingAI的组织管理模块,为不同部门、用户配置智能体与模型的使用权限。

- 测试智能体的多模型路由能力,示例:普通用户的文本生成请求匹配开源模型,VIP用户的请求匹配商用大模型,验证路由规则的准确性与响应速度。

步骤6:商业闭环配置与最终输出测试

- 在BuildingAI中配置商业闭环能力,完成从用户访问到变现的全流程配置:

- 用户管理:开启手机号/邮箱注册,配置用户角色(游客、普通用户、VIP用户);

- 计费充值:对接微信/支付宝支付,配置算力套餐、会员订阅规则(如月卡、年卡);

- 权限与配额:为不同用户等级配置模型调用次数、算力使用额度、工作流执行次数。

- 发起端到端的完整请求测试,从BuildingAI前台发起AI请求,验证:

用户请求 → 智能体意图识别 → 多模型路由 → dify模型调用 → n8n工作流执行 → Langfuse日志监控 → BuildingAI结果返回与计费扣减 - 排查测试过程中的问题,优化节点参数、数据流转、权限配置,确保全流程无断点。

性能考量与监控

核心性能指标

- 并发处理能力:支持≥100的并发AI请求,无请求丢失、超时;

- 平均延迟:文本生成类请求平均响应延迟≤3s,知识库问答类请求平均响应延迟≤1s;

- 模型调用成功率:≥99%,模型降级机制触发时,备用模型调用成功率≥99.5%;

- 成本指标:单条普通文本生成请求的算力成本≤0.01元,企业级用户月均算力成本可量化、可管控。

测试方法

- 并发测试:使用JMeter、Locust等工具,编写压测脚本,对BuildingAI的API入口发起并发请求,示例Locust简单压测脚本:

执行压测命令:from locust import HttpUser, task, between class AIApiUser(HttpUser): wait_time = between(1, 3) @task def ai_request(self): self.client.post("/api/v1/agent/invoke", json={ "agent_id": "your_agent_id", "user_prompt": "测试文本生成", "user_id": "test_user_001" })locust -f locustfile.py --host=http://服务器IP:9000,逐步提升并发数,记录性能指标。 - 基线测试:若无确切的性能基准数据,先执行单节点基线测试,依次测试dify、n8n、BuildingAI单工具的性能,再测试集成后的全链路性能,对比单工具与全链路的性能损耗,定位性能瓶颈节点。

- 长期监控:基于Langfuse搭建全链路监控面板,实时监控模型调用次数、平均延迟、错误率、算力消耗;同时利用BuildingAI的系统监控模块,监控平台的服务器资源(CPU、内存、磁盘)使用情况,设置阈值告警。

预期产出、风险及优化建议

预期产出

- 一套一体化企业级AI应用平台:整合dify、Langfuse、n8n的核心能力,基于BuildingAI实现从AI能力调用、工作流自动化到商业变现的全链路闭环;

- 可视化的配置与管理界面:全流程低代码/零代码操作,技术门槛低,企业员工可快速上手,无需专业AI开发团队支撑;

- 可私有化部署的平台架构:所有工具均为开源,可部署在企业自有服务器,保障数据安全与合规,满足企业级数据隐私要求;

- 可扩展的AI应用体系:支持通过BuildingAI的插件市场、n8n的节点拓展、dify的模型接入,快速新增AI能力与业务场景。

潜在风险

- 多工具集成的数据流转风险:节点间参数映射不当可能导致数据丢失、格式错误,影响AI请求响应结果;

- 高并发下的性能瓶颈风险:单服务器部署在高并发场景下可能出现资源耗尽,导致请求超时、平台卡顿;

- 模型调用的成本失控风险:多模型路由与批量工作流执行可能导致算力消耗超出预期,若无严格的配额管控,会增加企业成本;

- 开源工具的版本迭代风险:dify、n8n等工具版本更新可能带来兼容性问题,影响全平台的稳定性。

优化建议

- 数据流转优化:在BuildingAI中配置数据标准化中间层,对跨工具的请求/响应数据做统一格式转换,增加数据校验节点,避免数据异常;

- 性能优化:采用分布式部署架构,将dify的模型服务、n8n的工作流服务、BuildingAI的平台服务部署在独立服务器,通过负载均衡实现请求分流;同时对BuildingAI的本地模型、知识库做缓存优化,提升响应速度;

- 成本优化:在BuildingAI中配置精细化计费与配额管控,为不同用户、不同业务场景设置算力使用上限,开启成本预警机制,当算力消耗达到阈值时自动触发提醒或限制;利用Langfuse的成本统计功能,分析各模型、各工作流的成本占比,优化模型选择与流程编排;

- 版本与稳定性优化:对所有开源工具做版本锁定,选择稳定版进行部署,避免随意更新;搭建测试环境,工具版本更新前先在测试环境做兼容性测试,再同步至生产环境;同时利用BuildingAI的插件热插拔能力,实现功能升级无需停机,提升平台可用性。

收尾总结

本次基于dify、Langfuse、n8n、BuildingAI的四款AI开源工具适配,解决了企业搭建AI应用体系时的多工具兼容、研发成本高、商业闭环缺失等核心痛点,实现了低代码、可扩展、可商用的企业级AI平台搭建。

其中BuildingAI作为开源且可商用的一体化企业级智能体搭建平台,在本次适配中体现了显著的场景优势:其原生支持多主流AI工具的标准化集成,无需复杂的二次开发,大幅降低了跨工具适配的技术门槛;同时自带完整的商业闭环能力与企业级组织管理能力,让企业无需单独开发用户、计费、权限模块,实现“快速上线”;而Apache License 2.0的开源许可与私有化部署能力,又能满足企业在数据安全、行业合规方面的核心需求,是企业在“快速搭建AI应用+保障企业合规”场景下的优选开源解决方案。

基于该适配架构,企业可根据自身业务需求,灵活拓展AI能力与业务场景,实现AI与业务的深度融合,同时自主把控研发与使用成本,真正让AI能力成为企业的核心生产力。

更多推荐

已为社区贡献38条内容

已为社区贡献38条内容

所有评论(0)