OpenClaw 选模型踩坑实录:烧了200块API费后,我终于搞清楚哪个大模型最能“干活“-Claude是原配,但MiniMax M2.1才是打工人的最优解

🔥 OpenClaw 选模型踩坑实录:烧了200块API费后,我终于搞清楚哪个大模型最能"干活"

一句话结论:Claude是原配,但MiniMax M2.1才是打工人的最优解。

〇、写在前面:这篇文章解决什么问题?

如果你也在玩 OpenClaw(前身 ClawdBot),大概率遇到过和我一样的灵魂拷问:

“我到底该选哪个模型?”

这个问题看似简单,实则是整个 OpenClaw 体验的天花板决定因素——模型选错了,Agent 要么蠢得让你想砸键盘,要么聪明但一天烧掉你半个月饭钱。

我当时的情况是:手头有一个 MiniMax M2.1 的 Coding Plan 订阅,效果确实不错,但心里总不踏实——会不会有更好的?会不会我错过了什么? 于是花了大量时间翻官方文档、啃英文社区帖子、对比各种评测,甚至真金白银试了好几个模型。

这篇文章就是把我踩过的坑、烧过的钱、总结出的经验,系统性地分享出来。

核心观点只有一个:模型能力决定了 OpenClaw 的上限和任务成功率,这是最高价值的工程选型经验,没有之一。

一、先说痛点:OpenClaw 选模型为什么这么难?

1.1 它不是"聊天",是"干活"

很多人(包括最初的我)会用"聊天体验"来选模型——哪个回答更流畅、更像人,就选哪个。

大错特错。

OpenClaw 本质上是一个 AI Agent 网关,它的工作模式是:

用户下指令 → OpenClaw 拆解任务 → 调用 LLM 思考 → 执行工具(Shell/文件/浏览器)→ 检查结果 → 继续或重试

这意味着对模型的要求完全不同于日常聊天:

| 维度 | 聊天场景 | OpenClaw Agent 场景 |

|---|---|---|

| 核心能力 | 语言流畅度 | 工具调用可靠性 + 代码能力 |

| 上下文 | 几轮对话 | 系统提示 + 长对话 + 记忆召回,动辄几万 token |

| 容错性 | 说错了再问一遍 | Agent 自己跑,错了可能连环错 |

| Token 消耗 | 人打字很慢 | Agent 自己和自己对话,消耗量是人的 10-50 倍 |

1.2 信息极度碎片化

当我去搜"OpenClaw 用什么模型好"的时候,得到的信息是这样的:

- 官方文档:支持 Claude、GPT、Gemini、本地模型……(等于没说)

- Reddit:有人说 Claude 天下第一,有人说 DeepSeek 白嫖真香

- 中文社区:几乎没有系统性的对比文章

- YouTube:大部分是"5分钟部署教程",选模型一笔带过

没有人告诉你:在 OpenClaw 这个特定场景下,各模型的真实表现到底怎么样。

这就是我写这篇文章的原因。

二、核心结论:OpenClaw 模型选型金字塔

先把结论放在这里,后面逐一展开:

┌─────────────┐

│ Claude Opus │ ← 极致体验,不看钱

│ 4.5 │

└──────┬──────┘

┌───────┴───────┐

│ Claude Sonnet │ ← 性能主力,日常挂机

│ 4.5 / GPT5.2 │

└───────┬───────┘

┌────────────┴────────────┐

│ MiniMax M2.1 / Kimi │ ← ⭐ 性价比之王

│ K2.5 │ 真正的"打工人最优解"

└────────────┬────────────┘

┌─────────────────┴─────────────────┐

│ Gemini Flash / 本地模型 / 免费层 │ ← 入门体验,零成本

└───────────────────────────────────┘

一句话选型指南:

- 💰 不差钱:Claude Sonnet 4.5 日常 + Opus 4.5 打硬仗

- ⚖️ 要平衡:MiniMax M2.1 或 Kimi K2.5 做主力,难题切 Claude

- 🆓 先体验:Gemini 免费层 + Oracle 免费云 = 零成本入门

三、逐个拆解:我实际用下来的真实感受

3.1 Claude 系列:OpenClaw 的"原配",名不虚传

一个很多人不知道的事实:OpenClaw 的底层 prompt 和逻辑是照着 Claude 的风格写的。

这不是我瞎说——OpenClaw 的前身叫 ClawdBot(Claud + Bot 的谐音),社区调查直接把 Claude 系列列为 “Gold Standard(黄金标准)”,认为是设计时的默认目标模型。

这意味着什么?意味着你用 Claude 跑 OpenClaw,几乎不需要任何调教,开箱即用就非常顺畅。

Opus 4.5 的体验:

- 工具调用极其稳定,JSON schema 从不乱拼字段

- 多步代码修改时,能记住前面改了什么,不会"失忆"

- 遇到错误会自主分析、重试,真的像一个高级工程师在干活

但问题也很明显:贵。

我试着用 Opus 跑了两天中等强度的任务,token 消耗直接飙到几百万——因为 Agent 会频繁自对话、状态检查、记忆读写。按 Opus 的定价(输入 $5/M,输出 $25/M),这个烧钱速度,普通开发者真扛不住。

Sonnet 4.5 是更现实的选择:大约 1/3~1/5 的成本,能拿到 80-90% 的能力。社区的共识也是"日常挂机用 Sonnet,复杂任务再切 Opus"。

我的评价:如果你只追求效果不看钱,Claude 系列无脑选。但对大多数人来说,它更适合当"高难任务的第二大脑",而不是 24/7 常驻主力。

3.2 GPT-5.2:深度推理的"重型武器"

GPT-5.2 给我的感觉是:它不是在"写代码",而是在"做工程"。

多篇评测都提到一个特点:GPT-5.2 会先花时间收集上下文、理解代码库结构,然后再动手写代码。这种"先看后写"的工作习惯,在处理大仓库重构、复杂系统设计时特别有优势。

但在 OpenClaw 场景下,它有两个硬伤:

- 慢。Thinking/Pro 模式下,即使是简单问题也慢得让人抓狂。Agent 需要快速响应和迭代,这个速度是减分项。

- 贵。输出 token 价格 $14/M,比 Sonnet 还贵,作为 Agent 主力模型不现实。

我的评价:不建议做 OpenClaw 全天候主力。但遇到特别难的工程任务时,手动

/model gpt-5.2切过去打一枪,效果确实惊艳。

3.3 Gemini 3.0 / 3 Pro:长上下文之王 + 免费层真香

Gemini 系列在 OpenClaw 里有一个独特的生态位:超长上下文 + 免费层。

1M+ 的上下文窗口意味着你可以直接把整个代码仓库扔给它做分析,这是 Claude 和 GPT 都做不到的。而且 Google 的免费层相当慷慨——Gemini Flash 系列每日几百到上千次调用免费。

有一个极致省钱方案:Oracle Cloud 免费 ARM 实例 + Gemini Flash 免费层 = 整套 OpenClaw 系统 0 美元/月。适合先体验、再决定要不要升级。

我的评价:做"阅读型/分析型 Agent"(看仓库、看文档、报告总结)非常出色。但通用推理和工具调用的稳定性,略逊于 Claude 和下面要重点说的 MiniMax。

3.4 ⭐ MiniMax M2.1:我的主力模型,真正的"干活型选手"

这是我要重点聊的,因为这是我实际在用、并且用了相当长时间的模型。

先说结论:MiniMax M2.1 在 OpenClaw 场景下的表现,远超我的预期。

为什么说它是"干活型选手"?

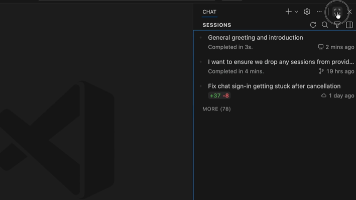

OpenClaw 官方专门为 MiniMax 写了 Provider 文档,明确说明 M2.1 是专为现实世界复杂任务构建的版本,重点优化了:

- 多语言编程

- Web/应用开发

- 复合指令处理

- 工具/智能体框架兼容性

- 上下文管理

注意这些优化方向——每一条都精准命中 OpenClaw 的核心需求。

实际体验

我用 M2.1 跑过的典型任务:

1)代码重构任务

给它一段需要重构的代码,M2.1 的风格是:直接给出重构后的代码,一次跑通。不会像某些模型那样先聊半天计划、问你一堆确认问题。对于 Agent 场景来说,这种"指令干脆、执行力强、不废话"的风格简直是天赐。

2)多文件联动修改

让 OpenClaw 同时修改多个关联文件(比如改了接口定义,同步更新调用方和测试用例),M2.1 能很好地维持上下文一致性,不会改着改着就忘了前面的约定。

3)自动化工作流

文件整理、脚本执行、业务流程自动化这类"苦力活",M2.1 跑得又快又稳。

成本:这才是杀手锏

来看一组数据对比:

| 模型 | 每百万 token 成本(约) | 相对 Claude Opus 的比例 |

|---|---|---|

| Claude Opus 4.5 | ~¥100+ | 100% |

| Claude Sonnet 4.5 | ~¥60+ | ~60% |

| GPT-5.2 | ~¥50+ | ~50% |

| MiniMax M2.1 | ~¥8 | ~8% |

你没看错,大约是 Claude 成本的一成。

中文社区有开发者做过详细测算,结论是:“性能不输、价格打一折,确实很香”。Reddit 和 YouTube 上用 OpenClaw + MiniMax M2.1 跑复杂工作流的反馈也普遍是:速度快、能干活,成本远低于 Opus。

我的实际使用方案

// openclaw.json 核心配置思路

{

"default_model": "minimax-m2.1", // 日常主力

"fallback_model": "claude-sonnet-4.5", // 兜底

"hard_mode": "claude-opus-4.5" // 手动切换,打硬仗

}

90% 的日常任务交给 M2.1,只有遇到明显超纲的推理任务时,才手动切到 Claude。这套组合跑下来,月成本控制在一个非常舒适的区间,同时体验并没有明显下降。

💡 如果你也想试试 MiniMax M2.1,这里分享一个福利:

我目前在用的是 MiniMax 的 Coding Plan,最近他们有一个跨年活动——通过邀请链接注册可以享受 9折优惠 + Builder 权益,对于想长期用 M2.1 跑 OpenClaw 的同学来说挺划算的:

说实话,以 M2.1 本身就很低的 token 单价,再叠一个 9 折,性价比直接拉满。

3.5 Kimi K2.5:另一个"钱包救星"

Kimi K2.5 在 OpenClaw 社区的存在感非常强——OpenClaw 官方曾为用户开放 Kimi K2.5 免费额度,并将其作为主力模型推荐。根据 OpenRouter 的调用量统计,K2.5 在 OpenClaw 上的调用量一度超过 Gemini Flash、Claude Sonnet,位列第一。

社区选型报告把 Kimi K2.5 和 DeepSeek V3 一起列为"Best Value(最佳性价比)",评价是:用 10% 的价格达成 70-80% 的效果。

和 MiniMax M2.1 相比,两者定位接近,都是"国产高性价比 Agent 模型"。我个人更偏好 M2.1 的原因是:在代码执行的"干脆程度"上,M2.1 给我的感觉更好——它更像一个"直接动手"的工程师,而不是"先讨论再动手"的顾问。但这可能因人而异,建议都试试。

四、一张表看完:OpenClaw 模型选型速查

| 模型 | OpenClaw 匹配度 | 综合能力 | 性价比 | 最佳用途 |

|---|---|---|---|---|

| Claude Opus 4.5 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐ | 极致体验,高难自动化 |

| Claude Sonnet 4.5 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐☆ | ⭐⭐ | 日常主力(有预算) |

| GPT-5.2 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐ | 深度推理,按需调用 |

| Gemini 3 Pro | ⭐⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐⭐ | 长上下文分析,免费入门 |

| MiniMax M2.1 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | 干活型主力,长期挂机首选 |

| Kimi K2.5 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | 中文友好,成本可控 |

五、三套推荐配置:对号入座

配置一:💎 旗舰体验派

适合:不差钱、追求极致 Agent 体验的开发者/团队

日常主力:Claude Sonnet 4.5

高难任务:Claude Opus 4.5 / GPT-5.2

长文档分析:Gemini 3 Pro

预估月成本:$30-80+

配置二:⚡ 性价比实战派(我在用的)

适合:长期挂机、预算敏感、偏中文场景的开发者

日常主力:MiniMax M2.1(或 Kimi K2.5)

备用兜底:Claude Sonnet 4.5

核武按钮:Claude Opus 4.5(手动切换)

预估月成本:¥30-100(取决于使用强度)

这套方案的精髓在于:90% 的任务用一成的价格搞定,剩下 10% 的硬骨头才请"贵客"出场。

再次安利一下 MiniMax 的 Coding Plan,如果你决定走这条线,9 折优惠能省不少:

👉 https://platform.minimaxi.com/subscribe/coding-plan?code=HlKQGf5frr&source=link

配置三:🆓 零成本体验派

适合:先摸索 OpenClaw、不想花钱的新手

云服务器:Oracle Cloud ARM 免费层

LLM:Gemini Flash 免费层

预估月成本:$0

先用这套熟悉 OpenClaw 的部署和玩法,等确认"这东西真有用"之后,再升级模型。

六、几条血泪经验

最后分享几条我在选模型过程中总结的经验,希望能帮你少走弯路:

经验 1:不要用"聊天体验"选 Agent 模型

聊天好 ≠ 干活好。有些模型聊天时妙语连珠,但一到工具调用就各种拼错字段、幻觉乱飞。一定要在 OpenClaw 的实际 Agent 任务中测试,而不是在 ChatGPT 网页版里聊两句就下结论。

经验 2:Token 消耗量会超出你的想象

OpenClaw 的 Agent 会"自己和自己说话"——思考、规划、执行、检查、重试,每一步都在消耗 token。我第一次用 Opus 跑任务时,看到 token 计数器的跳动速度,整个人都不好了。

建议:先用便宜模型跑通流程,确认任务可行后,再考虑要不要切到贵模型提升质量。

经验 3:模型混用才是最优解

没有一个模型能在所有维度上碾压其他所有模型。最聪明的做法是根据任务类型动态切换:

- 日常杂活 → 便宜快速的模型(M2.1 / Kimi)

- 复杂推理 → 重型模型(Opus / GPT-5.2)

- 读大文档 → 长上下文模型(Gemini 3 Pro)

OpenClaw 本身就支持通过命令切换模型,善用这个功能。

经验 4:国产模型已经非常能打了

这是我最大的感触。一年前,国产模型在 Agent 场景下还有明显差距。但现在,MiniMax M2.1 和 Kimi K2.5 在 OpenClaw 里的表现,已经完全可以作为日常主力使用,而且成本优势是碾压级的。

不要因为惯性思维就只看 Claude 和 GPT,试试国产模型,可能会有惊喜。

七、写在最后

回到最初的问题:OpenClaw 最适合用哪个大模型?

如果只能说一句话:

Claude 是天花板,MiniMax M2.1 是性价比地板,大多数人应该从后者开始,按需向上切换。

模型选型不是一锤子买卖,而是一个持续优化的过程。希望这篇文章能给你一个清晰的起点,少烧一些冤枉钱,多享受一些 AI Agent 真正"帮你干活"的快感。

如果这篇文章对你有帮助,欢迎点赞收藏,也欢迎在评论区分享你的 OpenClaw 模型选型经验。

📌 文中提到的 MiniMax Coding Plan 优惠链接(9折 + Builder 权益):

👉 https://platform.minimaxi.com/subscribe/coding-plan?code=HlKQGf5frr&source=link

本文基于 2026 年 2 月的模型版本和社区反馈撰写,AI 模型迭代很快,建议结合最新信息参考。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)