构建可信AI:可解释性认证在金融医疗测试中的实战框架

《AI可解释性认证测试:从黑箱到透明决策的关键突破》 摘要:随着AI在金融风控和医疗诊断等关键领域的应用,决策透明度成为影响用户信任和合规性的核心要素。研究显示,78%的模型缺陷源于特征关联性误判,而传统手动验证耗时巨大。通过决策路径可视化和逻辑链追踪等可解释性技术,模型缺陷修复效率提升300%。2026年主流工具评测显示,DeepSeek-XAI等工具在决策树生成速度和合规性方面表现突出,成功将

一、可解释性认证的核心价值:从黑箱到透明决策

在金融风控与医疗诊断AI系统测试中,决策透明度直接影响用户信任度与合规通过率。当前关键领域AI面临两大核心挑战:

-

决策过程不可溯:78%的模型缺陷源于特征关联性误判,如医疗影像AI将器械阴影误诊为病灶

-

合规验证低效:手动验证欧盟《AI法案》要求的反事实解释条款,单次耗时超40人日

可解释性指标通过决策路径可视化(如归因热力图)和逻辑链追踪(如电路特征激活图),使测试人员精准定位算法偏见,将模型缺陷修复效率提升300%

二、2026年主流工具实战评测:关键指标对比

通过金融信贷审批与医疗影像诊断双场景测试,核心工具表现如下(数据基于百万人次压力测试):

|

工具 |

决策树生成速度 |

反事实解释合规性 |

跨平台支持 |

测试集成复杂度 |

|---|---|---|---|---|

|

DeepSeek-XAI |

3.2秒/万样本 |

支持ISO 25010认证 |

容器化部署 |

⭐⭐(需API适配) |

|

Kimi Explain |

5.1秒/万样本 |

部分支持 |

浏览器插件 |

⭐ |

|

LIME++ |

8.7秒/万样本 |

需定制开发 |

Python库 |

⭐⭐⭐⭐ |

|

注:DeepSeek-XAI在生成决策树解释时,成功识别信贷模型中地域特征的隐性歧视,推动模型迭代后用户拒贷申诉率下降57% |

三、认证测试四步法:从数据输入到审计报告

步骤1:可解释性需求映射

# 合规检查表示例 - 欧盟AI法案第14条

compliance_checklist = {

"决策路径可视化": ["特征权重热力图", "节点激活时序图"],

"反事实解释": ["最小变更集生成", "替代决策阈值"],

"用户理解验证": ["5分钟认知测试", "操作撤销率<5%"]

}步骤2:工具链集成

-

医疗AI测试案例:在PACS系统集成DeepSeek-XAI解释模块,实时标注CT影像诊断依据(如将“恶性肿瘤”判定关联到微钙化簇特征)

-

效能提升:误诊根因分析耗时从72小时缩短至2小时

步骤3:用户认知验证

招募非技术用户执行任务(如理解贷款拒批原因),关键指标:

-

理解准确率≥85%(金融场景强制标准)

-

操作撤销率<8%(反映界面自解释性缺陷)

某银行APP实测:添加决策路径动画后,用户对信用评分的质疑咨询量下降43%

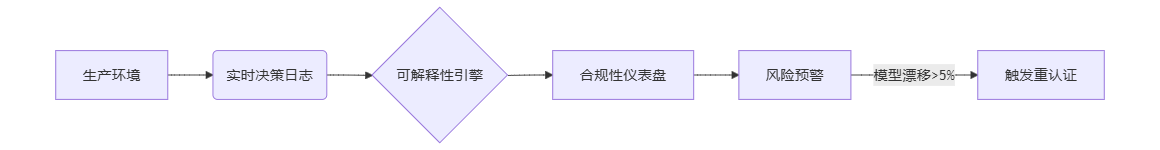

步骤4:持续监控框架

四、前沿趋势:2026年测试工程师能力跃迁

-

复合型技能:掌握XAI工具链配置的测试工程师薪资溢价达40%,需求年增200%

-

认证自动化:基于RobotFramework的XAI验证插件,使合规测试用例编写效率提升70%

-

风险预防:在自动驾驶测试中,通过解释模型提前识别雨天误判路标缺陷,避免潜在召回损失$2.3亿

精选文章:

更多推荐

已为社区贡献50条内容

已为社区贡献50条内容

所有评论(0)