构建类人智能体:超越 MCP 与 Skill 的 AI Agent 基础能力全景

不要被“Agent”一词迷惑——真正的智能体不是魔法,而是一套分层、模块化、可验证的能力系统。层级组件职责大脑外部 LLM API推理、决策、语言生成神经系统调度、状态管理、prompt 注入手脚感官MCP Server 集群连接记忆、工具、机器人经验库Skills(可选)封装复杂业务流程行动建议2026 年,AI Agent 的竞争已从“能否回答问题”转向“能否持续完成复杂任务”。MCP 不是协

作者:一位不愿微调大模型但想让机器人真正“思考”的工程师

适用场景:本地部署、外部 LLM API 调用、机器人控制、企业级 Agent 构建

引言:为什么今天的 Agent 还不够“像人”?

2026 年,AI 智能体(Agent)已从“聊天助手”迈向“数字员工”。然而,许多所谓“智能体”仍停留在单次问答或简单工具调用层面,缺乏连续性、自主性与反思力——而这正是“类人智能”的核心。

本文基于真实工程实践,系统梳理:

一个单智能体要真正“像人”,必须具备哪些基础能力概念?

MCP 与 Skill 在其中扮演什么角色?是否所有能力都该用 Skill 封装?

如何在不微调大模型的前提下,通过本地 MCP 机制实现这些能力?

最终,如何将这套体系集成到 OpenClaw 等个人 AI 代理与自动化平台?

一、AI Agent 的七大基础能力:不止于工具调用

当前业界共识(源自智源、Anthropic、Google A2A、通研院等 2025–2026 报告)认为,一个完整的单智能体需具备以下 7 大基础能力概念:

| 能力 | 核心作用 | 类人对应 |

|---|---|---|

| 1. 目标理解 | 解析用户真实意图,而非字面指令 | “听懂弦外之音” |

| 2. 自主规划 | 将大目标拆解为可执行步骤,并动态调整 | “有计划、会变通” |

| 3. 多层级记忆 | 短期(上下文)、工作(Redis)、长期(向量库)、事件(日志) | “记得住、忘得掉、查得到” |

| 4. 反思评估 | 任务后自我检查:“做对了吗?哪里可优化?” | “吃一堑,长一智” |

| 5. 工具使用 | 调用外部系统(API、数据库、机器人) | “动手能力强” |

| 6. 价值对齐 | 行为符合安全、伦理、权限约束 | “知对错、守规矩” |

| 7. 身份一致性 | 保持角色稳定(如“HR 助手”不会突然讲段子) | “有性格、有立场” |

注意:MCP 和 Skill 并非顶层能力,而是“工具使用”这一能力的具体实现手段。

二、MCP vs Skill:谁该负责什么?

许多开发者误以为“所有能力都该封装成 Skill”,但这会导致架构混乱。正确的分工如下:

| 能力 | 是否适合用 Skill? | 正确实现方式 |

|---|---|---|

| 目标理解、规划、身份一致性 | 否 | 由 Agent Runtime 在 LLM 调用前/后处理(如注入 system prompt、解析 plan) |

| 记忆、反思、安全、工具操作 | 是(但需 MCP 支撑) | Skill 定义“做什么”,MCP 实现“怎么做” |

关键原则:

- Skill = 业务逻辑包(如“订机票流程”)

- MCP = 能力接入层(如“连接 Milvus 查询记忆”)

- Runtime = 控制中枢(负责调度、状态管理、安全网关)

最佳实践:

Skills + MCP 组合拳 —— Skill 教 Agent “如何做事”,MCP 让它“安全地做成事”。

三、本地实现:为何 MCP 是你的唯一选择?

当你面临以下约束:

- 不能微调大模型(使用 DeepSeek、Qwen、Claude 等外部 API)

- 需操作本地资源(Redis、PostgreSQL、机器人硬件)

- 要求安全可控、可审计

那么,MCP 机制是你唯一可行的技术路径。

为什么?

- MCP 本质是 “LLM 的手脚扩展协议” :LLM 只负责推理,所有“做事”由本地服务完成。

- 它提供 标准化接口(JSON Schema),避免 prompt 堆砌的脆弱性。

- 所有敏感操作(如写数据库、控制机器人)都在你掌控的本地进程中执行。

MCP 就是 AI 时代的 USB-C:插上即用,无需改造“主机”(LLM)。

四、本地轻量级 MCP 架构设计

你不需要复杂部署。用 Python + FastAPI 即可快速搭建一套 本地 MCP 服务集群:

核心组件

[Agent Runtime] ← 调用外部 LLM API

↓

[MCP Router] → 路由 tool_name 到对应服务

↓

├── mcp_memory.py # 封装 Redis + Milvus + PostgreSQL

├── mcp_robot_control.py # 对接 OpenColo API

├── mcp_safety_guard.py # 输出过滤与权限检查

└── mcp_reflection.py # 任务后自动反思

MCP 接口规范(简化版)

// 请求

{ "tool_name": "memory_search", "arguments": { "query": "...", "user_id": "u123" } }

// 响应

{ "result": "用户偏好:极简主义" }

示例:记忆 MCP 服务

# mcp_memory.py

from fastapi import FastAPI

import redis

app = FastAPI()

r = redis.Redis()

@app.post("/invoke")

def invoke(tool: str, args: dict):

if tool == "working_memory_set":

r.hset(f"task:{args['task_id']}", args["key"], args["value"])

return {"result": "ok"}

# ... 其他操作

启动命令:uvicorn mcp_memory:app --port 8001

五、集成 OpenClaw:让智能体真正“思考”

要将上述体系集成到 OpenClaw智能体,只需新增一个 MCP 服务:

mcp_robot_control.py

@app.post("/invoke")

def robot_action(action: str, target: str):

if action == "grasp":

# 调用 OpenColo 的 HTTP/gRPC/ROS 接口

requests.post("http://opencolo.local/api/grasp", json={"object": target})

return {"status": "executed"}

完整工作流

- 用户说:“把红色积木放进盒子”

- LLM 调用

mcp_memory.search("red block location") - LLM 调用

mcp_planner(goal="move red block to box") - LLM 调用

mcp_robot_control(action="grasp", target="red_block") - OpenColo 执行动作,结果写入

mcp_memory(事件日志) - 触发

mcp_reflection,评估任务成败

所有数据不出本地,LLM 仅作为“决策大脑”,真正实现 安全、可追溯、可进化的机器人智能体。

六、总结:构建你的“最小可行人格”

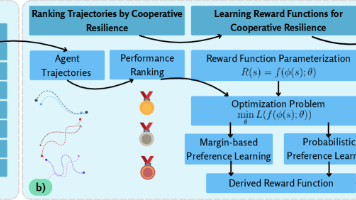

不要被“Agent”一词迷惑——真正的智能体不是魔法,而是一套分层、模块化、可验证的能力系统。

| 层级 | 组件 | 职责 |

|---|---|---|

| 大脑 | 外部 LLM API | 推理、决策、语言生成 |

| 神经系统 | Agent Runtime | 调度、状态管理、prompt 注入 |

| 手脚感官 | MCP Server 集群 | 连接记忆、工具、机器人 |

| 经验库 | Skills(可选) | 封装复杂业务流程 |

行动建议:

结语

2026 年,AI Agent 的竞争已从“能否回答问题”转向“能否持续完成复杂任务”。

MCP 不是协议,而是一种哲学:让大模型专注思考,把世界交还给工程。

你不需要微调模型,也不需要等待 AGI——

今天,你就可以在本地,用 MCP 构建一个真正“像人”的智能体。

更多推荐

已为社区贡献28条内容

已为社区贡献28条内容

所有评论(0)