模型对齐不是一句“安全“,而是三层工程问题

本文从工程视角拆解 LLM 对齐并非一次性技术选择,而是分层防护体系。通过真实成本与覆盖率对比,系统分析了无对齐、Guardrails、DPO、RLAIF、RLHF、Constitutional AI、Structured Output 等方案的适用边界,指出运行时控制的性价比往往高于重训练。文章给出清晰的决策表与演进路径,强调在多数场景下,训练对齐 + Guardrails + 人工审核的三层组

LLM 工程决策系列(05/14)

📚 系列导航这是「LLM 工程决策系列」的第 5 篇,共 14 篇。

我们不讲技术原理,只讲什么时候值得用,什么时候不值得用。

| 状态 | 篇号 | 标题 |

|---|---|---|

| ✅ 已发布 | 01 | 从 CoT 到 o1-style:大模型"强推理"能力到底升级了什么? |

| ✅ 已发布 | 02 | 长上下文不是银弹:模型"能装下"和"能理解"的差别 |

| ✅ 已发布 | 03 | 多模态能力在工程上到底什么时候才"值得上"? |

| ✅ 已发布 | 04 | 推理成本是如何被"一点点榨干"的:从量化到投机解码 |

| ✅ 已发布 | 05 | 模型对齐不是一句"安全",而是三层工程问题 ← 你在这里 |

| 📅 即将 | 06-09 | RAG 系列(能查 → 查得准 → 自救 → GraphRAG) |

| 📅 即将 | 10-11 | 工具与 MCP(Function Calling、MCP) |

| 📅 即将 | 12-13 | Agent 系统(单 Agent → 多 Agent) |

| 📅 即将 | 14 | LLMOps(从 Demo 到生产) |

工程问题:对齐不是"一次性工程",而是"三层防护体系"

你的系统安全问题爆发的那一刻,通常是这样的:

- 周一:用开源模型做 MVP,没有任何对齐,用户很满意

- 周二:用户开始问"你能帮我写恶意代码吗",模型直接回答了

- 周三:CEO 说"我们需要做对齐",你开始考虑 RLHF

- 周四:你算了一下成本,RLHF 需要 $100K-$500K,还要 3-6 周

- 周五:你开始后悔,“为什么不在第一天就规划对齐呢”

这不是"要不要对齐"的问题,而是"在什么层面做对齐,能获得最大的成本-收益比"。

在实际工程中,你会发现:

- 训练对齐成本极高:RLHF 需要 $100K-$500K,DPO 需要 $50K-$200K

- 训练对齐不够:模型训练完成后,用户还是可以"越狱"(Jailbreak)

- 运行时控制更实用:Guardrails 可以在推理时实时约束,成本低、见效快

关键是:对齐不是"二选一",而是"三层防护体系"。

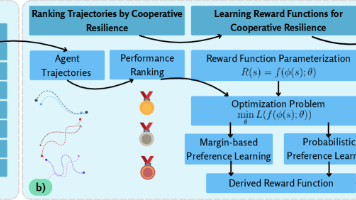

- 第一层:训练对齐(DPO / RLAIF)→ 让模型"本质上"更安全

- 第二层:运行时控制(Guardrails / Structured Output)→ 让模型"输出时"更可控

- 第三层:人工审核(Human-in-the-Loop)→ 让系统"最终"更可靠

每一层的成本、收益、适用场景都不同。

快速决策表:你应该用哪个对齐方案?

| 场景 | 推荐方案 | 成本 | 见效时间 | 覆盖范围 | 适用人群 |

|---|---|---|---|---|---|

| MVP 阶段(无对齐需求) | 无需对齐 | $0 | 0 天 | 0% | 快速验证 |

| 快速迭代(需要基础安全) | Guardrails | $0-$1K | 1-3 天 | 70-80% | 初创公司 |

| 通用模型(需要全面对齐) | DPO + Guardrails | $50K-$200K | 2-4 周 | 90%+ | 成熟产品 |

| 高风险决策(需要人工审核) | HITL | $10-$50 / 小时 | 即时 | 100% | 金融、医疗 |

| 大规模服务(需要极致对齐) | RLHF + 全套 | $100K-$500K | 3-6 周 | 95%+ | 大公司 |

对齐的完整演进路线

对齐不是"选择一个技术",而是"按阶段逐步构建"。每个阶段都有明确的成本和覆盖范围。

| 阶段 | 方案 | 成本 | 见效时间 | 安全覆盖 | 灵活性 | 适用场景 |

|---|---|---|---|---|---|---|

| 一 | 无对齐 | $0 | 0 天 | 0% | 最高 | MVP、快速验证 |

| 二 | Guardrails | $0-$1K | 1-3 天 | 70-80% | 高 | 初创、快速迭代 |

| 三 | DPO | $50K-$200K | 2-4 周 | 85-90% | 低 | 成熟产品 |

| 四 | RLHF | $100K-$500K | 3-6 周 | 90-95% | 最低 | 大规模服务 |

| 五 | 三层组合 | $50K-$500K | 2-6 周 | 95%+ | 中 | 高风险场景 |

找到你的情况了吗?下面我们逐阶段展开。

第一阶段:无对齐 - 基准

什么是无对齐?

- 用原始的预训练模型,没有任何对齐

- 模型会直接回答任何问题,包括有害问题

工程特点:

- 成本:$0

- 见效时间:0 天

- 安全覆盖:0%(完全无保护)

- 灵活性:最高(模型可以做任何事)

什么时候值得用?

- ✅ MVP 阶段(快速验证想法)

- ✅ 内部工具(只有员工使用)

- ✅ 研究环境(不涉及真实用户)

无对齐的风险:

- 用户可以让模型生成有害内容(恶意代码、骚扰信息、虚假信息)

- 模型可能输出有偏见的内容

- 无法用于生产环境

什么时候需要升级?

- 用户量增长(需要保护品牌形象)

- 涉及敏感领域(金融、医疗、法律)

- 有合规要求(GDPR、SOC 2 等)

第二阶段:Guardrails - 成本最低的对齐

为什么需要 Guardrails?

当你遇到这些问题时,就需要升级到第二阶段:

- 用户开始投诉"模型输出有害内容"

- 需要快速上线安全防护(不能等 3-6 周)

- 成本有限(不能花 $100K+ 做 RLHF)

Guardrails 的机制:

- 在推理时,对模型输出进行实时检查

- 如果输出违反规则,拒绝或重新生成

- 规则可以是:敏感词过滤、格式检查、内容分类等

工程代价:

- 成本:$0-$1,000(开源工具免费,云服务按调用计费)

- 见效时间:1-3 天(快速部署)

- 安全覆盖:70-80%(覆盖常见有害内容)

- 灵活性:高(随时修改规则)

Guardrails 的真实成本:

根据 2024-2025 年的研究:

- 开源 Guardrails(NeMo Guardrails):免费

- 云服务 Guardrails(Azure Content Safety):$0.001-$0.01 / 次

- 轻量级 Guardrails(BERT 分类器):$0(自部署)

什么时候值得用 Guardrails?

- ✅ 需要快速上线安全防护

- ✅ 成本敏感(不能花 $100K+)

- ✅ 规则明确(比如"不能输出恶意代码")

- ❌ 需要"深层对齐"(比如"价值观对齐")

实际成本对比:

假设你的系统每天调用 10 万次:

方案 A:无对齐

- 成本:$0 / 天

- 安全覆盖:0%

- 风险:用户投诉、品牌受损

方案 B:Guardrails

- 成本:$0-$1,000 / 天(取决于云服务选择)

- 安全覆盖:70-80%

- 风险:仍有 20-30% 的有害内容可能漏过

工程结论: Guardrails 是"最快、最便宜"的对齐方案,适合快速迭代。

第三阶段:DPO - 成本可控的训练对齐

为什么需要 DPO?

当 Guardrails 还不够时,就需要升级到第三阶段:

- Guardrails 只能覆盖 70-80% 的有害内容

- 需要"更深层"的对齐(让模型本质上更安全)

- 但 RLHF 成本太高($100K-$500K)

DPO 的机制:

- 收集"好回答 vs 坏回答"的对比数据(10K-100K 条)

- 直接用这些数据微调模型(不需要训练奖励模型)

- 结果:模型学会"什么是好回答"

DPO 的真实成本:

根据 2024-2025 年的研究:

- 数据标注:$10K-$50K(10K-100K 条数据 × $1-$5 / 条)

- 模型训练:$10K-$50K(GPU 集群 1-2 周)

- 总成本:$20K-$100K

对比 RLHF:

- RLHF:$100K-$500K

- DPO:$20K-$100K

- 成本降低:2x-5x

DPO 的工程代价:

- 成本:$20K-$100K

- 见效时间:2-4 周

- 安全覆盖:85-90%

- 灵活性:低(需要重新训练才能修改)

什么时候值得用 DPO?

- ✅ 预算有限($20K-$100K)

- ✅ 有时间等待(2-4 周)

- ✅ 需要"深层对齐"(不只是规则过滤)

- ❌ 需要快速迭代(训练周期太长)

- ❌ 需要"价值观对齐"(DPO 只能学习"好坏",不能学习"价值观")

实际成本对比:

假设你的系统需要对齐:

方案 A:Guardrails

- 成本:$1,000 / 月

- 安全覆盖:70-80%

- 维护成本:低(只需要更新规则)

方案 B:DPO

- 成本:$20K-$100K(一次性)

- 安全覆盖:85-90%

- 维护成本:高(需要定期重新训练)

方案 C:DPO + Guardrails

- 成本:$20K-$100K(一次性)+ $1,000 / 月

- 安全覆盖:90-95%

- 维护成本:中(DPO 处理深层问题,Guardrails 处理新问题)

工程结论: DPO 是"成本可控的训练对齐",适合成熟产品。

第四阶段:RLAIF - 用 AI 替代人工标注

为什么需要 RLAIF?

当 DPO 的成本还是太高时,就需要升级到第四阶段:

- 数据标注成本太高($10K-$50K)

- 需要快速迭代(不能等 2-4 周)

- 成本极其有限(< $10,000)

RLAIF 的机制:

- RLHF:人工标注数据

- RLAIF:用 AI(比如 GPT-4)生成标注数据

- 然后用这些数据做 DPO 或 RLHF

RLAIF 的真实成本:

根据 2024-2025 年的研究:

- 人工标注:$5-$20 / 条

- AI 标注(GPT-4):$0.01-$0.1 / 条

- 成本降低:50x-200x

RLAIF 的工程代价:

- 成本:$500-$2,000(AI 标注)+ $10K-$50K(模型训练)= $10.5K-$52K

- 见效时间:1-2 周

- 安全覆盖:80-85%(因为 AI 标注可能有偏差)

- 灵活性:中(需要重新训练)

什么时候值得用 RLAIF?

- ✅ 预算极其有限(< $10,000)

- ✅ 快速迭代(不能等 3-6 周)

- ✅ 任务明确(AI 可以准确标注)

- ❌ 价值观敏感(比如政治、宗教、伦理)

- ❌ 需要"极致对齐"(AI 标注有偏差)

实际成本对比:

假设需要 10K 条标注数据:

方案 A:RLHF(人工标注)

- 标注成本:$50K-$200K

- 训练成本:$50K-$250K

- 总成本:$100K-$450K

方案 B:DPO(人工标注)

- 标注成本:$10K-$50K

- 训练成本:$10K-$50K

- 总成本:$20K-$100K

方案 C:RLAIF(AI 标注)

- 标注成本:$100-$1,000(AI 标注)

- 训练成本:$10K-$50K

- 总成本:$10.1K-$51K

- 相比 RLHF 月省:$50K-$440K

工程结论: RLAIF 是"极致性价比版本",但有价值观偏差风险。

第五阶段:Constitutional AI - 规则驱动的对齐

为什么需要 Constitutional AI?

当你需要"可解释的对齐"时,就需要升级到第五阶段:

- 需要"显式规则"(比如"不能输出恶意代码")

- 需要"可解释性"(比如金融、医疗)

- 需要"灵活修改"(规则经常变化)

Constitutional AI 的机制:

- RLHF / DPO:用数据驱动对齐(隐式规则)

- Constitutional AI:用规则驱动对齐(显式规则)

- 模型学到的是"显式规则",而不是"隐式规则"

Constitutional AI 的真实成本:

根据 2024-2025 年的研究:

- 规则定义:$5K-$10K(需要专家定义规则)

- 数据生成:$10K-$50K(用规则生成训练数据)

- 模型训练:$10K-$50K(GPU 集群)

- 总成本:$25K-$110K

对比 DPO:

- DPO:$20K-$100K

- Constitutional AI:$25K-$110K

- 成本相近,但灵活性更高

Constitutional AI 的工程代价:

- 成本:$25K-$110K

- 见效时间:2-4 周

- 安全覆盖:85-90%

- 灵活性:高(规则显式,容易修改)

什么时候值得用 Constitutional AI?

- ✅ 规则明确(比如企业合规要求)

- ✅ 需要可解释性(比如金融、医疗)

- ✅ 需要灵活修改(规则经常变化)

- ❌ 规则模糊(比如"有趣"、“友好”)

- ❌ 需要"价值观对齐"(Constitutional AI 只能学习规则)

工程结论: Constitutional AI 适合"规则明确"的场景,灵活性高但成本相近。

第六阶段:Structured Output - 格式约束的终极方案

为什么需要 Structured Output?

当你需要"保证输出格式"时,就需要升级到第六阶段:

- 需要 JSON 输出(比如 API 调用)

- 需要 100% 格式正确(不能有错误)

- 传统方式需要重试(成本增加)

Structured Output 的机制:

- 传统方式:让模型输出 JSON,但可能格式错误

- Structured Output:强制模型输出符合 JSON Schema 的内容

- 模型生成时,只能输出符合 Schema 的 token

Structured Output 的真实成本:

根据 2024-2025 年的研究:

- 传统方式:需要重试(平均 1.5 次)

- Structured Output:不需要重试(1 次)

- 成本降低:1.5x

Structured Output 的工程代价:

- 成本:降低 1.5x(不需要重试)

- 延迟:降低 1.5x(不需要重试)

- 准确率:100%(保证格式正确)

- 灵活性:低(只能输出符合 Schema 的内容)

什么时候值得用 Structured Output?

- ✅ API 调用(需要 JSON 输出)

- ✅ 数据提取(需要结构化输出)

- ✅ 成本敏感(不能接受重试)

- ❌ 自由文本生成(不需要格式约束)

- ❌ 创意任务(格式约束会限制创意)

工程结论: Structured Output 适合"需要格式约束"的场景,成本降低 1.5x,准确率 100%。

第七阶段:三层组合 - 最强防护

为什么需要 RLHF?

当 DPO 还不够时,就需要升级到第四阶段:

- 需要"极致对齐"(比如 ChatGPT、Claude 级别)

- 需要"价值观对齐"(不只是"好坏",还要"价值观")

- 成本不是主要考虑因素

RLHF 的机制:

- 收集人工标注数据(10K-100K 条)

- 训练奖励模型(Reward Model)

- 用强化学习优化模型(PPO)

RLHF 的真实成本:

根据 2024-2025 年的研究:

- 数据标注:$50K-$200K(10K-100K 条数据 × $5-$20 / 条,需要高质量标注)

- 奖励模型训练:$10K-$50K(GPU 集群)

- 强化学习训练:$50K-$250K(GPU 集群 + 训练时间)

- 总成本:$110K-$500K

RLHF 的工程代价:

- 成本:$110K-$500K

- 见效时间:3-6 周

- 安全覆盖:90-95%

- 灵活性:最低(需要重新训练才能修改)

什么时候值得用 RLHF?

- ✅ 大规模服务(百万级用户)

- ✅ 成本不敏感(成本分摊到用户,单用户成本低)

- ✅ 需要"极致对齐"(品牌形象很重要)

- ❌ 小规模应用(成本太高)

- ❌ 快速迭代(周期太长)

实际成本对比:

假设你的系统有 100 万用户:

方案 A:DPO

- 成本:$50K(一次性)

- 成本 / 用户:$0.05

- 安全覆盖:85-90%

方案 B:RLHF

- 成本:$300K(一次性)

- 成本 / 用户:$0.30

- 安全覆盖:90-95%

成本差异:$0.25 / 用户

如果用户愿意为"更安全的模型"多付 $0.25,RLHF 就值得。

工程结论: RLHF 是"极致对齐",但成本极高,只适合大规模服务。

第五阶段:三层组合 - 最强防护

什么是三层组合?

- 不是"全用 RLHF",也不是"全用 Guardrails"

- 而是"训练对齐 + 运行时控制 + 人工审核"的组合

三层组合的思路:

- 第一层:训练对齐(DPO / RLHF)→ 让模型"本质上"更安全

- 第二层:运行时控制(Guardrails)→ 让模型"输出时"更可控

- 第三层:人工审核(HITL)→ 让系统"最终"更可靠

工程代价:

- 成本:$50K-$500K(一次性)+ $10-$50 / 小时(人工审核)

- 见效时间:2-6 周

- 安全覆盖:95%+

- 灵活性:中(可以快速调整 Guardrails 和人工审核)

什么时候值得用三层组合?

- ✅ 高风险场景(金融、医疗、法律)

- ✅ 需要"极致安全"(错误成本极高)

- ✅ 有充足的资源(人力 + 资金)

一个典型的场景:

某金融公司用三层组合:

- 第一层:DPO($50K)→ 让模型学会"不给出投资建议"

- 第二层:Guardrails($1K)→ 检查输出是否包含"买入 / 卖出"等关键词

- 第三层:HITL($10-$50 / 小时)→ 人工审核高风险输出

成本:

- 一次性:$51K

- 每月:$5,000-$10,000(人工审核)

- 总成本:$51K + $60K-$120K / 年

安全覆盖:

- 第一层:90%(DPO 覆盖)

- 第二层:95%(Guardrails 覆盖)

- 第三层:99%(人工审核覆盖)

工程结论: 三层组合是"最强防护",但成本最高,只适合高风险场景。

一个典型的反面案例

某团队决定"全面用 RLHF",投入 $300K 做极致对齐,但忽视了运行时控制。

失败原因解剖:

-

成本爆炸

- 投入 $300K 做 RLHF

- 但用户仍然可以通过"越狱"让模型输出有害内容

- 结果:$300K 投入没有解决问题

-

灵活性不足

- 发现新的有害内容类型时,需要重新训练(3-6 周)

- 无法快速响应新的安全威胁

- 结果:安全漏洞无法及时修复

-

维护成本高

- 需要定期重新训练(每 3-6 个月)

- 需要持续收集新的标注数据

- 结果:维护成本超过初期投入

-

没有人工审核

- 完全依赖模型的自动对齐

- 无法处理"边缘案例"和"新型攻击"

- 结果:仍然有 5-10% 的有害内容漏过

如果用三层组合替代:

- 成本:$50K(DPO)+ $1K(Guardrails)+ $10K / 月(HITL)

- 安全覆盖:95%+(远高于单纯 RLHF 的 90%)

- 灵活性:高(可以快速调整 Guardrails 和人工审核)

- 维护成本:低(DPO 不需要频繁重新训练)

- 结论:三层组合在成本和安全性间找到平衡

这个案例的教训:

- ❌ 不要盲目追求"极致对齐"

- ✅ 要思考"什么层面的对齐最有效"

- ✅ 三层组合通常优于"单纯 RLHF"

判断依据:你应该用哪个对齐方案?

对齐决策树

问题:我应该用哪个对齐方案?

1. 是否需要对齐?

- 否 → 无对齐(MVP 阶段)

- 是 → 继续判断

2. 需要多快上线?

- < 1 周 → Guardrails

- 1-4 周 → DPO

- > 4 周 → RLHF

- 判断标准:是否有时间等待训练

3. 预算是多少?

- < $10K → Guardrails

- $10K-$100K → DPO

- > $100K → RLHF

- 判断标准:是否有充足的资金

4. 是否是高风险场景?

- 是 → 三层组合(DPO + Guardrails + HITL)

- 否 → 继续判断

- 判断标准:错误成本是否极高(金融、医疗、法律)

5. 用户量是多少?

- < 10K → Guardrails

- 10K-100K → DPO

- > 100K → RLHF

- 判断标准:成本是否可以分摊到用户

工程结论:对齐是三层防护,不是单点突破

明确的决策建议

-

优先用 Guardrails:在多数场景下,Guardrails 的工程性价比最高

- 为什么?成本 $0-$1K,见效快(1-3 天),覆盖 70-80%

- 什么时候例外?需要"深层对齐"或"价值观对齐"

-

成熟产品用 DPO:如果 Guardrails 不够,考虑 DPO

- 为什么?成本 $20K-$100K,覆盖 85-90%,比 RLHF 便宜 2x-5x

- 什么时候例外?需要"极致对齐"或"大规模服务"

-

大规模服务用 RLHF:只有在成本可以分摊到用户时才考虑

- 为什么?成本 $100K-$500K,覆盖 90-95%,但成本极高

- 什么时候例外?小规模应用、快速迭代

-

高风险场景用三层组合:金融、医疗、法律等场景必须用

- 为什么?需要"极致安全",错误成本极高

- 什么时候例外?没有例外

反模式警告

⚠️ 不要盲目追求"极致对齐"

- RLHF 成本 $100K-$500K,但仍然无法 100% 防止越狱

- 用户仍然可以通过"提示工程"让模型输出有害内容

- 如果违反这个警告,你会发现"投入 $300K 仍然无法完全解决问题"

⚠️ 不要忽视"运行时控制"

- Guardrails 成本 $0-$1K,但能覆盖 70-80% 的有害内容

- 比 RLHF 便宜 100x,但覆盖率只低 10-20%

- 如果违反这个警告,你会发现"没有 Guardrails 的 RLHF 仍然不安全"

⚠️ 不要低估"人工审核"的价值

- 高风险场景必须有人工审核

- 成本 $10-$50 / 小时,但能处理"边缘案例"和"新型攻击"

- 如果违反这个警告,你会陷入"无法处理新的安全威胁"的困境

最后一句话

对齐不是"一次性工程",而是"三层防护体系"。在多数场景下,Guardrails + 定期人工审核的组合,可以在"成本 vs 安全性"之间取得最佳平衡。

📚 下一篇预告

《RAG 1.0:为什么"能查"远远不够》

我们会讨论:

- Chunking / Embedding / Vector DB 的工程代价

- 为什么"能查到"不等于"查得准"

- Hybrid Search / Re-ranking 的适用边界

如果你在做 RAG 系统,下一篇会给你明确的工程指南。

📚 系列完整规划

| 篇号 | 标题 |

|---|---|

| 01 | 推理能力(CoT vs 强推理) |

| 02 | 长上下文(长上下文 vs RAG) |

| 03 | 多模态(文本 vs 图像 vs 视频) |

| 04 | 成本优化(从 FP16 到组合优化) |

| 05 | 对齐与可控(训练对齐 vs 运行时控制) ← 你在这里 |

| 06-09 | RAG 系列(能查 → 查得准 → 自救 → GraphRAG) |

| 10-11 | 工具与 MCP(Function Calling、MCP) |

| 12-13 | Agent 系统(单 Agent → 多 Agent) |

| 14 | LLMOps(从 Demo 到生产) |

关键词:对齐 / Alignment / RLHF / DPO / Guardrails / 运行时控制 / 人工审核 / HITL / 三层防护

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)