【自然语言处理与大模型】什么是大模型幻觉?

这篇文章探讨一下 AI “一本正经胡说八道” 的根源。首先我们得知道什么是大模型幻觉。然后尝试简单回答为什么会有幻觉,最后结合OpenAI发表的《语言模型为何产生幻觉》论文来揭示幻觉的本质。

·

这篇文章探讨一下 AI “一本正经胡说八道” 的根源。首先我们得知道什么是大模型幻觉。然后尝试简单回答为什么会有幻觉,最后结合OpenAI发表的《语言模型为何产生幻觉》论文来揭示幻觉的本质。

一、什么是大模型幻觉?

常见的大模型四大幻觉类型。

| 幻觉类型 | 定义 | 举例说明 |

|---|---|---|

| 上下文矛盾 | 生成内容前后逻辑不一致 | 模型先说 “昨天去了巴黎”,后又说 “

从未离开家乡”。 |

| 荒谬回复 | 内容包含现实中不可能发生的事 | 模型声称 “人类可以通过呼吸水生存”。 |

| 提示词不符 | 生成内容与用户输入目标不一致 | 用户问 “如何制作披萨”,模型回答 “如何种植树木”。 |

| 违背事实 | 内容与已知科学、历史事实冲突 | 模型生成 “地球是平的”。 |

二、为什么大模型会有幻觉?

(1)提示词设计不当

- 核心问题:用户的问题或指令(提示词)本身存在歧义、目标不明确或信息缺失。

- 产生幻觉:模型会根据不清晰的指令进行 “脑补”,从而生成与用户真实意图不符的内容。

- 例如:用户问 “给我推荐一些好的电影”,但没有说明偏好类型,模型可能会推荐一些你不感兴趣的影片。

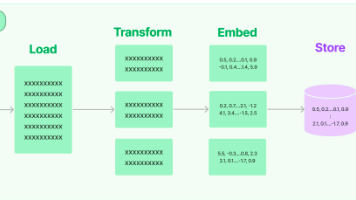

(2)生成过程的概率性

- 核心问题:大模型的工作原理是基于概率预测下一个词,而非真正理解语义。

- 产生幻觉:模型会从训练数据中学习词语之间的统计关系,并在生成时选择概率最高的词。这导致它更注重文本的连贯性和流畅性,而非内容的真实性。

- 例如:它可能会生成 “北京有埃菲尔铁塔” 这样的句子,因为它学习到 “北京” 与 “著名建筑” 相关,而 “埃菲尔铁塔” 是著名建筑的概率很高,从而将两者错误地组合在一起。

(3)训练过程中的过拟合

- 核心问题:在训练阶段,如果模型过度依赖和记忆了训练数据中的某些异常值或错误信息,就会产生 “过拟合”。

- 产生幻觉:当模型遇到新的、未见过的数据时,它可能会错误地套用训练数据中的异常模式,从而生成不符合常规逻辑的回答。

- 例如:如果训练数据中包含大量错误的历史事件描述,模型在回答相关问题时就可能复述这些错误。

(4)训练数据质量问题

- 核心问题:训练数据是大模型知识的唯一来源,但这些数据(通常是互联网内容)不可避免地包含错误、偏见、过时信息和逻辑矛盾。

- 产生幻觉:模型无法辨别信息的真伪,会将这些错误信息一并学习并放大。

- 例如:如果训练数据中包含 “地球是平的” 这类错误信息,模型在被问及相关问题时,就可能基于概率生成这一错误答案。

三、参考资料

OpenAI 发表的《Why Language Models Hallucinate》

(1)幻觉产生的直接原因

后训练阶段的奖励机制。模型答对得 1 分,答错或说 “不知道” 得 0 分。这导致模型倾向于猜测答案,而非直接说 “不知道”,从而产生幻象。

预训练阶段的数据和模型架构问题。即使预训练数据全部正确,模型仍可能因数据分布复杂、模型无法拆分细节等原因产生幻象。具体来说:

-

数据分布复杂:真实数据分布可能是圆形,但模型用线性分割,导致误判。

-

模型架构限制:模型难以拆分 token 细节,导致对某些数据的理解偏差。

-

数据无规律:大量无规律的事实(如人名与生日的对应关系)让模型难以记忆,回答时容易出错。

(2)论文给出的建议

要想减少语言模型的幻觉,关键不是多出几道防幻觉的测试题,而是要修改现有主流排行榜的评分方式——不再对“我不确定/不知道”这类回答做系统性惩罚,让模型在不确定时更安全地选择承认无知而不是硬猜。这是一个需要社区协同的“社会技术干预”,而不是单一算法技巧。

更多推荐

已为社区贡献19条内容

已为社区贡献19条内容

所有评论(0)