大模型实战从入门到精通:本地LLM情感分析保姆级教程,收藏这一篇就够了!

这一篇,我们不再讲部署、不讲参数、不讲框架对比,只干一件事:

- • 用 Ollama 把开源大模型跑在本地

- • 学会 API 调用 + LLM 封装

- • 把 AI 塞进 VS Code + Remote SSH

- • 尝试了更偏工程和性能的 vLLM 推理框架

但这一步都会有一个真实的疑问:

“环境是搭好了,但它到底能帮我干什么?”

这一篇,我们不再讲部署、不讲参数、不讲框架对比,

只干一件事:

用本地大模型,真正做一次“能用的文本分析”。

而且是——

不训练模型、不开复杂 NLP 管线、小白也能直接复现的那种。

一、为什么用大模型做文本分析,真的很合适?

在传统 NLP 里,哪怕只是一个简单的“文本分类”,你也要:

- • 分词

- • 构造特征

- • 准备标注数据

- • 训练模型

- • 调参、验证

对课程作业、毕设、小项目来说,这个成本其实很高。

而大模型改变了一件事:

它本身就已经“会读中文、懂情绪、会归纳”。

于是现在我们可以换一种思路:

- • 不训练模型

- • 不构造特征

- • 直接告诉模型:“你要做什么,输出什么”

这就是 Prompt = 分类器 的思路。

二、我们要完成一个什么任务?

为了保证复现性和通用性,这一篇选一个最稳的任务组合:

文本情感分析(正 / 中 / 负)

支持 CSV 批量处理

你可以把它直接用在:

- • 评论情感分析

- • 问卷开放题

- • 客服反馈

- • 新闻情绪初筛

- • 风险 / 舆情初步判断

示例文本

快点进吧,4 千点是起点再次见证历史 4000 点没意思啊,不放量就没有突破的意思,这样子的话下午还得下去

部分目标输出:

| text | label |

|---|---|

| 快点进吧,4 千点是起点 | 中性 |

| 再次见证历史 4000 点 | 正性 |

| 没意思啊,不放量就没有突破的意思,这样子的话下午还得下去 | 负向 |

三、关键一步:写一个稳定、可复现的 Prompt

这一部分是全篇的核心。

一个好的 Prompt,比你换模型更重要。

推荐系统提示

你是一个中文文本分析助手。请判断下面文本的情感类别,只能从以下三类中选择一个:- 正向- 中性- 负向要求:1. 只输出分类结果,不要输出任何解释。2. 输出必须严格为以上三个标签之一。

为什么这样写?

- • 限定身份(文本分析助手)

- • 限定标签集合

- • 禁止解释(避免输出不稳定)

这一步可以显著提高一致性。

四、先来一次:用 Ollama 本地模型做单条分析

如果你已经按第一篇配置好了 Ollama,这一步可以直接跑。

4.1 本地调用示例(Python)

from ollama import chatSYSTEM_PROMPT = """你是一个中文文本分析助手。请判断下面文本的情感类别,只能从以下三类中选择一个:- 正向- 中性- 负向只输出分类结果。"""resp = chat( model="deepseek-r1:1.5b", messages=[ {"role": "system", "content": SYSTEM_PROMPT}, {"role": "user", "content": "再次见证历史 4000 点"} ])print(resp["message"]["content"])

输出示例:

正向

到这里,你已经完成了:

一个不训练的“文本情感分类器”。

五、真正有用的部分:CSV 批量处理

单条分析只是热身,真正有价值的是批量处理。

5.1 准备一个TXT/ CSV 文件

数据量较小,以texts.txt为例。

text虽然红了,感觉有点假,管住手啊再次见证历史 4000 点没意思啊,不放量就没有突破的意思,这样子的话下午还得下去快点进吧,4 千点是起点大小盘齐发力,才能站稳 4 千点,干爆空狗相信国运,坐等起飞跌就死命跌,涨就磨磨唧唧一点点涨,这市场谁玩?拉尾盘,明天低开 2 个点抢筹上车今天涨多少,明天还回来!快加仓,晚上让我看看你们的底牌赶紧拉起来啊,都快到点了跑吧高开低走,平开低走,低开低走,一路向下!老乡别走,我也要走了开盘赚一万三,收盘你不会连个零头都不给我剩吧该涨涨了…… 又一个 5 年…… 人生有多少个 5 年啊?年摸一下 4000 不为过吧

5.2 批量标注代码(核心代码)

import pandas as pdfrom ollama import chatSYSTEM_PROMPT = """你是一个中文文本分析助手。请判断下面文本的情感类别,只能从以下三类中选择一个:- 正向- 中性- 负向只输出分类结果。"""defclassify(text): resp = chat( model="deepseek-r1:1.5b", messages=[ {"role": "system", "content": SYSTEM_PROMPT}, {"role": "user", "content": text} ] ) return resp["message"]["content"].strip()df = pd.read_csv("E:/C博士/课程/人工智能与大模型/lecture/lecture2_llm/lecture2_llm/comments.txt", header=None, names=["text"])df["label"] = df["text"].apply(classify)df.to_csv("labeled.csv", index=False, encoding="utf-8-sig")print(" 批量标注完成")

运行结束后,你会得到 labeled.csv:

text,label虽然红了,感觉有点假,管住手啊,负向再次见证历史 4000 点,正向没意思啊,不放量就没有突破的意思,这样子的话下午还得下去,正向

🎉 恭喜,你已经完成了一次“零训练的文本分析流程”。

当然,也可以调用API进行情感分析。参考第二篇大模型API调用。

六、那 vLLM 在这里有什么用?

如果你还记得第四篇,我们专门讲了 vLLM。

现在它的价值就很清楚了👇

Ollama 更适合:

- • 单条 / 小批量

- • 本地交互

- • 原型验证

- • 学生电脑

vLLM 更适合:

- • CSV 上千 / 上万行

- • 批量推理

- • 长文本

- • 服务器部署

- • 多用户 / 多任务

一句话总结:

**第四篇解决“跑得起来”,

**第五篇开始解决“跑得多、跑得快”。

代码几乎不用改,只需要把后端从 Ollama 换成 vLLM 服务即可。

七、学生 / 项目 / 研究可以直接用在哪?

下面这几个方向,几乎都是现成选题:

- • 📋 问卷开放题情感分析

- • 🛒 商品 / App 评论分析

- • 📰 新闻情绪或态度初筛

- • ⚠️ 风险句子初步识别

- • 📚 文献摘要与要点分类辅助

一句话定位:

大模型非常适合做“第一道文本处理工序”。

学AI大模型的正确顺序,千万不要搞错了

🤔2026年AI风口已来!各行各业的AI渗透肉眼可见,超多公司要么转型做AI相关产品,要么高薪挖AI技术人才,机遇直接摆在眼前!

有往AI方向发展,或者本身有后端编程基础的朋友,直接冲AI大模型应用开发转岗超合适!

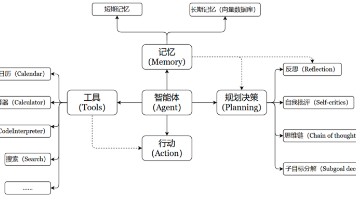

就算暂时不打算转岗,了解大模型、RAG、Prompt、Agent这些热门概念,能上手做简单项目,也绝对是求职加分王🔋

📝给大家整理了超全最新的AI大模型应用开发学习清单和资料,手把手帮你快速入门!👇👇

学习路线:

✅大模型基础认知—大模型核心原理、发展历程、主流模型(GPT、文心一言等)特点解析

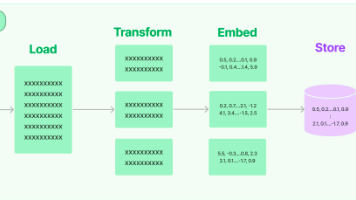

✅核心技术模块—RAG检索增强生成、Prompt工程实战、Agent智能体开发逻辑

✅开发基础能力—Python进阶、API接口调用、大模型开发框架(LangChain等)实操

✅应用场景开发—智能问答系统、企业知识库、AIGC内容生成工具、行业定制化大模型应用

✅项目落地流程—需求拆解、技术选型、模型调优、测试上线、运维迭代

✅面试求职冲刺—岗位JD解析、简历AI项目包装、高频面试题汇总、模拟面经

以上6大模块,看似清晰好上手,实则每个部分都有扎实的核心内容需要吃透!

我把大模型的学习全流程已经整理📚好了!抓住AI时代风口,轻松解锁职业新可能,希望大家都能把握机遇,实现薪资/职业跃迁~

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献633条内容

已为社区贡献633条内容

所有评论(0)