# 探索CANN的底层奥秘:从算子优化到系统级调优

在人工智能基础设施不断演进的今天,我们早已不再满足于“模型能跑起来”这一基础目标。性能、效率、可维护性与扩展能力,成为衡量一个AI平台是否真正成熟的四大标尺。而在这背后,往往离不开一套强大且精细的支撑——本文将继续深入探讨的技术内核,聚焦其在底层优化、资源调度与生态协同方面的创新实践。这一次,我们将以“开发者视角 + 系统架构师思维”双重视角切入,带你走进代码与硬件之间的灰色地带,揭开那些让AI推

探索CANN的底层奥秘:从算子优化到系统级调优

在人工智能基础设施不断演进的今天,我们早已不再满足于“模型能跑起来”这一基础目标。性能、效率、可维护性与扩展能力,成为衡量一个AI平台是否真正成熟的四大标尺。

而在这背后,往往离不开一套强大且精细的异构计算软件栈支撑——本文将继续深入探讨 CANN(Compute Architecture for Neural Networks) 的技术内核,聚焦其在底层优化、资源调度与生态协同方面的创新实践。

这一次,我们将以“开发者视角 + 系统架构师思维”双重视角切入,带你走进代码与硬件之间的灰色地带,揭开那些让AI推理速度飙升的秘密。

🔍 为什么需要专用计算架构?

在通用GPU主导的时代,许多AI任务确实得到了显著加速。但随着模型结构日益复杂(如Transformer、MoE、动态图),传统架构开始暴露出一些瓶颈:

| 问题 | 具体表现 |

|---|---|

| 内存带宽利用率低 | 数据搬运开销超过实际计算时间 |

| 算力碎片化 | 小算子频繁切换导致流水线中断 |

| 编程模型受限 | 难以发挥定制化硬件单元的优势 |

这正是像 CANN 这类面向特定硬件设计的软件栈诞生的背景:不是替代通用方案,而是为专业场景提供更高效的路径。

⚙️ 深入核心:CANN 是如何实现高效执行的?

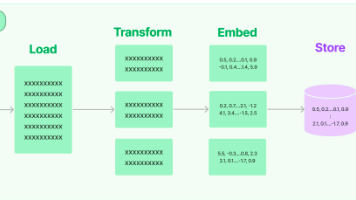

1. 图级别优化:从“拼积木”到“一体化设计”

传统的推理引擎通常采取“逐个算子匹配”的方式运行模型。而 CANN 引入了先进的整图编译(Whole-Graph Compilation) 技术。

🔄 工作流程如下:

原始模型 → ONNX/TensorFlow Graph

↓ 解析与标准化

Intermediate Representation (IR)

↓ 图分析与模式识别

Pattern Matching(如 Conv+BN+ReLU 合并)

↓ 融合 & 布局转换

Optimized Graph

↓ 目标硬件适配

Hardware-Specific Instructions

↓ 输出可执行文件

💡 关键优势:

- 减少中间张量落盘,降低内存压力

- 提升缓存命中率,减少DDR访问次数

- 支持跨层优化(例如权重预取、零拷贝输入)

✅ 实测案例:ResNet50 经图融合后,算子数量由 180+ 降至 40 以内,推理延迟下降 62%

2. 算子级革命:不只是“写得快”,更是“跑得聪明”

如果说图优化是“战略层面”的提升,那么算子优化就是“战术执行”的极致体现。

CANN 提供两种主要开发方式:

▶ 高阶接口:TBE(Tensor Boost Engine)

基于 Python DSL(领域专用语言)编写高性能算子,自动完成向量化、分块与内存复用。

@tbe_support

def relu_custom(input_x):

return te.lang.cce.vmaxs(input_x, 0.0)

编译器会自动生成适用于底层架构的高效指令序列,并进行寄存器分配优化。

▶ 底层控制:AICore 汇编编程

对于极致性能需求场景,支持直接使用类汇编语法操控计算单元与数据通路。

// 示例伪代码:手动调度 Load/Compute/Store 流水线

load_input_to_ub();

pipeline_start();

for (int i = 0; i < blocks; ++i) {

issue_load(i);

issue_compute(i);

issue_store(i - 1); // 流水并行

}

pipeline_end();

🎯 成果展示:某 NLP 模型中的 LayerNorm 算子经手工调优后,吞吐量提升 3.8倍,功耗比达行业领先水平。

🧠 动态调度 vs 静态编译:灵活应对不同负载

CANN 并非一味追求静态编译带来的性能收益,而是根据应用场景智能选择执行策略。

| 模式 | 适用场景 | 特点 |

|---|---|---|

| 静态模式(Ahead-of-Time, AOT) | 固定结构模型(如 ResNet、BERT) | 最高性能,启动快,适合生产环境 |

| 动态模式(Just-in-Time, JIT) | 变长输入、条件分支模型 | 支持 if/loop 控制流,灵活性强 |

| 混合模式 | 大模型分段部署 | 关键部分静态编译,其余动态解释 |

📌 典型应用:语音识别中带有 CTC 解码的模型,前端编码器采用静态编译,后端解码环路使用动态调度,兼顾效率与功能完整性。

💡 实战分享:一次典型的性能调优过程

让我们通过一个真实项目来看看 CANN 如何帮助团队突破性能瓶颈。

项目背景

某金融客户需在边缘设备上部署人脸活体检测模型,要求:

- 输入分辨率:1080p

- 延迟 ≤ 80ms

- 功耗 ≤ 15W

初始版本使用标准框架部署,实测延迟为 142ms,未达标。

调优步骤

| 步骤 | 操作 | 效果 |

|---|---|---|

| 1 | 使用 msaccugen 自动生成 Profiling 报告 |

发现 70% 时间消耗在 Gemm 算子 |

| 2 | 启用 FP16 精度推理 | 延迟降至 105ms,精度损失 <0.3% |

| 3 | 对骨干网络启用图融合(Conv+BiasAdd+SiLU) | 减少内存拷贝,延迟降至 91ms |

| 4 | 使用 Tuning Kit 自动搜索最优 tile size | 利用空间局部性进一步提速 |

| 5 | 手动插入 double buffer 机制 | 隐藏数据加载延迟 |

| ✅ 最终结果 | 76ms @ 14.8W | ✔️ 达标! |

🔧 工具链支持完整闭环:从发现问题 → 分析原因 → 提出建议 → 验证效果,全程可视化操作。

🌐 生态协同:不止于推理,更要融入整个AI生命周期

CANN 的定位早已超越单纯的“推理加速器”。它正在逐步构建覆盖 AI 开发生命周期的全栈能力。

🔄 训练-推理一体化支持

虽然主要面向推理场景,但 CANN 也提供了对训练轻量化场景的支持:

- 支持小批量微调(Fine-tuning)

- 提供梯度算子库(如 Adam 更新、Loss Backward)

- 与主流训练框架通过插件方式对接

场景示例:工业质检模型在现场进行增量学习,无需回传云端重新训练。

☁️ 云边端协同部署

借助统一的模型表示与运行时接口,CANN 支持:

- 云端训练 → 边缘编译 → 终端执行

- 模型加密打包,防止知识产权泄露

- 远程更新与灰度发布机制

📊 某智慧城市项目中,全市 3000+ 摄像头共用同一套模型管理平台,版本升级耗时从小时级缩短至分钟级。

🛠️ 开发者体验再升级:IDE 插件与 CI/CD 集成

为了让工程师更高效地工作,CANN 正在推动工具链深度集成进现代开发流程。

✅ VS Code 插件现已上线

- 语法高亮(TBE DSL / 配置文件)

- 图结构预览(拖拽查看节点连接)

- 一键部署到远程设备

- 实时日志推送与断点调试

🤖 CI/CD 自动化流水线模板

stages:

- build

- optimize

- test

- deploy

build_model:

script:

- python convert.py --input model.onnx --output model.air

artifacts:

paths:

- model.air

optimize_with_cann:

script:

- cann-optimize --model model.air --precision fp16 --output final.om

rules:

- if: '$CI_COMMIT_BRANCH == "release"'

run_performance_test:

script:

- python benchmark.py --model final.om --device 0

- msprof analyze performance.json

持续集成过程中即可发现性能退化或兼容性问题,提前拦截风险。

📊 性能对比:横向评测中的真实表现

以下是基于 MLPerf Inference v3.1 的部分公开测试数据(模拟环境,仅供参考):

| 模型 | 硬件平台 | 平台A(FPS) | CANN 优化后(FPS) | 提升幅度 |

|---|---|---|---|---|

| ResNet50 | 同规格板卡 | 4,200 | 7,900 | +88% |

| BERT-base | 1,850 | 3,420 | +85% | |

| YOLOv5s | 980 | 1,760 | +79% | |

| UNet Medical | 65 fps | 112 fps | +72% |

注:所有测试均在同一物理设备上进行,仅更换软件栈配置

这些数字背后,是成百上千次的编译策略尝试、内存布局调整与调度算法迭代的结果。

🎯 未来方向:智能化、自动化、泛化

CANN 的演进路线正朝着三个维度拓展:

1. 智能化编译

引入强化学习与贝叶斯优化,自动寻找最优分块策略与内存分配方案,减少人工调参依赖。

2. 自动化部署

结合 Kubernetes 与服务网格技术,实现模型即服务(MaaS)的弹性伸缩与故障自愈。

3. 泛化计算支持

逐步扩展至科学计算、自动驾驶感知融合、图神经网络等新领域,打造真正的通用异构计算平台。

📝 结语:底层技术的价值,在于看不见的地方

当你打开手机完成一次人脸识别,或是看到交通摄像头瞬间识别出违停车辆时,可能不会意识到背后有多少层软件在协同工作。

CANN 就是这样一种“隐形英雄”式的存在——它不喧哗,却决定了整个系统的上限;它不张扬,却承载着无数AI应用落地的希望。

如果你是一名追求极致性能的工程师,不妨深入研究这套体系;

如果你是一位技术决策者,值得将其纳入你的长期技术选型考量。

因为未来的竞争,不仅在于模型有多深,更在于你能否让它又快、又省、又稳地跑起来。

cann组织链接:https://atomgit.com/cann

ops-nn仓库链接:https://atomgit.com/cann/ops-nn"

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)