Serverless架构下的AI原生应用云端推理实践

我们的目的是深入探索在Serverless架构这个神奇世界里,如何让AI原生应用在云端进行推理工作。范围涵盖了从核心概念的理解,到具体算法的实现,再到实际项目的操作,最后到应用场景和未来趋势的探讨。就好像我们要开启一场冒险之旅,从起点到终点,把沿途的风景都看个遍。接下来我们会按照一定的顺序来展开这场冒险。先讲讲核心概念,就像认识冒险中的各种角色;然后了解核心算法原理和操作步骤,这就好比学习冒险中的

Serverless架构下的AI原生应用云端推理实践

关键词:Serverless架构、AI原生应用、云端推理、实践、成本效益

摘要:本文聚焦于Serverless架构下的AI原生应用云端推理实践。首先介绍了相关背景,包括Serverless架构和AI原生应用的基本概念。接着详细解释了核心概念及它们之间的关系,阐述了核心算法原理和具体操作步骤,通过数学模型和公式加深理解。还给出了项目实战案例,包括开发环境搭建、代码实现与解读。之后探讨了实际应用场景、工具和资源推荐,分析了未来发展趋势与挑战。最后进行总结,提出思考题,并提供常见问题解答和扩展阅读资料,帮助读者全面了解和掌握Serverless架构下AI原生应用云端推理的相关知识和实践方法。

背景介绍

目的和范围

我们的目的是深入探索在Serverless架构这个神奇世界里,如何让AI原生应用在云端进行推理工作。范围涵盖了从核心概念的理解,到具体算法的实现,再到实际项目的操作,最后到应用场景和未来趋势的探讨。就好像我们要开启一场冒险之旅,从起点到终点,把沿途的风景都看个遍。

预期读者

这篇文章适合那些对新技术充满好奇,想要了解Serverless架构和AI原生应用云端推理的小伙伴。不管你是刚刚接触编程的新手,还是有一定经验的开发者,都能从这里找到有用的知识。就像一场有趣的派对,欢迎所有对这个领域感兴趣的人来参加。

文档结构概述

接下来我们会按照一定的顺序来展开这场冒险。先讲讲核心概念,就像认识冒险中的各种角色;然后了解核心算法原理和操作步骤,这就好比学习冒险中的技能;再通过项目实战来检验我们的学习成果;接着看看实际应用场景,了解这些知识在现实生活中的用处;之后推荐一些工具和资源,帮助我们更好地进行探索;分析未来发展趋势与挑战,看看前方的道路会有什么变化;最后进行总结,提出一些思考题让大家进一步思考。

术语表

核心术语定义

- Serverless架构:这就像是一个神奇的魔法餐厅,你不需要自己准备厨房、餐具和厨师,只需要告诉餐厅你想要吃什么,餐厅就会帮你做好并端到你面前。在技术世界里,你不需要管理服务器,只需要专注于自己的代码和业务逻辑,云服务商会帮你处理服务器的事情。

- AI原生应用:可以把它想象成是一群聪明的小精灵,它们天生就会运用AI的能力来完成各种任务,比如识别图片、理解语音等。这些应用从设计之初就充分利用了AI技术。

- 云端推理:就好比是在云端有一个超级大脑,你把一些问题或者数据发送给它,它经过思考和计算后,把答案返回给你。在AI领域,就是把数据上传到云端,让云端的模型进行计算和判断,得出结果。

相关概念解释

- 容器:可以把容器想象成一个个小盒子,每个盒子里装着一个应用和它所需要的所有东西,比如软件、库等。这些盒子可以很方便地在不同的环境中移动和运行。

- 函数计算:这就像是一个魔法咒语,你念出这个咒语(调用函数),就会触发一系列的操作,完成特定的任务。在Serverless架构中,函数计算是一种常见的计算方式。

缩略词列表

- AWS Lambda:亚马逊云提供的一种函数计算服务,就像是亚马逊云这个大商场里的一个魔法工坊。

- Azure Functions:微软Azure云提供的函数计算服务,类似于微软云世界里的魔法工作室。

核心概念与联系

故事引入

从前有一个小镇,小镇上的居民们需要解决各种各样的问题。但是他们没有足够的资源和能力来自己解决这些问题。于是,有一个聪明的商人在小镇旁边建了一个超级智慧中心。这个智慧中心就像是云端,里面有很多聪明的智者(AI模型)。居民们只需要把自己的问题写在纸条上(数据),然后送到智慧中心,智者们就会根据自己的知识和经验(算法)给出答案。而且,居民们不需要自己建造智慧中心,也不需要雇佣智者,只需要为自己得到的答案付费就可以了。这就像是Serverless架构下的AI原生应用云端推理,居民们不需要管理服务器,只需要使用服务就可以了。

核心概念解释(像给小学生讲故事一样)

** 核心概念一:Serverless架构**

Serverless架构就像是一个神奇的共享厨房。想象一下,你想开一家餐厅,但是你不想自己买厨房设备、雇厨师和服务员。这时候,有一个共享厨房出现了,它里面有各种各样的厨房设备,还有专业的厨师和服务员。你只需要告诉他们你要做什么菜,他们就会帮你做好,然后把菜送到顾客面前。你只需要为你做的菜和使用的服务付费就可以了。在技术世界里,Serverless架构就是这样,你不需要管理服务器,云服务商会帮你处理服务器的事情,你只需要专注于自己的代码和业务逻辑。

** 核心概念二:AI原生应用**

AI原生应用就像是一群聪明的小机器人。这些小机器人从出生开始就被训练得非常聪明,它们可以做很多事情,比如认识图片里的东西、听懂你说的话、和你聊天等。它们的大脑里装着很多知识和技能(AI模型),可以根据你给它们的信息做出判断和决策。就像小朋友们在学校里学习了很多知识,然后可以用这些知识解决生活中的问题一样。

** 核心概念三:云端推理**

云端推理就像是在云端有一个超级大脑。你可以把一些问题或者数据发送到这个超级大脑里,它会根据自己的知识和经验(AI模型)进行思考和计算,然后把答案返回给你。比如说,你给它一张动物的图片,它会告诉你这是一只猫还是一只狗。这个超级大脑非常强大,它可以同时处理很多人的问题,而且计算速度非常快。

核心概念之间的关系(用小学生能理解的比喻)

** 概念一和概念二的关系**

Serverless架构和AI原生应用就像是一对好朋友。Serverless架构就像是一个贴心的管家,它可以帮助AI原生应用解决很多麻烦的事情,比如服务器的管理和维护。而AI原生应用就像是一个有才华的艺术家,它可以利用Serverless架构提供的服务,专注于发挥自己的才能,为用户提供更好的服务。就像管家帮助艺术家处理生活中的琐事,让艺术家可以专心创作一样。

** 概念二和概念三的关系**

AI原生应用和云端推理就像是一个团队。AI原生应用是团队里的前锋,它负责和用户打交道,收集用户的信息和需求。而云端推理是团队里的智囊团,它负责根据AI原生应用收集到的信息进行思考和计算,给出答案。它们一起合作,为用户提供准确、快速的服务。就像前锋把球传给智囊团,智囊团再把球踢进对方的球门一样。

** 概念一和概念三的关系**

Serverless架构和云端推理就像是一个舞台和演员。Serverless架构是舞台,它为云端推理提供了一个稳定、可靠的表演环境。而云端推理是演员,它在Serverless架构这个舞台上展示自己的才华,为用户提供服务。没有舞台,演员就无法表演;没有演员,舞台也会变得空荡荡的。它们相互配合,才能创造出精彩的表演。

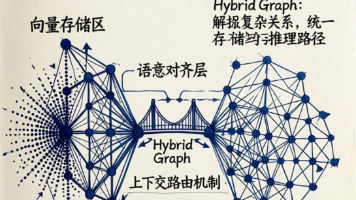

核心概念原理和架构的文本示意图(专业定义)

在Serverless架构下的AI原生应用云端推理系统中,主要包括以下几个部分:

- 用户端:这是用户与系统交互的地方,用户可以通过各种设备(如手机、电脑等)上传数据(如图像、文本等)。

- Serverless平台:提供计算资源和服务管理,负责接收用户的请求,分配资源,并调用相应的AI模型进行推理。

- AI模型仓库:存储各种预训练好的AI模型,这些模型可以根据不同的任务进行选择和使用。

- 推理引擎:负责执行AI模型的推理任务,对用户上传的数据进行处理和分析。

- 结果返回:将推理得到的结果返回给用户端。

Mermaid 流程图

核心算法原理 & 具体操作步骤

在Serverless架构下进行AI原生应用云端推理,常用的算法有深度学习算法,比如卷积神经网络(CNN)用于图像识别,循环神经网络(RNN)及其变体(如LSTM、GRU)用于自然语言处理等。下面以Python为例,使用TensorFlow框架,实现一个简单的图像分类推理任务。

核心算法原理

卷积神经网络(CNN)是一种专门用于处理具有网格结构数据(如图像)的深度学习模型。它通过卷积层、池化层和全连接层等组件,自动提取图像的特征,并进行分类。

具体操作步骤

1. 安装必要的库

!pip install tensorflow

2. 加载预训练模型

import tensorflow as tf

from tensorflow.keras.applications.resnet50 import ResNet50

from tensorflow.keras.preprocessing import image

from tensorflow.keras.applications.resnet50 import preprocess_input, decode_predictions

import numpy as np

# 加载预训练的ResNet50模型

model = ResNet50(weights='imagenet')

3. 准备图像数据

# 加载图像并调整大小

img_path = 'your_image.jpg'

img = image.load_img(img_path, target_size=(224, 224))

# 将图像转换为数组

x = image.img_to_array(img)

# 添加一个维度,因为模型期望的输入是一个批次

x = np.expand_dims(x, axis=0)

# 对图像进行预处理

x = preprocess_input(x)

4. 进行推理

# 进行推理

predictions = model.predict(x)

# 解码预测结果

decoded_predictions = decode_predictions(predictions, top=3)[0]

# 输出预测结果

for i, (imagenet_id, label, score) in enumerate(decoded_predictions):

print(f"{i + 1}. {label}: {score * 100:.2f}%")

数学模型和公式 & 详细讲解 & 举例说明

卷积操作

卷积操作是CNN中的核心操作,它可以提取图像的特征。假设输入图像为 XXX,卷积核为 WWW,卷积操作的输出 YYY 可以表示为:

Yi,j=∑m=0M−1∑n=0N−1Xi+m,j+n⋅Wm,nY_{i,j} = \sum_{m=0}^{M-1} \sum_{n=0}^{N-1} X_{i+m,j+n} \cdot W_{m,n}Yi,j=m=0∑M−1n=0∑N−1Xi+m,j+n⋅Wm,n

其中,MMM 和 NNN 是卷积核的大小,iii 和 jjj 是输出特征图的坐标。

例如,假设有一个 3×33\times33×3 的卷积核 WWW:

W=[10−120−210−1]W = \begin{bmatrix} 1 & 0 & -1 \\ 2 & 0 & -2 \\ 1 & 0 & -1 \end{bmatrix}W= 121000−1−2−1

输入图像 XXX 是一个 4×44\times44×4 的矩阵:

X=[12345678910111213141516]X = \begin{bmatrix} 1 & 2 & 3 & 4 \\ 5 & 6 & 7 & 8 \\ 9 & 10 & 11 & 12 \\ 13 & 14 & 15 & 16 \end{bmatrix}X= 15913261014371115481216

当我们在图像上滑动卷积核进行卷积操作时,对于输出特征图的第一个元素 Y0,0Y_{0,0}Y0,0,计算过程如下:

Y0,0=1×1+2×0+3×(−1)+5×2+6×0+7×(−2)+9×1+10×0+11×(−1)=−10Y_{0,0} = 1\times1 + 2\times0 + 3\times(-1) + 5\times2 + 6\times0 + 7\times(-2) + 9\times1 + 10\times0 + 11\times(-1) = -10Y0,0=1×1+2×0+3×(−1)+5×2+6×0+7×(−2)+9×1+10×0+11×(−1)=−10

池化操作

池化操作可以减小特征图的尺寸,同时保留重要的特征信息。常见的池化操作有最大池化和平均池化。以最大池化为例,假设输入特征图为 XXX,池化窗口大小为 2×22\times22×2,步长为 222,则最大池化操作的输出 YYY 可以表示为:

Yi,j=maxm=01maxn=01X2i+m,2j+nY_{i,j} = \max_{m=0}^{1} \max_{n=0}^{1} X_{2i+m,2j+n}Yi,j=m=0max1n=0max1X2i+m,2j+n

例如,对于一个 4×44\times44×4 的输入特征图 XXX:

X=[12345678910111213141516]X = \begin{bmatrix} 1 & 2 & 3 & 4 \\ 5 & 6 & 7 & 8 \\ 9 & 10 & 11 & 12 \\ 13 & 14 & 15 & 16 \end{bmatrix}X= 15913261014371115481216

经过 2×22\times22×2 最大池化后,输出特征图 YYY 为:

Y=[681416]Y = \begin{bmatrix} 6 & 8 \\ 14 & 16 \end{bmatrix}Y=[614816]

项目实战:代码实际案例和详细解释说明

开发环境搭建

1. 选择云服务提供商

可以选择亚马逊云(AWS)、微软Azure云、阿里云等云服务提供商。这里以AWS为例。

2. 创建AWS Lambda函数

登录AWS控制台,进入Lambda服务页面,点击“创建函数”。选择“从头开始创作”,配置函数的基本信息,如函数名称、运行时环境(选择Python 3.x)等。

3. 配置权限

为Lambda函数添加必要的权限,如访问S3存储桶、调用其他AWS服务等。

源代码详细实现和代码解读

1. 实现一个简单的图像分类推理Lambda函数

import tensorflow as tf

from tensorflow.keras.applications.resnet50 import ResNet50

from tensorflow.keras.preprocessing import image

from tensorflow.keras.applications.resnet50 import preprocess_input, decode_predictions

import numpy as np

import boto3

import io

# 加载预训练的ResNet50模型

model = ResNet50(weights='imagenet')

s3 = boto3.client('s3')

def lambda_handler(event, context):

# 从S3存储桶中获取图像

bucket = event['bucket']

key = event['key']

response = s3.get_object(Bucket=bucket, Key=key)

img_content = response['Body'].read()

# 加载图像并调整大小

img = image.load_img(io.BytesIO(img_content), target_size=(224, 224))

# 将图像转换为数组

x = image.img_to_array(img)

# 添加一个维度,因为模型期望的输入是一个批次

x = np.expand_dims(x, axis=0)

# 对图像进行预处理

x = preprocess_input(x)

# 进行推理

predictions = model.predict(x)

# 解码预测结果

decoded_predictions = decode_predictions(predictions, top=3)[0]

# 构建响应结果

results = []

for i, (imagenet_id, label, score) in enumerate(decoded_predictions):

results.append({

"rank": i + 1,

"label": label,

"score": float(score)

})

return {

"statusCode": 200,

"body": results

}

2. 代码解读

- 导入必要的库:导入TensorFlow、Keras相关库用于模型加载和图像处理,导入boto3用于与AWS S3存储桶交互。

- 加载预训练模型:使用

ResNet50加载预训练的ImageNet模型。 lambda_handler函数:这是Lambda函数的入口点,接收event和context两个参数。event包含了从调用者传递过来的信息,如S3存储桶名称和图像键。- 从S3获取图像:使用

boto3客户端从S3存储桶中获取图像内容。 - 图像处理和推理:对图像进行预处理,然后使用模型进行推理,解码预测结果。

- 构建响应结果:将预测结果封装成一个列表,返回给调用者。

代码解读与分析

- 性能优化:可以考虑使用模型量化、剪枝等技术来减小模型的大小,提高推理速度。

- 错误处理:在代码中添加适当的错误处理机制,如捕获S3获取图像失败、模型推理失败等异常情况。

- 安全性:确保Lambda函数的权限配置合理,避免泄露敏感信息。

实际应用场景

智能安防

在智能安防领域,Serverless架构下的AI原生应用云端推理可以用于实时监控和识别。例如,通过摄像头采集视频图像,上传到云端进行人脸识别、车辆识别等任务。一旦发现可疑人员或车辆,系统可以及时发出警报。

医疗影像诊断

在医疗领域,医生可以将患者的X光、CT等影像数据上传到云端,利用AI模型进行疾病诊断和分析。Serverless架构可以根据实际需求动态分配计算资源,提高诊断效率。

智能客服

智能客服系统可以利用自然语言处理技术,对用户的问题进行理解和回答。通过云端推理,智能客服可以不断学习和优化,提供更加准确和个性化的服务。

工具和资源推荐

云服务提供商

- AWS:提供AWS Lambda、SageMaker等服务,支持多种深度学习框架。

- Azure:提供Azure Functions、Azure Machine Learning等服务,与微软的其他产品集成良好。

- 阿里云:提供函数计算、机器学习平台等服务,适合国内用户。

深度学习框架

- TensorFlow:谷歌开发的开源深度学习框架,功能强大,社区活跃。

- PyTorch:Facebook开发的开源深度学习框架,易于使用,适合快速迭代和研究。

模型仓库

- Hugging Face:提供大量预训练的自然语言处理模型,方便开发者使用。

- TensorFlow Hub:提供各种预训练的深度学习模型,可用于图像、文本等任务。

未来发展趋势与挑战

发展趋势

- 融合更多技术:Serverless架构将与边缘计算、物联网等技术深度融合,实现更加高效和智能的应用。

- 模型轻量化:随着硬件资源的限制和对实时性的要求,模型轻量化技术将得到更广泛的应用。

- 自动化推理:未来将出现更多自动化的推理工具和平台,降低开发者的门槛。

挑战

- 性能优化:如何在有限的资源下提高推理性能,是一个需要解决的问题。

- 数据安全和隐私:在云端处理大量敏感数据时,如何保证数据的安全和隐私是一个重要的挑战。

- 成本控制:虽然Serverless架构可以按需计费,但在高并发场景下,成本控制仍然是一个难题。

总结:学到了什么?

核心概念回顾

我们学习了Serverless架构、AI原生应用和云端推理这三个核心概念。Serverless架构就像一个贴心的管家,帮助我们管理服务器;AI原生应用就像聪明的小机器人,拥有强大的AI能力;云端推理就像云端的超级大脑,能快速处理数据并给出答案。

概念关系回顾

我们了解了Serverless架构和AI原生应用是好朋友,Serverless架构为AI原生应用提供支持;AI原生应用和云端推理是团队,它们相互协作完成任务;Serverless架构和云端推理是舞台和演员,相互配合创造精彩表演。

思考题:动动小脑筋

思考题一

你能想到生活中还有哪些地方可以应用Serverless架构下的AI原生应用云端推理吗?

思考题二

如果你要开发一个基于Serverless架构的AI原生应用云端推理系统,你会选择哪个云服务提供商,为什么?

附录:常见问题与解答

问题一:Serverless架构下的AI原生应用云端推理的成本高吗?

答:Serverless架构通常是按需计费的,在低并发场景下成本相对较低。但在高并发场景下,需要合理控制资源使用,否则成本可能会增加。可以通过优化模型、调整资源配置等方式来降低成本。

问题二:如何保证云端推理的安全性?

答:可以采取以下措施保证云端推理的安全性:使用加密技术对数据进行加密传输和存储;对访问权限进行严格管理,只允许授权用户和应用访问;定期进行安全审计和漏洞扫描。

扩展阅读 & 参考资料

- 《深度学习》(Ian Goodfellow等著)

- AWS官方文档:https://docs.aws.amazon.com/

- TensorFlow官方文档:https://www.tensorflow.org/

- Hugging Face官方文档:https://huggingface.co/docs

更多推荐

已为社区贡献261条内容

已为社区贡献261条内容

所有评论(0)