OpenClaw(原ClawdBot/MoltBot)接入国内模型Minimax保姆级安装部署配置教程

本文介绍了在CentOS Stream 9系统上部署OpenClaw AI Bot框架的完整流程。主要内容包括:1) 通过nvm安装Node.js 24.13.0;2) 安装必要的前置依赖;3) 提供两种OpenClaw安装方式(官方脚本和npm安装);4) 详细说明初始化配置向导步骤;5) 配置飞书集成的具体方法,包括创建飞书应用、安装插件和添加渠道。文章还特别提醒了版本兼容性问题,并给出了常见

前言

如果你正在寻找一个能在本地运行、真正能够协助完成工作的AI助手,OpenClaw(之前也叫ClawdBot或MoltBot)值得尝试。作为一个开源的本地优先AI代理与自动化平台,它的核心定位很明确:通过自然语言指令,替代人工完成那些流程化、重复性的工作——简而言之,就是"真正干活的AI"。

今天本文将详细指导在Linux系统上部署和配置OpenClaw。相比那些云端AI助手,OpenClaw的最大优势在于数据完全由你掌控:所有任务数据默认存储在本地设备,不经过第三方服务器,隐私安全更有保障。而且它能通过飞书、钉钉等常用聊天工具直接交互,无需安装专用客户端,使用起来非常方便。

环境说明:我在CentOS Stream 9上完成了这次部署,实际测试过程较为顺利。需要注意的是,OpenClaw要求Node.js版本不低于22,所以如果你还在用CentOS 7这类老系统,可能需要先升级或换个新的发行版。硬件方面,建议至少有2GB内存,建议4GB以上,这样运行性能更佳。

一、安装 Node.js

OpenClaw依赖Node.js运行环境,我们推荐通过nvm(Node Version Manager)来安装和管理Node.js版本。使用nvm的优势在于版本切换方便,不会影响系统其他服务。安装过程相对简单,主要通过nvm管理Node.js版本。打开终端,按照以下步骤操作:

官方文档地址:https://nodejs.org/zh-cn/download

安装步骤

# 下载并安装 nvm

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.40.3/install.sh | bash

# 重新加载 nvm 配置(代替重启 shell)

\. "$HOME/.nvm/nvm.sh"

# 下载并安装 Node.js 24 版本

nvm install 24

# 验证 Node.js 版本

node -v # 应输出 v24.x.x 或更高版本(确保 ≥22)

# 验证 npm 版本

npm -v # 应输出相应版本号

二、安装前置依赖

在安装OpenClaw之前,需要先安装一些必要的编译工具和依赖包,以避免后续安装过程中出现各种常见错误:

# 安装 Git、Cmake、GCC、C++ 和 Make

dnf install -y git cmake gcc-c++ make

注意:上述命令适用于基于RHEL的系统(如CentOS、Fedora)。如果你使用的是Ubuntu或Debian,请将

dnf替换为apt:apt update && apt install -y git cmake gcc g++ make。

官方建议:如果你计划从源代码构建OpenClaw,可以安装pnpm(推荐但不是必须的)。另外,为了获得更好的网页搜索体验,建议获取Brave Search API密钥,可以通过openclaw configure --section web命令配置。

三、安装 OpenClaw

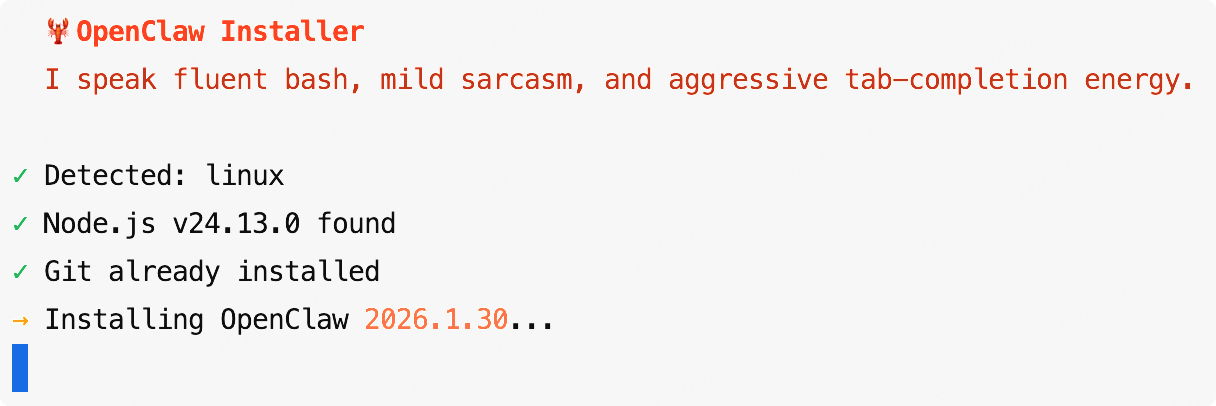

OpenClaw提供了多种安装方式,你可以选择最适合你的一种。官方推荐使用安装脚本,但如果网络环境不好,也可以直接用npm安装。

方式一:使用官方安装脚本(推荐)

curl -fsSL https://openclaw.ai/install.sh | bash

需要注意的是:如果脚本卡住不动,大概率是网络问题。无需长时间等待,直接换npm安装方式就行,下文将详细说明。

通过

curl方式安装成功后自动进入初始化配置界面,不需要再输入下方openclaw onboard指令了。

Windows用户注意:如果你在Windows上部署,可以使用PowerShell安装脚本:

iwr -useb https://openclaw.ai/install.ps1 | iex

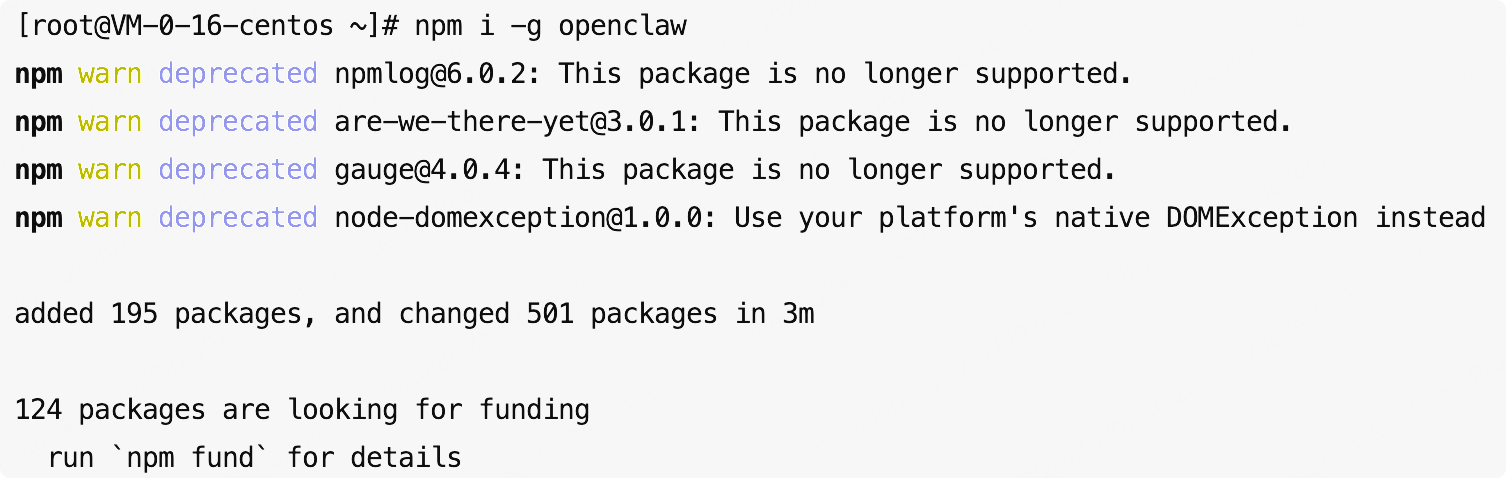

方式二:使用 npm 全局安装

npm i -g openclaw

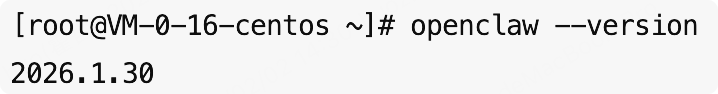

安装完成后,可以验证是否安装成功:

openclaw --version

如使用npm安装时出现任何问题,请按照步骤二安装必要的前置依赖。

四、初始化 OpenClaw 配置

安装完成后,运行以下命令进入配置向导:

openclaw onboard

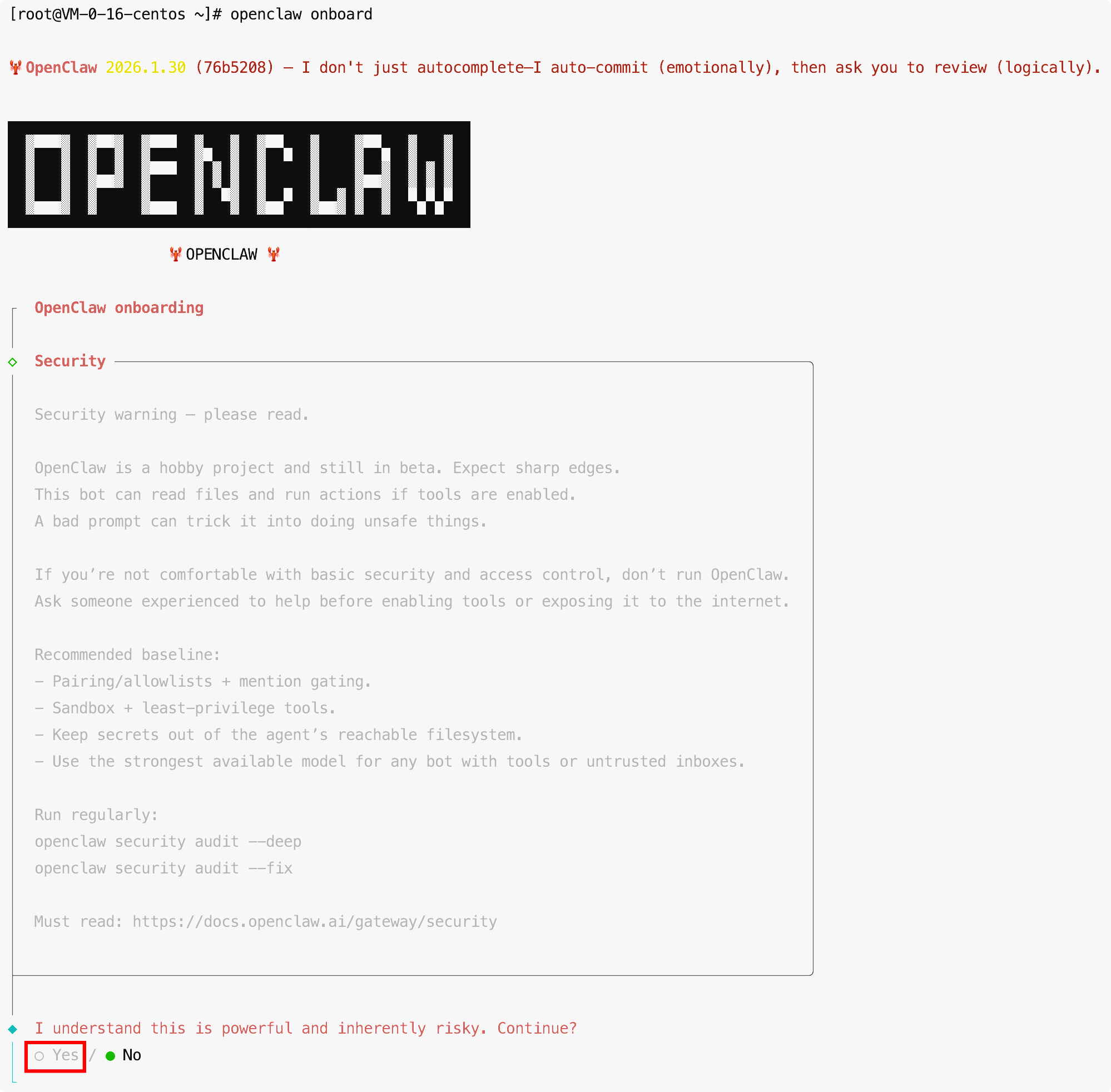

-

使用键盘方向键选择Yes同意风险说明。

-

选择安装方式,这里我们选择“QuicStart”快速入门

-

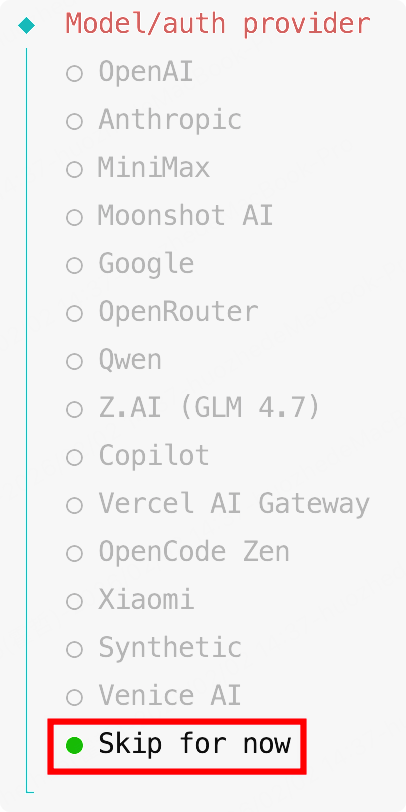

模型选择这部分由于OpenClaw默认提供的都是国际版模型,我们待会配置完需要改用国内大模型,就先暂时跳过这步骤,选择"Skip for now"跳过

-

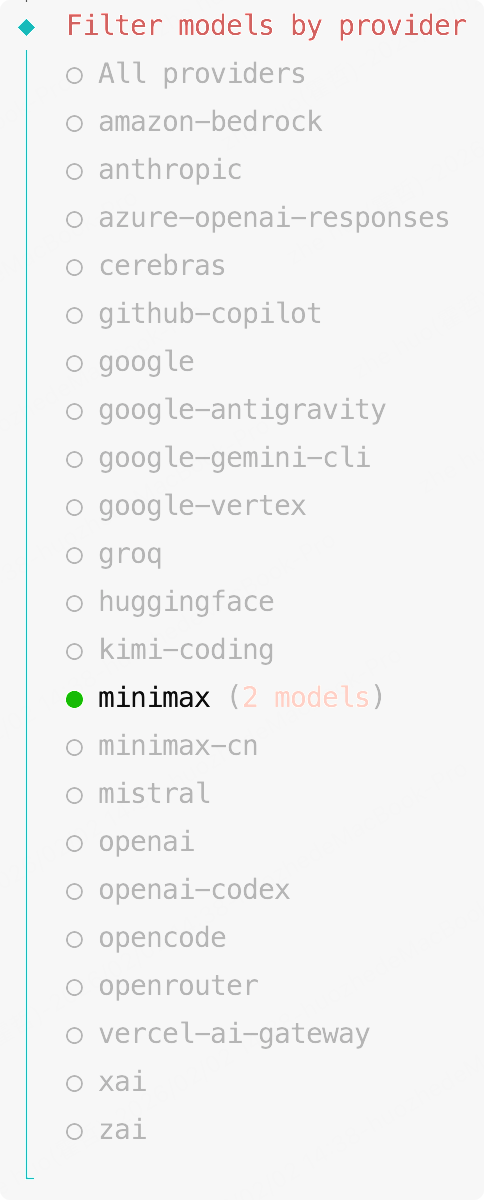

选择模型供应商,这边随便选,反正待会也会重新配置国内模型,这里我先随便选成minimax了

-

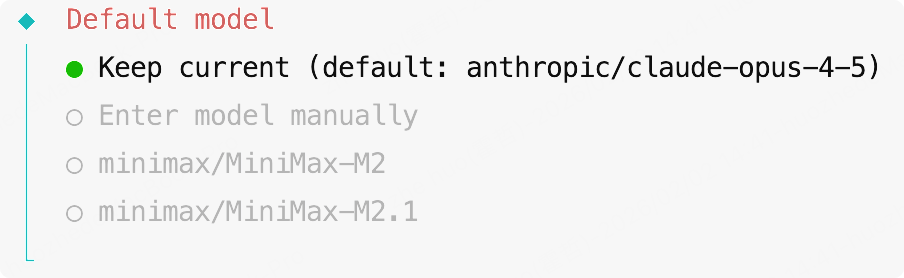

同理这一步也随便选,直接回车

-

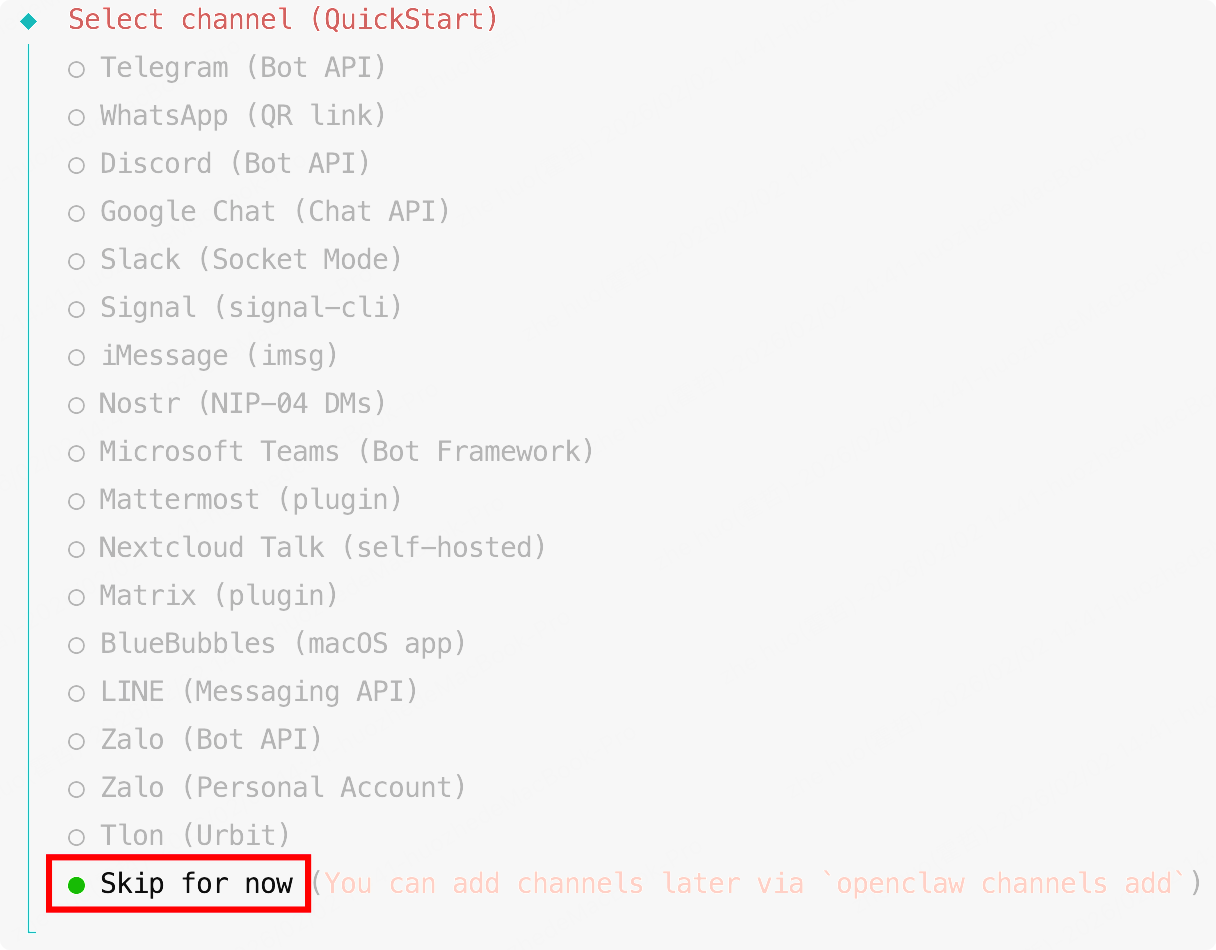

选择聊天工具,目前OpenClaw提供的聊天工具基本都是国际软件,在国内很难使用,待会我们会配置飞书聊天工具,所以这里先选择"Skip for now"跳过

-

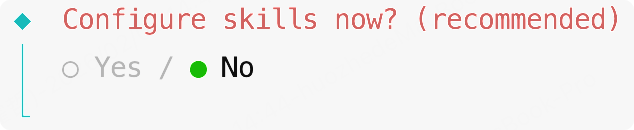

安装技能,首次安装就不要安装技能了,先将OpenClaw安装完毕,之后再安装技能,选择"No"

-

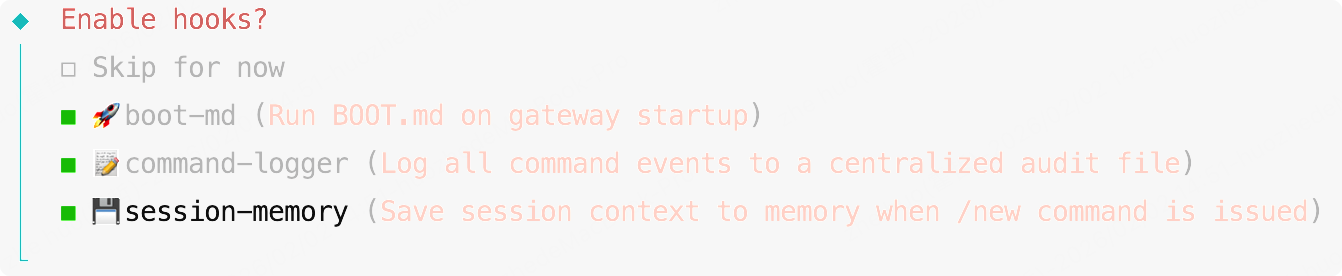

是否启用钩子(hooks),建议是将这三个全部打开,通过空格键勾选,回车键确定

功能说明:- boot-md:能在OpenClaw启动时自动执行BOOT.md里的任务,实现自动化工作流

- command-logger:把所有操作都记下来方便排查问题,便于后期调试

- session-memory:在切换会话时保存上下文,避免信息丢失,确保对话连续性

-

提示如下信息稍等一会。

-

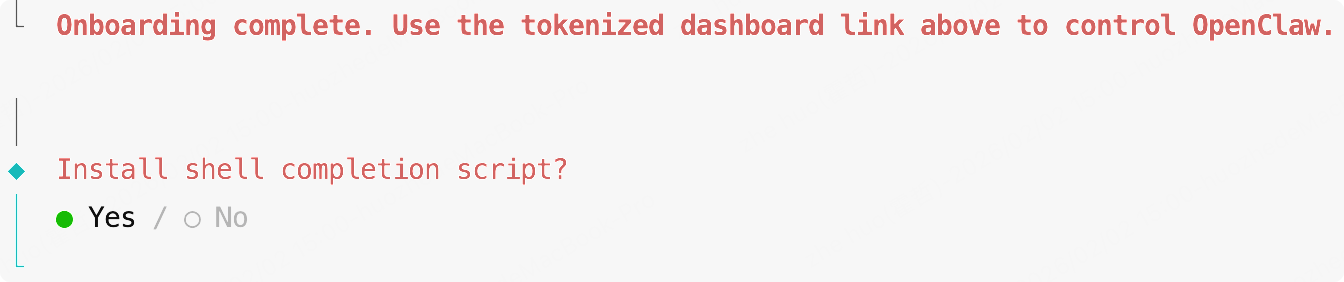

安装shell补全脚本,这里安装和不安装都可以,建议是安装,主要用处就是在你使用OpenClaw CLI时可以按Tab来帮你自动补全一些信息。

到此OpenClaw的基础配置就结束了,接下来是设置飞书聊天集成。

五、配置飞书集成

OpenClaw支持多种平台接入,这也是它的一大亮点——无需专用客户端,通过现有聊天工具就能操作。国内用户用飞书比较多,所以本文以飞书为例进行说明。

5.1 获取飞书应用凭证

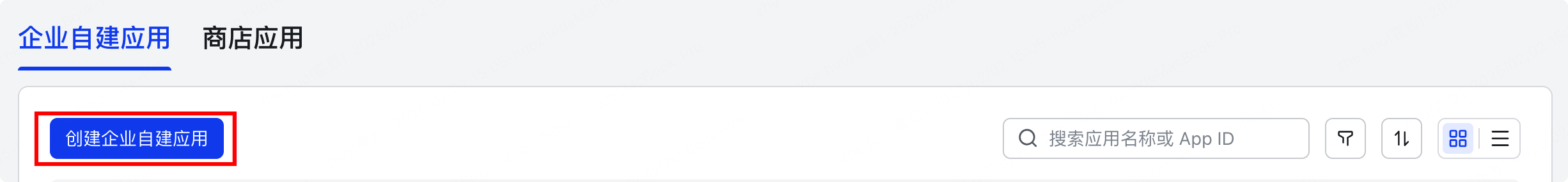

首先需要在飞书开放平台创建应用并获取必要的凭证:

- 访问飞书开放平台-开发者后台:https://open.feishu.cn/app

- 创建企业自建应用

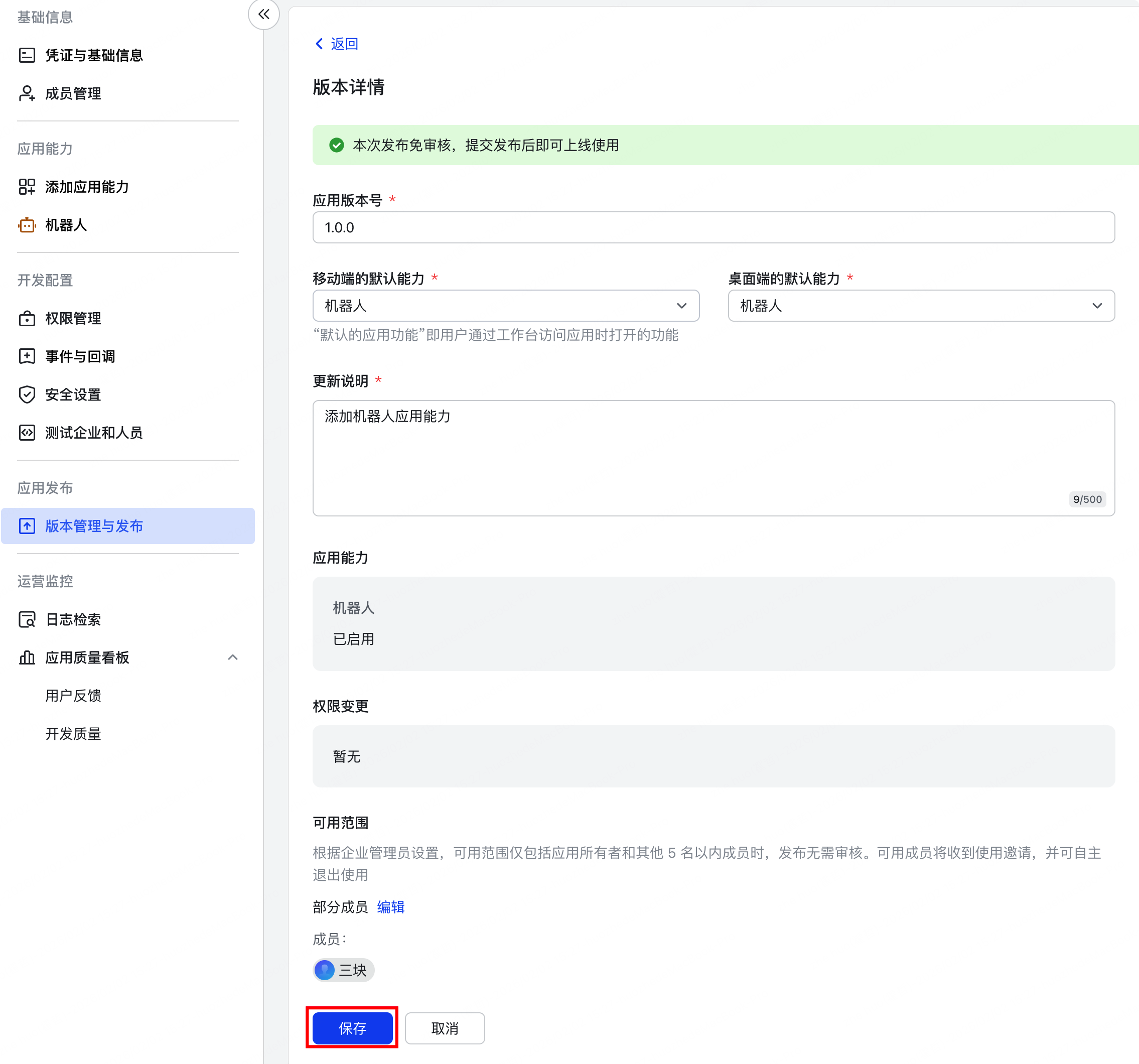

- 添加机器人应用能力

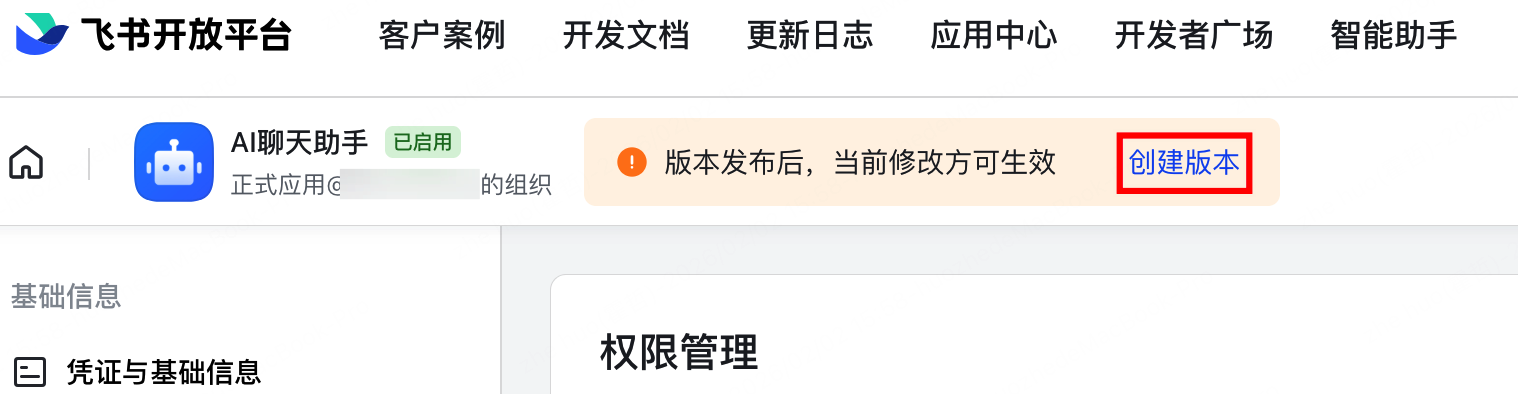

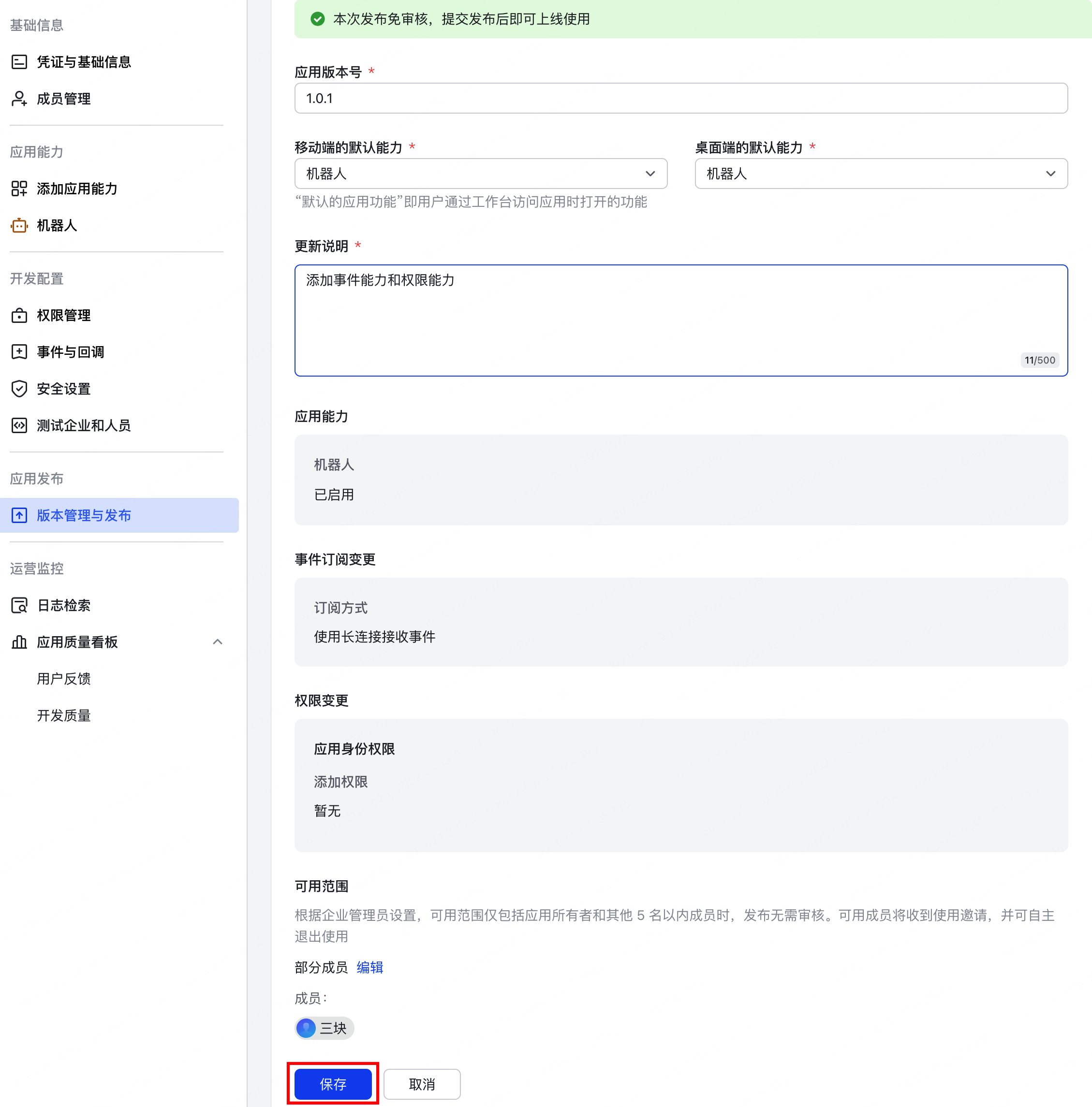

- 发布应用版本

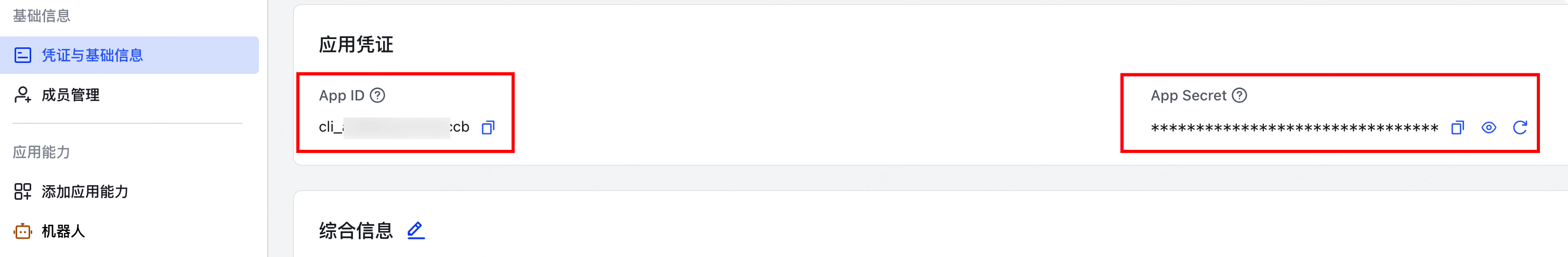

- 获取 App ID 和 App Secret

5.2 安装飞书插件

在OpenClaw中安装飞书官方插件:

openclaw plugins install @m1heng-clawd/feishu

![[在此处插入插件安装过程截图]](https://i-blog.csdnimg.cn/direct/130304e284344dc39d2af20892aa947e.png)

如果提示npm install failed安装失败,就删除安装目录后再次执行命令安装。

# 删除安装失败目录

rm -rf /root/.openclaw/extensions/feishu

# 再次进行安装

openclaw plugins install @m1heng-clawd/feishu

5.3 配置飞书渠道

安装插件后,需要添加飞书渠道配置:

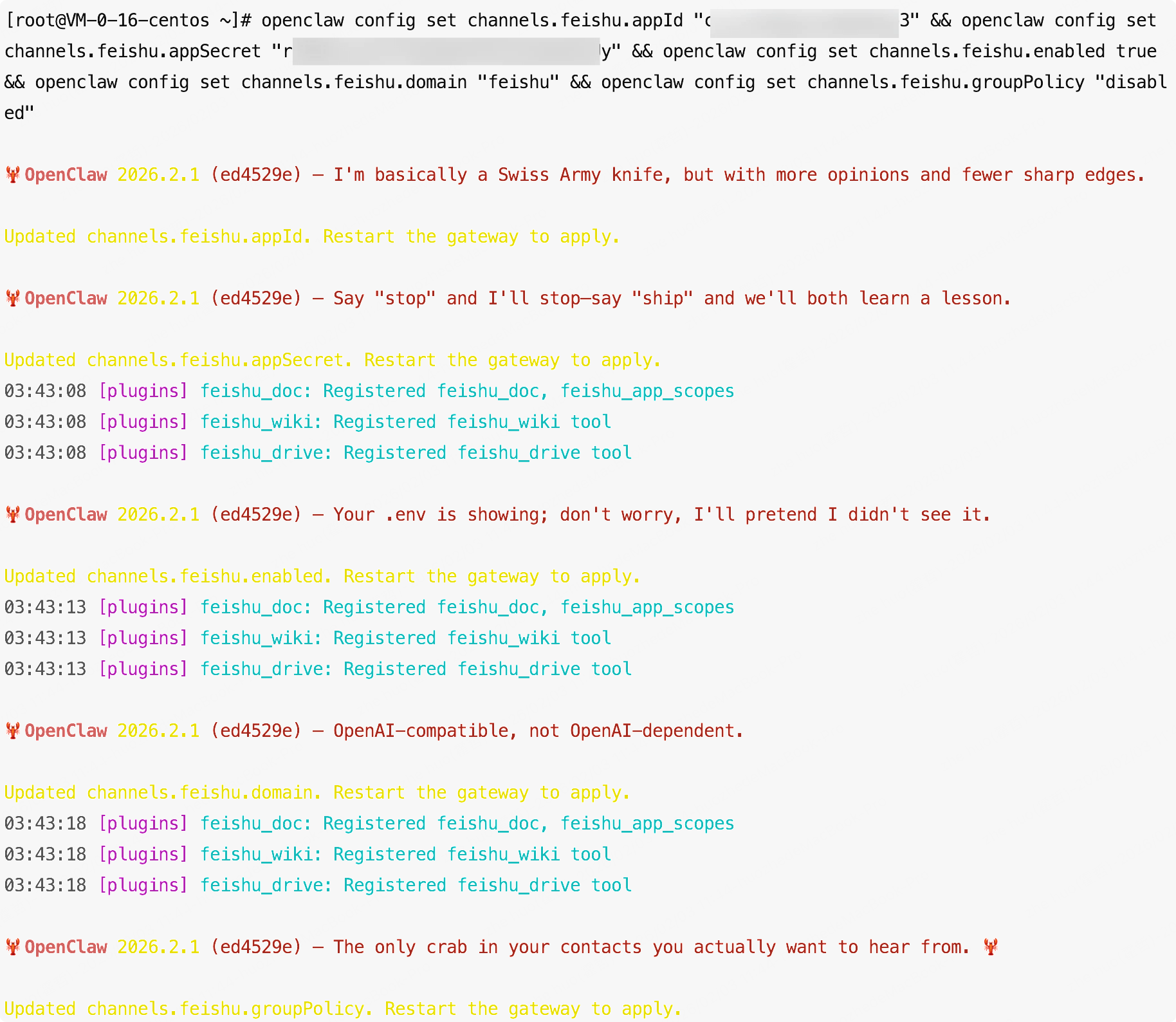

方式一:使用shell命令配置(快速配置)

修改脚本中的AppId和AppSecret后直接执行以下命令,配置效果与方式二一样。

openclaw config set channels.feishu.appId "这里填AppId" && openclaw config set channels.feishu.appSecret "这里填AppSecret" && openclaw config set channels.feishu.enabled true && openclaw config set channels.feishu.domain "feishu" && openclaw config set channels.feishu.groupPolicy "disabled"

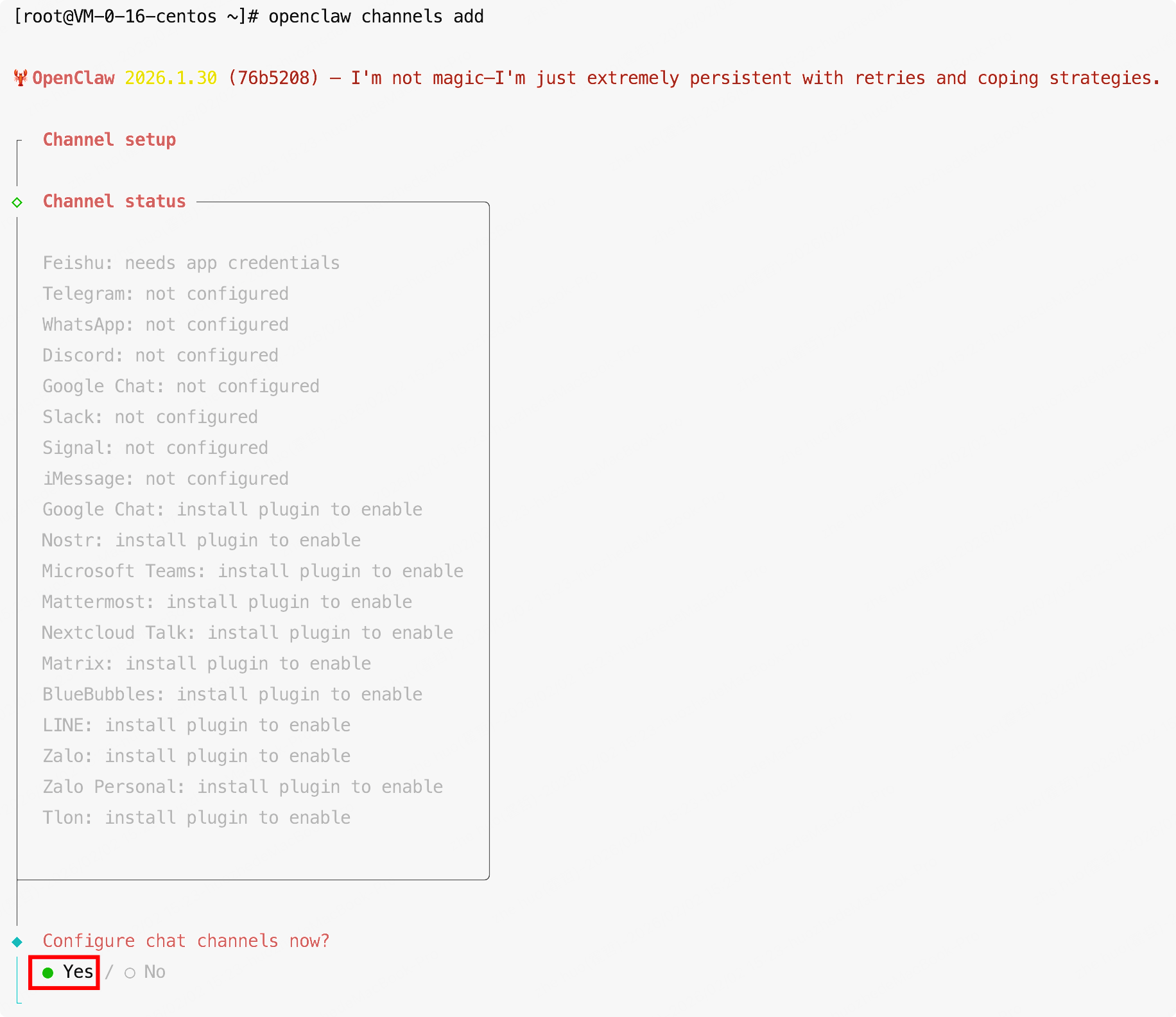

方式二:通过配置界面按步骤配置

openclaw channels add

-

添加渠道配置,勾选"Yes"

-

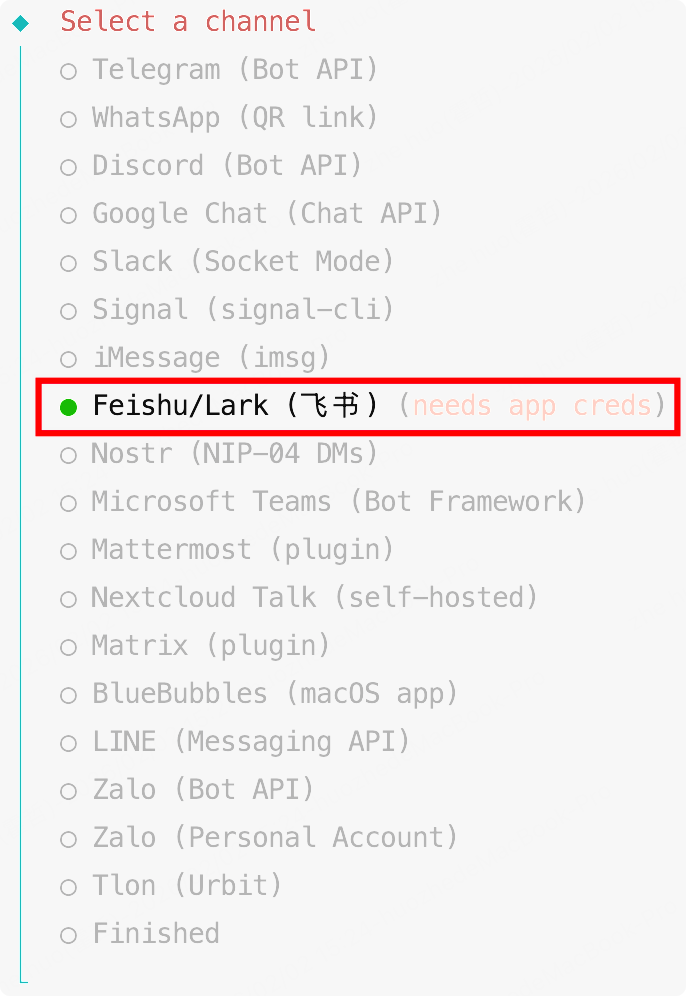

选择飞书渠道

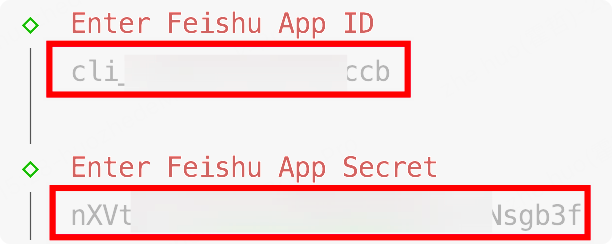

- 按照提示输入你在飞书开放平台获取的 App ID 和 App Secret。

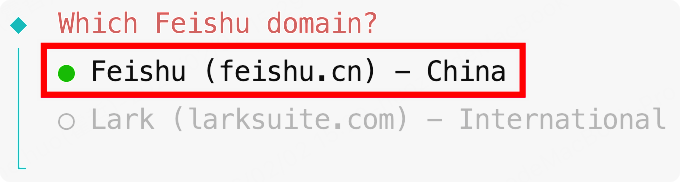

- 选择国内飞书

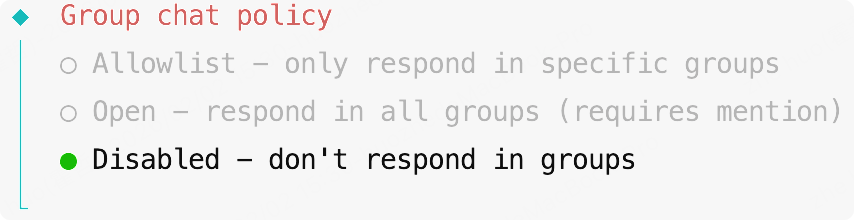

- 选择响应策略,这边根据具体场景选择,我就先选择Disabled

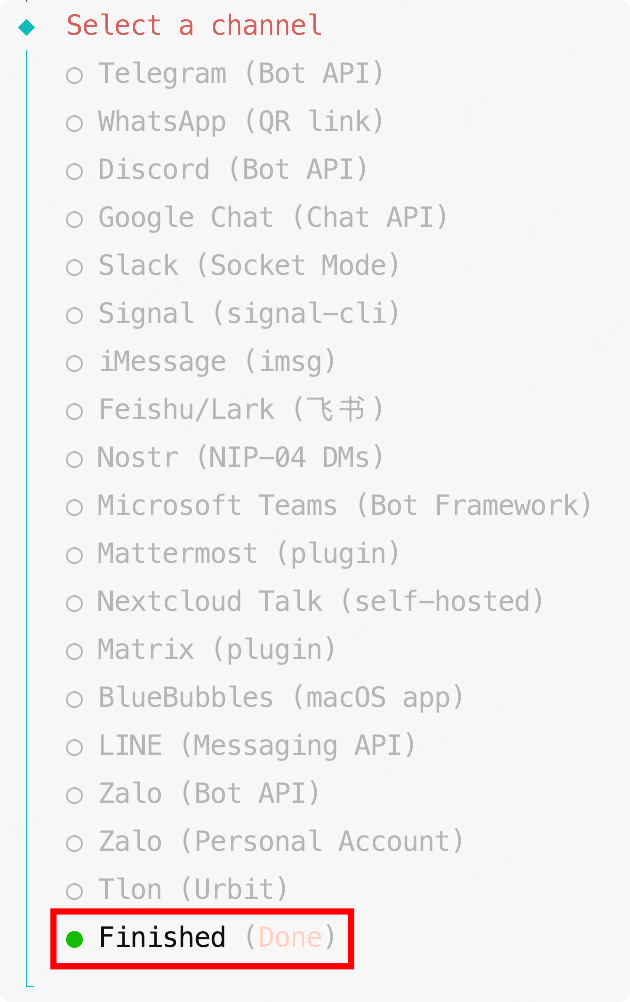

- 结束渠道配置

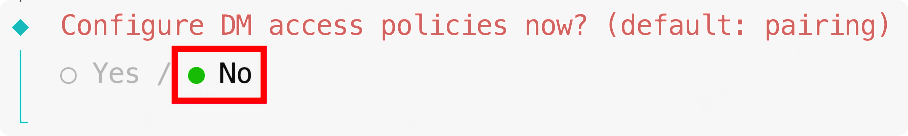

- 访问策略选择"No"

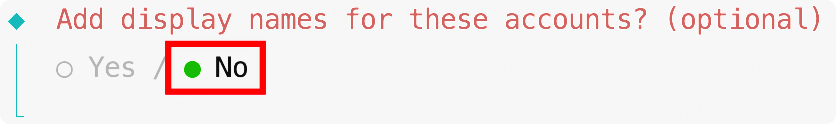

- 添加显示名称可选配置我们也选择"No"

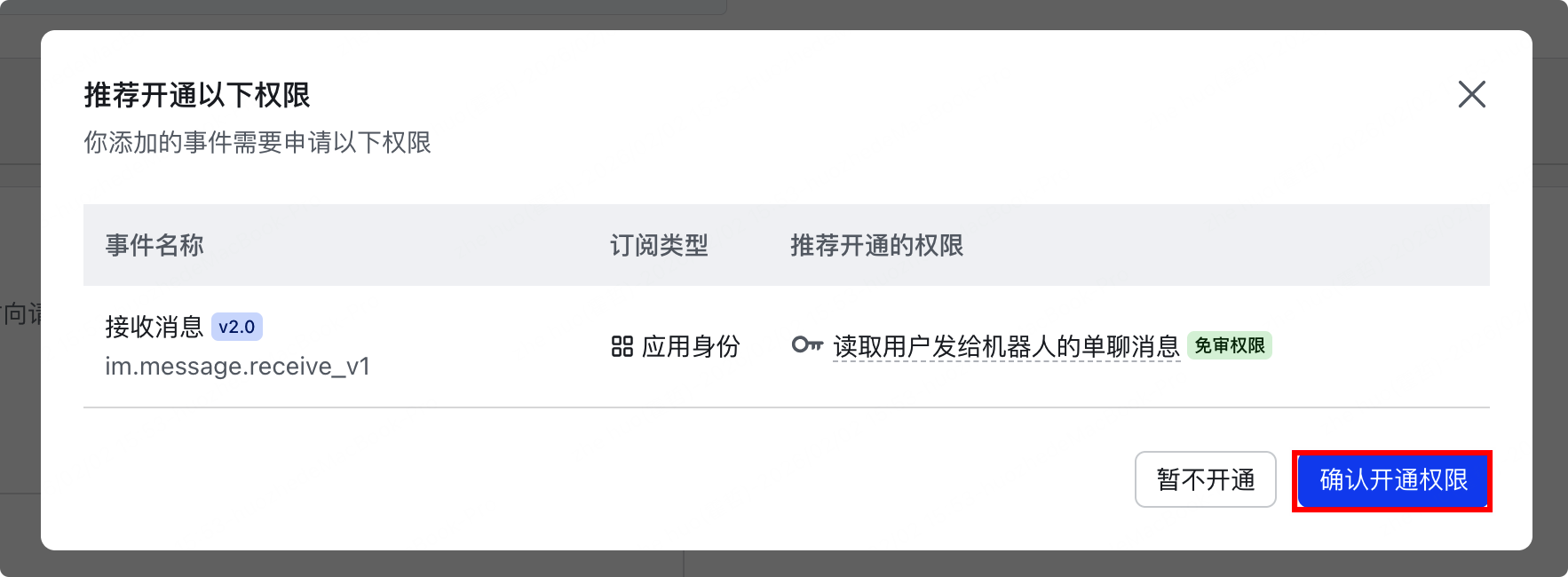

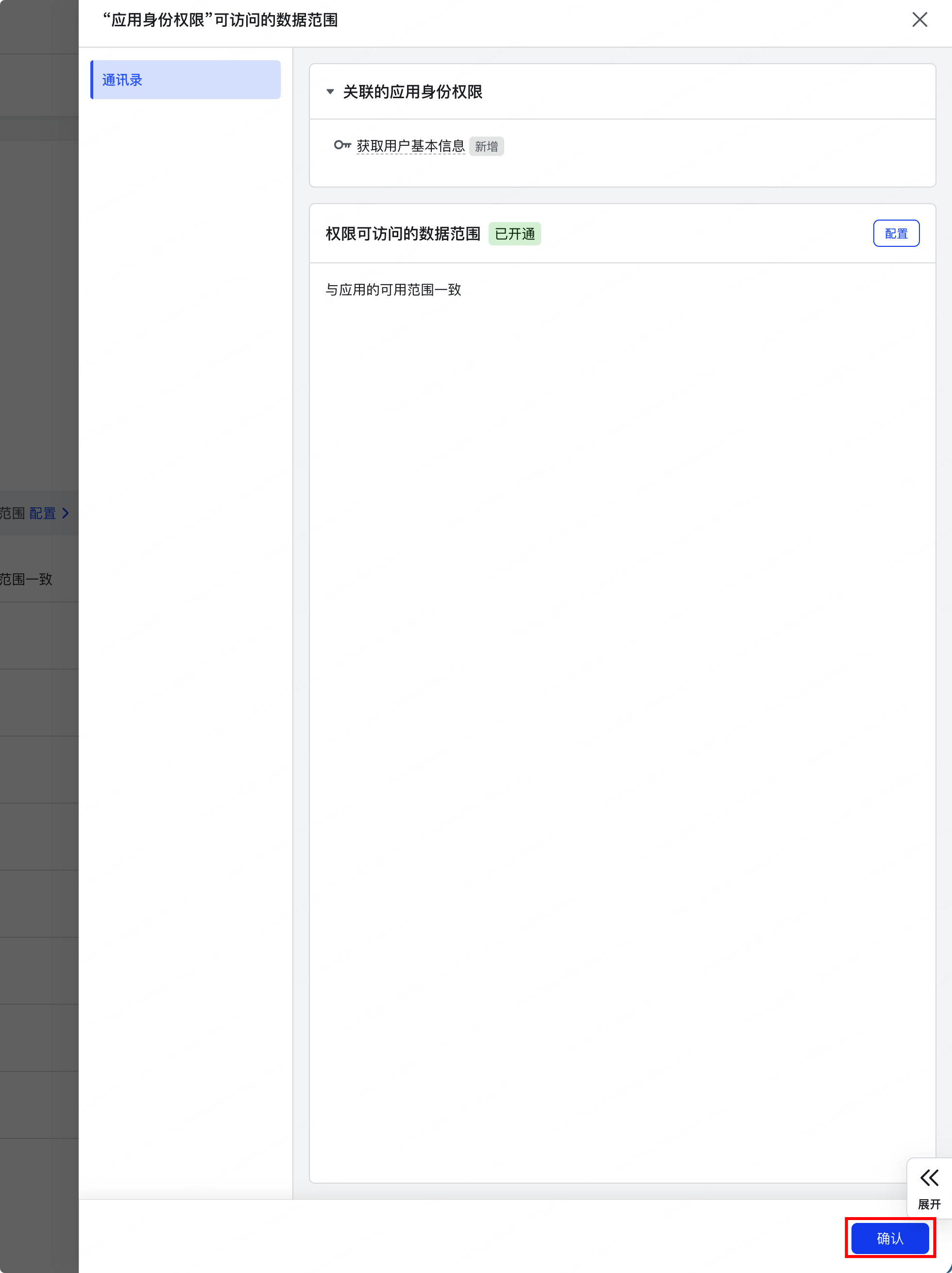

5.4 配置飞书权限事件

-

配置事件

-

添加事件

-

配置回调

-

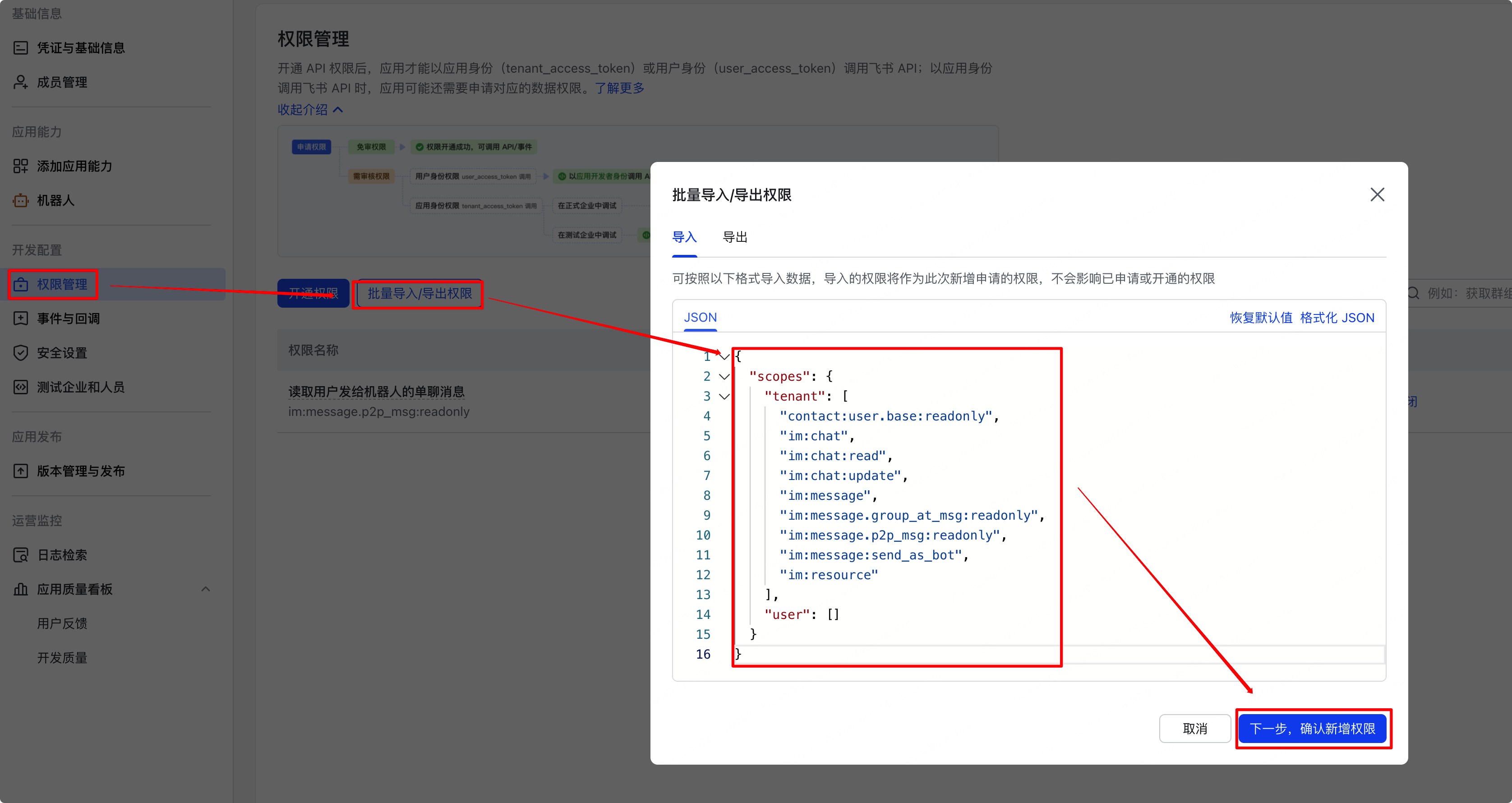

配置权限,直接批量导入以下json

{

"scopes": {

"tenant": [

"contact:user.base:readonly",

"im:chat",

"im:chat:read",

"im:chat:update",

"im:message",

"im:message.group_at_msg:readonly",

"im:message.p2p_msg:readonly",

"im:message:send_as_bot",

"im:resource"

],

"user": []

}

}

- 再次发布版本

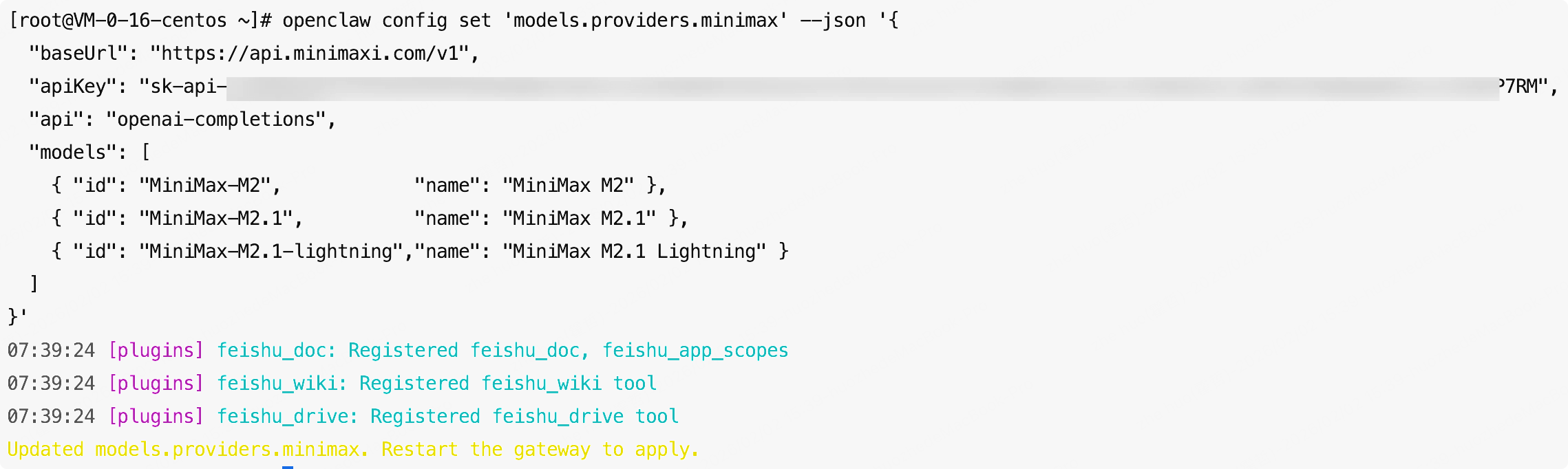

六、配置 AI 模型

OpenClaw支持多种大模型提供商,这是它另一个强大之处——你可以根据需求灵活切换。经过实际使用体验,我推荐使用MiniMax作为主力模型,它有不错的性价比和效果,而且对中文支持很好。

如需其他模型配置建议查看我另一篇文章《OpenClaw国内大模型配置指南:MiniMax、GLM、Kimi、Qwen全攻略》

6.1 配置 MiniMax 模型

使用以下命令配置MiniMax:

openclaw config set 'models.providers.minimax' --json '{

"baseUrl": "https://api.minimaxi.com/v1",

"apiKey": "这里填写你的APIKey",

"api": "openai-completions",

"models": [

{ "id": "MiniMax-M2", "name": "MiniMax M2" },

{ "id": "MiniMax-M2.1", "name": "MiniMax M2.1" },

{ "id": "MiniMax-M2.1-lightning","name": "MiniMax M2.1 Lightning" }

]

}'

注意:请将

apiKey值替换为你从MiniMax获取的真实API Key。

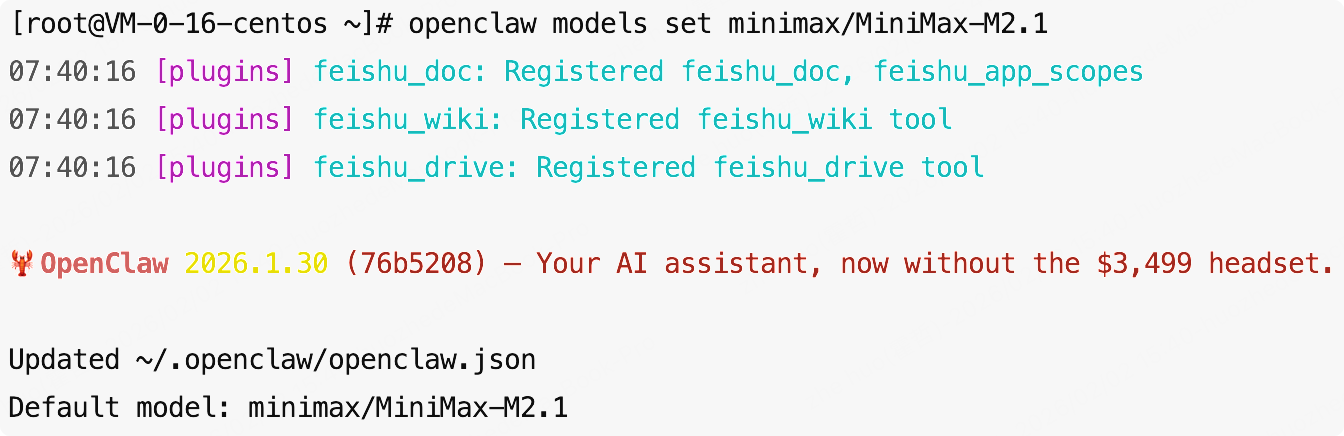

6.2 切换使用 MiniMax 模型

配置完成后,使用以下命令切换到MiniMax模型:

openclaw models set minimax/MiniMax-M2.1

七、验证配置

完成所有配置后,可以进行简单的测试验证:

# 查看openclaw配置的模型

openclaw models list

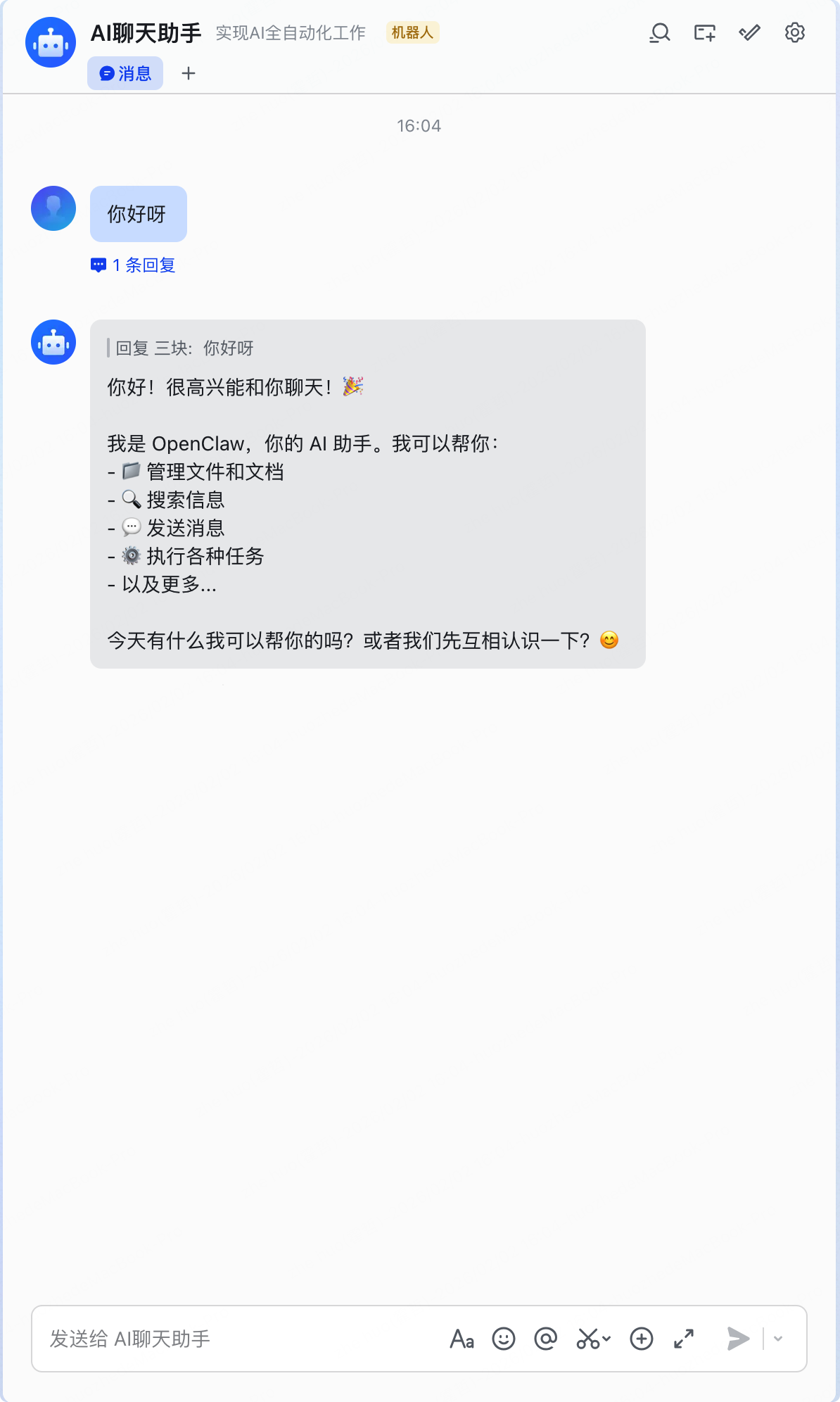

八、启动 OpenClaw 并验证效果

配置完成后,启动OpenClaw服务:

# 可以手动启动(前台模式)

openclaw gateway --port 18789 --verbose

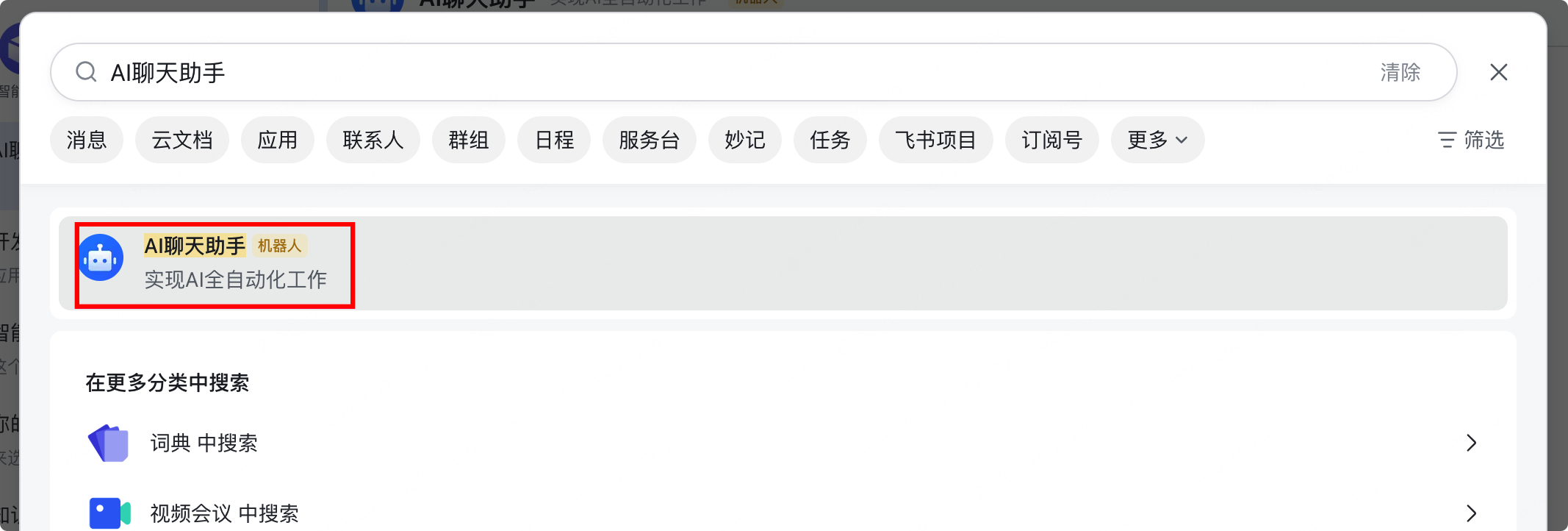

打开飞书电脑客户端或手机客户端,通过搜索刚刚创建的机器人应用,对话验证是否接入成功。

当机器人能够正常回复时,即可体验到OpenClaw的魅力——它能够实际协助完成工作,而非仅回答提问。

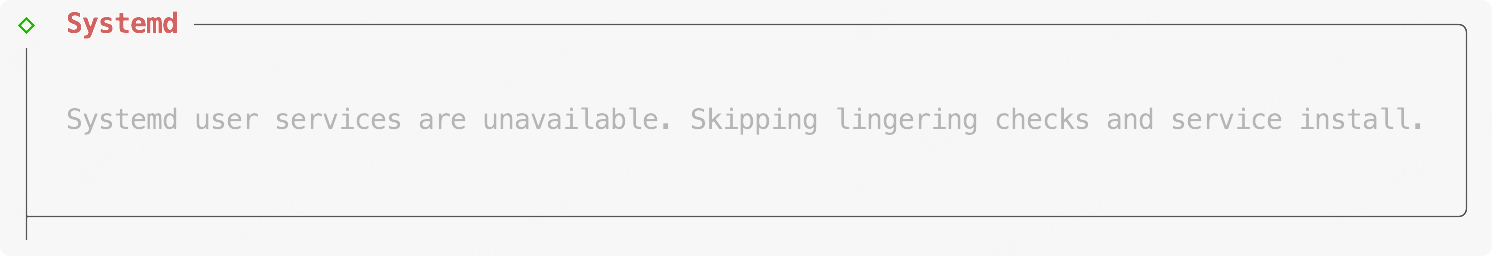

九、配置为系统服务

为了方便后续启动关闭openclaw,建议是讲openclaw配置成系统服务,通过systemctl来进行启动关闭操作

# 创建 systemd 服务文件

cat > /etc/systemd/system/openclaw-gateway.service << 'EOF'

[Unit]

Description=OpenClaw Gateway Service

After=network.target

[Service]

Type=simple

User=root

Environment="PATH=/root/.nvm/versions/node/v24.13.0/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin"

Environment="NODE_PATH=/root/.nvm/versions/node/v24.13.0/lib/node_modules"

WorkingDirectory=/root

ExecStart=/root/.nvm/versions/node/v24.13.0/bin/node /root/.nvm/versions/node/v24.13.0/lib/node_modules/openclaw/openclaw.mjs gateway run

Restart=on-failure

RestartSec=10

StandardOutput=journal

StandardError=journal

[Install]

WantedBy=multi-user.target

EOF

# 重新加载 systemd 配置

systemctl daemon-reload

# 启动服务

systemctl start openclaw-gateway

# 查看服务状态

systemctl status openclaw-gateway

# 设置开机自启

systemctl enable openclaw-gateway

十、常见问题

Q1: Node.js 版本不满足要求怎么办?

A: 请确保使用Node.js >= 22版本。如果已安装旧版本,可以使用nvm进行升级:

nvm install 24

nvm use 24

nvm alias default 24

Q2: 安装插件失败怎么办?

A: 检查网络连接,或尝试使用国内镜像源。有时候网络波动会导致下载失败,可尝试多次。

Q3: 飞书渠道配置后无法接收消息?

A: 请检查飞书应用的权限配置,确保已授予必要的机器人权限。尤其是im:message:send_as_bot这个权限必须确保已授予。

总结

经过完整的部署流程后,您应已成功搭建自己的OpenClaw环境。以下是对已完成工作的总结:

- ✅ Node.js环境安装:通过nvm管理Node.js版本,确保版本>=22

- ✅ 前置依赖准备:安装必要的编译工具,避免后续安装出错

- ✅ OpenClaw核心安装:选择官方脚本或npm方式,根据网络环境灵活选择

- ✅ 初始化配置:通过配置向导完成基础设置,重点启用三个实用钩子

- ✅ 飞书渠道集成:在飞书开放平台创建应用,安装插件并配置通道

- ✅ MiniMax模型配置:切换至性价比高的国内大模型,中文支持更好

- ✅ 服务验证与启动:通过官方命令验证配置,启动Gateway服务

相比传统的云端AI助手,OpenClaw具备以下明显优势:

- 数据隐私:所有数据都在你的设备上,不经过任何第三方服务器

- 执行能力:不仅能回答问题,更能实际操作文件、命令行、浏览器等

- 扩展灵活:通过ClawdHub有100+社区开发的技能模块可用

- 接入方便:支持飞书、钉钉等常用工具,无需安装专用客户端

正如社区用户所言:“It’s the closest to experiencing an AI enabled future!”——这即是OpenClaw所带来的实际体验。

如果你在部署过程中遇到其他问题,可以参考官方文档(https://docs.openclaw.ai/)或在GitHub社区(https://github.com/openclaw/openclaw)提问。OpenClaw的社区相当活跃,开发者们都很乐意帮忙。

现在即可让AI助手开始实际工作!

官方文档:https://openclaw.ai/

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

![[在此处插入配置验证的截图]](https://i-blog.csdnimg.cn/direct/7b5de025f1124920be693eabc206d599.png)

所有评论(0)