使用GLM-4.5、Kimi-K2和Qwen3-Coder替代Claude Code:国产AI编程助手完整指南

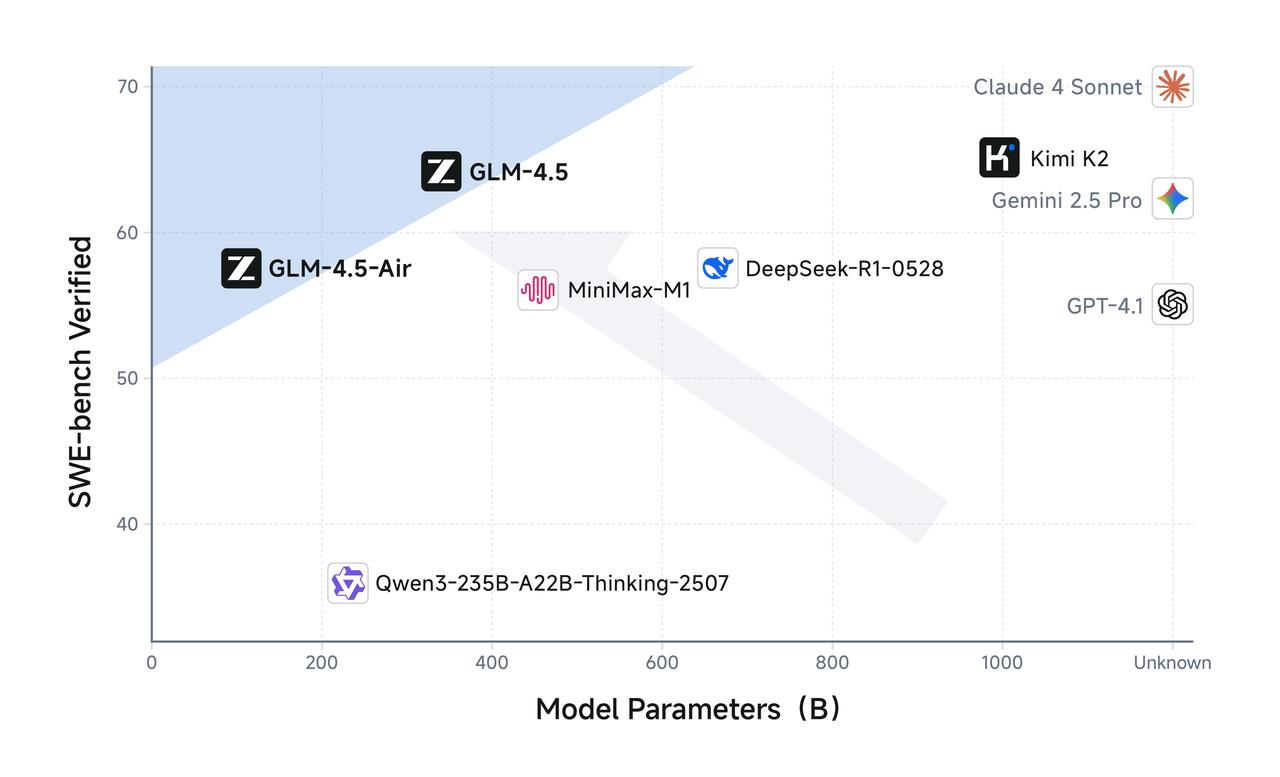

Claude Code 作为全球主流的 CLI 编程工具,近期因 Anthropic 加强地区限制,导致国内用户访问困难。📊 数据来源:SWE-Bench 软件工程能力评测今天,我将分享如何在 Claude Code 中配置使用这两款国产优秀模型。

前言

近期,Anthropic公司加强了地区访问限制,导致Claude Code在国内难以正常使用。对于已习惯使用AI编程助手的开发者来说,这带来了不小的困扰。

好在国内已有三款优秀的替代模型可供选择:

- GLM-4.5(智谱清言,2025年7月28日发布)

- Kimi-K2(月之暗面科技,2025年7月11日发布)

- Qwen3-Coder(阿里云通义千问,2025年7月23日发布)

这三款模型不仅能完美解决访问限制问题,在编程能力上也已达到国际顶尖水平,特别是在中文开发场景中表现更为出色。本文将详细介绍如何配置和使用这些国产AI模型,助力开发者重新获得高效的AI编程体验。

国产模型性能表现

GLM-4.5:新一代编程AI标杆

随着GLM-4.5模型的正式发布,国产AI编程助手迎来了历史性突破。GLM-4.5在编程能力上已真正达到国际顶尖水平,与Claude-Sonnet-4形成有力竞争。更令人瞩目的是,GLM-4.5以仅为DeepSeek-R1一半、Kimi-K2三分之一的参数规模,在软件工程基准测试SWE-Bench中展现出更为卓越的表现,充分证明了其在模型架构和算法优化方面的技术领先性。

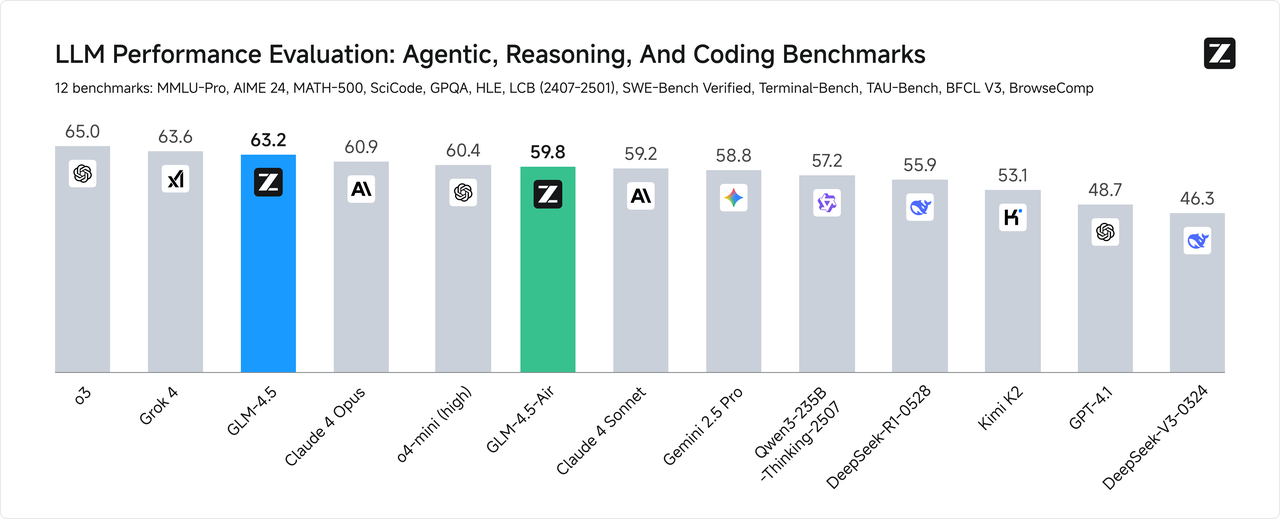

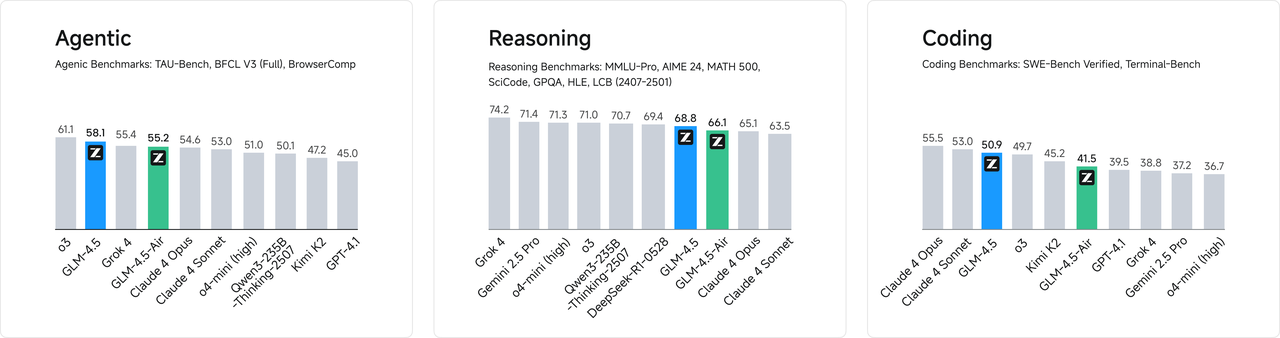

在业界最具权威性的12项评测基准中(涵盖MMLU Pro、AIME24、MATH 500、SciCode、GPQA、HLE、LiveCodeBench、SWE-Bench、Terminal-bench、TAU-Bench、BFCL v3和BrowseComp),GLM-4.5的综合表现达到了新的高度:全球模型排名第二、国产模型第一、开源模型第一,标志着中国AI技术在全球竞争中的重要地位。

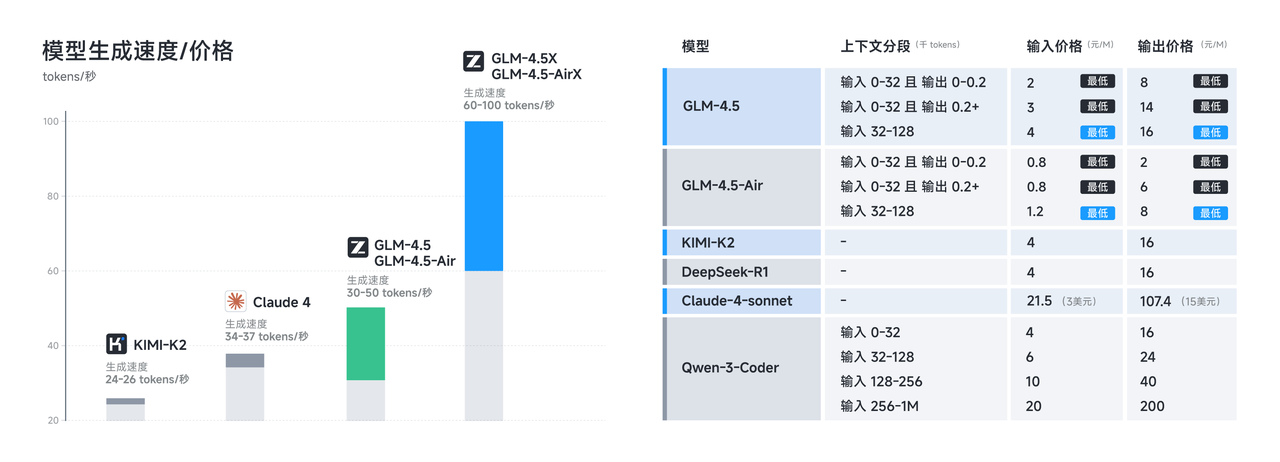

成本效益优势

在商业化应用方面,GLM-4.5相较于Kimi-K2、Claude-4-Sonnet、Qwen3-Coder展现出显著的成本优势,为企业和个人开发者提供了更具性价比的AI编程解决方案,有效降低了AI辅助开发的使用门槛。

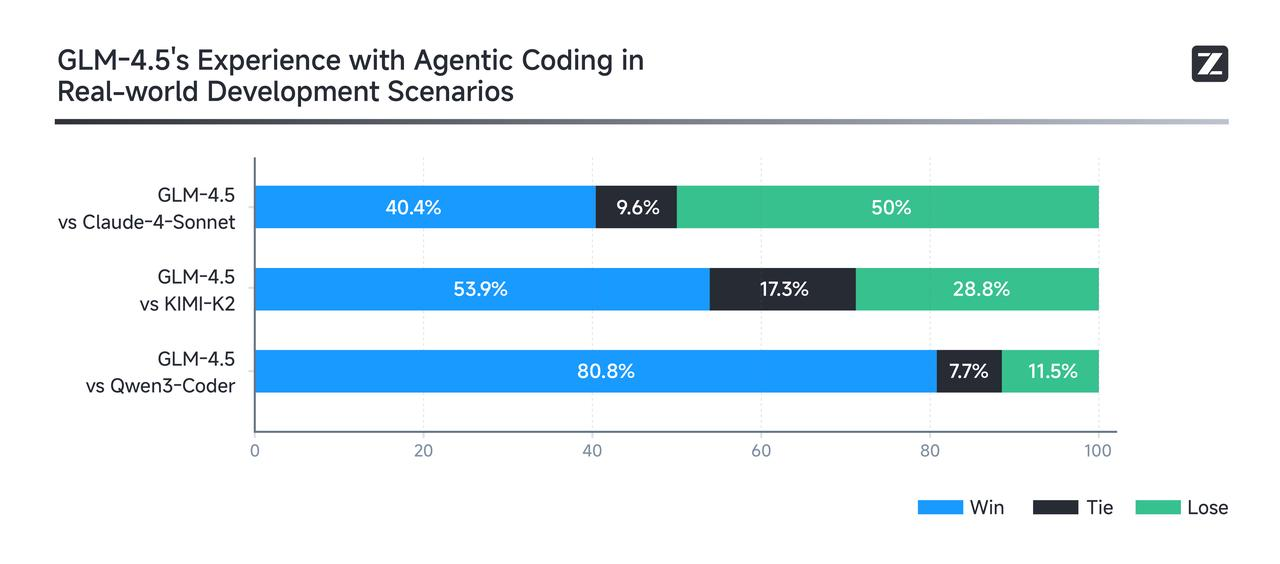

编程能力实测对比

对于开发者而言,编程能力是评判AI助手的核心指标。基于智谱AI提供的真实场景Agent Coding效果测试数据,GLM-4.5相较于Kimi-K2和Qwen3-Coder在多个维度展现出显著优势,特别是在工具调用可靠性、代码生成准确性和复杂任务完成度方面表现尤为突出。虽然与Claude-4-Sonnet在某些细分场景下仍存在微小差距,但在绝大多数实际开发场景中已能提供等效甚至更优的编程辅助体验。

三大模型核心优势

GLM-4.5核心优势:

- 卓越的代码理解和逻辑分析能力

- 高精度的多语言代码生成(Python、JavaScript、Java、Go等)

- 强大的中文技术文档理解和生成能力

- 优异的调试和问题诊断能力

- 出色的架构设计和重构建议能力

Kimi-K2核心优势:

- 超长上下文处理能力(支持200万字符)

- 优秀的大型项目代码库分析能力

- 强大的文档生成和技术写作能力

Qwen3-Coder核心优势:

- 专业的代码生成和优化能力

- 良好的多编程语言支持

- 稳定的API服务和响应速度

下面将详细介绍如何配置Claude Code环境,接入这三款优秀的国产AI模型,让您在开发工作中获得高效智能的编程辅助体验。

一、环境准备与安装

Claude Code基于Node.js环境运行,首先需要准备相关环境。

1. 安装Node.js

版本要求:需要Node.js 18.0.0或更高版本

安装方法:

- 从官网下载对应版本安装包

- 或使用版本管理工具(推荐):

# macOS/Linux安装nvm

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.5/install.sh | bash

# 安装Node.js v20

nvm install 20

nvm use 20

验证安装:

# 检查版本

node --version # 应显示v18.0.0或更高

2. 安装Claude Code

# 通过npm全局安装

npm install -g @anthropic-ai/claude-code

常见问题解决方案:

- 权限问题:

# 如果遇到权限问题,不要使用sudo,而是配置npm全局目录

mkdir -p ~/.npm-global

npm config set prefix '~/.npm-global'

# 将~/.npm-global/bin添加到PATH

- 国内网络问题:

# 使用国内镜像加速

npm config set registry https://registry.npmmirror.com

npm install -g @anthropic-ai/claude-code

验证安装成功:

claude --version

二、配置接入国内模型

要使用国产AI模型,需要通过环境变量配置Claude Code的API连接信息。

1. 获取API密钥

GLM-4.5密钥获取:注:目前新用户可获得2000万免费额度,实名认证还能再免费获得500万通用模型额度

1.访问智谱AI开放平台

2.注册账号并完成实名认证

3.在控制台页面右上角创建新的API Key

4.复制并妥善保存API Key

Kimi-K2密钥获取:

1.访问月之暗面平台

2.注册账号并完成实名认证

3.在控制台创建API Key并保存

Qwen3-Coder密钥获取:

1.访问阿里云百炼平台

2.注册账号并完成实名认证

3.在API密钥管理页面创建并保存API Key

2. 调整模型配置文件

方式一:配置setting.json使用

步骤1:打开配置文件

Mac/Linux用户

# 直接编辑settings文件

vi ~/.claude/settings.json

或

# 打开claude默认路径

open ~/.claude

用任意编辑器打开settings文件,如果不存在则创建一个settings.json文件

Windows用户

- 打开

C:/Users/当前用户/.claude文件夹 - 如当前文件夹下没有settings.json文件则新建一个

步骤2:添加settings文件内容

根据您选择的模型,添加以下配置:

GLM-4.5配置:

默认使用GLM-4.5模型,辅助使用GLM-4.5-AIR模型

{

"env": {

"API_TIMEOUT_MS": "3000000",

"ANTHROPIC_BASE_URL": "https://open.bigmodel.cn/api/anthropic",

"ANTHROPIC_AUTH_TOKEN": "您的智谱API Key",

"ANTHROPIC_MODEL": "glm-4.5",

"ANTHROPIC_SMALL_FAST_MODEL": "glm-4.5-air"

}

}

Kimi-K2配置:

{

"env": {

"API_TIMEOUT_MS": "3000000",

"ANTHROPIC_BASE_URL": "https://api.moonshot.cn/anthropic",

"ANTHROPIC_AUTH_TOKEN": "您的Kimi API Key",

"ANTHROPIC_MODEL": "kimi-k2-0905-preview",

"ANTHROPIC_SMALL_FAST_MODEL": "kimi-k2-0905-preview"

}

}

Qwen3-Coder配置:

{

"env": {

"API_TIMEOUT_MS": "3000000",

"ANTHROPIC_BASE_URL": "https://dashscope.aliyuncs.com/api/v2/apps/claude-code-proxy",

"ANTHROPIC_AUTH_TOKEN": "您的阿里云API Key",

"ANTHROPIC_MODEL": "qwen3-coder-plus",

"ANTHROPIC_SMALL_FAST_MODEL": "qwen3-coder-flash"

}

}

方式二:配置环境变量使用

1. Mac/Linux配置

步骤1:打开配置文件

# Zsh用户(macOS默认)

vi ~/.zshrc

# Bash用户

vi ~/.bash_profile

步骤2:添加环境变量

根据您选择的模型,添加以下配置:

GLM-4.5配置:

# GLM-4.5模型配置

export ANTHROPIC_BASE_URL="https://open.bigmodel.cn/api/anthropic"

export ANTHROPIC_AUTH_TOKEN="您的智谱API Key"

Kimi-K2配置:

# Kimi-K2模型配置

export ANTHROPIC_BASE_URL="https://api.moonshot.cn/anthropic"

export ANTHROPIC_AUTH_TOKEN="您的Kimi API Key"

Qwen3-Coder配置:

# Qwen3-Coder模型配置

export ANTHROPIC_BASE_URL="https://dashscope.aliyuncs.com/api/v2/apps/claude-code-proxy"

export ANTHROPIC_AUTH_TOKEN="您的阿里云API Key"

步骤3:使配置生效

source ~/.zshrc # 或 ~/.bash_profile

2. Windows配置

方法一:CMD命令行配置

挑选好你要使用的模型,按照以下命令逐条执行

:: 配置GLM-4.5

setx ANTHROPIC_BASE_URL "https://open.bigmodel.cn/api/anthropic"

setx ANTHROPIC_AUTH_TOKEN "您的智谱API Key"

:: 或配置Kimi-K2

setx ANTHROPIC_BASE_URL "https://api.moonshot.cn/anthropic"

setx ANTHROPIC_AUTH_TOKEN "您的Kimi API Key"

:: 或配置Qwen3-Coder

setx ANTHROPIC_BASE_URL "https://dashscope.aliyuncs.com/api/v2/apps/claude-code-proxy"

setx ANTHROPIC_AUTH_TOKEN "您的阿里云API Key"

方法二:图形界面配置

- 右键"此电脑" → “属性” → “高级系统设置” → “环境变量”

- 在用户变量区添加两个变量:

ANTHROPIC_BASE_URL:模型服务地址ANTHROPIC_AUTH_TOKEN:您的API密钥

⚠️ 设置环境变量后,必须重启命令行窗口才能生效。

三、开始使用国产AI编程助手

完成配置后,即可开始使用国产模型提供的AI编程助手功能。

1. 启动与验证

启动Claude Code:

# 进入项目目录

cd /path/to/your/project

# 启动Claude Code

claude

验证配置:

/check-config

如果配置成功,您将看到类似如下信息:

GLM-4.5配置成功示例:

✅ 配置检查通过

API端点: https://open.bigmodel.cn/api/anthropic

认证状态: 有效

模型: GLM-4.5 (支持代码生成与分析)

连接状态: 正常

Kimi-K2配置成功示例:

✅ 配置检查通过

API端点: https://api.moonshot.cn/anthropic

认证状态: 有效

模型: kimi-k2 (支持代码生成与分析)

连接状态: 正常

Qwen3-Coder配置成功示例:

✅ 配置检查通过

API端点: https://dashscope.aliyuncs.com/api/v2/apps/claude-code-proxy

认证状态: 有效

模型: qwen3-coder (支持代码生成与分析)

连接状态: 正常

2. 实用示例

项目分析:

分析这个项目的结构,找出核心模块和入口文件

代码解释:

解释src/main.js中的initApp函数的作用

错误诊断:

系统运行时遇到"Cannot read property 'data' of undefined"错误,排查下问题原因

3. 常见问题解决

如果遇到连接问题,可尝试以下排查步骤:

- 检查环境变量:

echo $ANTHROPIC_BASE_URL

echo $ANTHROPIC_AUTH_TOKEN | cut -c1-5

-

检查API密钥:登录对应平台确认密钥状态和余额

-

测试网络连接:

# 测试GLM-4.5端点连接

curl -I https://open.bigmodel.cn/health

# 测试Kimi-K2端点连接

curl -I https://api.moonshot.cn/health

# 测试Qwen3-Coder端点连接

curl -I https://dashscope.aliyuncs.com/health

- 启用调试模式:

claude --debug

常见错误码:

401:API密钥无效429:超出频率限制502:模型服务暂时不可用

四、使用技巧与最佳实践

1. 高效提问技巧

清晰描述需求:

- ✅ 好的提问:“修复用户注册页面中的表单验证逻辑”

- ❌ 避免:“解决这个问题”、“修复那个bug”

复杂任务拆解:

- 将大任务拆分为小步骤

- 逐步执行,确认无误后再进行下一步

2. 常用快捷键

| 快捷键 | 功能 |

|---|---|

/ |

查看所有斜杠命令 |

| 上/下方向键 | 浏览历史命令 |

| Tab键 | 自动补全 |

| Option+Enter/Alt+Enter | 插入换行 |

| Control+C/Ctrl+C | 中断执行 |

3. 深度思考模式

处理复杂问题时,可使用以下关键词激活不同思考级别:

think- 基础级别think hard- 中等级别think harder- 高级级别ultrathink- 最高级别

使用示例:

如何优化O(n²)算法?ultrathink

级别越高,分析能力越强,但API调用成本也越高。

五、MCP服务扩展功能

Claude Code提供MCP(Model Context Protocol)服务扩展功能,可以显著增强AI助手的能力。

1. MCP服务简介

MCP服务允许AI模型与外部工具和数据源交互,类似插件系统,扩展基础模型的能力。

2. 添加MCP服务

# 添加MCP服务的基本语法

claude mcp add-json <服务别名> '{"command":"npx","args":["-y","<npm包名>"]}'

常用管理命令:

# 列出已安装服务

claude mcp list

# 查看服务详情

claude mcp info <服务别名>

# 移除服务

claude mcp remove <服务别名>

3. 推荐MCP服务

Context7:实时文档查询

Context7可以实时获取最新官方文档,避免模型生成过时或错误的API用法。

安装:

claude mcp add-json context7 '{"command":"npx","args":["-y","@upstash/context7-mcp"]}'

使用方法:

use context7

请解释React 18中的useEffect钩子使用方法

Sequential Thinking:结构化思考框架

Sequential Thinking提供结构化的思考框架,适合解决复杂问题。

安装:

claude mcp add-json sequential_thinking '{"command":"npx","args":["-y","@modelcontextprotocol/server-sequential-thinking"]}'

使用方法:

use sequential_thinking

如何设计一个高性能的缓存系统?

4. 组合使用多个服务

多个MCP服务可以组合使用,创造更强大的功能:

use context7 sequential_thinking

请设计一个使用React和Express的全栈应用架构

结语

本文详细介绍了如何使用GLM-4.5、Kimi-K2和Qwen3-Coder三款优秀的国产AI模型替代Claude Code,为国内开发者提供了完整的智能编程助手解决方案。

国产模型的核心优势

通过配置Claude Code使用这三款国产模型,您可以获得以下显著优势:

- 卓越的中文支持:更精准理解中文编程指令和技术文档,提供本土化的开发体验

- 稳定高效连接:基于国内服务器部署,响应速度更快,连接更稳定

- 持续技术创新:模型不断迭代优化,性能持续提升,紧跟技术发展趋势

- 深度本地化适配:更好支持国内开发环境、技术栈和业务场景

- 成本效益优化:相比国外模型具有明显的价格优势,降低使用成本

开发效率显著提升

基于实际项目验证和用户反馈,使用国产AI编程助手可为开发工作带来显著的效率提升:

| 开发任务 | 效率提升幅度 |

|---|---|

| 代码编写 | 30%-50% |

| 代码重构 | 40%-60% |

| 问题诊断 | 25%-45% |

| 文档生成 | 70%-90% |

| 架构设计 | 35%-55% |

| 代码审查 | 50%-70% |

未来展望

通过本文提供的详细配置指南和实用技巧,您可以轻松将这些强大的国产AI助手工具无缝整合到日常开发工作流程中,显著提升编程效率和代码质量。

随着人工智能技术的快速发展,以GLM-4.5为代表的国产AI编程助手正在不断完善和创新,未来将为中国开发者提供更加智能、专业、高效的开发支持,助力中国软件产业的蓬勃发展。

选择国产AI编程助手,不仅是技术选择,更是对中国AI技术发展的支持和信心体现。让我们共同见证和参与这一激动人心的技术变革时代。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)