端侧大模型部署实战:从“大象塞进冰箱“到流畅运行的工程艺术

2024-2025年AI行业正经历"云端智能下沉"的变革,大模型向边缘设备迁移面临三大技术瓶颈:内存墙(Llama-2-7B需14GB显存)、带宽墙(Decode阶段带宽利用率仅10-30%)和功耗墙。解决方案包括量化技术(INT8-PTQ为主流)、结构化剪枝(可剪枝30-40%注意力头)和MoE架构优化。系统级优化需结合内存管理、异构计算调度(NPU处理Prefill,CPU

一、引言:当大模型遇上小设备

2024-2025年,AI行业正在经历一场静默但深刻的变革。随着GPT-4、Claude等大模型在云端展现惊人能力,业界开始思考一个更具挑战性的问题:如何让这些"智力巨人"在资源受限的边缘设备上奔跑?

智源研究院Emu3模型登上《Nature》正刊,标志着多模态大模型在理论层面的突破;而与此同时,端侧AI市场正以58%的年复合增长率狂奔,预计2028年将达到1.9万亿元规模。这种"云端智能下沉"的趋势,正在重塑AI应用的技术栈。

但挑战是残酷的:如何在只有8GB内存的手机上运行70亿参数的模型?如何在50ms延迟内完成推理?这不仅是算法问题,更是一场算法-系统-硬件的协同设计攻坚战。

二、端侧部署的三大技术瓶颈

2.1 内存墙:参数存储的物理极限

以Llama-2-7B为例,FP16精度下仅权重就需要14GB显存,这已超出大多数移动设备的容量。更棘手的是动态KV Cache,在长文本场景下可能膨胀至权重本身的数倍。

核心矛盾:模型容量与设备内存的剪刀差正在扩大,而非缩小。

2.2 带宽墙:Decode阶段的隐形杀手

端侧推理分为两个阶段:

-

Prefill阶段:计算密集型,受限于NPU/CPU算力

-

Decode阶段:内存带宽密集型,每个token生成都需加载全部参数

实测数据显示,在ARM架构上,Decode阶段通常只有10-30%的算术单元利用率,其余时间都在等待数据加载。这意味着单纯提升算力对整体吞吐改善有限。

2.3 功耗墙:移动设备的生死线

大模型推理动辄数十瓦的功耗,对于电池供电设备是不可承受之重。如何在精度-速度-功耗的三角约束中找到帕累托最优,是端侧部署的核心命题。

三、模型压缩技术栈:从FP32到INT4的进化之路

3.1 量化:精度与效率的博弈

量化是将高精度浮点数映射到低精度整数的过程。当前工业界的主流方案演进如下:

| 量化方案 | 精度 | 压缩比 | 适用场景 | 精度损失 |

|---|---|---|---|---|

| FP16 | 16位 | 2x | 高端手机/PC | <1% |

| INT8-PTQ | 8位 | 4x | 通用端侧部署 | 1-3% |

| INT8-QAT | 8位 | 4x | 精度敏感场景 | <1% |

| INT4-GPTQ | 4位 | 8x | 资源极度受限 | 3-5% |

| 混合精度 | 混合 | 3-6x | 复杂模型 | 1-2% |

实践建议:

解决方案:

关键优化点:

4.2 推理引擎选型对比

-

首选INT8-PTQ:无需重新训练,工具链成熟(LLMC、AutoGPTQ)

-

敏感层保护:对LayerNorm、Attention输出层保留FP16

-

动态缩放:采用per-channel或per-token量化而非per-tensor

# PyTorch Mobile量化示例(基于QNNPACK后端) import torch from torch.ao.quantization import get_default_qconfig, quantize_jit # 配置ARM架构优化 qconfig = get_default_qconfig('qnnpack') # 校准数据准备(关键步骤!) calibration_data = [torch.randn(1, 3, 224, 224) for _ in range(100)] # 执行量化 quantized_model = quantize_jit( traced_model, {'': qconfig}, calibration_data, dtype=torch.qint8 )3.2 剪枝与蒸馏:结构优化双雄

结构化剪枝通过移除整个卷积核或注意力头,直接降低计算密度。最新研究表明,在保持70%性能的前提下,可剪枝30-40%的注意力头。

知识蒸馏则让小模型(Student)学习大模型(Teacher)的行为分布。DeepSeek-R1的蒸馏版本证明,通过高质量的推理轨迹蒸馏,1.5B小模型可在特定任务上媲美原始大模型。

3.3 专家混合(MoE)的端侧适配

MoE架构通过稀疏激活实现"大参数量、小计算量"的幻觉。但在端侧部署时,专家路由的动态性带来新的挑战:

-

内存碎片化:不同输入激活不同专家,导致内存访问不连续

-

加载延迟:冷启动专家权重从Flash加载耗时

-

专家权重缓存:将高频激活专家常驻内存

-

投机性加载:基于历史模式预加载可能激活的专家

-

计算-通信重叠:通过流水线隐藏加载延迟

-

Prompt Cache:对系统提示(System Prompt)计算一次,后续复用KV Cache

-

滑动窗口注意力:限制KV Cache长度,权衡长程依赖与内存占用

| 推理框架 | 优势 | 适用场景 | 端侧支持 |

|---|---|---|---|

| llama.cpp | 极致轻量、多后端 | 纯CPU推理 | ⭐⭐⭐⭐⭐ |

| MLC-LLM | 编译优化、异构调度 | 手机/NPU | ⭐⭐⭐⭐ |

| TensorRT-LLM | GPU极致优化 | 高端安卓/车机 | ⭐⭐⭐ |

| ONNX Runtime | 生态丰富、易部署 | 通用边缘设备 | ⭐⭐⭐⭐ |

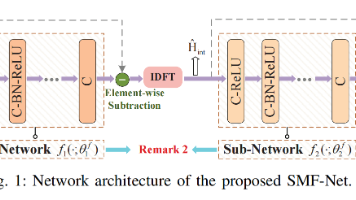

4.3 异构计算调度

现代SoC通常包含CPU、GPU、NPU多种计算单元。任务划分策略直接影响能效比:

Prefill阶段: offload至NPU,利用高并行度处理长序列

Decode阶段: 切换至CPU或中小核,优化单token延迟

混合精度: NPU支持INT8/INT4,CPU处理FP16回退

五、实战案例:在手机端部署70亿参数模型

5.1 环境准备

# 使用MLC-LLM进行Android部署

pip install mlc-llm-nightly mlc-ai-nightly

mlc_llm chat Llama-2-7b --quantization q4f16_15.2 模型转换与优化

四、系统级优化:榨取硬件最后一滴性能

4.1 内存管理策略

分页注意力(PagedAttention)技术将KV Cache划分为固定大小的块,显著减少内存碎片。在端侧实现时,需结合内存池预分配策略,避免运行时malloc的不可预测延迟。

# 配置量化与优化参数

from mlc_llm import quantization, core

config = quantization.QuantizationConfig(

mode="q4f16_awq", # 4-bit Activation-aware Weight Quantization

group_size=128,

pre_quantized=True

)

# 编译为移动端可执行格式

core.compile(

model="meta-llama/Llama-2-7b-chat-hf",

target="android/adreno_gpu", # 针对Adreno GPU优化

opt_level=3,

quantization_config=config

)5.3 性能调优 checklist

内存预算控制:确保模型权重 + KV Cache < 设备内存的70%

线程数调优:通常设置为大核数量的1-2倍

批处理策略:即使是单用户,也可通过 speculative decoding 提升吞吐

功耗监控:使用Systrace分析热节流对性能的影响

六、未来展望:端侧AI的2025图景

6.1 技术趋势

6.2 开发者建议

七、结语

端侧大模型部署不是简单的"模型压缩+SDK调用",而是需要深入理解计算架构、内存层次、能耗模型的系统工程。正如DeepSeek-OCR通过视觉模态实现10倍文本压缩率,未来的端侧优化必将走向算法-硬件协同设计的新范式。

在这个"把大象塞进冰箱"的过程中,我们不仅在优化模型,更在重新定义AI与物理世界的交互方式。当大模型真正运行在每一部手机、每一台IoT设备上时,普惠AI的愿景才算真正落地。

-

原生多模态端侧模型:Emu3等统一架构将推动端侧多模态应用爆发

-

AI Agent本地化:设备端智能体实现隐私保护与实时响应的平衡

-

存算一体芯片:通过模拟计算突破冯·诺依曼瓶颈,理论能效提升100x

-

关注TinyML生态:TensorFlow Lite Micro、CMSIS-NN等框架持续演进

-

掌握编译优化技术:TVM、IREE等AI编译器是性能调优的终极武器

-

重视数据隐私:端侧推理天然符合GDPR/个人信息保护法要求,是差异化竞争点

更多推荐

已为社区贡献106条内容

已为社区贡献106条内容

所有评论(0)