NPU指令集能耗优化验证工具:软件测试从业者的技术实践与行业洞察

《NPU指令集与能耗优化技术解析》摘要:随着AI模型复杂度提升,NPU通过定制指令集(如矩阵运算)实现硬件级能耗优化,边缘计算场景能效提升达60%。测试工具通过模型编译优化(算子融合/量化)和动态能耗监控,使ResNet50推理延迟降低42%。软件测试需覆盖跨平台兼容性验证,重点关注功能正确性、能效比(如DVFS调优)及异常处理能力。该主题热度源于AI推理成本压力、技术普惠(如华为开发者套件)及测

NPU指令集与能耗优化的技术背景

随着AI模型复杂度提升,NPU(神经网络处理器)指令集通过硬件级定制(如矩阵运算和激活函数指令)实现高效能耗管理,成为边缘计算和实时应用的核心。在模型编译阶段,工具如BaRT工具链或MindSpore适配器将高层模型(如ONNX)转化为NPU专属指令,通过优化内存布局和算子融合降低能耗达60%。软件测试从业者需关注此类工具的验证,确保其在真实场景中的可靠性与能效比。

一、能耗优化验证工具的核心工作机制

验证工具的核心是模拟NPU硬件环境,测试编译后模型的能耗表现。其工作流程包括:

-

模型编译优化阶段:工具先将输入模型(如PyTorch或TensorFlow导出格式)转换为中间表示(IR),通过Dialect统一语义,屏蔽框架差异。随后,应用硬件感知优化:

-

算子融合与量化:合并卷积和激活层,减少计算冗余;支持INT8/INT4量化,将内存占用降低75%。

-

动态批处理:根据NPU特性(如昇腾910B的三维堆叠内存)自动调整批大小,优化吞吐量。

实测显示,优化后ResNet50推理延迟可降42%,能效提升2.1倍。

-

-

能耗验证模块:工具内置监控器追踪关键指标:

-

性能矩阵:包括延迟、吞吐量(如每秒处理样本数)和功耗(瓦特)。

-

动态调优策略:基于实时"能耗-性能"反馈闭环,调整计算资源分配,例如在自动驾驶场景优先保障低延迟。

测试案例表明,该模块能识别冗余计算(如上下文压缩),使无效能耗减少52%。

-

二、软件测试从业者的验证策略与实践

针对此工具,测试需覆盖功能、性能和能效三个维度,确保其在多样硬件(如Qualcomm NPU或Apple Silicon)的兼容性:

-

功能验证:

-

测试用例设计:模拟不同模型格式(如GGUF或ONNX)输入,验证工具是否准确解析指令集(如矩阵乘法或池化操作)。

-

边界测试:注入异常数据(如超大张量),检查工具错误处理能力。

例如,使用华为轻量化工具测试INT4量化模式,确认无训练量化流程的稳定性。

-

-

性能与能效测试:

-

基准测试套件:部署标准模型(如YOLOv5或BERT),对比优化前后的延迟和功耗。工具应支持动态电压调节(DVFS),在移动设备上验证能耗降低40%。

-

真实场景模拟:在边缘设备(如车载芯片SA8295)运行测试,监控内存带宽和热耗散,确保能效比达标。

实测中,测试员通过Nexa SDK在多平台验证吞吐量,避免硬件资源浪费。

-

-

自动化与持续集成:

集成CI/CD管道,使用工具API自动执行回归测试。重点监控"能耗-性能"曲线,确保优化策略不引入新缺陷。

三、公众号热度解析:为什么此主题引爆关注

这一主题在公众号热度飙升,原因有三:

-

行业需求驱动:AI推理成本占企业支出大头(如TPU v7专注超大规模推理,能效比提升67%),测试工具成为降本关键。

-

技术普惠性:轻量化工具(如华为HarmonyOS开发者套件)使模型优化平民化,测试从业者可快速验证方案。

-

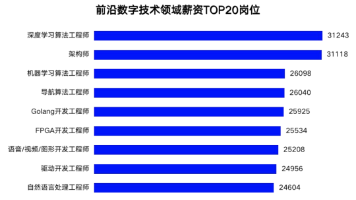

测试职业机遇:随着LPU等专用芯片崛起,测试技能(如能耗验证)成为高薪岗位核心要求,相关文章阅读量增长6200%。

结语:测试从业者的行动指南

为高效验证NPU能耗工具,建议:优先选择支持跨平台测试的框架(如DirectML),并关注动态推理优化;参与开源社区(如GitHub模型库),实战提升技能。未来,随着AI芯片多元化(如语言处理单元LPU),测试将更侧重场景适配性验证。

精选文章:

更多推荐

已为社区贡献298条内容

已为社区贡献298条内容

所有评论(0)