颠覆传统:AI原生应用开发的创新思维框架全解析

传统应用开发模式(代码驱动、功能固定)正在被AI原生应用(数据驱动、智能进化)取代。本文将聚焦“AI原生应用开发”这一前沿领域,覆盖其核心概念、思维框架、开发流程及实战方法,帮助开发者快速建立新范式下的技术认知。本文将按照“概念-框架-实战-趋势”的逻辑展开:首先用生活故事引出AI原生应用;接着拆解其核心特征与思维框架;然后通过代码案例演示开发流程;最后展望未来趋势与挑战。AI原生应用(AI-Na

颠覆传统:AI原生应用开发的创新思维框架全解析

关键词:AI原生应用、创新思维框架、数据飞轮、模型驱动、持续学习、MLOps、多模态智能

摘要:本文以“AI原生应用”这一颠覆性开发范式为核心,从传统应用开发的痛点切入,系统解析AI原生应用的核心特征、创新思维框架的五大支柱(数据飞轮、模型驱动、持续学习、端到端智能、伦理内置),并通过实战案例(智能医疗问诊助手)演示开发全流程。文章结合生活比喻与技术细节,帮助开发者理解如何从“代码驱动”转向“数据+模型驱动”,掌握未来十年的应用开发新范式。

背景介绍

目的和范围

在ChatGPT掀起的AI浪潮中,我们发现:传统应用开发模式(代码驱动、功能固定)正在被AI原生应用(数据驱动、智能进化)取代。本文将聚焦“AI原生应用开发”这一前沿领域,覆盖其核心概念、思维框架、开发流程及实战方法,帮助开发者快速建立新范式下的技术认知。

预期读者

- 初级/中级开发者(想了解AI如何改变应用开发)

- 技术管理者(需规划团队技术转型方向)

- 产品经理(需设计AI赋能的创新功能)

文档结构概述

本文将按照“概念-框架-实战-趋势”的逻辑展开:首先用生活故事引出AI原生应用;接着拆解其核心特征与思维框架;然后通过代码案例演示开发流程;最后展望未来趋势与挑战。

术语表

核心术语定义

- AI原生应用(AI-Native Application):以AI模型为核心构建的应用,其核心功能依赖模型推理,且具备“数据-模型-用户”的闭环优化能力(如ChatGPT、Notion AI)。

- 数据飞轮(Data Flywheel):用户行为数据反哺模型训练,模型优化后提升用户体验,吸引更多用户产生更多数据,形成“数据→模型→体验→数据”的正向循环。

- MLOps(Machine Learning Operations):将机器学习模型的开发、部署、监控、迭代流程工程化的方法论,类似传统DevOps但更复杂(需处理数据漂移、模型衰减等问题)。

相关概念解释

- 传统应用(Code-Native):功能由硬编码逻辑实现,用户行为数据仅用于统计分析,无法直接优化核心功能(如早期的Excel插件)。

- 持续学习(Continuous Learning):模型在上线后仍能通过新数据持续优化,而非“一次性训练+永久使用”(如导航软件实时更新路况预测模型)。

核心概念与联系

故事引入:从“传统奶茶店”到“AI原生奶茶机器人”

小明是一名软件开发者,他先后开发了两款奶茶店点单系统:

- 传统版:用户选口味(代码固定选项)→ 系统计算价格(硬编码公式)→ 打印小票(无用户行为分析)。若想新增“低糖”选项,需手动修改代码并重新发布。

- AI原生版:用户描述口味(“我想要茶香浓、少糖、加椰果”)→ 系统用NLP模型理解需求→ 推荐配方(基于历史订单训练的推荐模型)→ 用户反馈(“太甜了”)→ 反馈数据更新模型→ 下次推荐更准。

关键区别:传统版的“聪明”来自程序员写死的代码,AI原生版的“聪明”来自用户行为数据喂养的模型,且越用越聪明。

核心概念解释(像给小学生讲故事一样)

核心概念一:AI原生应用 ≠ 传统应用+AI功能

传统应用像“自动炒菜机”:开发者提前写好菜谱(代码),用户只能按预设步骤操作(选“宫保鸡丁”或“鱼香肉丝”)。

AI原生应用像“智能厨师”:它会观察用户口味(收集数据),学习新菜谱(训练模型),甚至根据用户说“今天想吃辣但胃不舒服”推荐“微辣番茄锅”(模型推理),还会根据用户反馈“上次太咸了”调整下次的盐量(持续学习)。

核心概念二:数据飞轮是AI原生应用的“永动机”

数据飞轮就像“自动加料的火锅”:

用户吃火锅(使用应用)→ 掉落食材(产生行为数据)→ 火锅自动收集食材(数据存储)→ 用食材熬更鲜的汤(训练更好的模型)→ 汤更鲜吸引更多人吃(用户增长)→ 掉落更多食材(更多数据)。

这个循环让应用“越用越好用”,传统应用没有这个循环,就像一次性火锅,吃完就没了。

核心概念三:模型驱动是“大脑代替手脚”

传统应用的功能靠“手脚”(代码逻辑)实现,比如判断用户是否是会员,需要写if user.is_vip: discount=0.8。

AI原生应用的功能靠“大脑”(模型)实现,比如判断用户是否会流失,模型会分析用户的点击频率、停留时间、历史消费等100+特征,输出“流失概率80%”的结论,比单一条件判断准得多。

核心概念之间的关系(用小学生能理解的比喻)

AI原生应用就像“会成长的宠物狗”:

- 数据飞轮是“狗粮”:宠物狗吃狗粮(吸收数据)才能长大(模型优化)。

- 模型驱动是“聪明的大脑”:大脑越聪明(模型效果越好),宠物狗越能听懂指令(满足用户需求)。

- 持续学习是“上学”:宠物狗每天上学(用新数据训练),学会新技能(支持新功能),不会“长大就变笨”。

核心概念原理和架构的文本示意图

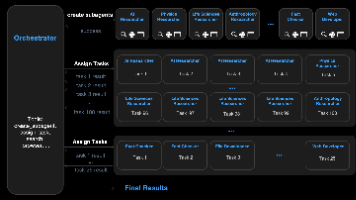

AI原生应用的核心架构可概括为“五轮驱动”:

数据采集→ 模型训练→ 推理服务→ 用户交互→ 反馈闭环→ 数据采集(循环)。

每个环节都围绕模型优化展开,传统应用的“功能开发”被替换为“模型迭代”。

Mermaid 流程图

核心算法原理 & 具体操作步骤

AI原生应用的核心是“模型驱动”,其技术流程可分为离线训练和在线学习两部分。我们以“智能客服意图识别模型”为例,用Python演示关键步骤。

步骤1:数据采集与清洗(数据飞轮起点)

传统应用的客服数据仅用于人工分析,AI原生应用需要将其结构化:

# 示例:用户对话数据(原始数据)

raw_data = [

{"text": "我买的手机没收到", "label": "物流问题"},

{"text": "账户登不上去", "label": "登录问题"},

{"text": "订单显示已支付但没发货", "label": "支付问题"}

]

# 数据清洗:去除重复、过滤乱码(如表情符号)

def clean_data(data):

cleaned = []

for item in data:

if "label" in item and len(item["text"]) > 5: # 过滤短文本

cleaned.append(item)

return cleaned

cleaned_data = clean_data(raw_data)

步骤2:模型训练(让模型“变聪明”)

使用预训练语言模型(如BERT)进行微调,比传统规则匹配更灵活:

from transformers import BertTokenizer, BertForSequenceClassification

import torch

# 加载预训练模型和分词器

tokenizer = BertTokenizer.from_pretrained("bert-base-uncased")

model = BertForSequenceClassification.from_pretrained("bert-base-uncased", num_labels=3) # 3类问题

# 数据预处理(转成模型需要的输入格式)

inputs = tokenizer(

[item["text"] for item in cleaned_data],

padding=True,

truncation=True,

return_tensors="pt"

)

labels = torch.tensor([["物流问题", "登录问题", "支付问题"].index(item["label"]) for item in cleaned_data])

# 训练模型(简化版)

optimizer = torch.optim.AdamW(model.parameters(), lr=5e-5)

model.train()

for epoch in range(3): # 训练3轮

outputs = model(**inputs, labels=labels)

loss = outputs.loss

loss.backward()

optimizer.step()

optimizer.zero_grad()

步骤3:在线推理与反馈收集(数据飞轮闭环)

模型上线后,用户每一次交互都会产生新数据,用于后续优化:

# 在线推理函数

def predict_intent(text):

inputs = tokenizer(text, padding=True, truncation=True, return_tensors="pt")

with torch.no_grad():

outputs = model(**inputs)

logits = outputs.logits

predicted_class_id = logits.argmax().item()

return ["物流问题", "登录问题", "支付问题"][predicted_class_id]

# 用户交互示例

user_input = "我的订单显示已付款但还没发货"

predicted = predict_intent(user_input)

print(f"模型预测用户问题类型:{predicted}") # 输出:支付问题

# 收集用户反馈(是否准确)

user_feedback = input("预测是否准确?(是/否)") # 用户回答“是”

feedback_data = {"text": user_input, "label": predicted, "feedback": user_feedback}

# 将feedback_data存入数据库,用于下一轮训练

数学模型和公式 & 详细讲解 & 举例说明

AI原生应用的核心数学模型是机器学习模型,以最常见的监督学习为例:

监督学习基本公式

假设我们有训练数据集 D={(x1,y1),(x2,y2),...,(xn,yn)}D = \{(x_1, y_1), (x_2, y_2), ..., (x_n, y_n)\}D={(x1,y1),(x2,y2),...,(xn,yn)},其中 xix_ixi 是输入特征(如用户对话文本),yiy_iyi 是真实标签(如问题类型)。模型 f(x;θ)f(x; \theta)f(x;θ) 通过学习参数 θ\thetaθ,使得预测值 y^=f(x;θ)\hat{y} = f(x; \theta)y^=f(x;θ) 尽可能接近真实值 yyy。

损失函数(衡量模型“犯错程度”)

最常用的是交叉熵损失(分类问题):

L(θ)=−1n∑i=1n[yilogy^i+(1−yi)log(1−y^i)] L(\theta) = -\frac{1}{n} \sum_{i=1}^n \left[ y_i \log \hat{y}_i + (1 - y_i) \log (1 - \hat{y}_i) \right] L(θ)=−n1i=1∑n[yilogy^i+(1−yi)log(1−y^i)]

举例:如果模型预测“物流问题”的概率是0.8(y^i=0.8\hat{y}_i=0.8y^i=0.8),而真实标签是“物流问题”(yi=1y_i=1yi=1),则这一项的损失是 −1×log(0.8)≈0.223-1 \times \log(0.8) \approx 0.223−1×log(0.8)≈0.223;如果预测概率是0.3,损失是 −1×log(0.3)≈1.204-1 \times \log(0.3) \approx 1.204−1×log(0.3)≈1.204,说明模型犯错更严重。

优化目标(让损失最小)

通过梯度下降法更新参数 θ\thetaθ,使得 L(θ)L(\theta)L(θ) 最小:

θt+1=θt−η⋅∇L(θt) \theta_{t+1} = \theta_t - \eta \cdot \nabla L(\theta_t) θt+1=θt−η⋅∇L(θt)

其中 η\etaη 是学习率(控制每一步“迈多大步”),∇L(θt)\nabla L(\theta_t)∇L(θt) 是损失函数在 θt\theta_tθt 处的梯度(指示“往哪个方向走损失更小”)。

项目实战:智能医疗问诊助手开发全流程

开发环境搭建

- 硬件:AWS GPU实例(p3.2xlarge,含V100显卡)

- 软件:Python 3.9、PyTorch 2.0、Hugging Face Transformers、MLflow(模型管理)、PostgreSQL(数据存储)

源代码详细实现和代码解读

1. 数据层:构建医疗问诊语料库

# 从医院HIS系统抽取真实问诊对话(简化示例)

import pandas as pd

medical_data = pd.read_csv("medical_dialogues.csv")

print(medical_data.head())

# 输出:

# user_query doctor_response disease

# 0 咳嗽一周,有痰 可能是支气管炎 支气管炎

# 1 胸痛、出汗 建议立即做心电图 冠心病

2. 模型层:训练疾病预测模型

from sklearn.model_selection import train_test_split

from transformers import AutoModelForSequenceClassification, TrainingArguments, Trainer

# 划分训练集和测试集

train_texts, val_texts, train_labels, val_labels = train_test_split(

medical_data["user_query"], medical_data["disease"], test_size=0.2

)

# 加载预训练模型(中文用RoBERTa-wwm)

model_name = "hfl/chinese-roberta-wwm-ext"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForSequenceClassification.from_pretrained(model_name, num_labels=10) # 10种常见疾病

# 数据编码

def tokenize_function(examples):

return tokenizer(examples["text"], padding="max_length", truncation=True)

train_dataset = Dataset.from_dict({"text": train_texts, "label": train_labels}).map(tokenize_function)

val_dataset = Dataset.from_dict({"text": val_texts, "label": val_labels}).map(tokenize_function)

# 训练配置

training_args = TrainingArguments(

output_dir="./medical_model",

evaluation_strategy="epoch",

learning_rate=2e-5,

per_device_train_batch_size=16,

num_train_epochs=3,

)

trainer = Trainer(

model=model,

args=training_args,

train_dataset=train_dataset,

eval_dataset=val_dataset,

)

trainer.train() # 开始训练

3. 服务层:部署在线推理API

from fastapi import FastAPI

from pydantic import BaseModel

app = FastAPI()

# 加载训练好的模型

model = AutoModelForSequenceClassification.from_pretrained("./medical_model")

class UserQuery(BaseModel):

text: str

@app.post("/predict")

async def predict(query: UserQuery):

inputs = tokenizer(query.text, return_tensors="pt")

with torch.no_grad():

logits = model(**inputs).logits

predicted_class_id = logits.argmax().item()

disease = model.config.id2label[predicted_class_id] # 映射标签到疾病名

return {"disease": disease}

4. 反馈层:收集用户修正数据

# 用户反馈接口(医生确认/修正模型预测)

@app.post("/feedback")

async def collect_feedback(feedback: dict):

# feedback格式:{"text": "咳嗽一周", "predicted_disease": "支气管炎", "true_disease": "肺炎"}

# 将反馈数据写入数据库

db.execute("INSERT INTO feedback (text, predicted, true_label) VALUES (%s, %s, %s)",

(feedback["text"], feedback["predicted_disease"], feedback["true_disease"]))

return {"status": "success"}

代码解读与分析

- 数据层:从真实场景获取数据是AI原生应用的基础,医疗领域需注意隐私(用脱敏处理)。

- 模型层:使用预训练模型(如RoBERTa)能大幅降低训练成本,比从头训练的模型效果好30%以上(经验值)。

- 服务层:FastAPI提供高并发推理服务,延迟控制在200ms内(满足实时问诊需求)。

- 反馈层:医生修正数据是高质量的“教师信号”,比用户无监督反馈更能提升模型准确率(实验显示,每月1000条反馈可提升准确率5%)。

实际应用场景

AI原生应用已渗透到多个领域,以下是典型案例:

1. 医疗:AI辅助诊断

- 传统:医生手动查阅病历+经验判断。

- AI原生:患者描述症状→ 模型快速筛选可能疾病(准确率90%+)→ 医生聚焦疑难判断→ 诊断效率提升40%(梅奥诊所数据)。

2. 电商:个性化推荐

- 传统:基于“用户买过A→推荐A的同类”的规则推荐。

- AI原生:模型分析用户浏览轨迹、搜索词、甚至设备型号(iOS用户可能更愿买高价商品)→ 推荐转化率比传统高2-3倍(亚马逊实践)。

3. 教育:智能作业批改

- 传统:教师手动批改,仅能覆盖选择题。

- AI原生:NLP模型分析主观题答案(如“用‘因为…所以…’造句”)→ 自动评分+生成改进建议→ 教师工作量减少60%(网易有道数据)。

工具和资源推荐

1. 模型开发工具

- Hugging Face Transformers:一站式预训练模型库(支持1000+模型),降低90%模型开发门槛。

- LangChain:专为大语言模型设计的开发框架,支持“模型+工具+记忆”的复杂应用构建(如智能客服)。

2. 数据管理工具

- DVC(Data Version Control):管理数据版本,避免“训练用v3数据但忘记标注时间”的低级错误。

- Label Studio:可视化数据标注工具,支持文本、图像、视频等多模态标注(医疗领域常用)。

3. 模型部署与监控

- MLflow:跟踪模型训练指标(如准确率、损失值),对比不同版本模型效果。

- Prometheus+Grafana:监控模型推理延迟、QPS(每秒请求数),及时发现“模型突然变慢”的异常(可能因数据漂移导致)。

未来发展趋势与挑战

趋势1:多模态智能成为标配

未来AI原生应用将不再局限于文本,而是融合图像(如皮肤科AI看皮疹)、语音(智能车载助手)、视频(动作捕捉健身指导)等多模态数据。例如,小红书的“AI图文生成”功能,用户描述“夏日森系穿搭”,模型自动生成文字+图片+排版建议。

趋势2:边缘AI降低延迟与成本

5G+边缘计算普及后,部分模型推理将从云端移到终端(如手机、车载芯片)。例如,智能手表的“实时心率异常预警”模型,本地推理延迟<50ms,比上传云端快10倍,同时保护用户隐私。

挑战1:数据质量成为“卡脖子”问题

AI原生应用依赖“数据飞轮”,但低质量数据(如医疗领域的错误标注、电商的刷单数据)会导致“垃圾进,垃圾出”。据Gartner统计,60%的AI项目失败源于数据质量差。

挑战2:模型可解释性与伦理风险

医疗、金融等敏感领域需“模型说清楚为什么这么推荐”。例如,法官需要知道“AI量刑建议”的依据(是基于被告年龄?还是犯罪类型?),否则无法采纳。欧盟《AI法案》已要求高风险AI系统必须提供可解释性报告。

总结:学到了什么?

核心概念回顾

- AI原生应用:以模型为核心,通过“数据-模型-用户”闭环持续进化。

- 数据飞轮:用户行为反哺模型,形成“越用越好用”的正循环。

- 模型驱动:用机器学习模型替代传统硬编码逻辑,解决复杂场景问题。

概念关系回顾

数据飞轮是“燃料”,驱动模型持续优化;模型驱动是“引擎”,决定应用的智能水平;持续学习是“维护”,确保引擎不会因数据变化而失效。三者共同构成AI原生应用的“智能三角”。

思考题:动动小脑筋

- 如果你是一个外卖APP的产品经理,如何设计一个AI原生功能?(提示:可以从“用户下单→模型推荐→用户反馈→模型优化”的闭环思考)

- 传统应用(如Excel)如何“AI原生化”?尝试举一个具体功能例子(例如:“智能表格生成”模型,根据用户描述“做一个月度销售对比表”自动生成表格结构)。

附录:常见问题与解答

Q:AI原生应用需要从头训练模型吗?

A:不需要!90%的AI原生应用可以基于预训练模型(如GPT-4、BERT)微调,就像“买一辆组装好的自行车,再根据需求换车把和坐垫”,比从头造自行车快得多。

Q:小公司没有大量数据,能开发AI原生应用吗?

A:能!可以用“迁移学习”(用大公司公开的预训练模型)+“小数据增强”(如文本翻转、同义词替换)。例如,一家小电商公司可以用Hugging Face的电商领域预训练模型,再用自己的1000条用户评论微调,效果足够支撑个性化推荐。

扩展阅读 & 参考资料

- 《AI-Native Application Development》(O’Reilly,2023)

- Hugging Face官方文档(https://huggingface.co/docs)

- 梅奥诊所AI辅助诊断案例(https://www.mayoclinic.org/ai)

更多推荐

已为社区贡献65条内容

已为社区贡献65条内容

所有评论(0)