稳如泰山:在 MCP Server 中构建异步任务队列,优雅处理高并发 Embedding 索引任务

在高频率文件变动场景下,同步执行昂贵的嵌入(Embedding)计算会导致 CPU/GPU 负载瞬间过载。本文深度解析了如何利用 Python 的构建生产者-消费者模型,实现任务的削峰填谷。我们将展示如何设计带权重的任务队列、实现任务合并(Task Coalescing)以减少重复计算,并提供具备“优雅关闭”能力的 Worker 逻辑,确保 MCP Server 在支撑海量文档更新时依然保持毫秒级

⚙️ 稳如泰山:在 MCP Server 中构建异步任务队列,优雅处理高并发 Embedding 索引任务

📝 摘要 (Abstract)

在高频率文件变动场景下,同步执行昂贵的嵌入(Embedding)计算会导致 CPU/GPU 负载瞬间过载。本文深度解析了如何利用 Python 的 asyncio.Queue 构建生产者-消费者模型,实现任务的削峰填谷。我们将展示如何设计带权重的任务队列、实现任务合并(Task Coalescing)以减少重复计算,并提供具备“优雅关闭”能力的 Worker 逻辑,确保 MCP Server 在支撑海量文档更新时依然保持毫秒级的响应。

一、 为什么要引入队列?——从“暴力并发”到“有序执行” 🚀

1.1 显存容量的“天花板”

Embedding 模型(如 BGE-M3 或 Sentence-Transformers)在推理时需要占用显存。如果同时开启 50 个 Embedding 线程,会导致 CUDA Out of Memory (OOM) 错误。队列充当了缓冲器,确保同一时间只有固定数量(通常为 1 或 2)的任务在消耗硬件资源。

1.2 响应性能的“护城河”

MCP Server 的主线程(Stdio 读写)必须保持极高的响应优先级。如果主线程被阻塞在耗时的 Embedding 计算上,Host(如 Claude)会因为超时而断开连接。通过异步队列,我们将“耗时操作”从“通信循环”中剥离,实现了真正的非阻塞架构。

1.3 核心设计模式对比:

| 模式 | 实现逻辑 | 优点 | 缺点 |

|---|---|---|---|

| 立即触发 | 收到事件立刻 await |

实现简单,实时性最高 | 易崩溃,占用主线程 |

| 异步并推 | asyncio.create_task |

速度快,主线程不卡顿 | 无法限制并发数,易导致 OOM |

| 工作队列 | 生产者-消费者模式 | 负载稳定,硬件友好 | 有微秒级入队延迟 |

二 : 实战演练:实现带负载均衡的 MCP 任务队列 🛠️

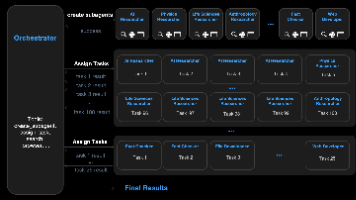

2.1 架构设计:生产者与消费者的解耦

- 生产者 (Producer): 监听

Watchdog文件事件,将其封装为任务对象入队。 - 消费者 (Worker): 后台常驻,按顺序从队列获取任务并执行真正的 Embedding 逻辑。

2.2 代码实现:带限流功能的 MCP Server

import asyncio

import os

from mcp.server import Server

import mcp.types as types

# 1. 定义任务消息结构

class EmbeddingTask:

def __init__(self, file_path: str, action: str):

self.file_path = file_path

self.action = action # 'update' or 'delete'

class TaskQueueManager:

"""任务队列管理核心"""

def __init__(self, concurrency=1):

self.queue = asyncio.Queue()

self.concurrency = concurrency

self._workers = []

self.pending_files = set() # 用于任务合并,防止同一文件重复入队

async def add_task(self, path: str, action: str):

"""生产者:将文件变动转化为任务"""

if path in self.pending_files:

return # 简单防抖:如果该文件已在排队,则跳过本次

self.pending_files.add(path)

await self.queue.put(EmbeddingTask(path, action))

async def start_workers(self, process_func):

"""启动后台消费者"""

for i in range(self.concurrency):

worker = asyncio.create_task(self._worker_loop(i, process_func))

self._workers.append(worker)

async def _worker_loop(self, worker_id, process_func):

print(f"Worker-{worker_id} 已就绪")

while True:

task = await self.queue.get()

try:

# 执行实际的 Embedding 与数据库写入逻辑

await process_func(task)

except Exception as e:

print(f"Worker-{worker_id} 处理失败: {e}")

finally:

self.pending_files.discard(task.file_path)

self.queue.task_done()

# --- 集成到 MCP Server ---

task_manager = TaskQueueManager(concurrency=1)

server = Server("queued-indexing-server")

async def process_embedding(task: EmbeddingTask):

"""模拟耗时的 Embedding 计算过程"""

print(f"正在处理: {task.file_path}...")

await asyncio.sleep(2) # 模拟硬件计算耗时

print(f"完成索引: {task.file_path}")

async def main():

# 启动后台 Worker

await task_manager.start_workers(process_embedding)

# 模拟 Watchdog 生产者(实际应由文件监听器调用)

# await task_manager.add_task("./docs/readme.md", "update")

async with stdio_server() as (read, write):

await server.run(read, write, server.create_initialization_options())

if __name__ == "__main__":

asyncio.run(main())

2.3 关键点:任务合并(Task Coalescing)

在代码中我引入了 pending_files 集合。这是一个非常实用的 “专业级小技巧”:当用户在编辑器中频繁按 Ctrl+S 时,文件系统会短时间内产生多个 on_modified 事件。通过在入队前检查文件是否已经在排队,我们可以有效合并重复任务,将计算压力降低数倍。

三 : 专家级架构思考:如何让队列具备“生产级”健壮性? 🧠

3.1 优先级队列(Priority Queue)

并非所有文件变动都同等重要。

- 优化策略:使用

asyncio.PriorityQueue。用户当前正在编辑的文件或较小的 Markdown 文档应赋予高优先级(立即更新),而大批量的历史日志导入则设为低优先级,利用 CPU 空闲时间慢慢处理。

3.2 任务持久化与“断点续传”

如果正在处理队列时 MCP Server 重启了,队列中的任务会全部丢失。

- 进阶方案:引入一个轻量级的 SQLite 表存储任务队列的状态(Pending/Processing/Done)。Server 启动时先扫描 SQLite,将未完成的任务重新入队。

3.3 反压(Backpressure)机制

如果入队速度远高于处理速度,内存中的 asyncio.Queue 会不断膨胀。

- 设计原则:为队列设置

maxsize。当队列满载时,生产者(File Watcher)应降低采样频率,或者向 Host 发送一个“系统忙”的Notification。这种机制能防止系统在极端压力下发生“雪崩”。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)