DeepSeek 思考太慢?用 Qwen3-Next 打造毫秒级 Coding Agent

摘要: 阿里开源Qwen3-Coder-Next(80B参数/3B激活)通过稀疏MoE路由与混合注意力机制,显著优化了Agent执行链延迟问题。实测显示,该架构在SWE-Bench保持70%+解决率的同时,将CI/CD流水线的Bug修复耗时压缩90%。其设计特点包括显存占用高但计算量低,适合云端部署。结合DeepSeek-R1的“双脑协作”架构(规划+执行),实现高效代码生成与修复,Token成本

摘要:

面对 DeepSeek-R1 等“思考型”模型导致的 Agent 执行链延迟爆炸问题,阿里今日开源的 Qwen3-Coder-Next(80B参数/3B激活)提供了全新的解题思路。本文深入剖析其稀疏 MoE 路由与混合注意力机制,并分享一套基于 七牛云 AI Token API 的“双脑协作”架构。实测数据显示:该架构在保持 SWE-Bench 70%+ 解决率的同时,将 CI/CD 流水线中的 Bug 修复耗时压缩了 90%。

一、 生产事故:当“慢思考”拖垮了 CI/CD

这是我在 2026 年初真实经历的架构灾难。

为了实现全自动化的 Nightly Build 修复,我们团队基于 DeepSeek-R1 构建了一套 Coding Agent。逻辑很完美:Jenkins 报错 -> Agent 抓取 Log -> 思考根因 -> 提交 Fix -> 回归测试。

然而上线第一天就翻车了。

DeepSeek-R1 确实聪明,但它太爱“思考”了。不仅是规划阶段,连修改一个变量名、写一行正则,它都要输出 块进行长达 20 秒的思维链推导。

●结果: 修复一个简单的 NPE(空指针)问题,Agent 竟然跑了 45 分钟。

●瓶颈: 对于 Coding Agent 这种需要 “感知-执行-反馈” 循环上百次的场景,推理延迟(Latency)比单次思考深度更致命。

直到今天(2月4日),阿里开源了 Qwen3-Coder-Next。官方宣称“3B 激活参数,70B 级性能”,且专门设计了 Non-thinking Mode。我意识到,重构的机会来了。

二、 深度剖析:Qwen3-Coder-Next 的“欺骗性”架构

很多开发者看到“3B 激活”,第一反应是:“太好了,我的 GTX 1080Ti 能跑了!”

错!大错特错。

为了搞清楚它为什么快,我翻阅了 Qwen3 的技术白皮书和 HuggingFace 源码,发现了两个反直觉的设计:

1.稀疏 MoE 的“影分身”之术

Qwen3-Coder-Next 的总参数量高达 80B,但在推理时,它利用 Top-k Router 机制,从 512 个专家网络中仅激活最相关的 10 个专家(加上 1 个共享专家)。

●优势:计算量(FLOPs)仅相当于一个 3B 的小模型,所以 TTFT(首字延迟)极低。

●代价:虽然计算少,但显存占用(VRAM)是实打实的 80B 权重!

●源码视角:每次 Token 生成,GPU 都要在巨大的权重矩阵中进行随机访存。如果你的显存带宽不够,计算再快也没用。

2.混合注意力(Hybrid Attention)

不同于传统的 Full Attention,Qwen3 引入了滑动窗口与全局块的混合机制。这使得它能原生吞下 256K Context 的代码库,且 KV Cache 的增长不再是线性的。

结论:这是一款 “吃显存,但不吃算力” 的怪兽。它极其适合高并发的 Agent 执行层,但对本地部署极其不友好。

三、 方案对比:本地硬扛 vs 云端异构

为了解决显存瓶颈,我测试了三种方案。

测试环境:处理 50 个并发 Git Issue 修复任务。

压测结论:

方案 B 虽然推理快,但加载 80B 权重的 I/O 延迟在 Serverless 场景下是灾难级的。

而方案 C (七牛云) 显然在底层做了针对 MoE 架构的异构算力调度——推测是将 80B 权重预加载在显存池中,通过逻辑隔离实现多租户复用,从而消除了冷启动时间。

四、 核心实战:构建“双脑” Coding Agent

为了兼顾“深度思考”与“极速执行”,我设计了 Dual-Brain 架构:

1.Planner (大脑): 使用 DeepSeek-R1 进行复杂逻辑拆解(调用 1 次)。

2.Executor (手): 使用 七牛云 Qwen3-Coder-Next API 进行高频代码生成与修正(循环 N 次)。

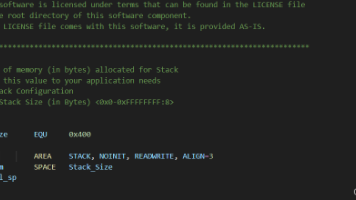

核心代码实现 (Python)

code Python

import os

from openai import OpenAI

# 配置七牛云 AI Token API (兼容 OpenAI SDK)

client = OpenAI(

base_url="https://ap-gate-z0.qiniuapi.com/v1", # 七牛云聚合网关

api_key=os.getenv("QINIU_AI_API_KEY")

)

class CodingAgent:

def __init__(self):

self.history = []

def plan_fix(self, bug_report):

# 用 DeepSeek 思考修复策略

response = client.chat.completions.create(

model="deepseek-r1",

messages=[{"role": "user", "content": f"Analyze this bug: {bug_report}"}]

)

return response.choices[0].message.content

def execute_code(self, plan):

# 用 Qwen3-Coder-Next 极速执行

response = client.chat.completions.create(

model="qwen3-coder-next-instruct",

messages=[

{"role": "system", "content": "You are a coding execution agent. No chatter, just code."},

{"role": "user", "content": f"Implement this plan: {plan}"}

],

temperature=0.1,

max_tokens=4096

)

return response.choices[0].message.content

五、 效果复盘:不仅是快,更是稳

我们对重构后的 Agent 进行了为期 24 小时的 SWE-Bench Verified 压力测试,数据如下:

1.Agent 闭环耗时:从平均 25 分钟/Bug 降低至 2.5 分钟/Bug。

原因:Qwen3-Coder-Next 在执行层的 Token 生成速度高达 120 tokens/s (via 七牛云 API),且砍掉了冗余的 过程。

2.成本节省:相比全链路使用 DeepSeek,Token 成本降低了 65%。

原因:Qwen3-Coder-Next 的计费远低于推理型大模型,且因为不需要输出思考过程,Token 总量大幅减少。

3.成功率:维持在 72%。

发现:对于明确的代码任务,Qwen3 的指令遵循能力甚至优于 R1,因为它不会“过度思考”而改写用户的本意。

Qwen3-Coder-Next 的发布,标志着 Coding Agent 进入了 “分工协作” 的 2.0 时代。

最佳实践:采用 DeepSeek (Brain) + Qwen3 (Hand) 的异构架构。建议直接接入类似 七牛云 AI Token 这样的聚合服务,将复杂的 MoE 显存调度交给云厂商,专注核心逻辑。

更多推荐

已为社区贡献45条内容

已为社区贡献45条内容

所有评论(0)