为什么显存总是不够:不是模型的问题

摘要: 大模型工程中,显存问题频繁出现,但根源往往不是模型本身过大,而是资源使用方式不当。显存紧张通常是系统设计问题的信号,而非单纯资源不足。常见误区包括:过度压榨显存、忽视非参数占用(如KV cache)、沿用训练期习惯、并行处理而非分阶段判断、用显存弥补设计缺陷。解决显存问题的关键在于优化系统架构,通过策略性判断和分阶段处理来减少资源浪费。显存报警应被视为改进系统设计的契机,而非单纯的技术障碍

显存是最先“抗议”的那一层

在所有大模型工程问题里,

显存问题出现得最早,也最频繁。

- batch 一调大,炸

- 序列一拉长,炸

- 多卡一并行,炸

- 微调一开始,炸

于是很多人会下意识得出一个结论:

“模型太大了。”

但如果你认真看过一些长期稳定运行的系统,会发现一个很反直觉的事实:

它们用的模型不一定更小,

但显存问题却很少成为“持续性困扰”。

这说明一件事:

显存不够,很少是模型尺寸本身的问题。

显存报错频率 vs 项目阶段示意图

先给一个总判断(很重要)

在正式展开之前,我先把这篇文章的核心判断写出来:

显存不够,通常不是“资源不足”,

而是“资源使用方式不匹配”。

更具体一点说:

- 你在用实验期的用法

- 承担工程期的负载

而显存,只是第一个站出来说“不行了”的组件。

第一层误解:把“显存”当成一种可以无限压榨的资源

很多人潜意识里,会把显存当成一种:

- 能靠技巧挤出来

- 能靠优化榨干

- 能靠经验“省下来”的资源

于是你会看到非常熟悉的操作:

- 再开 gradient checkpointing

- 再降 batch size

- 再关一些中间 tensor

- 再想办法“凑一凑”

这些操作在短期验证阶段完全合理,

但问题在于:

你不能指望一个长期系统,

一直运行在“极限挤压模式”。

显存持续紧张,往往不是技术能力问题,

而是系统在告诉你:

当前设计,本来就不该这么跑。

第二层误解:把“模型大小”当成唯一变量

当显存不够时,最常见的归因是:

“模型太大了。”

但如果你把显存占用拆开来看,会发现模型参数只是其中一部分。

在训练或推理中,显存通常被几类东西占用:

- 模型参数

- 梯度

- optimizer state

- activation

- KV cache

- 中间 buffer

而很多项目真正吃显存的,恰恰不是参数本身。

举个非常典型的例子:

# 一个看起来“很正常”的设置

batch_size = 8

seq_len = 4096

use_kv_cache = True

在这个配置下,

KV cache 的显存占用,可能已经远超模型参数本身。

但很多人并没有意识到这一点,

还在纠结:

“是不是该换个更小的模型?”

显存构成拆解图(参数 vs activation vs cache)

第三层问题:你在用“训练思维”跑“工程负载”

这是显存问题最常见、也最隐蔽的来源之一。

很多系统,在进入“准生产状态”后,

仍然保留着大量训练期的使用习惯:

- batch 偏大

- 序列偏长

- 中间状态全保留

- 评估时不开任何裁剪

这些习惯在训练时很自然,

但在工程里,它们往往意味着:

你在用显存换“便利性”,

而不是换“必要性”。

而工程系统,最忌讳的就是:

为了一点方便,把资源消耗推到不可控。

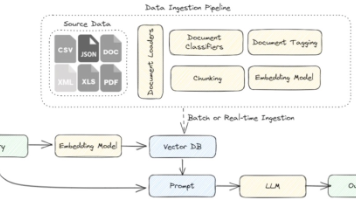

第四层问题:你在“并行堆能力”,而不是“串行做判断”

这是很多显存问题的结构性根源。

一个非常常见的系统形态是:

- RAG 一次拉很多 chunk

- 模型一次性看完

- 再在一次 forward 里做所有判断

从代码上看很干净,

但从显存角度看,这意味着:

你在让显存同时承载所有不确定性。

但事实上,很多判断是可以拆开的:

- 先判断“是否值得回答”

- 再决定“给模型多少上下文”

- 最后才是生成

当你不做这些判断,

而是一次性全塞给模型时,

显存自然会第一个爆。

并行堆能力 vs 串行做判断 对比示意图

第五层问题:你在用显存,弥补系统设计的空缺

这是一个非常真实、但不太愿意被承认的情况。

当系统缺乏:

- 清晰的拒答策略

- TopK 控制

- 上下文裁剪

- 分阶段推理

显存往往会被迫承担一个“兜底角色”:

“多给点上下文,总没错吧?”

但事实是:

- 显存不是智能

- 显存不会判断

- 显存只会被吃光

当你发现显存总是不够时,很可能是在用资源,

弥补本该由策略和判断解决的问题。

一个非常典型的“显存问题演化路径”

一开始:显存有点紧

↓

调参数 / 开优化

↓

又紧了

↓

换更大卡 / 多卡

↓

系统更复杂

↓

显存问题依然存在

注意:

这里没有一步是明显错误的。

但如果你回头看,会发现:

没有一步真正解决了“为什么要用这么多显存”。

为什么“显存不够”,往往是一个好信号

这听起来有点反直觉,但是真的。

在很多成熟项目里,

显存问题第一次出现时,

往往被当成一个结构性提醒。

它在提醒你:

- 系统是不是一次做了太多事

- 判断是不是太晚发生

- 模型是不是承担了不该承担的工作

当你把显存问题当成“报警”,

而不是“障碍”,

你反而更容易做出正确的工程决策。

一个非常实用的自检问题

当你准备继续“优化显存”之前,可以先问自己一句话:

如果显存突然翻倍,

这个系统的逻辑会因此变得更合理吗?

- 如果答案是否定的 → 问题不在显存

- 如果答案是肯定的 → 才值得继续优化

这个问题,能帮你避免大量无效优化。

很多团队在显存问题上反复“技术攻坚”,却始终绕不开根本原因:模型承担了太多本该由系统决策解决的事情。用LLaMA-Factory online把微调、推理配置和评估策略拆开观察,更容易看清:显存紧张到底是模型问题,还是系统设计在向你发出信号。

总结:显存不够,往往是系统在提醒你“该停一下了”

我用一句话,把这篇文章彻底收住:

显存不够,很少是因为模型太大,

更多时候,是因为你还没决定:

哪些事值得消耗资源,哪些不值得。

当你开始:

- 用判断替代堆资源

- 用策略替代一次性并行

- 用边界替代兜底

你会发现:

- 显存自然松了

- 系统反而更稳了

- 模型也更好用了

显存问题从来不是敌人,

它只是第一个站出来,

提醒你系统已经开始“勉强自己”的那一层。

更多推荐

已为社区贡献30条内容

已为社区贡献30条内容

所有评论(0)