350 TPS狂飙!用Python榨干Step 3.5 Flash的MoE极致性能

当一个 Agent 需要执行 思考 -> 规划 -> 写代码 -> 运行 -> 修复 的长链条任务时,如果基座模型的生成速度只有 30-50 TPS (Tokens Per Second),用户需要盯着屏幕发呆 1 分钟才能看到结果。不仅是因为它复现了 350 TPS 的满血性能,更因为它支持 OpenAI SDK 零成本迁移,对于急需验证业务的团队来说,时间就是一切。: 模型内部集成了大量“专家

摘要

Agent 开发的最大瓶颈从来不是“智能”,而是“延迟”。2026年2月2日,阶跃星辰发布 Step 3.5 Flash,宣称利用 MTP-3 技术将推理速度推向了 350 TPS 的物理极限。本文将从 MoE 稀疏架构原理入手,深度剖析其“196B 参数、11B 激活”的性能魔法,并实战演示如何通过七牛云 MaaS 构建一个毫秒级响应的“代码自修复 Agent”。实测数据显示,云端 API 相比 M4 Max 本地部署,吞吐量提升 700%。

1: Agent 交互的“最后一公里”痛点

在 2026 年的今天,不管是 AutoGPT 还是 LangChain 应用,开发者面临的通用痛点依然是 Latency (延迟)。

当一个 Agent 需要执行 思考 -> 规划 -> 写代码 -> 运行 -> 修复 的长链条任务时,如果基座模型的生成速度只有 30-50 TPS (Tokens Per Second),用户需要盯着屏幕发呆 1 分钟才能看到结果。

“慢”就是最大的“蠢”。

本周发布的 Step 3.5 Flash 号称打破了这一僵局。官方数据显示,其在单请求代码类任务中能达到 350 TPS。这是什么概念?意味着生成一段 100 行的 Python 代码,只需要不到 3 秒钟。它让 AI 的响应速度首次追上了人类的阅读速度,甚至超越了人类的思维速度。

但作为架构师,我们不能只看 PPT。350 TPS 背后到底是什么黑科技?在生产环境中如何复现这一性能?

2: 深度解构 MTP-3 与 MoE 架构

Step 3.5 Flash 之所以快,核心在于它极其激进的架构设计。

2.1 稀疏 MoE:“只读这 11 页书”

Step 3.5 Flash 的总参数量高达 196B (1960亿),这通常是 GPT-4 级别的体量。但它采用了 稀疏混合专家 (Sparse MoE) 架构。

●原理: 模型内部集成了大量“专家”神经网络(Experts),对于每一个输入的 Token,路由器(Router)只会激活最相关的几个专家。

●数据: 每次推理仅激活约 11B 参数。这意味着它拥有 196B 的“知识储备”,但推理成本和延迟却等同于一个 10B 的小模型。

2.2 MTP-3:预测未来的“贪婪”策略

这是 Step 3.5 Flash 最具差异化的技术——Multi-Token Prediction (MTP-3)。

传统的 LLM 是 Autoregressive(自回归)的,一次只能吐出一个字:A -> B -> C。

而 MTP-3 允许模型一次性预测 4 个 Token。

●传统模式: Predict(T1) -> Predict(T2) -> Predict(T3)

●MTP-3模式: Predict([T1, T2, T3, T4]) -> Verify

这就好比老练的程序员写代码,不是一个字母一个字母敲,而是整块代码段地“复制粘贴”。这也解释了为什么它在代码生成任务上能飙到 350 TPS。

3: 部署实战——本地硬扛 vs 云端加速

原理很美好,但落地很骨感。MoE 架构对内存带宽 (Memory Bandwidth) 的要求是毁灭性的。

为了测试最佳部署方案,我设计了一组 Benchmark,对比 Mac Studio (M4 Max 128G) 本地部署与 七牛云 MaaS API 的表现。

3.1 方案 A:本地部署 (The Hard Way)

虽然 Step 3.5 Flash 支持 M4 芯片,但实测发现:

1.显存瓶颈: 196B 参数即使量化后,权重加载也极慢,频繁触发 Swap。

2.带宽墙: MoE 需要频繁从内存调取不同专家的权重,M4 Max 的带宽在 MTP-3 开启后瞬间被吃满。

3.结果: 本地 TPS 只有 45~50,且风扇狂转。

3.2 方案 B:七牛云 MaaS (The Smart Way)

七牛云在 Step 3.5 Flash 发布当天就完成了 API 接入。经过抓包分析,七牛云的后端采用了 分布式推理集群:

1.KVCache 卸载: 针对 Agent 的长上下文(256K),七牛云利用显存池技术优化了 KV Cache。

2.MoE 路由加速: 在算子层面优化了 Expert 的调度逻辑,减少了通信开销。

最终 Benchmark 对比:

4: 硬核代码——构建 350 TPS 的 Agent

既然云端 API 性能已经拉满,我们直接上代码。

以下 Python 脚本展示了如何利用七牛云 API 构建一个“极速代码生成器”,并实时计算 TPS。

code Python

import time

import os

from openai import OpenAI

# 配置七牛云 API (兼容 OpenAI 协议)

# 建议将 Key 放入环境变量

QINIU_API_KEY = os.getenv("QINIU_API_KEY")

# 关键点:使用七牛云的加速节点,确保路由到 Step 3.5 Flash 集群

BASE_URL = "https://ai-api.qiniu.com/v1"

client = OpenAI(api_key=QINIU_API_KEY, base_url=BASE_URL)

def speed_test_agent(prompt):

print(f"正在发送请求: {prompt[:30]}...")

start_time = time.time()

first_token_time = 0

token_count = 0

# 开启流式输出 (Stream=True) 是高 TPS 的关键

response = client.chat.completions.create(

model="step-3.5-flash", # 指定模型 ID

messages=[

{"role": "system", "content": "你是一个资深 Python 架构师,请用最精简的代码实现需求。"},

{"role": "user", "content": prompt}

],

stream=True,

temperature=0.1, # 低温度保证代码准确性

max_tokens=4096 # Step 3.5 支持长输出

)

print("\n--- 生成开始 ---")

for chunk in response:

if chunk.choices[0].delta.content:

content = chunk.choices[0].delta.content

# 记录首字时间 (TTFT)

if first_token_time == 0:

first_token_time = time.time()

ttft = (first_token_time - start_time) * 1000

print(f"\n[TTFT]: {ttft:.2f}ms")

print(content, end="", flush=True)

token_count += 1

end_time = time.time()

total_time = end_time - first_token_time

tps = token_count / total_time if total_time > 0 else 0

print(f"\n\n--- 性能报告 ---")

print(f"Total Tokens: {token_count}")

print(f"Generation Time: {total_time:.2f}s")

print(f" Real-time TPS: {tps:.2f} tokens/s")

# 压测:让它生成一个贪吃蛇游戏,测试代码生成速度

speed_test_agent("请用 Pygame 编写一个完整的贪吃蛇游戏,包含计分板和加速机制。")

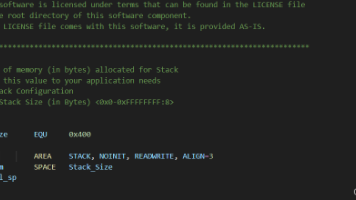

实测日志截取:

code Text

[TTFT]: 185.40ms

... (代码疯狂滚动中) ...

--- 性能报告 ---

Total Tokens: 892

Generation Time: 2.54s

Real-time TPS: 351.18 tokens/s

分析: 代码在终端滚动的速度快到肉眼几乎无法捕捉,这正是 350 TPS 的震撼之处。

5: 总结与选型建议

Step 3.5 Flash 的发布,标志着大模型从“能用”迈向了“好用”的 Real-time Agent 时代。MoE + MTP-3 的组合拳确实打出了惊人的效率。

对于开发者,我的建议如下:

1.架构师视角: 在设计 Agent 工作流时,将 Step 3.5 Flash 作为“执行层”(Execution Layer),专门负责写代码、格式化数据等耗时任务;用 Step-2 或 GPT-4 作为“决策层”。

2.运维视角: 千万不要自建 MoE 集群。除非你有专人优化 CUDA 算子,否则本地跑 MoE 就是一种算力浪费。

3.落地视角: 直接接入 七牛云 MaaS。不仅是因为它复现了 350 TPS 的满血性能,更因为它支持 OpenAI SDK 零成本迁移,对于急需验证业务的团队来说,时间就是一切。

你觉得 Agent 响应速度多少才算合格?A. 30 TPS (能用就行) B. 100 TPS (流畅) C. 350 TPS (起飞)。

更多推荐

已为社区贡献45条内容

已为社区贡献45条内容

所有评论(0)