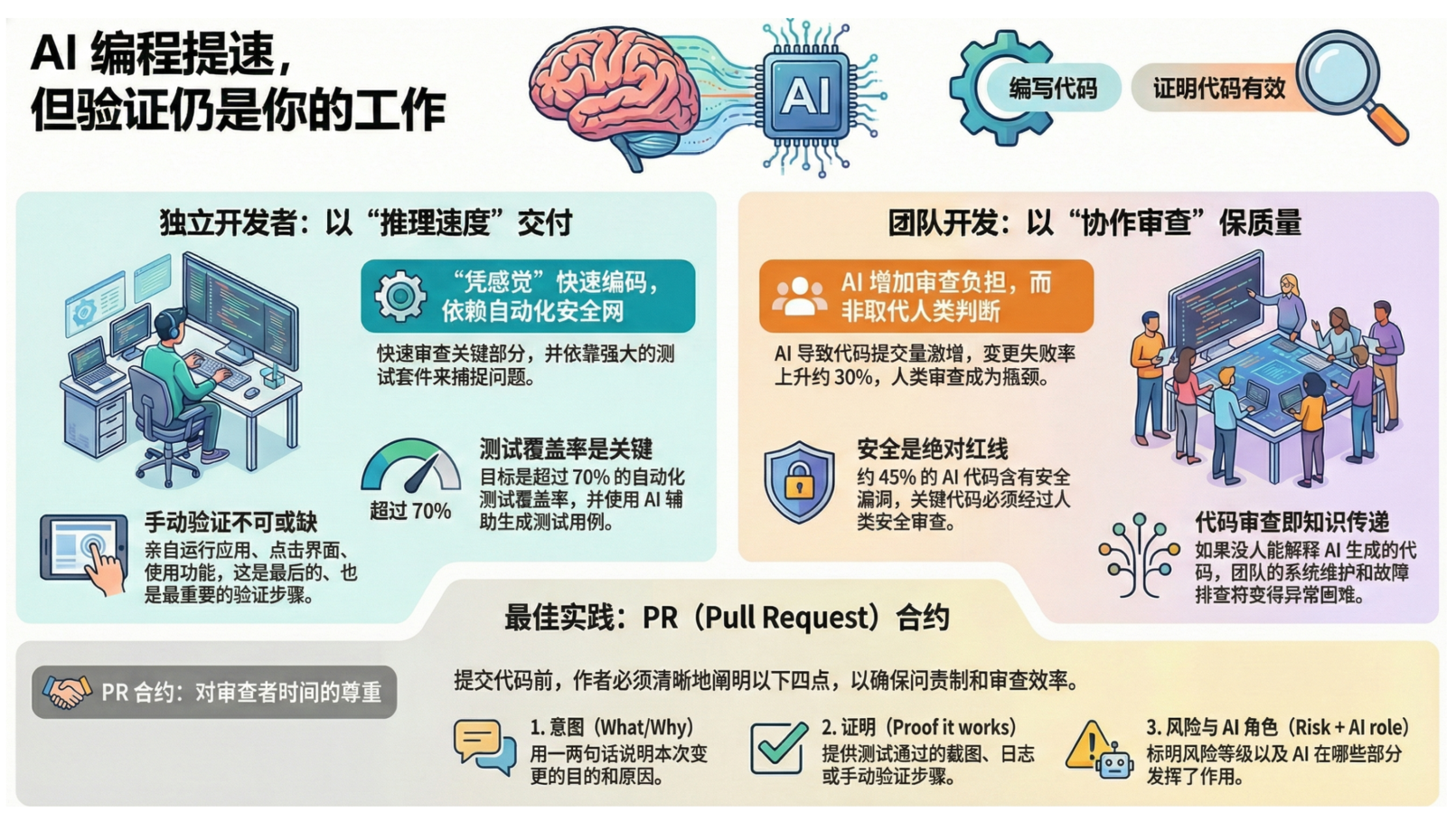

AI 把编码速度推向极限,但“举证责任”现在是你的了

当产出代码的速度超过了验证其质量的能力时,我们发布的将是更多的 Bug 和故障。明智的团队会强制推行增量开发,将庞大的 AI 输出分解为更小、可堆叠的拉取请求,确保审查工作切实可行,而不是被代码海啸淹没。但在这令人兴奋的效率背后,一个核心矛盾也浮出水面:尽管 AI 写代码的速度飞快,它却给我们带来了新的、更重要的负担——证明这些代码能够正常工作。AI 正在将代码审查从逐行检查的“守门员”角色,转变

推荐阅读

Superpowers框架实施指南:面向开发者的高效集成手册-CSDN博客

软件工程的十字路口:应对未来的五大关键问题与双重情景-CSDN博客

超越单一智能体:利用“开发者-审计者”对抗模式实现生产级代码质量-CSDN博客

Spec-Kit:以规范驱动,重塑高效软件开发流程-CSDN博客

什么是规范驱动开发 (SDD)?AI 时代的编程新范式-CSDN博客

目录

人工智能编码助手无疑点燃了开发的激情,带来了前所未有的速度。但在这令人兴奋的效率背后,一个核心矛盾也浮出水面:尽管 AI 写代码的速度飞快,它却给我们带来了新的、更重要的负担——证明这些代码能够正常工作。本文将揭示几个你可能没想到的、关于 AI 编程时代的惊人真相。

AI 并未终结代码审查,反而加重了举证责任

AI 擅长快速草拟功能,但在处理复杂的逻辑、安全性和边缘情况时常常出错。这使得开发者的工作重心发生了根本性的转变:从“编写代码”转移到了“证明代码有效”。如果你的拉取请求(Pull Request)里没有包含它能正常工作的证据,那你并没有真正提高效率,只是把问题推给了下游环节。

AI 并没有扼杀代码审查,它只是让举证责任变得更加明确。提交变更时,请附上证据,如手动验证记录和自动化测试结果,然后利用审查来评估风险、明确意图和落实责任。

你的 AI “队友”其实漏洞百出

依赖 AI 生成的代码,就如同与一个才华横溢但粗心大意的队友合作。数据显示,AI 生成代码的风险不容小觑。研究发现:

- 大约 45% 的 AI 生成代码包含安全漏洞。

- 逻辑错误的出现频率是人类编写代码的 1.75 倍。

- 跨站脚本(XSS)漏洞的出现频率更是高出 2.74 倍。

因此,我们必须建立一条明确的规则:当代码涉及身份验证、支付、密钥管理或处理不受信任的输入时,必须进行严格的人工威胁建模审查。在这种高风险场景下,要把 AI 当作一个速度极快的实习生——它的工作必须经过资深工程师的严格审查,而绝不能直接采纳。

警惕 AI 引发的“代码海啸”

AI 显著增加了代码的产出量,这也彻底改变了团队的动态。随着 AI 的普及,拉取请求(PR)的规模平均增大了约 18%。这不仅仅是让审查变慢的问题,它正在直接导致更严重的后果:每个 PR 的事故率上升了约 24%,变更失败率更是上升了约 30%。当产出代码的速度超过了验证其质量的能力时,我们发布的将是更多的 Bug 和故障。

正如 Graphite 公司的 Greg Foster 所言:

如果我们发布的的代码从未被任何一个同事真正阅读或理解过,我们将面临巨大的风险。

一个典型的例子是,OCaml 的维护者拒绝了一个包含 13,000 行 AI 生成代码的 PR。原因很简单:审查 AI 代码比审查人类编写的代码“更费力”。明智的团队会强制推行增量开发,将庞大的 AI 输出分解为更小、可堆叠的拉取请求,确保审查工作切实可行,而不是被代码海啸淹没。

两种截然不同的工作流:单兵作战 vs. 团队协作

独立开发者和团队在使用 AI 时的心态和方法论截然不同,形成了两种独特的工作模式。

- 孤狼开发者:依赖“感觉”和自动化 独立开发者倾向于快速交付功能,但他们看似惊人的速度有一个关键的先决条件:一个强大的自动化测试安全网。如果没有健全的测试实践,AI 带来的速度优势将荡然无存。正如开发者 Peter Steinberger 所承认的,他现在很少逐行阅读代码,而是观察其输出流并检查关键部分。对于他们而言,瓶颈不再是打字速度,而是等待 AI 生成结果的“推理时间”。

- 团队协作:审查即知识传递 在团队环境中,代码审查的意义远不止是发现错误。它是一种传递系统背景知识、建立共同责任感的核心机制。AI 无法理解路线图对齐和组织内部背景知识这类关键信息,而这恰恰是人类审查的价值所在。如果 AI 写了一段没人能解释清楚的代码,那么在凌晨两点处理线上紧急故障将成为一场噩梦。

新时代的新法则:“证据优于感觉”

为了应对 AI 带来的挑战,最成功的团队已经开始采用一种新的协作框架,可以称之为“PR 合同”。这份非正式的合同要求代码提交者提供清晰的证据,而不是含糊的承诺。其核心要素包括:

做什么/为什么:用一两句话清晰说明变更的意图。

工作正常的证明:提供测试通过的截图、手动验证的步骤或日志。

风险与 AI 角色:明确变更的风险等级(例如,支付功能为高风险),并说明哪些部分由 AI 生成。

审查重点:向审查者指出需要他们重点关注的一两个具体方面,如架构设计或业务逻辑。

这个框架的核心是责任。无论 AI 参与了多少,最终的责任人永远是人类。正如 IBM 的一句古老格言所说:

计算机永远无法承担责任。作为环路中的人类,这是你的工作。

结论:向前看,瓶颈已经转移

AI 正在将代码审查从逐行检查的“守门员”角色,转变为更高层次的质量控制过程,但人类的判断力仍然是保障安全和质量的关键环节。我们看到的是工作流程的演变,而不是终结。

最终,人类工程师的角色是利用 AI 加速流程,但绝不能放弃责任。在 AI 时代,最好的工程师会让 AI 处理机械性的工作,同时自己牢牢守住质量和责任的底线。

你准备好迎接这个从“编写代码”到“证明代码有效”的转变了吗?

作者:道一云低代码

作者想说:喜欢本文请点点关注~

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)