Java工程师如何转大模型开发

时间目标关键动作第1周跑通 Python + RAG Demo安装 Ollama + LangChain,实现本地问答第2周用 Spring AI 封装模型写一个/chat接口,返回流式响应第3-4周构建完整微服务架构拆分 rag-service、llm-service,加监控1-2月做一个作品集项目如“企业知识库助手”、“智能客服系统”3月+投简历,面试强调“工程落地能力”,而非算法理论✨最后忠

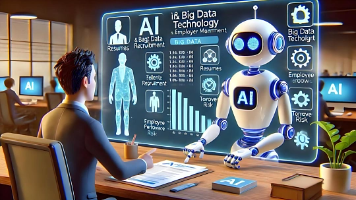

你的情况非常典型:有扎实的 Java + Spring 生态工程经验,想切入大模型赛道提升竞争力。好消息是——你不需要从零开始,也不必成为算法专家,而是走一条 “Java 工程师 → 大模型应用工程师” 的高效转型路径。

下面结合你的背景,给出清晰、可执行的学习路线:

✅ 一、先明确:你的优势和定位

🎯 你的核心优势:

- 熟悉 企业级架构(Spring Cloud)

- 掌握 高并发、分布式、微服务

- 有 工程化思维和 DevOps 经验

🎯 你应该瞄准的岗位:

大模型应用工程师 / AI 全栈工程师 / 智能系统后端开发

这类岗位的核心要求是:

- 能把大模型 集成到业务系统中

- 构建 RAG、Agent、对话流

- 做好 API 封装、性能优化、监控告警

- 不要求推导 Transformer,但要会用 LangChain + 向量库 + Prompt 工程

💡 参考资料 [2][3][5]:Java 工程师转型大模型,天然适合做工程落地,而非从头训练模型。

✅ 二、学习路径:分三阶段,聚焦“能用、能跑、能赚钱”

🔹 阶段 1:快速上手 Python + 大模型工具链(1~2 周)

目标:能调通 API、跑通 RAG Demo

| 学什么 | 为什么 | 学到什么程度 |

|---|---|---|

| Python 基础 | 大模型生态以 Python 为主 | 会写函数、读 JSON、用 requests 调 API 即可 |

| Hugging Face Transformers | 加载开源模型(如 Qwen、Llama) | 会 pipeline() 调用文本生成 |

| LangChain / LlamaIndex | 构建 RAG 和 Agent | 能搭一个“知识库问答”系统 |

| 向量数据库(Chroma/Pinecone) | 存储和检索语义向量 | 会 add_documents() 和 similarity_search() |

✅ 不用学:NumPy/Pandas 深度操作、机器学习数学、神经网络原理

示例任务(第1周完成):

# 用 LangChain + Chroma 实现本地知识库问答

from langchain_community.document_loaders import TextLoader

from langchain_text_splitters import CharacterTextSplitter

from langchain_chroma import Chroma

from langchain_huggingface import HuggingFaceEmbeddings

from langchain_core.runnables import RunnablePassthrough

loader = TextLoader("your_doc.txt")

docs = loader.load()

text_splitter = CharacterTextSplitter(chunk_size=500, chunk_overlap=50)

splits = text_splitter.split_documents(docs)

vectorstore = Chroma.from_documents(splits, HuggingFaceEmbeddings())

retriever = vectorstore.as_retriever()

# 接入你的 Java 后端(通过 FastAPI 或 gRPC)🔹 阶段 2:深度整合 Spring + 大模型(2~4 周)

目标:用 Java 生态构建生产级 AI 应用

表格

| 技术点 | 实践建议 |

|---|---|

| Spring AI(重点!) | 你已会 Spring,直接用 spring-ai 模块封装大模型调用→ 支持 OpenAI、Ollama、Qwen 等 |

| RAG 微服务化 | 用 Spring Cloud 拆分: - rag-service(处理检索)- llm-service(调用模型)- gateway(统一入口) |

| 异步 & 流式响应 | 用 WebFlux + SSE 实现“打字机效果” |

| Prompt 管理 | 把 prompt 模板存数据库,支持动态更新 |

示例代码(Spring AI + RAG):

@RestController

public class RagController {

@Autowired

private AiClient aiClient;

@PostMapping("/ask")

public String ask(@RequestBody QueryRequest request) {

// 1. 调用向量库(可封装为 Feign Client)

List<Document> docs = ragService.retrieve(request.getQuery());

// 2. 构建 prompt(含上下文)

String prompt = "基于以下信息回答问题:\n" +

String.join("\n", docs.stream().map(d -> d.getContent()).collect(Collectors.toList())) +

"\n问题:" + request.getQuery();

// 3. 调用大模型

return aiClient.generate(prompt);

}

}✅ 这就是企业真正需要的能力:把大模型变成可运维、可扩展的微服务

🔹 阶段 3:进阶能力(按需学习,1~2 个月)

目标:解决实际业务问题,提升薪资

| 方向 | 是否必须学 | 建议 |

|---|---|---|

| LoRA 微调 | ❌ 不必须 | 会用 peft 库跑脚本即可,无需理解低秩分解数学 |

| 模型部署(vLLM/TensorRT) | ⚠️ 了解即可 | 知道如何用 Docker 部署 Qwen,调优并发参数 |

| Agent 开发(ReAct/Plan-and-Execute) | ✅ 推荐 | 用 LangChain 构建能调用 API 的智能体 |

| 算法理论(反向传播等) | ❌ 不需要 | 除非你想转算法岗 |

💡 重点:学“怎么用”,而不是“为什么”。例如:

- 知道

temperature=0.7控制随机性 → ✅- 推导 softmax 梯度 → ❌

✅ 三、是否需要学算法?

直接回答:

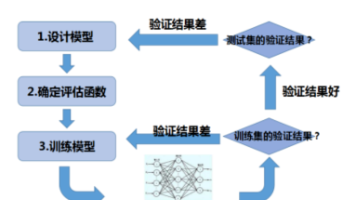

不需要系统学习传统机器学习算法(如 SVM、决策树),但必须理解大模型的基本工作原理。

你需要知道的“算法相关”知识(仅限应用层):

- Transformer 是什么?

- 知道它由 Encoder/Decoder 组成,Attention 让模型关注关键词

- 什么是 Embedding?

- 文本 → 向量,用于语义检索

- 什么是微调(Fine-tuning)?

- 在预训练模型上继续训练,适配你的数据

- 什么是 RAG?

- 检索外部知识 + 生成答案,避免幻觉

📌 这些内容看 吴恩达《Generative AI for Everyone》(2小时)就够了,不必啃《深度学习》花书。

✅ 四、推荐学习资源(精准匹配你的背景)

| 类型 | 推荐 |

|---|---|

| 入门课程 | 吴恩达《Generative AI for Everyone》(免费,2小时) |

| 实战教程 | LangChain 官方文档 + Spring AI 官方示例 |

| 开源项目 | GitHub 搜 “spring-ai-rag-demo”、“java-langchain-agent” |

| 避坑指南 | 参考资料 [2]:《Java程序员转型大模型开发:12步进阶实战指南》 |

💡 特别提醒:不要花几万买显卡!

如资料 [3] 所说:用阿里云/腾讯云租 GPU 服务器(每天几十元),本地只写代码。

✅ 五、总结:你的转型路线图

| 时间 | 目标 | 关键动作 |

|---|---|---|

| 第1周 | 跑通 Python + RAG Demo | 安装 Ollama + LangChain,实现本地问答 |

| 第2周 | 用 Spring AI 封装模型 | 写一个 /chat 接口,返回流式响应 |

| 第3-4周 | 构建完整微服务架构 | 拆分 rag-service、llm-service,加监控 |

| 1-2月 | 做一个作品集项目 | 如“企业知识库助手”、“智能客服系统” |

| 3月+ | 投简历,面试 | 强调“工程落地能力”,而非算法理论 |

✨ 最后忠告:

你最大的价值不是“会调模型”,而是“能把模型稳定、安全、高效地集成到企业系统中”。

这正是当前市场最缺的——懂大模型的 Java 架构师。

抓住这个机会,6 个月内你就能从“普通 Java 工程师”跃迁为“AI 应用架构师”,薪资翻倍不是梦。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)