收藏备用|程序员/小白转行大模型全攻略,从零入门不踩坑

大模型入门不难,难的是“坚持实操、不盲目跟风”。对于小白、程序员来说,核心路径是:定方向→打基础→学核心技术→做实操项目→借力开源→求职深耕。不用追求“一口吃成胖子”,每天进步一点,坚持6-12个月,就能成功转型大模型领域。对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(尤其是大模型方向)

对于想入局大模型领域的程序员、零基础小白来说,最头疼的莫过于“不知从何学起”“学了不会用”。本文整理了一份超详细的大模型转型指南,从方向选择到实践落地,从学习资源到职业规划,手把手帮你从零突破,快速跻身大模型赛道,建议收藏慢慢看、跟着练!

一、先定方向:避免盲目跟风,选对赛道少走弯路

转行大模型的第一步,不是急着学技术,而是明确自己的目标方向——大模型领域分支众多,不同方向的学习重点、职业路径差异很大,结合自身兴趣和基础选择,才能坚持走下去。核心方向分为4类,小白可优先从应用、开发入手,有基础的程序员可侧重工程或研究方向:

1. 大模型开发

核心是参与大模型的训练、微调和优化,是目前需求量最大的方向之一。适合有一定编程基础(比如会Python)、对模型底层逻辑感兴趣的程序员,入门可先从“预训练模型微调”入手,不用一开始就钻研千亿级模型训练。

2. 大模型应用

将大模型落地到具体业务场景,比如NLP(文本生成、情感分析)、CV(图像识别、图像生成)、智能办公等,门槛相对较低,是小白最易入门的赛道。适合擅长落地实践、喜欢结合业务解决问题的人,入门可先做简单的API调用、小场景应用开发。

3. 大模型研究

侧重大模型的理论研究,探索新的算法、架构和训练方法(比如优化Transformer架构、提升模型效率),门槛最高。适合数学基础扎实(线性代数、概率论功底强)、喜欢钻研学术、愿意长期深耕的人,入门需先吃透经典论文(如《Attention is All You Need》)。

4. 大模型工程

负责大模型的部署、运维、性能优化,解决“模型能跑起来、跑得稳、跑得块”的问题,适合有系统运维、工程化经验的程序员。入门可先学习Docker部署、GPU调度,掌握模型压缩、分布式训练的基础方法。

二、夯实基础:小白必学,程序员可查漏补缺

大模型不是“空中楼阁”,离不开编程、数学、机器学习三大基础,建议循序渐进学习,不用追求“一口吃成胖子”,重点是“理解+会用”,而非死记硬背。

(一)编程语言与工具:优先掌握这些,入门更高效

1. Python(必学)

大模型领域的“通用语言”,没有Python基础,几乎无法开展后续学习。小白重点掌握:基础语法(变量、循环、条件判断)、数据结构(列表、字典、集合)、函数定义与调用、模块和包的使用(如os、sys);有编程基础的程序员,可补充学习Python高级特性(装饰器、迭代器、生成器、多线程),这些在处理大规模数据、并行训练时会常用到。

小技巧:小白可先刷50道Python基础编程题(聚焦数据处理、循环判断),熟练后再接触大模型相关库,避免直接上手就卡壳。

2. 深度学习框架(优先学PyTorch)

大模型的“开发工具”,无需从零搭建模型,借助框架可快速实现模型的构建、训练和推理。优先学习PyTorch(研究、工业界都常用,语法更简洁,小白易上手),其次可了解TensorFlow(大厂部分业务会用到)。

入门重点:掌握模型结构定义(nn.Module)、数据加载(DataLoader)、优化器设置(Adam、SGD)、模型训练与评估的基本流程;进阶可学习自定义层、分布式训练,适配大模型训练需求。

3. 数据处理工具(必备)

大模型训练、微调离不开数据,这3个工具小白必须掌握,程序员可查漏补缺:

- Pandas:处理结构化数据(读取、清洗、转换、统计),比如清洗文本数据集、处理标签数据,入门可练“CSV文件读取与预处理”;

- NumPy:数值计算库,处理多维数组(大模型数据的核心格式),重点掌握数组运算、广播机制;

- Hugging Face:大模型入门“神器”,提供丰富的预训练模型(BERT、GPT等)和工具,可直接调用模型进行推理、微调,小白可先从“transformers库”入手,不用自己从零训练模型。

(二)数学基础:不用精通,但要理解核心概念

很多小白看到“数学”就退缩,其实大模型入门不需要精通所有数学知识,重点掌握以下核心内容,能理解模型原理、看懂公式即可:

- 线性代数:矩阵运算(加法、乘法、转置)、向量的点积/叉积、特征值分解,核心是理解“矩阵如何表示模型参数”“矩阵运算如何实现神经元输出”;

- 概率论与统计:概率分布(正态分布、均匀分布)、贝叶斯定理、最大似然估计,重点理解“随机梯度下降的随机性来源”“模型不确定性的描述方法”;

- 微积分:梯度、导数、链式法则,这是模型优化的核心,重点理解“梯度下降如何更新模型参数”“链式法则如何计算复合函数梯度”。

小技巧:小白可结合“可视化工具”学习数学(比如用NumPy实现矩阵运算,直观看到结果),不用死磕理论公式,重点是“知道怎么用、为什么能用”。

(三)机器学习基础:搭建大模型与基础技术的桥梁

大模型是深度学习的“升级版”,不懂机器学习基础,很难理解大模型的核心逻辑,建议小白先学基础,再攻大模型:

- 经典机器学习算法:重点学习线性回归、决策树、SVM,了解它们的核心思想(比如“线性回归如何拟合数据”“决策树如何分类”),不用深入推导,重点是理解“机器学习的基本流程——数据预处理→模型训练→评估调优”;

- 深度学习基础概念:掌握神经网络(神经元、隐藏层、输出层)、激活函数(ReLU、Sigmoid)、反向传播、损失函数(MSE、交叉熵),这些是理解Transformer架构、大模型训练的前提。

三、深入进阶:聚焦大模型核心技术,从入门到实操

夯实基础后,重点学习大模型的核心技术,这部分是“区分小白和入门者”的关键,建议结合实操练习,避免“只看不动手”。

(一)Transformer架构:大模型的“灵魂”,必须吃透

所有主流大模型(GPT、BERT、LLaMA等)的核心都是Transformer架构,摒弃了传统RNN、CNN的缺陷,采用自注意力机制,能更好地捕捉长距离依赖,也是并行计算的关键。

入门重点:不用深入推导所有公式,重点理解3个核心组件:

- 自注意力机制(Self-Attention):理解“模型如何关注输入序列中的关键信息”(比如处理文本时,模型如何关联上下文词汇);

- 多头注意力机制(Multi-Head Attention):为什么需要多个“头”?每个“头”的作用是什么(本质是从不同角度捕捉信息);

- 编码器(Encoder)与解码器(Decoder):BERT用编码器、GPT用解码器、T5用编码器-解码器,它们的区别的是什么,分别适用于哪些场景。

推荐资料:必读论文《Attention is All You Need》(可看中文翻译版,重点看实验部分和结论),搭配Hugging Face的Transformer源码解读(小白可先看简化版源码,不用啃完整项目)。

(二)预训练与微调:大模型落地的核心流程

大模型的训练的核心是“预训练+微调”,小白不用纠结“如何训练千亿级大模型”(需要海量数据和算力),重点掌握“如何利用预训练模型,通过微调适配具体场景”,这是工业界最常用的方式。

- 预训练:在大规模无监督数据上训练模型,让模型学习通用特征(比如文本的语义、图像的纹理),比如GPT在海量文本语料上预训练,BERT在海量双语语料上预训练。小白重点理解“预训练的目的”——减少后续微调的成本,让模型具备基础的理解和生成能力;

- 微调:在小规模任务数据上,对预训练模型进行进一步训练,让模型适配具体需求(比如用预训练BERT微调,实现文本情感分类;用GPT微调,实现专属文案生成)。小白入门可练“小数据集微调”(比如用1000条文本数据微调BERT),掌握微调的基本流程:加载预训练模型→准备任务数据→设置微调参数→训练评估→保存模型。

(三)大模型优化:解决“模型跑不动、跑不好”的问题

大模型的痛点是“参数量大、算力需求高”,优化技术是工程师、开发者必备技能,小白可先掌握基础优化方法,进阶再深入:

- 模型压缩:在不显著降低模型性能的前提下,减小模型体积、降低算力需求,常用3种方法:

- 知识蒸馏:将大模型(教师模型)的知识,迁移到小模型(学生模型),适合部署到移动端、边缘设备;

- 剪枝:删除模型中不重要的参数、连接,减少参数量(比如删除权重接近0的连接);

- 量化:将模型参数从高精度(float32)转换为低精度(int8),减少存储和计算开销,小白可先用Hugging Face的量化工具实操。

- 分布式训练:当单GPU无法满足训练需求时,将训练任务分配到多GPU、多节点,缩短训练时间。小白可先学习PyTorch Distributed的基础用法,用2个GPU实操简单模型的分布式训练,理解“数据并行”“模型并行”的区别。

(四)大模型应用:落地实操,积累项目经验

学习技术的最终目的是落地应用,小白可从3个热门场景入手,实操简单项目,积累经验(这些项目可直接放到GitHub,为后续求职加分):

- 自然语言处理(NLP):文本分类、情感分析、文本生成、问答系统,小白可先用BERT做IMDB电影评论情感分类,用GPT做简单的文案生成;

- 计算机视觉(CV):图像生成、目标检测,小白可先用GAN、扩散模型生成简单图像(比如MNIST手写数字生成),用YOLO做简单的目标检测(比如检测图片中的猫、狗);

- 多模态模型:融合文本、图像等数据,比如用CLIP实现“文本检索图像”,用DALL-E根据文本描述生成图像,小白可直接调用Hugging Face的多模态模型API,快速实现简单应用。

四、实操落地:从项目入手,拒绝“纸上谈兵”

对于程序员、小白来说,“实操”是最快的成长方式——光看教程、记笔记没用,只有亲手做项目,才能发现问题、解决问题,真正掌握技术。以下4个入门项目,从易到难,小白可循序渐进练习:

- 项目1:文本情感分类(入门级)

- 数据集:IMDB电影评论数据集(公开可下载);

- 技术栈:Python + PyTorch + Hugging Face Transformers;

- 目标:用预训练BERT微调,实现“正面评论/负面评论”二分类,准确率达到85%以上;

- 重点:练习数据预处理、模型加载、微调参数设置、模型评估。

- 项目2:简单机器翻译(进阶级)

- 数据集:WMT英汉平行语料库(简化版,适合小白);

- 技术栈:Python + PyTorch + Transformer架构;

- 目标:实现简单的英汉翻译(比如“Hello”翻译成“你好”);

- 重点:理解Transformer编码器-解码器架构,练习模型训练、推理的完整流程。

- 项目3:简单问答系统(进阶级)

- 数据集:SQuAD问答数据集(简化版);

- 技术栈:Python + PyTorch + BERT;

- 目标:输入问题,模型从给定文本中提取答案;

- 重点:练习模型微调、输入格式处理、答案提取逻辑。

- 项目4:图像生成(提升级)

- 数据集:CIFAR-10图像数据集;

- 技术栈:Python + PyTorch + 扩散模型;

- 目标:生成与CIFAR-10数据集中类似的图像(比如飞机、汽车);

- 重点:理解扩散模型的基本原理,练习模型训练、图像生成的实操。

小技巧:每个项目完成后,整理成技术博客(发布到CSDN),记录学习过程、遇到的问题及解决方案,既能巩固知识,又能积累个人品牌。

五、借力开源社区:快速提升,积累人脉

开源社区是大模型学习的“宝藏资源”,小白、程序员可通过开源社区,获取最新技术、学习优秀代码、结识同行,快速提升自己,推荐4个必关注的开源社区/项目:

- Hugging Face(小白首选):全球最大的大模型开源社区,提供丰富的预训练模型、工具库(Transformers、Datasets等),还有详细的入门教程和示例代码,小白可直接fork项目,修改代码实操,遇到问题可在社区提问;

- OpenAI:大模型领域的标杆,关注GPT系列、Sora等最新成果,可学习其开源的模型代码、技术文档,了解行业前沿动态;

- TensorFlow Model Garden:包含大量经典深度学习、大模型的参考实现(图像分类、目标检测等),适合有TensorFlow基础的程序员学习,借鉴工程化实现思路;

- PyTorch Lightning:简化PyTorch训练流程的工具,封装了训练循环、分布式训练等逻辑,让开发者更专注于模型设计,小白可用来快速搭建项目训练流程,提高开发效率。

参与方式:小白可先“读代码、抄代码、改代码”,熟悉项目结构;有基础后,可提交bug修复、补充文档,甚至贡献自己的小功能,积累开源经验。

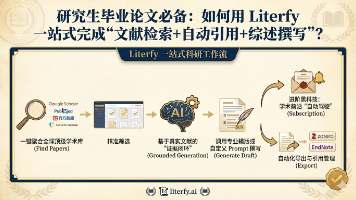

六、学习资源推荐:精选高效资源,拒绝无效内卷

整理了适合小白、程序员的学习资源,涵盖课程、书籍、论文、博客,不用到处找资源,跟着学即可,重点是“精读+实操”,而非贪多:

(一)在线课程(优先免费,小白友好)

- Coursera:Andrew Ng《深度学习专项课程》,经典中的经典,小白可先学“神经网络与深度学习”模块,理解深度学习基础;

- B站:李沐《动手学深度学习》,免费且实操性强,每节课都有代码示例,小白可跟着视频一步步敲代码,适合零基础;

- Udacity:深度学习纳米学位,实操项目丰富,有专人指导,适合想系统提升、愿意付费的学习者;

- Hugging Face Courses:免费的大模型入门课程,针对性强,重点讲解Transformers、微调、模型部署,小白必看。

(二)书籍(精读3本,胜过泛读10本)

- 《深度学习》(Ian Goodfellow 著):深度学习“圣经”,全面覆盖数学基础、算法模型,适合反复精读,理解底层原理;

- 《动手学深度学习》(李沐 著):小白实操指南,代码示例丰富,结合视频课程学习,效果更佳;

- 《大模型实战:技术、架构与案例》:聚焦大模型落地,包含大量实操案例,适合学完基础后,学习工程化落地思路。

(三)论文与博客(了解前沿,积累经验)

- 论文:arXiv平台(免费),重点关注大模型相关论文,小白可先看中文翻译版,重点看实验部分和结论,不用深入推导公式,推荐先读《Attention is All You Need》《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》;

- 博客:CSDN(同行经验多,适合小白参考)、Medium(海外技术博客,可看中文翻译)、Hugging Face Blog(大模型实操技巧多),重点关注“实操类”博客,避免只看理论。

七、职业发展建议:从入门到深耕,少走职业弯路

无论是小白转行,还是程序员转型,最终的目标都是“找到合适的工作、长期发展”,结合大模型行业特点,给出3条核心建议,适合所有想入局的人:

(一)构建个人品牌:让雇主看到你的能力

- GitHub:重点打造,将自己做的大模型项目(比如前面提到的4个入门项目)上传到GitHub,完善项目文档(说明项目目的、技术栈、实现思路、效果),定期更新,这是求职时最有说服力的“简历”;

- 技术博客:在CSDN、知乎等平台,定期分享学习心得、项目总结(比如“微调BERT遇到的5个坑及解决方案”),既能巩固知识,又能让同行、雇主看到你的能力;

- 技术会议/比赛:参加大模型相关的技术会议(比如中国人工智能大会)、比赛(比如Kaggle大模型相关竞赛),结识同行、专家,展示自己的项目,积累人脉和荣誉,为求职加分。

(二)寻找工作机会:结合自身基础,合理定位

- 大厂(Google、OpenAI、字节跳动、阿里、腾讯等):适合有一定基础(有项目经验、熟悉核心技术)的程序员,岗位多为大模型开发、工程、研究,福利好、资源多,可关注官网招聘信息,提前准备算法题、项目讲解;

- 初创公司:适合小白、转行新手,岗位多为大模型应用、基础开发,能接触到完整的业务流程,快速积累落地经验,晋升空间大,部分初创公司还会提供股权激励;

- 实习:如果是应届生、转行新手,优先找大模型相关实习,哪怕是基础的标注、数据处理、模型微调,也能快速了解行业、积累经验,为后续全职求职铺路。

(三)持续学习:跟上行业节奏,不被淘汰

大模型领域发展极快,新模型、新技术不断涌现(比如GPT-4、Sora、LLaMA系列),想要长期立足,必须保持持续学习的习惯:

- 关注行业动态:定期看开源社区、技术博客、论文,了解最新技术趋势;

- 深耕一个方向:不要“什么都学、什么都不精”,比如小白可先深耕“大模型应用”,有基础后再拓展到“模型优化”“工程部署”;

- 多和同行交流:加入大模型学习群、开源社区交流群,遇到问题及时请教,学习同行的经验,避免闭门造车。

八、常见问题解答:小白/程序员最关心的5个问题

1. 没有机器学习、编程基础,能转行大模型吗?

可以,但需要循序渐进,不能急于求成。建议先花1-2个月学习Python基础、简单的机器学习算法(线性回归、决策树),再学习深度学习基础,最后攻大模型核心技术。零基础转行通常需要6-12个月,只要坚持实操、持续学习,就能成功入门。

2. 转行大模型,需要多久才能找到工作?

因人而异,核心看“基础+项目经验”:

- 有编程、机器学习基础的程序员:3-6个月,重点补充大模型核心技术、做1-2个实操项目,即可投递简历;

- 零基础小白:6-12个月,先打基础,再做3-4个入门项目,积累经验后再投递,建议优先找实习,降低求职门槛。

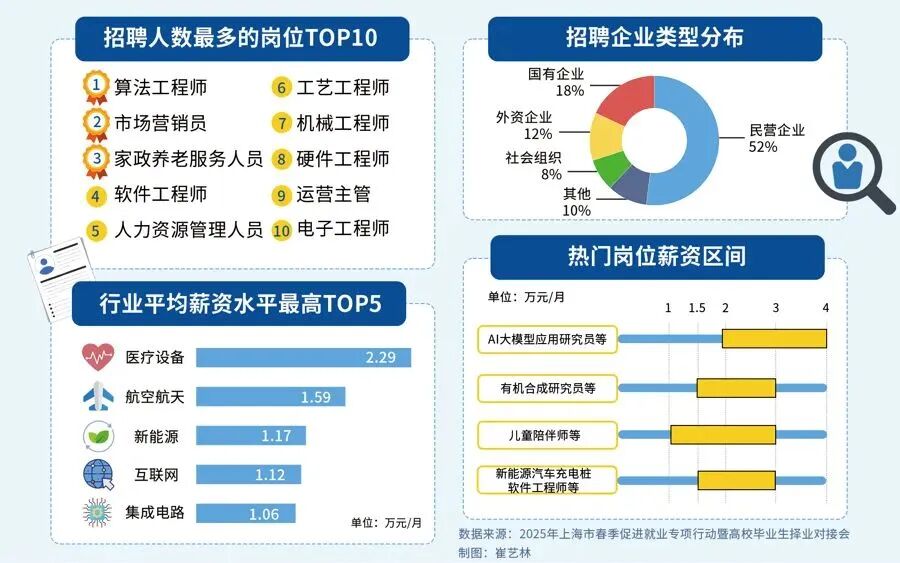

3. 大模型领域的职业前景如何?薪资水平怎么样?

职业前景广阔,是目前AI领域的热门赛道,需求持续增长——随着大模型在互联网、金融、医疗、教育等行业的落地,对大模型开发、应用、工程、研究类人才的需求越来越大。薪资水平高于普通程序员,应届生入门薪资通常在15k-30k/月,有1-2年项目经验的,薪资可达30k-50k/月,大厂、核心岗位薪资更高。

4. 学习大模型,需要准备高性能电脑吗?

入门阶段不需要,小白可先用CPU实操简单模型(比如微调小型BERT、简单文本分类),也可使用Colab(免费GPU)、Kaggle(免费GPU),满足入门实操需求;如果想深入学习模型训练、分布式训练,可准备一台带GPU(显存8G以上)的电脑,后续可根据需求升级。

5. 大模型和传统机器学习、深度学习,有什么区别?

核心区别是“参数量、泛化能力”:传统机器学习适合小数据集、简单任务(比如简单分类),参数量少;深度学习适合中大规模数据集、复杂任务(比如图像识别),参数量中等;大模型参数量极大(亿级、千亿级),泛化能力强,能处理更复杂的任务(比如多模态生成、复杂问答),且能通过微调适配多种场景,无需为每个任务从零训练模型。

最后总结

大模型入门不难,难的是“坚持实操、不盲目跟风”。对于小白、程序员来说,核心路径是:定方向→打基础→学核心技术→做实操项目→借力开源→求职深耕。不用追求“一口吃成胖子”,每天进步一点,坚持6-12个月,就能成功转型大模型领域。

建议收藏本文,跟着攻略一步步学习、实操,遇到问题及时复盘、调整,相信你一定能顺利入局大模型赛道,实现职业升级!

最后

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?

答案只有一个:人工智能(尤其是大模型方向)

当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应聘者,月基础工资也能稳定在4万元左右。

再看阿里、腾讯两大互联网大厂,非“人才计划”的AI相关岗位应聘者,月基础工资也约有3万元,远超其他行业同资历岗位的薪资水平,对于程序员、小白来说,无疑是绝佳的转型和提升赛道。

对于想入局大模型、抢占未来10年行业红利的程序员和小白来说,现在正是最好的学习时机:行业缺口大、大厂需求旺、薪资天花板高,只要找准学习方向,稳步提升技能,就能轻松摆脱“低薪困境”,抓住AI时代的职业机遇。

如果你还不知道从何开始,我自己整理一套全网最全最细的大模型零基础教程,我也是一路自学走过来的,很清楚小白前期学习的痛楚,你要是没有方向还没有好的资源,根本学不到东西!

下面是我整理的大模型学习资源,希望能帮到你。

👇👇扫码免费领取全部内容👇👇

最后

1、大模型学习路线

2、从0到进阶大模型学习视频教程

从入门到进阶这里都有,跟着老师学习事半功倍。

3、 入门必看大模型学习书籍&文档.pdf(书面上的技术书籍确实太多了,这些是我精选出来的,还有很多不在图里)

4、 AI大模型最新行业报告

2026最新行业报告,针对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

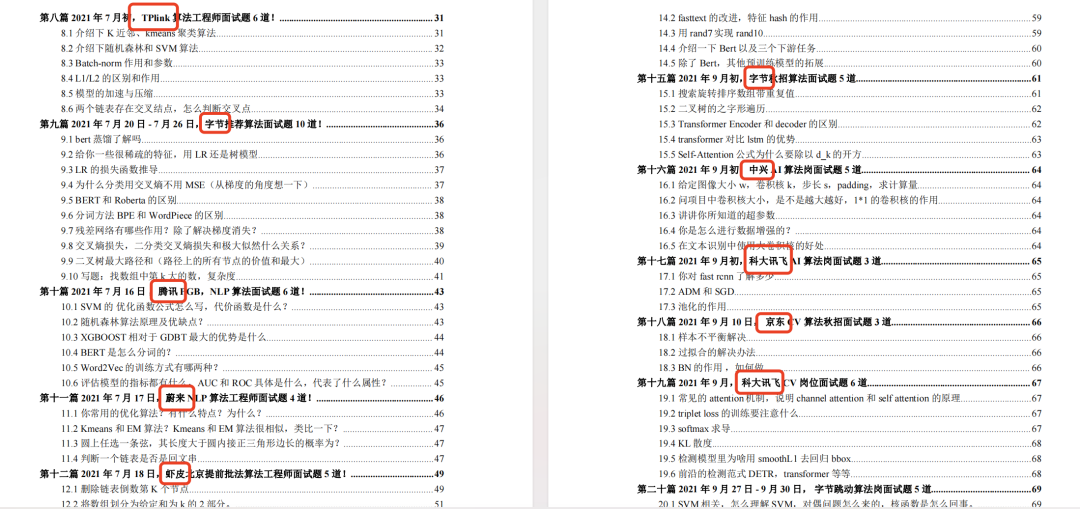

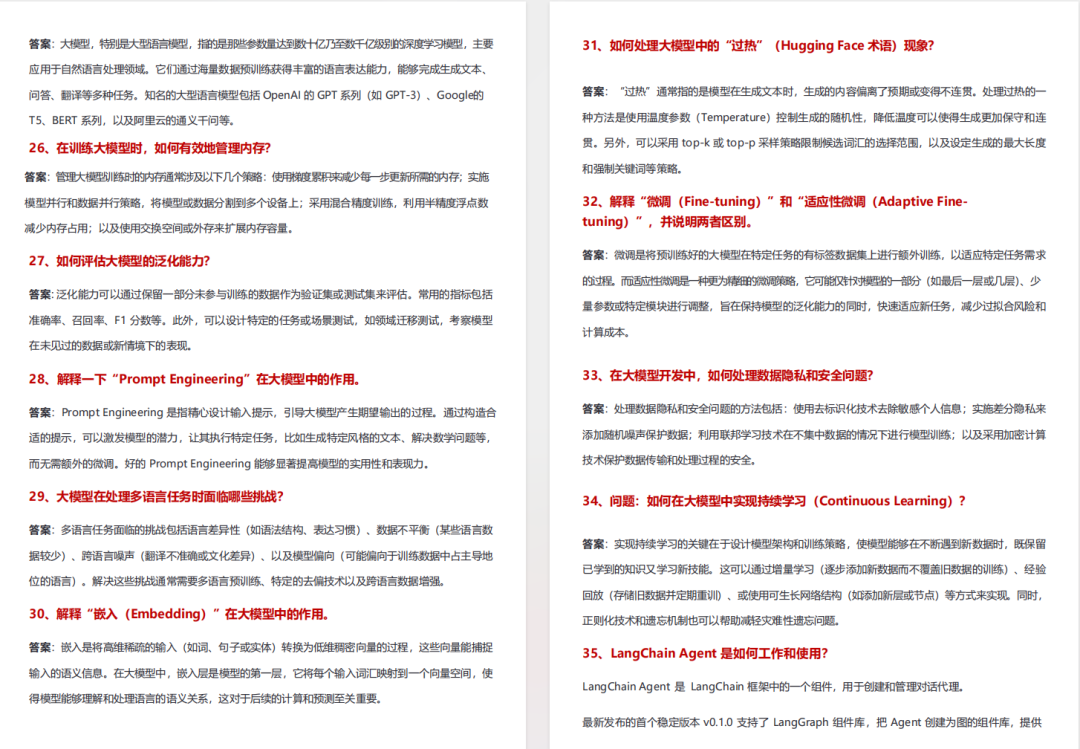

5、面试试题/经验

【大厂 AI 岗位面经分享(107 道)】

【AI 大模型面试真题(102 道)】

【LLMs 面试真题(97 道)】

6、大模型项目实战&配套源码

适用人群

四阶段学习规划(共90天,可落地执行)

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

-

硬件选型

-

带你了解全球大模型

-

使用国产大模型服务

-

搭建 OpenAI 代理

-

热身:基于阿里云 PAI 部署 Stable Diffusion

-

在本地计算机运行大模型

-

大模型的私有化部署

-

基于 vLLM 部署大模型

-

案例:如何优雅地在阿里云私有部署开源大模型

-

部署一套开源 LLM 项目

-

内容安全

-

互联网信息服务算法备案

-

…

👇👇扫码免费领取全部内容👇👇

3、这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献484条内容

已为社区贡献484条内容

所有评论(0)