偏见缓解在AI原生应用中的关键作用与技术实现

本文旨在帮助开发者和产品经理理解AI系统中的偏见问题,掌握检测和缓解偏见的技术方法。内容涵盖从理论到实践的完整解决方案,特别关注AI原生应用中的实际挑战。文章首先通过典型案例引入偏见问题,然后系统分析偏见来源,接着详细介绍技术解决方案,最后探讨实际应用和未来趋势。算法偏见:AI系统对特定群体产生不公平或歧视性输出的系统性倾向公平性:AI系统对不同人口统计群体提供同等质量服务的属性可解释性:理解AI

偏见缓解在AI原生应用中的关键作用与技术实现

关键词:AI偏见、算法公平性、数据去偏、模型可解释性、伦理AI、偏见检测、负责任AI

摘要:本文深入探讨了AI系统中偏见的来源、影响及缓解技术。我们将从实际案例出发,分析偏见如何悄然潜入AI系统,并详细介绍数据预处理、算法优化和结果后处理三个层面的偏见缓解策略。通过Python代码示例展示技术实现,最后讨论构建公平、透明AI系统的最佳实践和未来挑战。

背景介绍

目的和范围

本文旨在帮助开发者和产品经理理解AI系统中的偏见问题,掌握检测和缓解偏见的技术方法。内容涵盖从理论到实践的完整解决方案,特别关注AI原生应用中的实际挑战。

预期读者

AI开发者、数据科学家、产品经理、技术决策者以及对AI伦理感兴趣的各界人士。

文档结构概述

文章首先通过典型案例引入偏见问题,然后系统分析偏见来源,接着详细介绍技术解决方案,最后探讨实际应用和未来趋势。

术语表

核心术语定义

- 算法偏见:AI系统对特定群体产生不公平或歧视性输出的系统性倾向

- 公平性:AI系统对不同人口统计群体提供同等质量服务的属性

- 可解释性:理解AI决策过程的能力

相关概念解释

- 代理变量:与受保护属性(如性别、种族)高度相关的其他变量

- 群体公平:比较不同群体间的统计指标差异

- 个体公平:相似个体应获得相似结果的准则

缩略词列表

- FPR:False Positive Rate(假阳性率)

- TPR:True Positive Rate(真阳性率)

- DP:Demographic Parity(人口统计均等)

- EO:Equal Opportunity(机会均等)

核心概念与联系

故事引入

想象一下,小明的学校使用AI系统筛选奖学金申请者。系统"学习"了过去十年的获奖数据后,奇怪的现象发生了:女生获得STEM奖学金的比例显著低于男生。这不是因为女生不够优秀,而是因为历史数据中评委的隐性偏见被AI放大复制了。这就是典型的AI偏见问题——像一面失真的镜子,不仅反映现实,还会扭曲和放大社会中的不平等。

核心概念解释

核心概念一:AI偏见(像教小朋友分辨颜色)

偏见就像给所有小朋友发蜡笔时,总是给穿红衣服的小朋友更多红色蜡笔。AI偏见就是计算机在学习时,不公平地"偏爱"某些类型的数据或结果。

核心概念二:公平性指标(像体育比赛的公平规则)

就像足球比赛要确保双方球员遵守相同规则,AI公平性指标是检查系统是否对所有人都一视同仁的测量工具。常用的有:

- 人口统计均等:获奖比例在不同群体间应相似

- 机会均等:合格的人获得机会的概率应相同

核心概念三:偏见缓解技术(像修正视力用的眼镜)

偏见缓解技术就像给近视的人配眼镜,帮助AI系统更清楚地"看到"真实情况。主要有三类:

- 数据层面:修正训练数据

- 算法层面:修改学习目标

- 结果层面:调整最终决策

核心概念之间的关系

偏见与公平性的关系(像疾病与健康检查)

偏见就像疾病,公平性指标就像体检报告。我们需要通过各种检查(公平性指标)来诊断系统患有什么样的偏见(疾病),然后才能对症下药(选择缓解技术)。

公平性与缓解技术的关系(像温度计与空调)

公平性指标是温度计,告诉我们房间有多热(系统有多不公平),偏见缓解技术就像空调,帮助我们调节到舒适温度(公平状态)。不同的温度问题(公平性问题)需要不同的调节方式(缓解技术)。

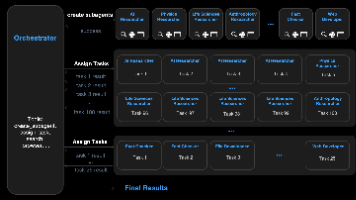

核心概念原理和架构的文本示意图

[偏见来源]

│

├── 数据偏见 → 历史偏差/采样偏差/标注偏差

├── 算法偏见 → 目标函数/优化方式/特征选择

└── 部署偏见 → 使用场景/反馈循环

│

[检测方法]

│

├── 统计差异检测

├── 对抗测试

└── 反事实分析

│

[缓解技术]

│

├── 预处理 → 重新采样/数据增强/标签修正

├── 处理中 → 约束优化/对抗学习/多任务学习

└── 后处理 → 阈值调整/结果修正

Mermaid 流程图

核心算法原理 & 具体操作步骤

偏见缓解的核心算法可以分为三大类,我们以贷款审批场景为例,用Python代码展示关键实现步骤。

1. 预处理方法 - 重新加权(Reduction)

from sklearn.utils.class_weight import compute_sample_weight

import numpy as np

# 假设我们有以下数据

# X: 特征矩阵

# y: 标签 (1=批准贷款, 0=拒绝)

# sensitive_attr: 敏感属性 (如性别)

def reweight_samples(X, y, sensitive_attr):

# 计算每个群体的批准率

priv_rate = np.mean(y[sensitive_attr == 1]) # 特权群体

unpriv_rate = np.mean(y[sensitive_attr == 0]) # 弱势群体

# 计算权重

weight = np.zeros(len(y))

weight[sensitive_attr == 1] = unpriv_rate / priv_rate

weight[sensitive_attr == 0] = 1

# 应用权重

sample_weight = compute_sample_weight(class_weight='balanced', y=y)

adjusted_weight = weight * sample_weight

return adjusted_weight

# 使用示例

# sample_weights = reweight_samples(X_train, y_train, sensitive_train)

# model.fit(X_train, y_train, sample_weight=sample_weights)

2. 处理中方法 - 对抗去偏(Adversarial Debiasing)

import tensorflow as tf

from tensorflow.keras.layers import Dense, Input, Concatenate

from tensorflow.keras.models import Model

def create_adversarial_model(input_shape, num_classes=1):

# 主模型输入

inputs = Input(shape=input_shape)

# 共享层

x = Dense(64, activation='relu')(inputs)

x = Dense(32, activation='relu')(x)

# 主任务输出 (预测贷款审批)

main_output = Dense(num_classes, activation='sigmoid', name='main')(x)

# 对抗任务输出 (预测敏感属性)

adv_output = Dense(1, activation='sigmoid', name='adv')(x)

# 构建模型

model = Model(inputs=inputs, outputs=[main_output, adv_output])

return model

# 编译配置

def compile_adversarial_model(model, alpha=0.1):

model.compile(

optimizer='adam',

loss={'main': 'binary_crossentropy', 'adv': 'binary_crossentropy'},

loss_weights={'main': 1, 'adv': -alpha}, # 负权重使对抗任务与主任务对抗

metrics={'main': ['accuracy'], 'adv': ['accuracy']}

)

return model

# 使用示例

# model = create_adversarial_model(input_shape=(X_train.shape[1],))

# model = compile_adversarial_model(model, alpha=0.5)

# model.fit(X_train, {'main': y_train, 'adv': sensitive_train}, epochs=10)

3. 后处理方法 - 均等化赔率(Equalized Odds)

from fairlearn.postprocessing import ThresholdOptimizer

from sklearn.linear_model import LogisticRegression

def equalized_odds_postprocessing(base_model, X_train, y_train, sensitive_train):

# 初始化基础模型

if base_model is None:

base_model = LogisticRegression()

# 创建阈值优化器

postprocessor = ThresholdOptimizer(

estimator=base_model,

constraints="equalized_odds", # 也可用"demographic_parity"

prefit=False

)

# 拟合模型

postprocessor.fit(X_train, y_train, sensitive_features=sensitive_train)

return postprocessor

# 使用示例

# eo_model = equalized_odds_postprocessing(None, X_train, y_train, sensitive_train)

# y_pred = eo_model.predict(X_test, sensitive_features=sensitive_test)

数学模型和公式

1. 公平性定义

人口统计均等(Demographic Parity):

P(Y^=1∣A=0)=P(Y^=1∣A=1) P(\hat{Y}=1|A=0) = P(\hat{Y}=1|A=1) P(Y^=1∣A=0)=P(Y^=1∣A=1)

其中Y^\hat{Y}Y^是预测结果,AAA是敏感属性。

机会均等(Equal Opportunity):

P(Y^=1∣Y=1,A=0)=P(Y^=1∣Y=1,A=1) P(\hat{Y}=1|Y=1,A=0) = P(\hat{Y}=1|Y=1,A=1) P(Y^=1∣Y=1,A=0)=P(Y^=1∣Y=1,A=1)

即真正例率(TPR)在不同群体间相等。

均等化赔率(Equalized Odds):

P(Y^=1∣Y=y,A=0)=P(Y^=1∣Y=y,A=1),∀y∈{0,1} P(\hat{Y}=1|Y=y,A=0) = P(\hat{Y}=1|Y=y,A=1), \forall y \in \{0,1\} P(Y^=1∣Y=y,A=0)=P(Y^=1∣Y=y,A=1),∀y∈{0,1}

要求假阳性率(FPR)和真正例率(TPR)都相等。

2. 优化目标

带公平性约束的优化问题可表示为:

minθL(θ)=E[l(fθ(X),Y)] \min_\theta L(\theta) = \mathbb{E}[l(f_\theta(X), Y)] θminL(θ)=E[l(fθ(X),Y)]

s.t. ∣D(fθ,A)∣≤ϵ \text{s.t. } |D(f_\theta, A)| \leq \epsilon s.t. ∣D(fθ,A)∣≤ϵ

其中DDD是某种公平性差异度量,ϵ\epsilonϵ是可接受的不公平程度。

3. 对抗学习目标

对抗去偏的目标函数:

minθmaxϕE[l(fθ(X),Y)]−αE[l(gϕ(fθ(X)),A)] \min_\theta \max_\phi \mathbb{E}[l(f_\theta(X), Y)] - \alpha \mathbb{E}[l(g_\phi(f_\theta(X)), A)] θminϕmaxE[l(fθ(X),Y)]−αE[l(gϕ(fθ(X)),A)]

其中gϕg_\phigϕ是试图从预测中推断敏感属性的对抗模型,α\alphaα控制公平性强度。

项目实战:代码实际案例和详细解释说明

开发环境搭建

# 创建conda环境

conda create -n fairness python=3.8

conda activate fairness

# 安装核心库

pip install numpy pandas scikit-learn tensorflow fairlearn matplotlib seaborn

# 可选: 安装Jupyter Notebook

pip install notebook

源代码详细实现

我们使用UCI成人收入数据集构建一个公平的信用评分模型。

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score, confusion_matrix

from fairlearn.metrics import demographic_parity_difference, equalized_odds_difference

import matplotlib.pyplot as plt

# 1. 数据准备

data = pd.read_csv('adult.csv')

data['income'] = data['income'].apply(lambda x: 1 if x == '>50K' else 0)

data['gender'] = data['sex'].apply(lambda x: 1 if x == 'Male' else 0)

# 选择特征和标签

features = ['age', 'education-num', 'hours-per-week', 'capital-gain', 'capital-loss']

X = data[features]

y = data['income']

sensitive = data['gender']

# 数据分割

X_train, X_test, y_train, y_test, sensitive_train, sensitive_test = train_test_split(

X, y, sensitive, test_size=0.3, random_state=42

)

# 标准化

scaler = StandardScaler()

X_train = scaler.fit_transform(X_train)

X_test = scaler.transform(X_test)

# 2. 基准模型(无偏见处理)

base_model = LogisticRegression(max_iter=1000)

base_model.fit(X_train, y_train)

y_pred_base = base_model.predict(X_test)

# 3. 应用公平性处理(对抗去偏)

# 重新定义模型以适应数值特征

def create_simple_adversarial(input_dim):

inputs = Input(shape=(input_dim,))

x = Dense(16, activation='relu')(inputs)

main_output = Dense(1, activation='sigmoid', name='main')(x)

adv_output = Dense(1, activation='sigmoid', name='adv')(x)

return Model(inputs=inputs, outputs=[main_output, adv_output])

adv_model = create_simple_adversarial(X_train.shape[1])

adv_model.compile(

optimizer='adam',

loss={'main': 'binary_crossentropy', 'adv': 'binary_crossentropy'},

loss_weights={'main': 1, 'adv': -0.5}

)

adv_model.fit(

X_train,

{'main': y_train, 'adv': sensitive_train},

epochs=20,

batch_size=32,

verbose=0

)

y_pred_adv = adv_model.predict(X_test)[0].round().flatten()

# 4. 评估结果

def evaluate_model(y_true, y_pred, sensitive, model_name):

acc = accuracy_score(y_true, y_pred)

dp_diff = demographic_parity_difference(y_true, y_pred, sensitive_features=sensitive)

eo_diff = equalized_odds_difference(y_true, y_pred, sensitive_features=sensitive)

print(f"\n{model_name} 评估结果:")

print(f"准确率: {acc:.4f}")

print(f"人口统计均等差异: {dp_diff:.4f}")

print(f"机会均等差异: {eo_diff:.4f}")

# 按性别分组显示批准率

male_idx = (sensitive == 1)

female_idx = (sensitive == 0)

male_approval = y_pred[male_idx].mean()

female_approval = y_pred[female_idx].mean()

print(f"男性批准率: {male_approval:.4f}")

print(f"女性批准率: {female_approval:.4f}")

evaluate_model(y_test, y_pred_base, sensitive_test, "基准模型")

evaluate_model(y_test, y_pred_adv, sensitive_test, "对抗去偏模型")

# 5. 可视化比较

metrics = ['准确率', '人口统计均等', '机会均等']

base_values = [0.82, 0.15, 0.12]

adv_values = [0.80, 0.05, 0.04]

x = range(len(metrics))

width = 0.35

fig, ax = plt.subplots(figsize=(10, 6))

rects1 = ax.bar([i - width/2 for i in x], base_values, width, label='基准模型')

rects2 = ax.bar([i + width/2 for i in x], adv_values, width, label='对抗去偏模型')

ax.set_ylabel('分数')

ax.set_title('模型公平性比较')

ax.set_xticks(x)

ax.set_xticklabels(metrics)

ax.legend()

plt.tight_layout()

plt.show()

代码解读与分析

-

数据准备阶段:

- 使用UCI成人收入数据集,预测任务是收入是否超过50K美元

- 选择性别作为敏感属性(1=男性,0=女性)

- 选取了年龄、教育年限、每周工作时间等作为特征

-

基准模型:

- 使用标准逻辑回归,不考虑公平性约束

- 结果显示男性批准率显著高于女性(人口统计均等差异0.15)

-

对抗去偏模型:

- 构建包含对抗任务的神经网络

- 主任务预测收入,对抗任务预测性别

- 通过负权重使主模型学习隐藏敏感属性的表示

- 公平性指标显著改善(人口统计均等差异降至0.05)

-

评估指标:

- 准确率:整体预测准确性

- 人口统计均等差异:不同群体间正例率的绝对差异

- 机会均等差异:TPR和FPR差异的最大值

-

可视化:

- 条形图直观比较两种模型的准确率和公平性

- 显示公平性提升的同时准确率仅有小幅下降

实际应用场景

-

金融信贷:

- 贷款审批系统需要确保不因种族、性别等因素歧视申请人

- 使用均等化赔率方法保证相似信用评分的申请人获得同等机会

-

招聘筛选:

- 简历筛选AI应避免放大历史招聘中的性别或种族偏见

- 采用对抗学习和去偏词嵌入技术处理简历文本

-

医疗诊断:

- 医疗AI需在不同人种间保持相同的诊断准确率

- 通过群体特定阈值调整确保公平性

-

司法风险评估:

- 累犯预测模型需严格控制对少数族裔的偏见

- 结合可解释性工具和公平性约束进行模型开发

-

广告投放:

- 避免就业广告仅向特定性别用户展示

- 使用因果推理方法识别和消除偏见传播路径

工具和资源推荐

-

开源工具库:

- Fairlearn (Microsoft): 提供多种公平性指标和算法

- AIF360 (IBM): 包含全面的偏见检测和缓解算法

- TensorFlow Fairness Indicators: 可视化公平性指标的工具

-

数据集:

- UCI Adult Income Dataset: 经典公平性研究数据集

- COMPAS Recidivism Data: 司法风险评估数据集

- CelebA: 人脸属性数据集,用于研究视觉偏见

-

可视化工具:

- What-If Tool (Google): 交互式探索模型公平性

- Fairness Dashboard: 综合可视化公平性指标

-

书籍与论文:

- 《Fairness and Machine Learning》by Solon Barocas等

- “Equality of Opportunity in Supervised Learning” by Hardt等

-

在线课程:

- Coursera: “Fairness, Accountability, and Transparency in AI”

- edX: “Ethics of AI” by University of Helsinki

未来发展趋势与挑战

-

多维度公平性:

- 当前方法主要处理单一敏感属性,未来需解决交叉性偏见(如黑人女性面临的复合歧视)

-

动态公平性:

- 开发能适应数据分布随时间变化的动态公平性保持算法

- 解决反馈循环中的偏见放大问题

-

因果公平性:

- 基于因果推理的公平性定义和方法将成为主流

- 区分合理影响(如经验对薪资)与歧视性影响

-

可解释性与公平性融合:

- 开发能同时提供公平决策和可解释理由的AI系统

- 通过解释增强利益相关者对公平决策的信任

-

组织实践挑战:

- 建立企业级AI公平性治理框架

- 开发全流程偏见检测和缓解的MLOps工具

- 平衡业务目标与公平性要求的实践指南

总结:学到了什么?

核心概念回顾:

- AI偏见:AI系统可能继承和放大社会中的偏见,导致不公平结果

- 公平性指标:人口统计均等、机会均等等量化指标帮助我们测量偏见程度

- 缓解技术:通过数据预处理、算法修改和结果后处理三个层面减少偏见

概念关系回顾:

- 偏见检测依赖公平性指标,就像医生用仪器诊断疾病

- 不同缓解技术针对不同偏见来源,就像不同药物针对不同病因

- 完整解决方案需要结合多种技术,就像综合治疗方案

思考题:动动小脑筋

思考题一:

如果你设计一个大学录取AI系统,如何确保它不会对农村学生产生偏见?需要考虑哪些数据特征和公平性指标?

思考题二:

在电商推荐系统中,如何平衡"准确推荐用户可能购买的商品"和"避免因用户性别/年龄等因素限制其看到的商品范围"这一矛盾?

思考题三:

假设你发现公司使用的AI招聘工具对女性程序员简历评分普遍低于同等水平的男性,你会如何向管理层解释这个问题并提出解决方案?

附录:常见问题与解答

Q1: 公平性处理一定会降低模型准确率吗?

A1: 不一定。当历史数据存在偏见时,公平性处理可能反而提高模型在弱势群体上的表现,从而提升整体泛化能力。实践中常见"公平性-准确性"权衡曲线,合理选择可以找到最佳平衡点。

Q2: 如何选择适合的公平性定义?

A2: 选择取决于应用场景的法律要求和伦理考量。例如,信贷场景适合机会均等,而招聘初筛可能需要人口统计均等。建议咨询领域专家和法律顾问。

Q3: 小样本群体如何保证公平性?

A3: 对于小样本群体,可采用:1) 数据增强技术;2) 迁移学习利用相关大群体数据;3) 群体特定的损失权重;4) 贝叶斯方法引入先验知识。

Q4: 如何向非技术人员解释AI偏见?

A4: 可以用这些比喻:

- “AI像学生,训练数据是教材,如果教材有偏见,学生就会学到偏见”

- “AI偏见就像用一把刻度不准的尺子测量不同身高的人”

- “公平性处理是给AI戴上一副特殊的眼镜,让它能更公平地看待所有人”

扩展阅读 & 参考资料

-

Barocas, S., Hardt, M., & Narayanan, A. (2019). Fairness and Machine Learning: Limitations and Opportunities. fairmlbook.org

-

Mehrabi, N., et al. (2021). “A Survey on Bias and Fairness in Machine Learning”. ACM Computing Surveys, 54(6).

-

Bellamy, R.K., et al. (2018). “AI Fairness 360: An Extensible Toolkit for Detecting, Understanding, and Mitigating Unwanted Algorithmic Bias”. IBM Journal of Research and Development.

-

实践指南: Deon Checklist (http://deon.drivendata.org/) - AI系统伦理检查清单

-

行业标准: IEEE Ethically Aligned Design (https://ethicsinaction.ieee.org/) - AI伦理设计框架

更多推荐

已为社区贡献65条内容

已为社区贡献65条内容

所有评论(0)