深度解析:AI与视觉技术在创意产业的范式转移与实操落地

在视觉技术演进的漫长岁月中,我们正经历着一场从“手工数字化”向“AI原生创作”的根本性变革。作为一名在视觉技术领域深耕15年的从业者,我见证了从最初的逐帧离线渲染到如今实时生成技术的跨越。传统的CG管线(Pipeline)正受到生成式AI(GenAI)与实时引擎的深度侵入,这种变革不仅是效率的提升,更是创作逻辑的重构。当前的行业节点可以定义为“算法驱动的实时创意时代”。生成式AI允许用户通过自然语

[TOC]

前言:从数字化到AI原生的范式转移

在视觉技术演进的漫长岁月中,我们正经历着一场从“手工数字化”向“AI原生创作”的根本性变革。作为一名在视觉技术领域深耕15年的从业者,我见证了从最初的逐帧离线渲染到如今实时生成技术的跨越。传统的CG管线(Pipeline)正受到生成式AI(GenAI)与实时引擎的深度侵入,这种变革不仅是效率的提升,更是创作逻辑的重构。

当前的行业节点可以定义为“算法驱动的实时创意时代”。生成式AI允许用户通过自然语言处理(NLP)来解释和反应标准人类语言,这极大地降低了技术门槛。本文将深入探讨AI在电影特效、广告创意及在线教育三大核心领域的具体应用,并提供可落地的技术方案、调试经验及硬件配置建议。

第一章:电影特效——实时引擎与多模态AI的底层重构

在传统电影工业中,特效制作往往意味着高昂的补拍成本与漫长的后期周期。随着Unreal Engine 5 (UE5) 提供的虚拟生产工具集为电影制作带来了前所未有的创意控制力,电影工业正在进入一个“算力即生产力”的时代。

1.1 ICVFX (In-Camera VFX) 深度实操手册

在《Fallout》等顶尖剧集的制作中,ICVFX 技术将后期前置化。以下是落地该技术的关键步骤:

实现步骤:

- 资产准备与优化:在UE5中使用Nanite和Lumen优化高模场景,确保在指定分辨率下达到稳定24fps/50fps。

- nDisplay 拓扑配置:在UE中创建nDisplay配置文件,定义LED墙的几何尺寸、分辨率及渲染节点(Primary/Display Nodes)的映射关系。

- 硬件级同步(Genlock):通过同步信号发生器将相机、渲染服务器和LED控制器锁定在同一时钟频率,防止画面撕裂。

- 相机追踪接入:集成Mo-Sys或Stype等硬件,将摄影机的位姿数据通过Live Link实时传入UE,驱动虚拟相机。

实战调试技巧与常见问题:

- 摩尔纹(Moiré Pattern)处理:当LED点距与相机感光元件发生干涉时产生。解决方案:微调相机焦距、增加背景景深,或微调相机与LED墙的物理距离。

- 延迟补偿(Latency Offset):物理相机移动与LED背景更新之间存在固有延迟。解决方案:在Live Link中设置负延迟补偿,通常在2-4帧之间进行微调。

硬件配置建议:

- 渲染节点:双路英伟达 RTX A6000 或 RTX 4090(具备Sync卡接口)。

- 网络:10GbE 交换机用于高速内网资产同步与控制信号传输。

1.2 NeRF与3D高斯泼溅:从照片到无限场景

3DGS允许我们通过数十张照片在几分钟内重建具有复杂半透明效果的工业级场景。

import torch

from gaussian_renderer import render

def init_gaussian_scene(point_cloud_path):

"""

初始化3D高斯泼溅场景,将稀疏点云转换为可渲染的高斯球

"""

# 1. 加载通过COLMAP生成的稀疏点云

xyz, rgb = load_ply(point_cloud_path)

# 2. 初始化高斯参数:位置、缩放、旋转、不透明度、球谐函数(SH)

gaussians = GaussianModel(sh_degree=3)

gaussians.create_from_pcd(xyz, rgb)

# 3. 优化迭代逻辑

optimizer = torch.optim.Adam(gaussians.parameters(), lr=1e-3)

for i in range(step_count):

loss = compute_loss(gaussians, target_images)

loss.backward()

optimizer.step()

if i % 500 == 0:

gaussians.densify_and_prune(max_grad, min_opacity)

return gaussians第二章:广告创意——扩散模型与精准控制的工业化工作流

广告行业追求极高的一致性与细节表现。Google的研究表明,AI自动化策略正在重新定义营销创意。

2.1 工业级 SKU 训练与生成管线

实现步骤:

- 高精度数据集预处理:收集100张以上SKU高清图,使用TagGUI进行多维度打标(Subject, Lighting, Angle, Material)。

- LoRA 训练配置:使用Kohya_ss,设置Network Rank为128以保留材质细节。核心参数:学习率1e-4, 开启BF16训练以平衡精度与速度。

- 多节点控制流(ComfyUI):

- 基础生成层:使用Checkpoint进行背景构图。

- 控制增强层:挂载两个ControlNet,一个用Depth图锁定产品空间位置,另一个用Canny图确保产品Logo不形变。

- 细部修复层:对产品主体应用Inpaint Mask,局部提高Denoising强度至0.55进行材质重绘。

实战调试技巧:

- 颜色偏移(Color Drift):生成的SKU颜色与真实产品不符。解决方案:在提示词中显式声明HEX色码,或在ComfyUI中使用IP-Adapter注入原始颜色参考图。

- 边缘锯齿:高分辨率导出时边缘出现伪影。解决方案:采用SUPIR或Ultimate SD Upscale节点进行分块放大,并配合Tile控制模型。

硬件配置建议:

- 显卡:首选 RTX 4090 (24GB VRAM),大显存是运行高分辨率修复(Hires. fix)和多ControlNet并行的门槛。

- 内存:建议 64GB DDR5,用于处理大规模图像预处理及显存交换。

2.2 技术实操:生产级自动化节点驱动

def generate_ad_batch(sku_id, bg_prompt):

"""

模拟ComfyUI API的高级调用,集成IP-Adapter与ControlNet

"""

workflow_payload = {

"client_id": "creative_studio_01",

"nodes": {

"IP_Adapter": {"weight": 0.8, "model": "ip-adapter-plus_sdxl_vit-h"},

"ControlNet_Canny": {"strength": 0.9, "image": f"sku_{sku_id}_outline.png"},

"Sampler": {"steps": 40, "cfg": 7.5, "denoise": 1.0}

}

}

# 性能优化:在Linux环境下通过xformers减少30%的推理时间

return call_comfy_backend(workflow_payload)第三章:在线教育——RAG知识库与情感AI的交互进化

在线教育正从“录播课”向“互动式AI课堂”转变。UNESCO调查显示,全球教育者正加速部署AI辅助教学系统。

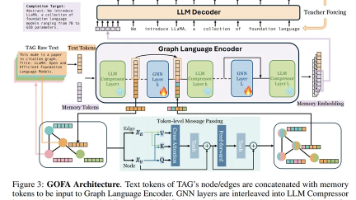

3.1 企业级 RAG(检索增强生成)架构实现

实现步骤:

- 数据层:多级索引策略:

- 使用语义分块(Semantic Chunking)将教材分为含义完整的逻辑段落。

- 通过

bge-reranker-v2-m3模型对检索回来的Top-10文档进行重排序(Rerank),确保最相关的知识点排在第一位。

- 逻辑层:幻觉抑制管线:

- 引入“引用溯源”机制,要求LLM在每个回答后标注参考的具体页码。

- 设置逻辑一致性检查节点,对比RAG原文与LLM生成结果的语义冲突。

- 表现层:低延迟语音合成(TTS):

- 集成ChatTTS或GPT-SoVITS实现具有呼吸声和情感起伏的教师音色。

实战调试技巧:

- 检索失效(No Hit):学生提问过于口语化导致无法匹配学术词汇。解决方案:在检索前增加Query Expansion步骤,利用LLM将口语提问改写为学术术语。

- Token 溢出:长课本检索出的背景信息过多。解决方案:采用滑动窗口上下文管理,或仅提取关键实体信息注入Prompt。

硬件配置与性能优化:

- 推理引擎:使用 vLLM 或 TensorRT-LLM 部署 Llama-3/Qwen2。

- 配置建议:单机 4x RTX 4090 或 A100 (80G)。开启 KV Cache 量化(INT8/FP8)可使并发处理能力提升2-3倍。

3.2 数字人驱动:基于 NVIDIA A2F 的实时交互

{

"rag_advanced_config": {

"embedding_model": "text-embedding-3-large",

"vector_db": "Milvus_Cluster",

"rerank_threshold": 0.72,

"inference_acceleration": {

"quantization": "AWQ",

"flash_attention": "v2",

"max_batch_size": 32

},

"digital_human": {

"driver": "Audio2Face_Live",

"latency_target": "<800ms",

"emotional_mapping": {

"confusion_detected": "soften_tone_and_slow_down",

"success_detected": "cheer_and_nod"

}

}

}

}结语:技术落地的路线图与未来展望

视觉技术正从单纯的“表现层”向“逻辑层”渗透。对于希望转型的团队,建议如下:

- 工具集成阶段:引入RTX 4090等高性能硬件,利用开源WebUI/ComfyUI快速验证创意。

- 管线自动化阶段:通过Python API封装工作流,建立基于私有LoRA的产品资产库。

- AI原生创作阶段:构建基于深度RAG、实时渲染引擎与情感AI的闭环交互系统。

AI不会取代创意,但那些能驾驭算法逻辑、编排自动化管线的创意人,必将在未来占据绝对优势。我们正站在新时代的起点,视觉技术的边界将由我们的想象力与算法的算力共同定义。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)