2026 年将引领潮流的 AI Agent 工作流模式

Agentic workflow 模式代表了我们设计与部署 AI 系统方式的根本转变。从一次性提示走向迭代、结构化的工作流,极大拓展了 AI Agents 的可靠能力边界。不再孤立生成答案,Agents 现在可以在问题展开过程中进行规划、行动、反思、协作与适应。Reflection pattern 通过自我审查与打磨提升质量。Tool use pattern 让 Agent 超越纯语言,连接真实系

gentic workflow 模式代表了我们设计与部署 AI 系统方式的根本转变。从一次性提示走向迭代、结构化的工作流,极大拓展了 AI Agents 的可靠能力边界。不再孤立生成答案,Agents 现在可以在问题展开过程中进行规划、行动、反思、协作与适应。

第一次使用大型语言模型时,很多人都觉得几乎是“魔法”。

你输入一个提示词。 它给出回应。 就这样结束了。

对于快速答疑、头脑风暴或生成一段文本,这种“一次性交互”足够好。问一个问题,得到一个回复,然后继续下一件事。简单、高效、令人满意。

但当我们开始要求 AI 去做_真正的工作_时,问题就暴露出来了。

让 AI 去分析市场趋势、交叉核对来源、综合洞见,并将这些内容转化为清晰、可执行的建议。你通常会得到听起来很聪明但让人感觉不完整的东西。模型没有机会暂停、收集更多上下文、质疑自己的假设,或根据刚刚学到的东西改进输出。

这并不是因为模型不够强大, 而是因为我们在让它用一口气把事情“想完”。

这正是agentic workflows改变一切的地方。(注:agentic workflows 在本文中不翻译,指赋予 AI 以计划、行动、反思与迭代能力的工作流。)

与其把 AI 当作一次性应答者,agentic workflows 将其变成一个能够计划、行动、反思并迭代的系统。它们允许模型使用 tool(工具)、回看之前步骤、调整策略,并逐步提升结果。这个转变细微却深刻——不再像对话机器人,而更像与一位会随着时间提出更好问题的初级分析师协作。

这差别就像草图与成画。二者都从一个想法开始,但只有一个会通过修改、反馈和意图而不断打磨。当可靠性、深度与信任重要时,迭代总是更胜一筹。

本文将探讨最重要的 agentic workflow 模式,它们为何成为现代 AI 系统的基石,以及它们如何塑造 2026 年真实产品的构建方式。

理解 Agentic Workflows

一个 agentic workflow 并不会只是等待指令然后直接产出。它拥有一定的自主性——决定_如何_处理任务、_接下来哪些步骤_最合理,以及_何时_根据沿途得到的信息调整策略。

这听起来似乎只是一个小差异,但它代表了我们设计和思考 AI 系统方式的根本转变。

为了更清楚地看到差异,想象你让一个基础聊天机器人帮你写研究报告。你给出一个提示,它一次性生成完整草稿,完全基于它已有的知识和最初的假设。结果也许看起来很体面,但它是静态的。一旦生成,就没有探索、验证或纠错的空间。

一个 agentic 系统会用非常不同的方式处理同一任务。

它可能先从外部来源收集最新信息。接着将这些发现聚类成主题,拟定报告结构,并逐段撰写。在此过程中,它会停下来评估某一段是否薄弱、模糊或不一致,进行修订,然后再继续。每一步都需要选择——使用什么 tool、哪些信息重要、又该根据实时发现去优化什么。

真正让这些工作流呈现“agentic”特质的是迭代与反馈回路的存在。

Agent 不再一次性生成输出,而是先行动,观察结果,并用这些观察来指导下一步。这更接近人类解决复杂问题的方式。我们通常并不会从一个完美的计划开始,而是先尝试、观察有效与否,然后不断调整。

Agentic workflows 将这种自适应、反思式的过程引入 AI 系统,让它们超越静态回应,走向更周到、更可靠的问题求解。

五大关键 Agentic Workflow 模式

既然我们已经理解什么是“真正的 agentic”工作流,接下来看看在实际系统中反复出现的这些模式。

它们不是抽象理论,而是团队们用来跨越“聪明的回答”,构建能够推理、适应、并随时间改进的 AI 系统的实用设计方法。

我们从最基础的开始。

Agentic Workflow Patterns(快速索引)

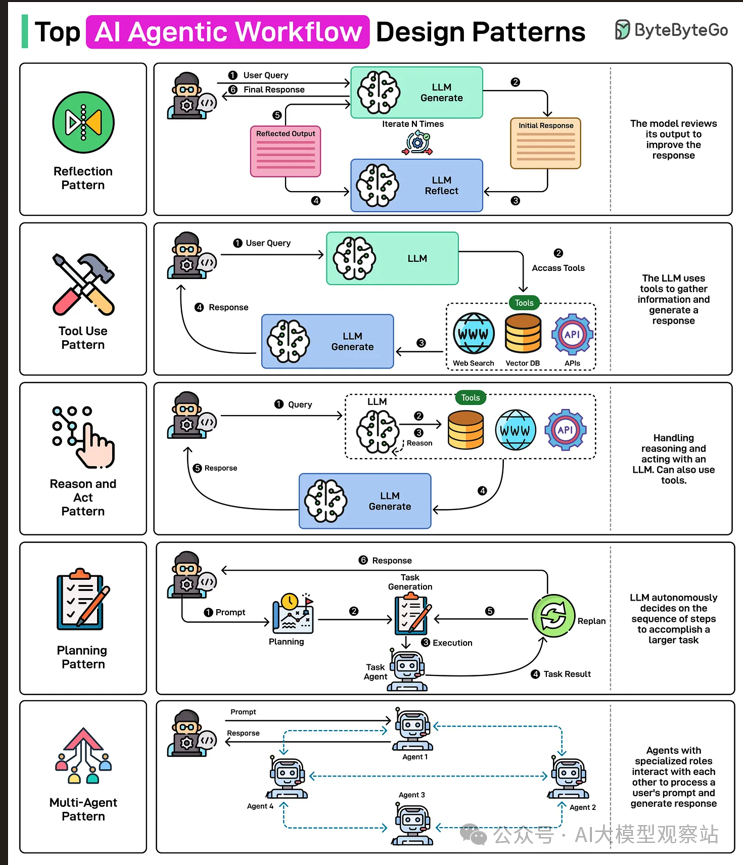

- Reflection Pattern - The Self-Improving Agent

- Tool Use Pattern - Extending Agents Beyond Language

- Reason and Act (ReAct) Pattern - Thinking While Doing

- Planning Pattern - Strategic Structure for Complex Tasks

- Multi-Agent Pattern - Collaboration Through Specialization

Reflection Pattern:自我改进的 Agent

从本质上说,reflection 就是赋予 Agent 在将任何东西视为“最终结果”之前,退一步评估自身工作的能力。

这个想法很简单,但对质量的提升却是倍增效应。

反思型 Agent 不会假设第一版就够好,而是会回看刚生成的内容,寻找薄弱或错误之处,然后据此修订。这引入了一条有意的打磨回路——持续捕捉错误、提升清晰度、强化最终结果。

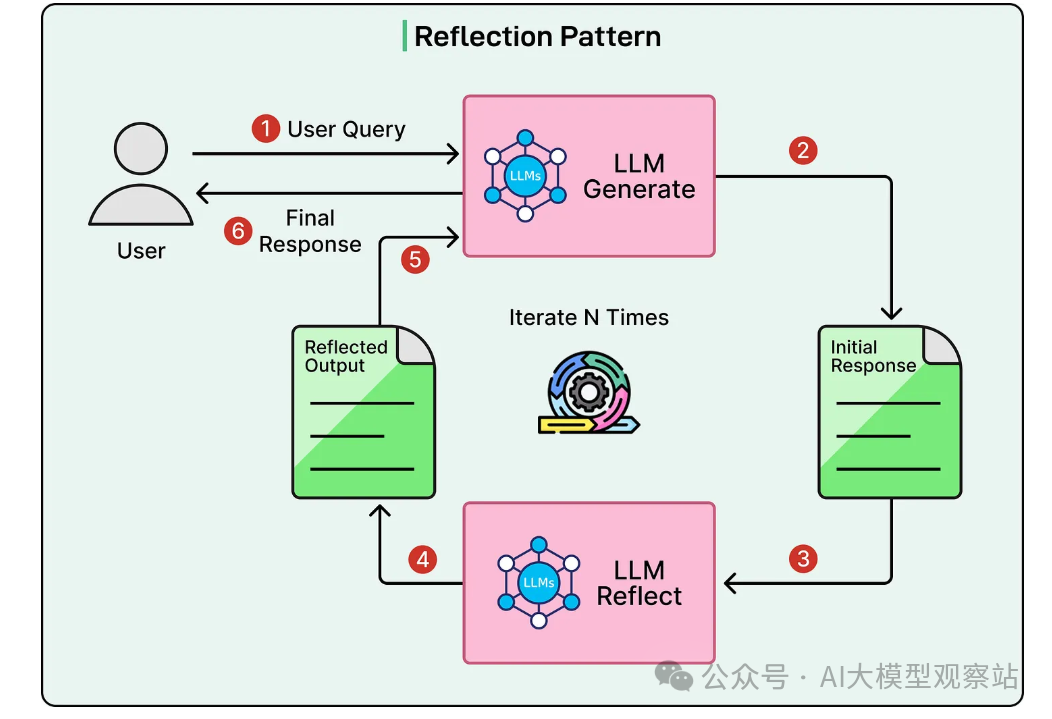

实践中,一个 reflection 循环通常是这样:

首先,Agent 根据收到的任务或提示生成初版输出。

接着,Agent 不会马上返回结果,而是切换到“批判”心态。它审视自己的工作,问自己:这说得通吗?有什么遗漏吗?是否存在不一致或薄弱的解释? 这里的目标不是完美,而是“觉察”。

随后,批判的结论成为修订的输入。

Agent 根据自己的反馈产出改进版,直接针对它识别的问题。在许多实现中,这个过程不止一轮。循环可能重复多次,每一轮都在增量提升输出。

这一模式的真正力量在于,它与人类思考的方式高度贴合。我们在写作、设计或分析重要内容时,很少第一遍就对。我们会回看、重想、再打磨。Reflection 将这种纪律带入 AI 工作流。

(参见下图,了解该循环的可视化分解。)

https://blog.bytebytego.com/p/top-ai-agentic-workflow-patterns

Reflection 模式的真正强项,在于 Agent 不仅仅“回看”,而是带着明确意图去回看。

反思不必是泛泛而谈。实践中,往往从特定角度逐一审视会更有效——一次专注一个质量维度。

例如,Agent 可以纯粹关注准确性,检查自己陈述的事实是否正确、是否最新、是否有充分支撑。这在研究密集或分析类任务中尤为重要,因为细小的不准确就会破坏信任。

在另一些情况下,反思关注清晰度。Agent 会审视自己的解释,判断对领域不熟悉的人是否真的能看懂。行业术语、隐含假设或结构混乱的观点常在此被揪出,并能在输出给读者之前修正。

创作任务也能获得不同的收益。在写故事、博客或营销文案时,反思可以聚焦语气与声线——这是否符合目标受众?会不会太正式、太随意或太普通?一次反思就能显著提升“人味儿”。

在代码生成中,反思则更技术化。Agent 可以自查代码中的明显 bug、安全风险、边界情况,或改进性能与可读性的机会。虽然它不能替代正式测试或人工审查,但常常能抓住一次性生成容易漏掉的问题。

当然,reflection 并非处处适用。

当质量重于速度、且任务包含需要判断与打磨的主观元素时,这一模式闪耀光芒。对于简单的事实性问题,或对速度极端敏感、达标即可的场景,它的价值就不高。

如同多数 agentic 模式,reflection 的力量不在复杂,而在“用得其所”。

Tool Use Pattern:让 Agent 超越自身知识

Tool use 模式标志着 AI Agent 现实可为范围的重大转折。

单独来看,即便最先进的语言模型也有根本限制。它基于训练中学到的模式进行推理,并从内部知识生成文本。它不知道昨天发生了什么。它无法可靠地处理大规模计算。它不能从数据库中拉取记录,或与外部世界交互。

Tool 打破了这道边界。(注:下文保留 tool/tool use 为英文术语,首次处提供中文解释。)

当我们将 tool use 引入 agentic workflow,我们不再要求模型去_假装_它无所不知。相反,我们赋予它外伸的能力——在需要时获取最新信息、运行计算、查询系统,并在真实数据上行动。

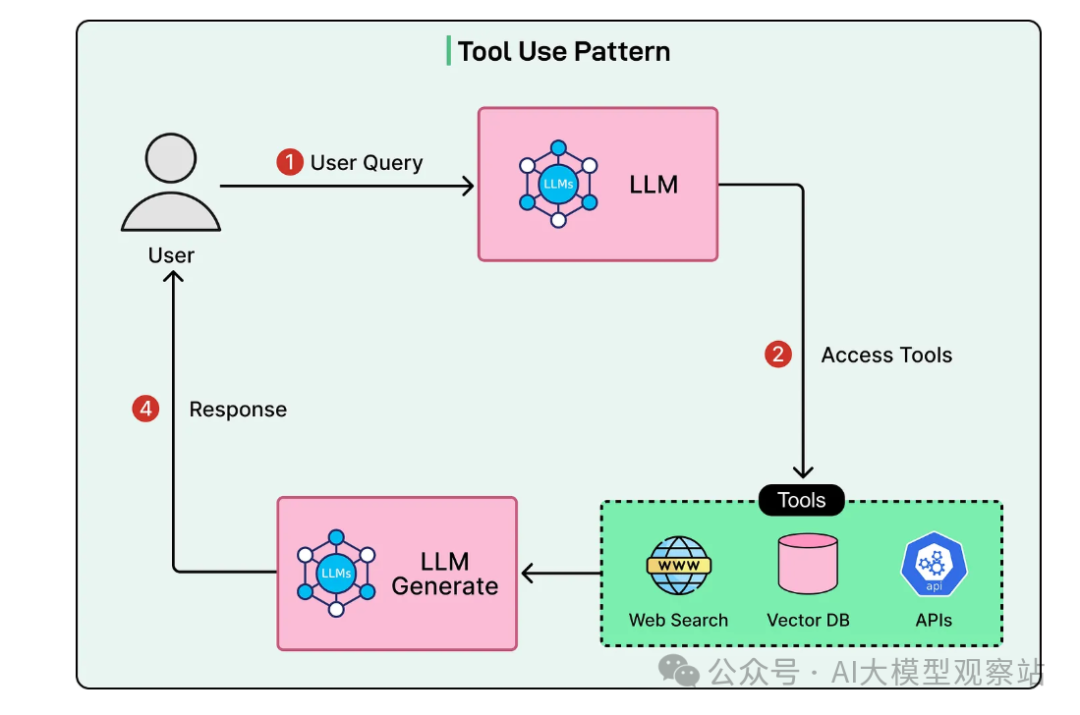

在这个模式里,Agent 被配置了一组可动态调用的 tools:比如用于最新信息的网页搜索、天气或市场数据等服务的 API、用于运行程序与精确计算的代码执行环境、用于检索特定记录的数据库查询 tool,或用于读写文档的文件系统访问。实际中,随着系统专业化,这个清单会很快扩展。

真正让这一模式具备 agentic 特性的并不是 tools 本身,而是谁来决定何时使用它们。

与传统软件中由开发者硬编码 tool 使用不同,agentic 系统会根据当前任务自主决定_何时_需要某个 tool,以及_如何_使用。如果 Agent 发现缺少信息,它会搜索;如果某个计算不宜“心算”,它会跑代码;如果决策依赖外部数据,它会调用对应 API。

这种自主性,正是把语言模型从静态应答者转变为主动问题求解者的关键。

不再强行让一切通过文本生成来完成,具备 tool 能力的 Agent 学会将推理与行动相结合——跨越“智能”与“执行”之间的鸿沟。

(参见下图,了解 tool 调用如何嵌入 Agent 循环的可视化概览。)

https://blog.bytebytego.com/p/top-ai-agentic-workflow-patterns

当 Agent 接到任务,它的第一步不是生成答案,而是判断完成任务所需条件。

有时 Agent 会意识到信息不足。在这种情况下,它会求助于搜索或数据检索 tool,而不是凭空猜测。如果任务涉及计算或数据处理,它可能会选择运行代码或使用计算器,而不是通过文本推理。如果任务需要与外部系统交互——例如获取价格、触发工作流或更新记录——Agent 会选择相应的 API,并通过该接口操作。

这一模式的力量还在于,tool 的使用不是静态的一次性动作,而是动态且可组合的。

Agent 可以将多个 tool 调用串联起来,用前一步的输出指导下一步。一次搜索结果可能引出一次数据库查询,随后进入一次计算,最终共同塑造呈现给用户的回应。每个动作都基于上下文选择,并随 Agent 的实时认知不断调整。

同样重要的是,Agent 不会被锁死在预定义脚本里。

如果搜索返回的信息贫弱或不完整,Agent 可以重构查询再试;如果某个 API 调用失败或返回异常错误,它可以更换策略——用不同参数重试,或直接选择替代 tool。正是这种实时适应能力,让具备 tool 的 Agent 与传统自动化截然不同。

你得到的,不再是脆弱、线性的流程,而是能自我恢复、探索与调整的系统——在混乱的真实世界环境中更具韧性与能力。

Reason and Act 模式(ReAct)

Reason and Act(简称 ReAct)模式,捕捉了更贴近现实的解题方式。(注:ReAct 指“先推理再行动、在行动中持续推理”的循环。)

它既不强迫 Agent 预先想好完整计划,也不让它在缺乏反思的情况下直接行动。ReAct 将二者融合:Agent 在思考接下来该做什么与实际去做之间交替。这样的往复,带来自然、灵活、近乎人类的解题过程。

从高层看,ReAct 有效在于避免极端。事先规划一切预设了完美信息;不加思索地行动假设错误无关紧要。现实问题很少允许这两种极端。ReAct 站在中间。

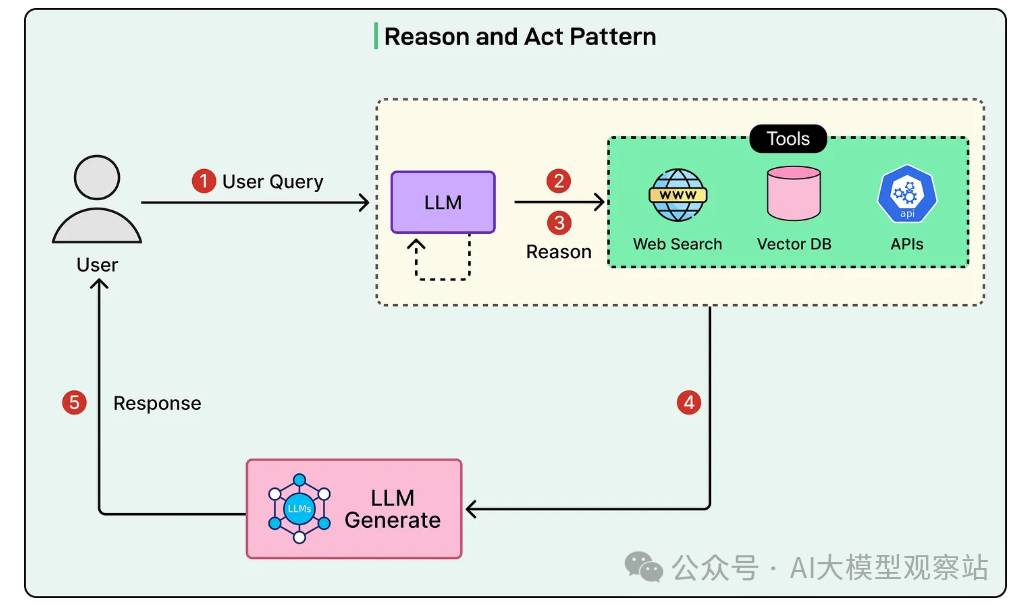

循环本身很直白。

首先,Agent 暂停并对当前形势进行推理。它考虑已知信息、缺失信息、存在的约束与可选路径。此处推理是显式的:Agent 会主动评估可能的前进路线,而不是直接跳到结论。

基于推理,Agent 随后采取一个动作:调用 tool、拉取信息、运行计算,或做出一个推动任务前进的具体决定。

动作完成后,Agent 观察结果,再进入新一轮推理,反思学到了什么、结果是否有用、下一步该如何。从这里,循环继续。

直到 Agent 认为目标已达成——或意识到在现有信息与 tools 下无法继续。

ReAct 的强大在于它的适应性。Agent 既不被僵化计划束缚,也不是盲目反应。每个动作都由推理支撑,而每次推理都扎根于来自环境的真实反馈。

实践中,这一模式让 Agent 比线性工作流更有效地驾驭不确定性。

(参见下图,了解 Reason–Act 循环的可视化。)

https://blog.bytebytego.com/p/top-ai-agentic-workflow-patterns

ReAct 工作流中显式的推理步骤不是实现细节,而是让模式可靠的根基。

首先,推理帮助 Agent 始终围绕目标保持定向。通过反复陈述要达成的目标及某个动作的理由,Agent 更不容易跑题或陷入低效循环。这个小小的“先想一想”,常常能避免后续的大错误。

推理还使适应成为可能。当一个动作产生了意外或弱结果时,Agent 不会凭惯性硬往前推。推理阶段提供空间去问_为什么_不奏效,并据此调整策略。这让基于 ReAct 的系统能够恢复,而不是默默失败。

还有一个常被忽略的好处:透明度。

由于推理步骤是显式的,开发者和用户不仅能看到 Agent 做了什么,还能看到背后的逻辑。在调试行为、建立对自动化的信任、或理解 Agent 为何得出某个结果时,这种可见性无价。

把 ReAct 与它所替代的两种极端做对比,价值更清晰。

纯规划假设你能在行动前规划好每一步。在可控、可预测的环境中也许可行,但一旦信息不完整、探索本身就是任务的一部分、或条件中途变化,就会迅速失效。

纯执行在另一端。少思考快行动虽然快,但也脆。错误会迅速叠加,一旦偏航几乎没有纠偏机会。

ReAct 找到了务实的中间地带:用推理提供足够结构以保持聚焦,同时保留行动、学习与实时调整的灵活性。在凌乱的现实问题中,这种平衡往往决定了一件事是“演示好看”,还是“真的好用”。

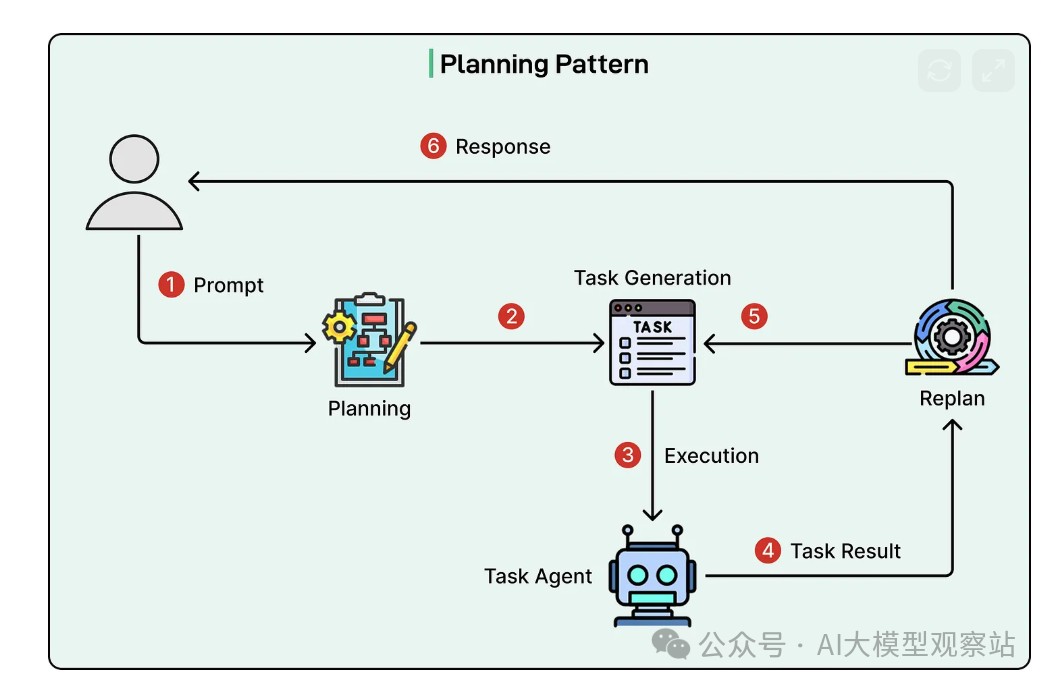

Planning Pattern

与 ReAct 不同,planning 模式强调在执行前进行更强的前置战略性思考。

在 planning 模式中,Agent 先分析总体目标并理解成功的标准。然后将目标拆解为更小、更可操作的子任务。这个分解会持续,直到得到具体、可执行的步骤。

关键在于,Agent 会识别任务间的依赖,确定哪些步骤必须先完成、哪些可以并行推进;并考虑每一步需要哪些资源、tools 或信息。只有在形成结构化计划之后,Agent 才开始执行。

见下图:

https://blog.bytebytego.com/p/top-ai-agentic-workflow-patterns

Planning 模式的一大优势是自适应规划。

这不是创建一份僵硬的逐步脚本并盲目照做。相反,Agent 在形成结构化计划的同时,仍然保持开放态度,随着新信息出现而回看并调整计划。计划提供方向,但不意味着盲从。

当任务天然可分为清晰的阶段、并且存在明确的先后顺序时,planning 最为有效。尤其是在存在现实约束的场景中——如截止日期、预算、算力限制或共享资源——协调与排序至关重要。

在错误代价高昂的情况下,这一模式也表现出色。如果回滚会浪费时间、金钱或信任,那么前期放慢速度、想清楚是值得的。包含多个并行工作流(研究、分析、执行、复核)的复杂项目,也极度受益于一个能保持整体对齐的高层计划。

当然,planning 并非万能。

对于简单、线性的任务,每一步都会自然引出下一步,此时正式规划常常只会增加不必要的开销。在这类场景下,任务本身的结构就足够,额外的规划反而像“过度工程化”。

在高度不确定的环境中,planning 也会吃力。当关键信息很可能只会在执行中浮现,且这些信息可能从根本上改变方向,那么过重的前期规划可能是浪费精力——Agent 可能花了很多时间规划从未发生的情形,而没有真正推进。

与大多数 agentic 模式一样,planning 的威力在于有的放矢。用得恰当,它带来清晰与对齐;用得滥,它会拖慢节奏。

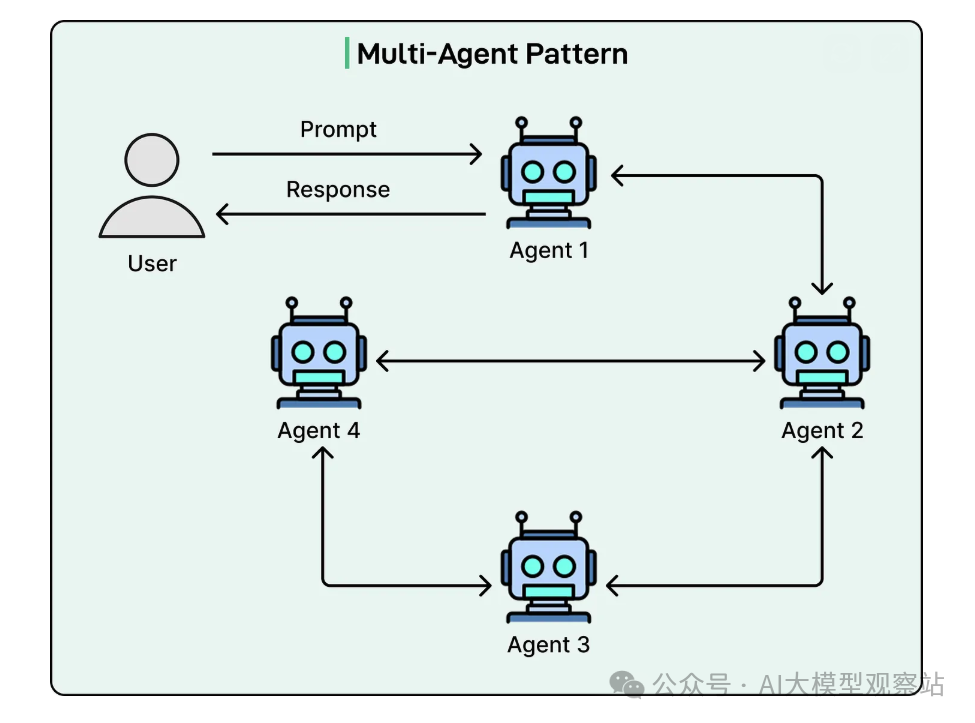

Multi-Agent Pattern:打造会“组队思考”的系统

Multi-agent 模式是构建 AI 系统最强大也最微妙的方法之一。

不再让单一 Agent 包揽一切,而是将工作分配给多个专业化的 Agents,共同协作达成共享目标。每个 Agent 都有特定的强项、视角或职责,它们组合起来就像一支结构良好的团队。

这一模式的核心洞见很简单却重要:专精通常胜过通才。

当单一 Agent 被期望处理复杂任务的方方面面时,很快就会面临权衡:既要深入推理、保持创意、又要严苛批判、管理 tools、协调步骤……在同一系统内平衡这些竞争需求,往往导致至少某些方面变得浅薄。

Multi-agent 系统通过分工来规避这一问题。

一个 Agent 侧重研究与信息收集;另一个评估准确性或风险;第三个负责综合、规划或最终呈现。每个 Agent 都能为其专职角色优化,而不是为了“一把抓”而处处妥协。

这与现实中的高效团队如出一辙。我们不会指望一个人同时在战略、执行、质量控制与沟通上都同样出色。我们会分配角色——AI 系统从这种结构中同样受益。

通过让 Agents 协作,而不是无休止地“一人多角”,multi-agent 模式在任务复杂度提升时,实现了更深入的推理、更好的相互制衡与更可靠的结果。

https://blog.bytebytego.com/p/top-ai-agentic-workflow-patterns

实践中,multi-agent 系统通常围绕一些常见角色来组织。

你经常会看到用于特定领域或任务的specialist agents。一个 research agent 擅长查找与综合信息;一个 coding agent 负责编写、测试与调试代码;一个 data analysis agent 专攻统计、建模或可视化。每个 specialist 追求深度而非广度。

同时,许多系统还会引入critic/review agents。它们的工作不是产出新内容,而是评估其他 Agents 的产出——发现漏洞、质疑假设、核实准确性或提出改进建议。它们像内置的质量过滤器,防止薄弱输出漏网。

大多数 multi-agent 架构还依赖某种coordinator/orchestrator agent。它负责管理整体工作流:决定哪个 specialist 处理哪个子任务、安排顺序、解决依赖,并确保所有内容汇聚成一致的最终结果。

这种结构很强大,但并非没有代价。

随着 Agents 的增加,协调开销会升高。Agents 之间的通信需要清晰的协议与共享预期。调试也更具挑战,因为问题常源自 Agents 的交互,而非某个单点失败。

这就是为什么 multi-agent 模式需要“名副其实”。

对于简单任务,一个设计良好的单体 Agent 几乎总是更好的选择。但当问题需要多元专长、严格复核或多重视角时,尽管复杂度增加,multi-agent 往往能交付单一 Agent 难以匹敌的结果。

结语

Agentic workflow 模式代表了我们设计与部署 AI 系统方式的根本转变。

从一次性提示走向迭代、结构化的工作流,极大拓展了 AI Agents 的可靠能力边界。不再孤立生成答案,Agents 现在可以在问题展开过程中进行规划、行动、反思、协作与适应。

回顾本文的五大核心模式:

- Reflection pattern 通过自我审查与打磨提升质量。

- Tool use pattern 让 Agent 超越纯语言,连接真实系统与数据。

- ReAct pattern 将推理与行动融合,从容应对不确定性。

- Planning pattern 为复杂且高风险任务引入战略性结构。

- Multi-agent pattern 通过专业分工与协作,实现智能的规模化。

更多推荐

已为社区贡献175条内容

已为社区贡献175条内容

所有评论(0)