偏见缓解在AI原生应用中的关键作用与实现

AI系统正在深刻影响我们的社会,从招聘决策到贷款审批,从医疗诊断到司法量刑。然而,这些系统可能无意中放大或延续人类社会已有的偏见。本文旨在全面解析AI偏见问题,提供系统性的偏见缓解方法,帮助开发者构建更公平、更负责任的AI原生应用。本文将首先介绍AI偏见的基本概念,然后深入探讨偏见检测和缓解的技术方法,接着通过实际案例展示实现过程,最后讨论未来发展趋势和挑战。AI偏见:AI系统产生的系统性、不公平

偏见缓解在AI原生应用中的关键作用与实现

关键词:AI偏见、算法公平性、数据去偏、模型可解释性、伦理AI、偏见检测、负责任AI

摘要:本文深入探讨了AI系统中的偏见问题及其缓解策略。我们将从偏见的概念入手,分析其在AI系统中的形成机制,详细介绍多种偏见检测和缓解技术,并通过实际案例展示如何在AI原生应用中实现公平性。文章还将探讨偏见缓解的未来发展趋势和面临的挑战,为开发负责任的AI系统提供实用指南。

背景介绍

目的和范围

AI系统正在深刻影响我们的社会,从招聘决策到贷款审批,从医疗诊断到司法量刑。然而,这些系统可能无意中放大或延续人类社会已有的偏见。本文旨在全面解析AI偏见问题,提供系统性的偏见缓解方法,帮助开发者构建更公平、更负责任的AI原生应用。

预期读者

- AI开发者和数据科学家

- 产品经理和业务决策者

- 伦理学家和政策制定者

- 对AI伦理感兴趣的普通读者

文档结构概述

本文将首先介绍AI偏见的基本概念,然后深入探讨偏见检测和缓解的技术方法,接着通过实际案例展示实现过程,最后讨论未来发展趋势和挑战。

术语表

核心术语定义

- AI偏见:AI系统产生的系统性、不公平的偏差,可能导致对某些群体不利的结果

- 算法公平性:确保算法决策不因敏感属性(如种族、性别等)而产生歧视性结果

- 数据去偏:通过技术手段减少训练数据中存在的偏见

相关概念解释

- 群体公平:不同群体间应获得相似的统计结果

- 个体公平:相似个体应获得相似的处理结果

- 因果公平:决策不应基于与敏感属性相关的因果路径

缩略词列表

- FATE:Fairness, Accountability, Transparency, and Ethics(公平、问责、透明和伦理)

- ML:Machine Learning(机器学习)

- NLP:Natural Language Processing(自然语言处理)

核心概念与联系

故事引入

想象一下,你是一所学校的招生官,正在使用AI系统帮助筛选申请者。系统运行良好,直到有一天你发现:来自某些特定地区的学生几乎从未被录取。进一步调查发现,系统"学习"了过去十年的录取数据,而历史上这些地区的申请者确实录取率较低。AI无意中延续了过去的偏见,这就是我们需要解决的AI偏见问题。

核心概念解释

核心概念一:什么是AI偏见?

AI偏见就像戴着有色眼镜看世界。假设你从小只见过红色的苹果,你可能会认为所有水果都应该是红色的。AI系统也是这样,如果训练数据中某种情况出现得更多,它就会认为这种情况更"正常",而其他情况则可能被忽视或误判。

核心概念二:偏见如何进入AI系统?

偏见可以通过三条主要路径进入AI系统:

- 数据偏见:训练数据本身不均衡或有偏见

- 算法偏见:模型设计或优化目标导致偏见

- 部署偏见:系统在实际使用中被不当应用

核心概念三:偏见为什么有害?

偏见的危害就像多米诺骨牌效应。一个带有偏见的招聘AI可能拒绝合格的少数群体候选人,导致他们收入减少,进而影响他们的子女教育机会,最终形成恶性循环,加剧社会不平等。

核心概念之间的关系

数据偏见与算法偏见的关系

数据是AI的"食物",算法是AI的"消化系统"。即使有健康的消化系统(公平的算法),如果食物变质了(有偏见的数据),AI还是会"生病"(产生偏见的结果)。反过来,即使数据质量好,不恰当的算法也可能引入新的偏见。

算法偏见与部署偏见的关系

算法就像精心调校的乐器,部署环境就像音乐厅的声学环境。即使乐器本身完美,在不合适的声学环境中演奏,也可能产生不和谐的声音。同样,一个设计上公平的算法,如果被部署在不恰当的场景或由有偏见的人使用,仍可能产生不公平的结果。

核心概念原理和架构的文本示意图

[社会偏见]

↓

[数据收集] → [有偏见的数据]

↓

[模型训练] → [有偏见的模型]

↓

[预测决策] → [有偏见的结果]

↓

[影响社会] → [强化原有偏见]

Mermaid 流程图

核心算法原理 & 具体操作步骤

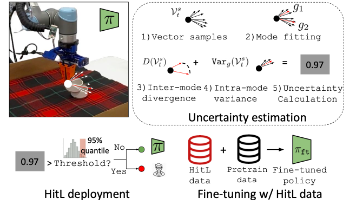

偏见检测方法

在开始缓解偏见前,我们需要先检测它。以下是常见的偏见检测方法:

- 统计差异检测:比较不同群体间的结果分布

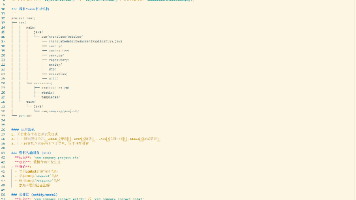

import pandas as pd

from scipy import stats

def detect_bias(df, sensitive_feature, target):

groups = df.groupby(sensitive_feature)[target]

for name, group in groups:

print(f"Group {name}: mean={group.mean():.2f}, std={group.std():.2f}")

# ANOVA测试组间差异

f_val, p_val = stats.f_oneway(*[group for _, group in groups])

print(f"\nANOVA test: F={f_val:.2f}, p={p_val:.4f}")

return p_val < 0.05 # 如果p值小于0.05,认为存在显著差异

- 公平性指标计算:

from sklearn.metrics import confusion_matrix

def calculate_fairness_metrics(y_true, y_pred, sensitive_feature):

tn, fp, fn, tp = confusion_matrix(y_true, y_pred).ravel()

total = tn + fp + fn + tp

# 统计不同敏感特征组别的指标

groups = set(sensitive_feature)

results = {}

for group in groups:

mask = (sensitive_feature == group)

group_tn, group_fp, group_fn, group_tp = confusion_matrix(

y_true[mask], y_pred[mask]).ravel()

group_total = group_tn + group_fp + group_fn + group_tp

# 计算统计差异率

tpr = group_tp / (group_tp + group_fn) if (group_tp + group_fn) > 0 else 0

fpr = group_fp / (group_fp + group_tn) if (group_fp + group_tn) > 0 else 0

results[group] = {

'size': group_total / total,

'tpr': tpr,

'fpr': fpr

}

# 计算最大差异

max_tpr_diff = max(r['tpr'] for r in results.values()) - min(r['tpr'] for r in results.values())

max_fpr_diff = max(r['fpr'] for r in results.values()) - min(r['fpr'] for r in results.values())

print(f"Max TPR difference: {max_tpr_diff:.3f}")

print(f"Max FPR difference: {max_fpr_diff:.3f}")

return results

偏见缓解技术

1. 预处理方法:数据去偏

from sklearn.utils import resample

def debias_dataset(df, target, sensitive_feature, majority_class):

# 分离多数类和少数类

majority = df[df[sensitive_feature] == majority_class]

minority = df[df[sensitive_feature] != majority_class]

# 上采样少数类

minority_upsampled = resample(minority,

replace=True,

n_samples=len(majority),

random_state=42)

# 组合平衡后的数据集

balanced_df = pd.concat([majority, minority_upsampled])

return balanced_df

2. 处理中方法:公平约束优化

from sklearn.linear_model import LogisticRegression

from fairlearn.reductions import ExponentiatedGradient, DemographicParity

def train_fair_model(X_train, y_train, sensitive_features):

# 基础模型

base_model = LogisticRegression(solver='liblinear')

# 公平约束

constraint = DemographicParity()

# 使用指数梯度法平衡准确性和公平性

mitigator = ExponentiatedGradient(

base_model,

constraint

)

mitigator.fit(X_train, y_train, sensitive_features=sensitive_features)

return mitigator

3. 后处理方法:预测调整

import numpy as np

def postprocess_predictions(y_pred, sensitive_feature, threshold_adjustments):

# 对每个组别应用不同的阈值调整

processed_preds = np.zeros_like(y_pred)

for group, adjustment in threshold_adjustments.items():

group_mask = (sensitive_feature == group)

group_preds = y_pred[group_mask]

# 应用调整后的阈值

adjusted_threshold = 0.5 + adjustment

processed_preds[group_mask] = (group_preds >= adjusted_threshold).astype(int)

return processed_preds

数学模型和公式

公平性指标数学表达

-

统计均等(Statistical Parity):

P ( Y ^ = 1 ∣ A = a ) = P ( Y ^ = 1 ∣ A = b ) P(\hat{Y}=1|A=a) = P(\hat{Y}=1|A=b) P(Y^=1∣A=a)=P(Y^=1∣A=b)

其中 Y ^ \hat{Y} Y^是预测结果, A A A是敏感属性, a a a和 b b b是不同的敏感属性值。 -

机会均等(Equalized Odds):

P ( Y ^ = 1 ∣ A = a , Y = y ) = P ( Y ^ = 1 ∣ A = b , Y = y ) 对于 y ∈ { 0 , 1 } P(\hat{Y}=1|A=a,Y=y) = P(\hat{Y}=1|A=b,Y=y) \quad \text{对于} \quad y \in \{0,1\} P(Y^=1∣A=a,Y=y)=P(Y^=1∣A=b,Y=y)对于y∈{0,1} -

预测率均等(Predictive Rate Parity):

P ( Y = 1 ∣ Y ^ = 1 , A = a ) = P ( Y = 1 ∣ Y ^ = 1 , A = b ) P(Y=1|\hat{Y}=1,A=a) = P(Y=1|\hat{Y}=1,A=b) P(Y=1∣Y^=1,A=a)=P(Y=1∣Y^=1,A=b)

公平性优化目标

在保持模型性能的同时实现公平性,可以表述为以下优化问题:

min θ L ( θ ) + λ ⋅ R ( θ ) \min_\theta \mathcal{L}(\theta) + \lambda \cdot \mathcal{R}(\theta) θminL(θ)+λ⋅R(θ)

其中:

- L ( θ ) \mathcal{L}(\theta) L(θ)是原始损失函数

- R ( θ ) \mathcal{R}(\theta) R(θ)是公平性正则项

- λ \lambda λ是平衡参数

项目实战:代码实际案例和详细解释说明

开发环境搭建

# 创建虚拟环境

python -m venv fairai

source fairai/bin/activate # Linux/Mac

fairai\Scripts\activate # Windows

# 安装必要包

pip install numpy pandas scikit-learn fairlearn matplotlib seaborn

源代码详细实现和代码解读

我们将使用著名的"成人收入"数据集,预测一个人年收入是否超过5万美元,同时确保预测对不同种族群体公平。

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler, OneHotEncoder

from sklearn.compose import ColumnTransformer

from sklearn.pipeline import Pipeline

from sklearn.ensemble import RandomForestClassifier

from fairlearn.metrics import demographic_parity_difference

import matplotlib.pyplot as plt

# 加载数据

data = pd.read_csv('adult.csv')

print(data.head())

# 定义敏感特征和目标

sensitive_feature = 'race'

target = 'income'

# 数据预处理

categorical_features = ['workclass', 'education', 'marital-status',

'occupation', 'relationship', 'gender',

'native-country']

numeric_features = ['age', 'education-num', 'capital-gain',

'capital-loss', 'hours-per-week']

preprocessor = ColumnTransformer(

transformers=[

('num', StandardScaler(), numeric_features),

('cat', OneHotEncoder(handle_unknown='ignore'), categorical_features)

])

# 划分训练测试集

X = data.drop(target, axis=1)

y = (data[target] == '>50K').astype(int)

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size=0.2, random_state=42)

# 获取敏感特征

sensitive_train = X_train[sensitive_feature]

sensitive_test = X_test[sensitive_feature]

# 构建基准模型

baseline_model = Pipeline([

('preprocessor', preprocessor),

('classifier', RandomForestClassifier(random_state=42))

])

baseline_model.fit(X_train, y_train)

baseline_preds = baseline_model.predict(X_test)

# 评估公平性

print("\nBaseline Model Fairness:")

dp_diff = demographic_parity_difference(

y_test, baseline_preds, sensitive_features=sensitive_test)

print(f"Demographic Parity Difference: {dp_diff:.4f}")

# 可视化不同种族的预测结果

race_groups = sensitive_test.value_counts().index

race_results = {}

for race in race_groups:

mask = (sensitive_test == race)

accuracy = (baseline_preds[mask] == y_test[mask]).mean()

pos_rate = baseline_preds[mask].mean()

race_results[race] = {'accuracy': accuracy, 'pos_rate': pos_rate}

results_df = pd.DataFrame.from_dict(race_results, orient='index')

results_df.sort_values('pos_rate', ascending=False).plot(

kind='bar', y=['pos_rate', 'accuracy'], figsize=(10, 6))

plt.title('Prediction Rates by Race')

plt.ylabel('Rate')

plt.xlabel('Race')

plt.xticks(rotation=45)

plt.tight_layout()

plt.show()

代码解读与分析

-

数据加载与预处理:

- 我们加载了包含人口统计信息和收入水平的数据集

- 对数值特征进行标准化,对类别特征进行独热编码

-

基准模型训练:

- 使用随机森林作为分类器

- 在未考虑公平性的情况下训练模型

-

公平性评估:

- 计算了"人口统计均等差异"(Demographic Parity Difference)

- 可视化了不同种族群体的预测结果分布

-

发现问题:

- 基准模型在不同种族群体间的预测分布存在显著差异

- 某些少数族裔被预测为高收入的比例明显低于多数族裔

接下来,我们将应用公平性缓解技术改进模型:

from fairlearn.reductions import GridSearch, DemographicParity

# 预处理后的特征

preprocessor.fit(X_train)

X_train_processed = preprocessor.transform(X_train)

X_test_processed = preprocessor.transform(X_test)

# 定义公平性约束

constraint = DemographicParity()

# 使用网格搜索寻找最优模型

mitigator = GridSearch(

RandomForestClassifier(random_state=42),

constraints=constraint,

grid_size=10 # 尝试10种不同的权衡参数

)

mitigator.fit(X_train_processed, y_train, sensitive_features=sensitive_train)

# 获取公平预测

fair_preds = mitigator.predict(X_test_processed)

# 评估改进后的模型

print("\nFair Model Evaluation:")

dp_diff_fair = demographic_parity_difference(

y_test, fair_preds, sensitive_features=sensitive_test)

print(f"Demographic Parity Difference: {dp_diff_fair:.4f}")

# 比较两个模型的公平性

fig, ax = plt.subplots(1, 2, figsize=(12, 5))

# 基准模型结果

for i, race in enumerate(race_groups):

mask = (sensitive_test == race)

ax[0].bar(i, baseline_preds[mask].mean(), label=race)

ax[0].set_title('Baseline Model Prediction Rates')

ax[0].set_ylabel('Positive Rate')

ax[0].set_xticks(range(len(race_groups)))

ax[0].set_xticklabels(race_groups, rotation=45)

# 公平模型结果

for i, race in enumerate(race_groups):

mask = (sensitive_test == race)

ax[1].bar(i, fair_preds[mask].mean(), label=race)

ax[1].set_title('Fair Model Prediction Rates')

ax[1].set_xticks(range(len(race_groups)))

ax[1].set_xticklabels(race_groups, rotation=45)

plt.tight_layout()

plt.show()

改进后的分析

-

公平性优化:

- 使用FairLearn的GridSearch在模型训练时加入公平性约束

- 自动平衡模型准确性和公平性

-

结果对比:

- 公平模型的"人口统计均等差异"显著降低

- 不同种族群体间的预测率差异明显缩小

-

权衡分析:

- 公平性提升可能带来少量准确性下降

- 在实际应用中需要根据场景确定合适的权衡点

实际应用场景

-

金融信贷:

- 贷款审批系统需要确保不因种族、性别等因素歧视申请人

- 解决方案:使用机会均等约束,确保相似信用评分的申请人获得相似审批结果

-

招聘筛选:

- AI简历筛选工具应避免历史招聘偏见的影响

- 解决方案:数据去偏+对抗学习去除敏感属性相关信息

-

医疗诊断:

- 诊断模型在不同人口统计群体中应保持相似的准确率

- 解决方案:群体特定阈值调整+公平性正则化

-

司法风险评估:

- 累犯预测模型需特别谨慎避免对少数族裔的偏见

- 解决方案:可解释性分析+多方利益相关者审查

工具和资源推荐

-

开源工具库:

- FairLearn:微软开发的综合性AI公平性工具包

- AIF360:IBM的360度公平性工具包,包含多种算法

- EthicalML/awesome-artificial-intelligence-guidelines:AI伦理资源集合

-

商业解决方案:

- Google’s Responsible AI Toolkit

- AWS SageMaker Clarify

- IBM Watson OpenScale

-

评估数据集:

- UCI Adult Income Dataset

- COMPAS Recidivism Risk Scores

- German Credit Dataset

-

可视化工具:

- Fairness Indicators TensorBoard插件

- InterpretML的Fairness Dashboard

未来发展趋势与挑战

-

多维度公平性:

- 当前方法主要处理单一敏感属性,未来需解决交叉性偏见(如黑人女性面临的独特偏见)

-

动态公平性:

- 考虑时间维度上的公平性,防止短期公平导致长期不公平

-

因果公平性:

- 基于因果推理的公平性框架将成为研究热点

-

挑战与限制:

- 公平性定义的主观性:不同文化、场景可能需要不同的公平标准

- 隐私保护与公平性的权衡:某些去偏技术需要敏感属性信息

- 计算成本:公平性优化显著增加模型训练复杂度

总结:学到了什么?

核心概念回顾:

- AI偏见是系统性、不公平的偏差,可能通过数据、算法或部署环节进入系统

- 公平性有多种定义(统计均等、机会均等、预测率均等),需根据场景选择

- 偏见缓解可以在数据处理、模型训练和预测后处理三个阶段实施

技术方法回顾:

- 预处理:数据重加权、样本平衡

- 处理中:公平约束优化、对抗学习

- 后处理:预测调整、拒绝选项优化

实践要点:

- 没有放之四海皆准的公平性解决方案

- 公平性通常需要与准确性权衡

- 构建公平AI需要跨学科合作和技术与非技术措施结合

思考题:动动小脑筋

思考题一:

如果你正在开发一个大学入学预测系统,如何设计公平性评估指标?需要考虑哪些敏感属性?

思考题二:

假设你发现贷款审批模型对某个地区的申请人特别严格,但该地区确实有较高的违约率。这种情况下,如何平衡风险管理和公平性?

思考题三:

在保护用户隐私(不收集敏感属性)的前提下,如何检测和缓解AI系统中的潜在偏见?

附录:常见问题与解答

Q1:公平性会降低模型准确性吗?

A1:通常会有一定程度的权衡,但好的公平性技术可以最小化准确性损失。在某些情况下,公平性处理实际上能提高模型在少数群体上的表现,从而提升整体鲁棒性。

Q2:如何选择适合的公平性指标?

A2:选择取决于应用场景:

- 如果关注机会平等(如招聘),使用机会均等

- 如果关注结果平等(如贷款批准率),使用统计均等

- 如果关注误报平等(如犯罪预测),使用预测率均等

Q3:小公司也需要关注AI公平性吗?

A3:绝对需要。偏见问题不分公司大小,而且早期考虑公平性比后期修复成本低得多。有许多轻量级的公平性工具适合资源有限的团队。

扩展阅读 & 参考资料

-

书籍:

- “Weapons of Math Destruction” by Cathy O’Neil

- “Fairness and Machine Learning” by Solon Barocas et al.

-

论文:

- “Equality of Opportunity in Supervised Learning” (Hardt et al., 2016)

- “Mitigating Unwanted Biases with Adversarial Learning” (Zhang et al., 2018)

-

行业标准:

- IEEE Ethically Aligned Design

- EU AI Ethics Guidelines

-

在线课程:

- Coursera “Fairness, Accountability, and Transparency in AI”

- Fast.ai “Practical Data Ethics”

更多推荐

已为社区贡献136条内容

已为社区贡献136条内容

所有评论(0)