有些问题,调一百次参数也解决不了

本文探讨了在AI模型微调过程中过度依赖参数调整的误区。作者指出,参数只能改变模型内部行为,但无法解决系统层面的根本问题,并列举了六类不应靠参数解决的问题:数据偏差、评估体系错误、系统约束缺失、RAG检索问题、不可解释行为以及拒绝能力不足。文章强调,当模型效果不佳时,工程师应首先判断问题是否属于数据、评估或系统设计层面,而非盲目调参。最后提出一个实用自检清单,建议团队在调参前先明确问题本质,避免陷入

参数能解决的问题,远比你想象的少

几乎每一个微调项目,都会经历同一个阶段:

- 一开始,参数真的很有用

- learning rate、batch size、epoch 调一调

- 模型明显“变了”,效果也肉眼可见

但只要项目继续往前走,你迟早会遇到这样一个时刻:

- 参数还在

- loss 还能降

- 但你隐约感觉到——再调下去,好像也只是“换一种不对”。

很多团队就是在这个阶段,把项目调死的。

因为他们做了一个非常自然、但非常致命的判断:

“既然是模型问题,那就继续调模型参数。”

而这篇文章要做的,就是把这层错觉拆掉。

一个先说清楚的前提:参数只能改变“模型如何变化”,不能改变“问题的性质”

这是后面所有判断的基础。

你在微调里能调到的,本质只有三类东西:

- 模型对数据的拟合强度

- 模型行为变化的幅度

- 模型偏好被固化的速度

这些都属于**“模型内部行为”**。

但在真实工程里,很多问题根本不属于这个层面。

当问题本质不在模型内部时,

你继续调参数,只是在:

用模型的不确定性,去掩盖系统设计的问题。

第一类永远不该靠参数解决的问题:数据本身是歪的

这是最经典、也是最容易被忽略的一类。

很多团队在遇到问题时,会下意识想:

- “是不是 learning rate 不合适?”

- “是不是 epoch 不够?”

但如果你的训练数据本身存在这些问题:

- 标注标准不一致

- 不同来源混在一起

- 高频样本强烈偏向某种回答风格

- 边界问题极少甚至缺失

那参数调得越“好”,风险往往越大。

为什么?

因为参数只会帮模型更快、更坚定地学会数据里的偏差。

数据是歪的,参数只会让模型歪得更自信。

数据偏差 → 参数放大 → 行为固化链路图

一个非常典型的误判场景

你可能见过这种情况:

- 模型在常见问题上表现很好

- 但在边界问题上非常危险

于是有人提出:

“那我们把 learning rate 再调小一点,稳一稳。”

结果是:

- 常见问题依然很好

- 边界问题依然危险

- 只是危险方式变得更“温和”了一点

这不是参数的问题,

而是你根本没给模型学“怎么在边界停下来”的数据。

第二类问题:评估体系是错的

这是一个非常“工程味”,但极其致命的问题。

如果你衡量模型好坏的方式是:

- loss

- BLEU / ROUGE

- 或一些泛化能力不明确的自动指标

那你很可能在优化一个和业务目标不一致的方向。

这时候你会看到:

- 参数怎么调,指标都能提升

- 但业务方总觉得“不太对”

继续调参数,只会让模型在“错误的坐标系里跑得更快”。

评估错了,参数调得越好,偏得越远。

评估目标偏移 → 参数优化方向错误示意图

一个很现实的判断标准

你可以问自己一个问题:

如果我把模型输出原样给业务方看,

他们会不会觉得“这很危险,但指标看起来很好”?

如果答案是“会”,

那问题根本不在参数。

第三类问题:问题本身需要“系统约束”,而不是“模型记忆”

这是很多团队踩得最深的一个坑。

典型场景包括:

- 合规规则

- 风控边界

- 退款/赔付条件

- 医疗/法律免责声明

这些问题的共同特点是:

- 规则明确

- 例外复杂

- 责任重大

而你如果试图通过微调参数,让模型“记住这些规则”,

本质上是在做一件非常危险的事:

你在用统计模型,模拟确定性系统。

参数永远解决不了:

- “该不该答”

- “该不该拒绝”

- “该不该转人工”

这些判断,必须来自系统层,而不是模型偏好。

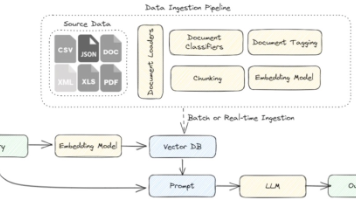

第四类问题:RAG 里的检索和切分问题

你前面已经写了很多 RAG 相关的文章,这里我只把结论落在“参数误用”上。

当 RAG 效果不好时,很多人会:

- 微调模型

- 调 generation 参数

- 调 prompt

- 调 temperature

但如果问题来自于:

- 文档切分不合理

- chunk 不可独立理解

- TopK 过大引入冲突证据

那你调模型参数,只是在让模型:

更努力地在垃圾证据里编一个合理故事。

这是你前面文章里反复强调的:

证据冲突 ≫ 证据不足。

参数永远解决不了“证据结构错误”。

RAG 问题根因分层 vs 参数误用示意图

第五类问题:模型行为已经进入“不可解释区间”

这是一个非常工程化、但非常重要的判断点。

如果你已经发现:

- 同样的问题,不同次回答差异很大

- 同样的参数,换个数据集就翻车

- 团队里没人能清楚解释“为什么这版好一点”

那继续调参数,往往意味着:

你在扩大一个已经不可解释的系统。

参数调优应该发生在:

- 行为可解释

- 变化方向可预测

的前提下。

一旦你已经失去这种控制感,

继续调,只会让系统更脆弱。

第六类问题:你真正缺的是“拒绝能力”,而不是“回答能力”

这是很多客服、知识助手项目后期才意识到的一点。

模型的问题往往不是:

- 答不出来

而是:

- 不该答的时候,答得太多、太确定

如果你试图用参数去“压制风险回答”,

比如:

- 降低 temperature

- 调小 learning rate

- 加强正则

你可能会看到:

- 回答稍微保守一点

但真正的问题没有解决:

模型仍然不知道“什么时候该闭嘴”。

这不是参数能教会的,

这是策略、流程、系统设计的问题。

一个非常实用的工程自检清单

当你准备“再调一轮参数”之前,

我强烈建议你先问完下面这几个问题:

- 这个问题是否能通过补数据解决?

- 是否是评估方式误导了我们?

- 是否应该在系统层面加约束?

- 是否是 RAG 证据结构问题?

- 是否已经进入不可解释区间?

只要其中有两个答案是“是”,

那继续调参数,大概率是错误动作。

一个简化但非常真实的工程分流示意

问题出现

↓

是模型能力不足吗?

↓ 否

是数据 / 评估 / 系统问题吗?

↓ 是

→ 停止调参

→ 修系统,而不是修模型

这个分流非常简单,

但在真实项目里,能帮你省掉大量无效调参。

在很多微调项目后期,最大的风险不是“参数没调好”,而是团队误判了问题层级。用LLaMA-Factory online把“参数变化带来的行为变化”和“数据 / RAG / 系统改动带来的变化”拆开对比,往往能更快意识到:哪些问题已经不该再丢给参数,而应该在系统层解决。

总结:参数不是万能钥匙,继续调参也不是努力的唯一形式

我用一句话,把这篇文章彻底收住:

当你把所有问题都交给参数,

你其实是在逃避对系统设计负责。

成熟的微调工程,不是:

- 参数调得多细

而是:

- 清楚知道哪些问题永远不该再靠参数解决。

当你能果断地说出这句话:

“这个问题,不该再调模型了。”

你已经跨过了大模型工程里

最重要、也最难的一道门槛。

更多推荐

已为社区贡献30条内容

已为社区贡献30条内容

所有评论(0)