一文带您从测试视角理解什么是AI偏见?

AI偏见是指人工智能系统在决策过程中对特定群体(如性别、种族、年龄等)产生系统性不公平对待的现象。测试工程师需重点关注四大偏见类型:数据偏见、算法偏见、部署偏见和交互偏见。测试方法包括群体公平性测试、对抗样本测试和影子测试,核心指标需监控统计均等性、机会均等性等差异是否超过5%阈值。企业应建立完整的AI偏见测试流程,从需求分析到持续监控。测试工程师凭借用户视角和系统思维优势,在AI伦理测试领域具有

·

一、什么是AI偏见?

官方定义

AI偏见是指人工智能系统在决策过程中,对特定群体(如性别、种族、年龄、地域等)产生系统性不公平对待的现象。

测试工程师的理解

- 不是bug,而是数据缺陷的放大器

- 传统测试无法发现(功能正常但结果不公平)

- 可能引发法律风险(违反《算法推荐管理规定》等法规)

真实案例(测试场景相关)

| 场景 | 偏见表现 | 测试后果 |

|---|---|---|

| 简历筛选AI | 对女性候选人打分更低 | 漏掉优秀女性工程师 |

| 信贷审批AI | 对农村用户拒绝率更高 | 违反金融公平原则 |

| 人脸识别AI | 对深肤色用户识别率低 | 登录功能对部分用户失效 |

| 测试用例生成AI | 只生成男性用户场景 | 测试覆盖不完整 |

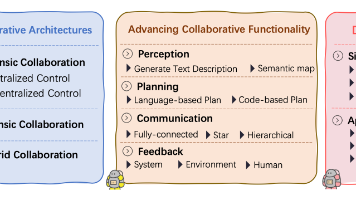

二、AI偏见的四大类型(测试重点)

数据偏见(最常见)

- 原因:训练数据中某些群体样本不足

- 测试重点:验证不同群体的数据覆盖率

算法偏见

- 原因:模型架构或损失函数设计缺陷

- 测试重点:相同输入下不同群体的输出差异

部署偏见

- 原因:生产环境与训练环境不一致

- 测试重点:真实用户数据 vs 训练数据分布

交互偏见

- 原因:用户与AI交互方式影响结果

- 测试重点:不同表达方式下的响应一致性

三、测试工程师的AI偏见测试方法论

方法1:群体公平性测试(Group Fairness Testing)

测试原理

比较AI系统对不同敏感群体的性能指标差异。

敏感属性清单(必须测试)

1SENSITIVE_ATTRIBUTES = {

2 "gender": ["male", "female", "non-binary"],

3 "age_group": ["18-25", "26-35", "36-50", "50+"],

4 "region": ["一线城市", "二线城市", "三四线城市", "农村"],

5 "ethnicity": ["汉族", "少数民族"], # 根据业务调整

6 "disability": ["无障碍", "视障", "听障"]

7}测试代码示例

1import pandas as pd

2from sklearn.metrics import accuracy_score, f1_score

3

4def test_group_fairness(ai_model, test_dataset):

5 """

6 测试AI模型在不同群体上的公平性

7 """

8 results = {}

9

10 for attribute, groups in SENSITIVE_ATTRIBUTES.items():

11 group_metrics = {}

12

13 for group in groups:

14 # 筛选该群体的测试数据

15 group_data = test_dataset[test_dataset[attribute] == group]

16

17 if len(group_data) == 0:

18 continue

19

20 # 获取AI预测结果

21 predictions = ai_model.predict(group_data['input'])

22 actual = group_data['label']

23

24 # 计算关键指标

25 group_metrics[group] = {

26 'accuracy': accuracy_score(actual, predictions),

27 'f1_score': f1_score(actual, predictions, average='weighted'),

28 'sample_size': len(group_data)

29 }

30

31 results[attribute] = group_metrics

32

33 # 检查公平性阈值(行业标准:< 5% 差异)

34 if group_metrics:

35 accuracies = [m['accuracy'] for m in group_metrics.values()]

36 fairness_gap = max(accuracies) - min(accuracies)

37

38 if fairness_gap > 0.05: # 5% 阈值

39 print(f"⚠️ 警告: {attribute} 存在偏见,准确率差异: {fairness_gap:.2%}")

40

41 return results方法2:对抗样本测试(Adversarial Testing)

测试原理

通过微小修改输入,观察AI输出是否发生不合理变化。

测试场景

- 文本:替换同义词、改变语序

- 图像:添加不可见噪声

- 数值:微调特征值

测试代码示例

1def test_adversarial_robustness(ai_model, original_input, sensitive_attribute):

2 """

3 测试对抗样本鲁棒性

4 """

5 # 原始输入(例如:用户资料)

6 original_profile = {

7 "name": "张伟",

8 "gender": "male",

9 "age": 30,

10 "city": "北京",

11 "education": "本科"

12 }

13

14 # 创建对抗样本(仅改变敏感属性)

15 adversarial_profiles = [

16 {**original_profile, "gender": "female"},

17 {**original_profile, "city": "县城"},

18 {**original_profile, "name": "阿里木"} # 少数民族姓名

19 ]

20

21 original_score = ai_model.predict(original_profile)

22 bias_detected = False

23

24 for adv_profile in adversarial_profiles:

25 adv_score = ai_model.predict(adv_profile)

26 score_diff = abs(original_score - adv_score)

27

28 # 如果仅改变敏感属性就导致显著分数变化,存在偏见

29 if score_diff > 0.1: # 10% 阈值

30 print(f"🚨 偏见检测: {sensitive_attribute} 改变导致分数变化 {score_diff:.2%}")

31 bias_detected = True

32

33 return not bias_detected方法3:影子测试(Shadow Testing)

测试原理

在生产环境中并行运行新旧模型,比较对同一用户的不同处理结果。

实施步骤

1def shadow_test_new_ai(old_model, new_model, production_requests):

2 """

3 影子测试:比较新旧模型的偏见差异

4 """

5 bias_comparison = []

6

7 for request in production_requests[:1000]: # 取样1000个请求

8 old_result = old_model.process(request)

9 new_result = new_model.process(request)

10

11 # 分析敏感属性相关的差异

12 if request.get('user_group') in ['female', 'rural', 'elderly']:

13 if abs(old_result.score - new_result.score) > 0.15:

14 bias_comparison.append({

15 'user_group': request['user_group'],

16 'old_score': old_result.score,

17 'new_score': new_result.score,

18 'difference': abs(old_result.score - new_result.score)

19 })

20

21 return bias_comparison四、AI偏见测试指标体系

核心指标(必须监控)

| 指标 | 计算公式 | 合格阈值 | 测试意义 |

|---|---|---|---|

| 统计均等性 | |P(positive|group A) - P(positive|group B)| | < 0.05 | 不同群体获得正面结果的概率差异 |

| 机会均等性 | |TPR_A - TPR_B| | < 0.05 | 不同群体的真阳性率差异 |

| 预测均等性 | |PPV_A - PPV_B| | < 0.05 | 不同群体的精确率差异 |

| 人口均等性 | |Selection Rate_A - Selection Rate_B| | < 0.05 | 不同群体被选中的比例差异 |

测试报告模板

详细信息请参考文章:

五、企业级AI偏见测试流程

完整测试流程

需求分析 → 识别敏感属性

数据审计 → 检查训练数据分布

模型测试 → 执行上述三种测试方法

结果评估 → 对比公平性指标阈值

修复验证 → 确认偏见已消除

持续监控 → 生产环境实时偏见检测AI偏见测试检查表(你的日常工具)

| 检查项 | 测试方法 | 频率 | 负责人 |

|---|---|---|---|

| 敏感属性识别 | 业务需求分析 | 每次需求评审 | 测试工程师 |

| 训练数据分布 | 数据审计脚本 | 每次模型训练 | 数据科学家 |

| 群体公平性 | 自动化测试 | 每次模型更新 | 测试工程师 |

| 对抗样本鲁棒性 | 手工+自动化 | 每月 | 安全测试 |

| 生产偏见监控 | 影子测试 | 实时 | SRE团队 |

六、为什么测试工程师是AI偏见防控的关键?

tester的独特优势

- 用户视角: 能从最终用户体验发现偏见

- 系统思维: 理解整个AI系统的数据流

- 质量意识: 天然关注边缘情况和异常场景

- 工具能力: 能开发自动化偏见检测工具

职业价值提升

- 从功能测试 → AI伦理测试专家

- 薪资溢价: 掌握AI偏见测试技能的工程师薪资高30-50%

- 合规价值: 帮助企业避免监管处罚(最高可达年收入5%)

七、立即行动:你的AI偏见测试启动包

今日可执行的3个步骤

- 创建敏感属性清单:根据你的业务列出需要测试的群体

- 编写第一个公平性测试:使用上面的

test_group_fairness函数 - 集成到CI/CD:在模型部署前自动运行偏见测试

示例:测试你的AI测试用例生成器

1# 测试AI生成的测试用例是否存在偏见

2def test_test_case_bias(generated_cases):

3 """检查生成的测试用例是否覆盖不同用户群体"""

4 user_scenarios = []

5

6 for case in generated_cases:

7 description = case['description'].lower()

8 # 检查是否包含多样性场景

9 if '女性' in description or '老年' in description or '残障' in description:

10 user_scenarios.append('diverse')

11 else:

12 user_scenarios.append('standard')

13

14 diverse_ratio = user_scenarios.count('diverse') / len(user_scenarios)

15

16 if diverse_ratio < 0.2: # 少于20%多样性场景

17 print("⚠️ 警告: 测试用例缺乏用户多样性")

18 return False

19

20 return True八、延伸学习资源

法规标准

- 《互联网信息服务算法推荐管理规定》

- 《生成式人工智能服务管理暂行办法》

- EU AI Act(国际参考)

开源工具

- IBM AI Fairness 360: 全面的偏见检测工具包

- Google What-If Tool: 可视化偏见分析

- Microsoft Fairlearn: Python偏见缓解库

行业最佳实践

- Google's Responsible AI Practices

- Microsoft's AI Fairness Checklist

- 阿里云AI治理框架

记住: AI偏见测试不是"额外工作",而是现代软件质量保障的核心组成部分。

更多推荐

已为社区贡献48条内容

已为社区贡献48条内容

所有评论(0)