本地部署智能体——同一局域网下多个设备访问使用主机模型

本地部署ollama+cherry studio+本地模型

目录

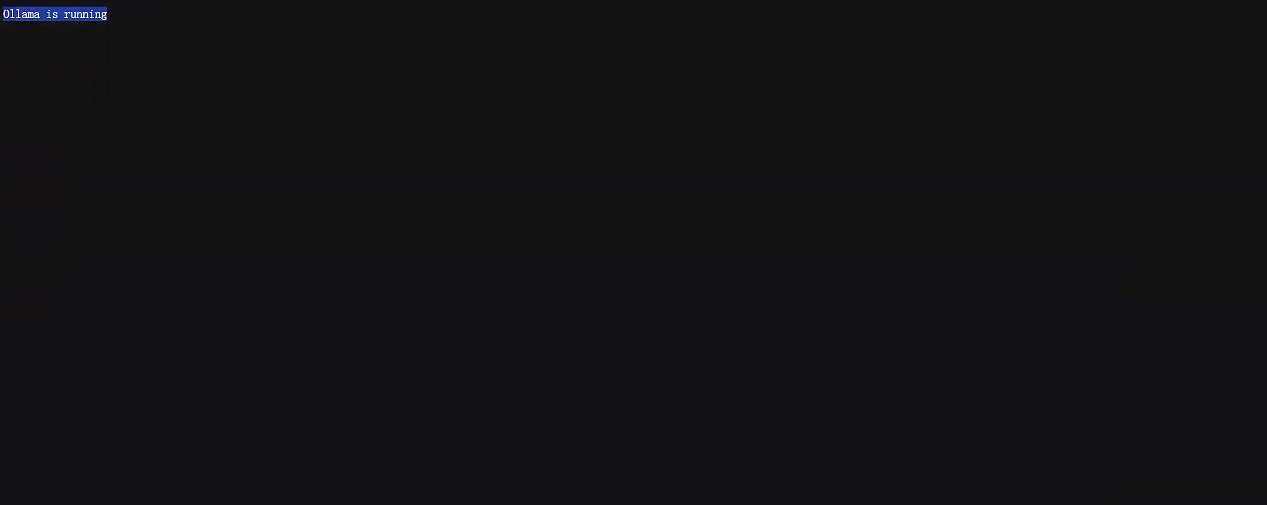

3.打开浏览器输入:xx.xx.xx.xx:11434,可以看到效果如下所示:编辑

1.从机只需下载cherry studio即可,不需要下载ollama,模型等。

2.打开cherry studio设置界面,选中ollama:

一、安装ollama

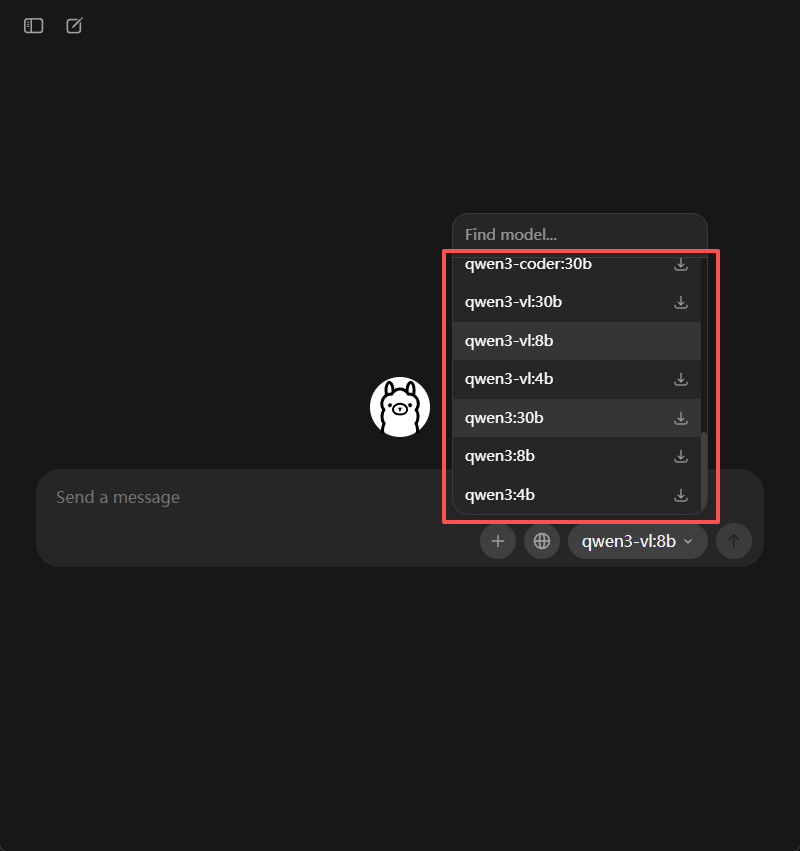

二、下载模型

1.打开ollama

选择我们想要使用的模型,然后选中之后,随便发送一个文字,即可下载(需要根据自己电脑的配置来进行选择)

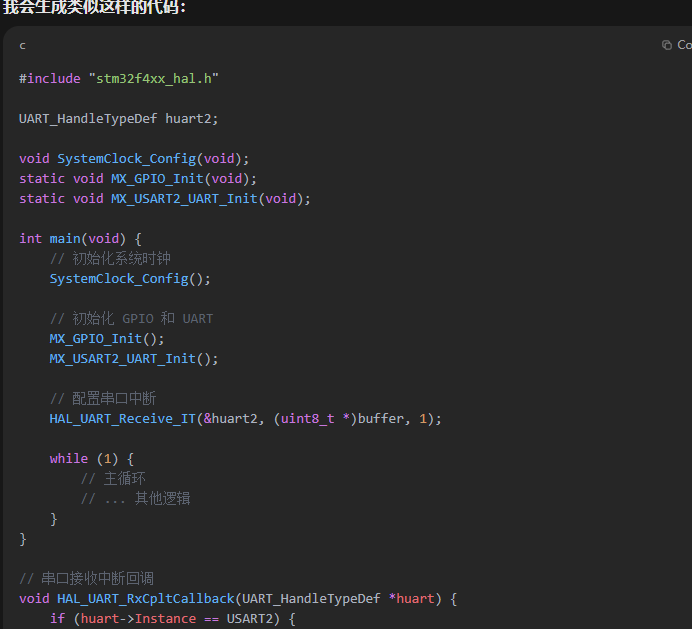

2.实现效果:询问您好,帮我实现嵌入式代码的生成

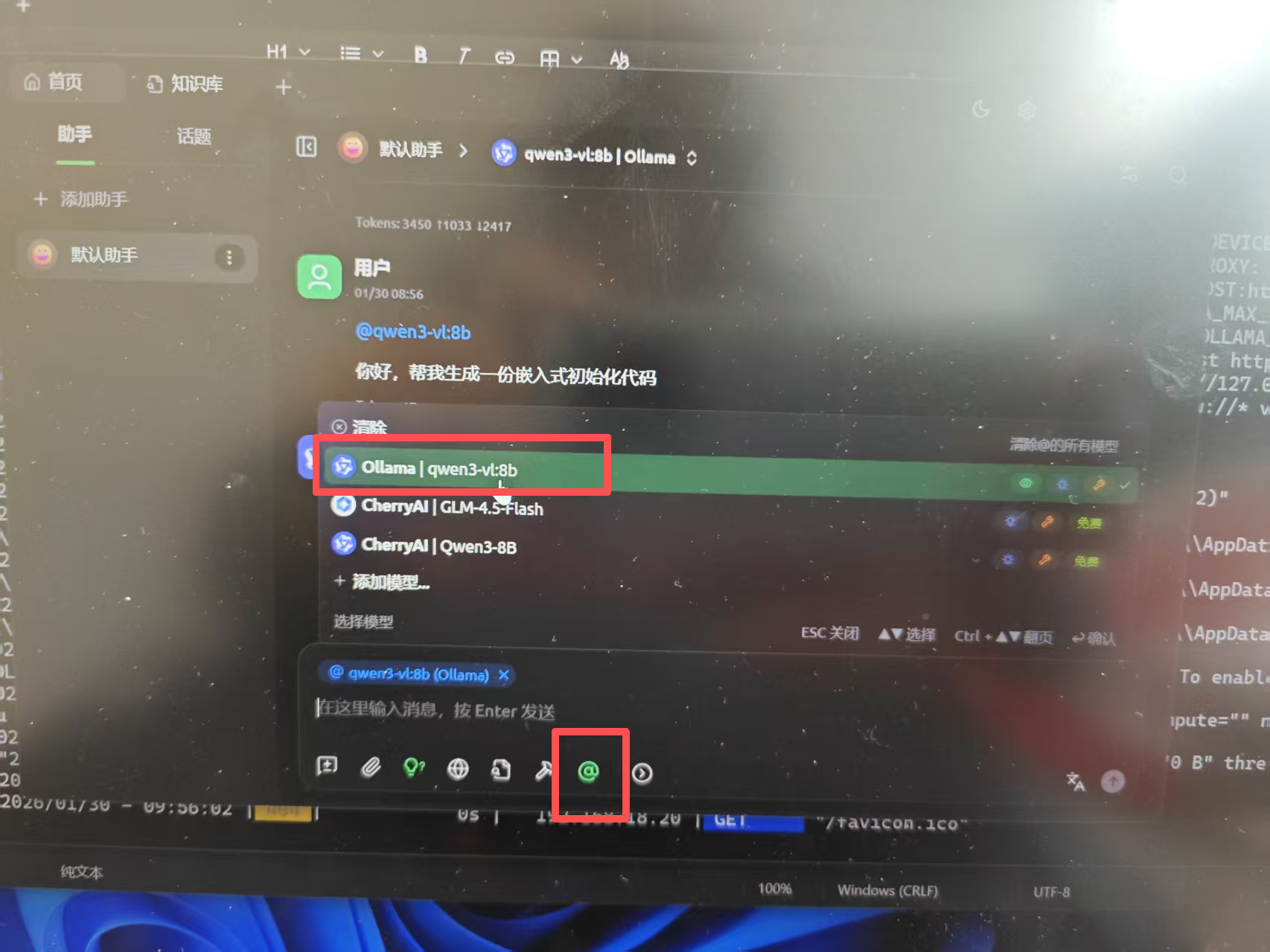

三、安装cherry studio(可选)

安装这个软件主要是建立自己的知识库等信息。

Cherry Studio 官方网站 - 全能的 AI 助手

下载之后打开如下所示,按照如此配置就可以连接到ollama中的本地下载好的模型了。

使用方式:

四、同一局域网其它设备访问该主机模型

1.主机操作:

1.关闭ollama

需把右下角的ollama点击退出,否则ollama只能是本地localhost的端口,其它设备访问不到,所以我们需要关闭。

2.开启windows powershell

输入命令:

$env:OLLAMA_HOST = "0.0.0.0:11434"

ollama serve

开启之后,powershell窗口不要关闭,放到后台,之后ipconfig看一下自己的地址,得到自己的地址: IPv4 地址 . . . . . . . . . . . . : xx.xx.xx.xx

3.打开浏览器输入:xx.xx.xx.xx:11434,可以看到效果如下所示:

同时,其它设备上(从机),打开浏览器输入xx.xx.xx.xx:11434也可出现如上图所示效果。注:xx.xx.xx.xx是主机的ip地址。

2.从机操作

1.从机只需下载cherry studio即可,不需要下载ollama,模型等。

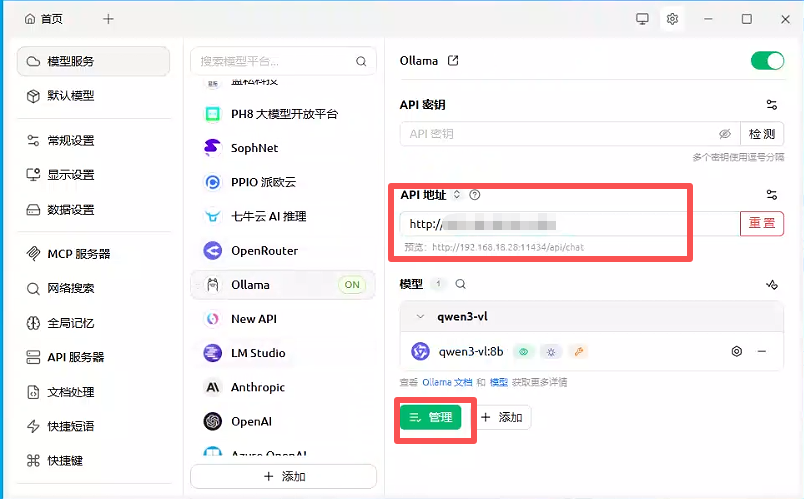

2.打开cherry studio设置界面,选中ollama:

将API地址修改为主机的ip地址即:http://xx.xx.xx.xx:11434,再次点击管理即可,会加载远程主机的本地模型。我们选中它并且使用。至此所有配置完毕。

五、温馨提示

如果想要配置成局域网内一台主机,其它从机访问它,只需主机下载ollama+下载本地模型,从机只需下载一个cherry studio即可;

如果想要实现每台电脑不通过局域网连接主机,则需要每台电脑都要下载ollama+下载本地模型+cherry studio(按需),即没有主机从机之分。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)