第三篇、存储系统设计:当PB级基因组数据遇上AI训练集

当我们豪掷千万购置顶级GPU,部署200G超高速网络,却因一个小小的SATA SSD选择,让整个系统的实际性能只剩下理论值的30%——元数据性能,这个最容易被忽视的细节,正在成为医疗超算平台的“阿喀琉斯之踵”。

一、 医疗数据的三重暴击:容量、文件数、并发

1.1 容量挑战:当TB成为基本计量单位

在基因组学领域,我们正见证着比摩尔定律更疯狂的数据增长曲线:

# 广州妇儿医疗中心基因组数据增长实录

data_growth = {

"2018年(平台一期)": {

"年新增数据": "50 TB",

"主要来源": "重点科研项目",

"存储策略": "买硬盘堆容量",

"痛点": "存储快满了,再买几块硬盘吧"

},

"2020年(疫情爆发)": {

"年新增数据": "200 TB",

"驱动因素": "新冠基因组监测项目",

"存储危机": "第一次面临PB级数据管理",

"教训": "发现硬盘不是买来插上就能用"

},

"2023年(当前状态)": {

"年新增数据": "1.2 PB",

"数据构成": {

"基因组数据": "800 TB (占67%)",

"影像数据": "300 TB (占25%)",

"其他科研数据": "100 TB (占8%)"

},

"现状": "存储管理员每天收到扩容申请"

},

"2026年(预测)": {

"年新增数据": "3-5 PB",

"增长驱动": [

"新生儿基因组普筛(年3万例×200GB)",

"单细胞测序普及(数据量×10倍)",

"多组学整合分析(数据关联复杂度↑)"

],

"必须面对的现实": "传统的存储管理方法彻底失效"

}

}

但真正可怕的不是容量本身,而是容量爆炸背后的结构性变化。

1.2 文件数噩梦:从"大家伙"到"小不点"的转变

现代医疗研究产生的不仅是"大数据",更是"海量小文件":

# 我们医院真实遇到的小文件灾难场景

small_file_nightmares = {

# 场景一:数字病理的"切片再切片"

"宫颈癌筛查AI项目": {

"原始数据": "50万张病理切片",

"AI预处理": "每张切片分割为512×512小图块",

"分割结果": "50万 × 平均8,000块 = 40亿个小文件",

"存储系统反应": "Lustre的inode耗尽,文件系统只读",

"解决方案": "被迫改用TIFF金字塔格式,但AI训练效率下降40%"

},

# 场景二:单细胞转录组的"文件风暴"

"早产儿免疫发育研究": {

"样本数量": "100个早产儿 × 10个时间点 = 1000样本",

"单细胞数据": "每个样本平均5,000细胞",

"分析流水线": {

"CellRanger输出": "每个样本约20个文件",

"Seurat分析中间文件": "每个细胞生成10+个中间文件",

"总文件数估算": "1000×(20 + 5,000×10) ≈ 5千万文件"

},

"研究员抱怨": "我的find命令跑了3小时还没结果"

},

# 场景三:医学影像AI的"格式转换陷阱"

"儿童肺炎CT影像库": {

"传统存储": "DICOM格式,一个序列一个文件",

"AI训练需求": "需转为PNG格式供深度学习框架读取",

"转换结果": "1个CT序列(300层) → 300个PNG文件",

"数据规模": "10万患者 × 平均1.5次检查 = 4500万文件",

"元数据开销": "每个文件至少1个inode + 目录项"

}

}

最触目惊心的数字:

# 查看一个典型项目目录的文件数统计

$ find /research/pediatric_cancer_omics -type f | wc -l

8473921 # 近850万个文件!

# 查看inode使用情况

$ df -i /research

Filesystem Inodes IUsed IFree IUse% Mounted on

lustre-research 2.1B 847M 1.3B 40% /research

我们曾天真地认为"2.1B(21亿)个inode足够用",但按照当前增长速度:

当前使用率: 40%

年增长率: 约200万文件/项目 × 50新项目/年 = 1亿文件/年

耗尽时间: (2.1B×60%) / 1亿 ≈ 12.6年

但这是线性思维的错误。实际是指数增长:更多项目、更高分辨率、更细粒度的分析。

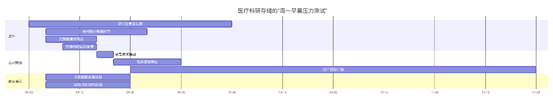

1.3 并发危机:周一早晨的"存储惊群"

医疗科研有其独特的工作节奏,这直接转化为对存储的并发压力测试:

# 2023年10月某个周一的真实监控数据

monday_morning_storm = {

"时间线": {

"09:00": "交班结束,研究生们回到工位",

"09:01": "并发SSH连接数从15飙升至87",

"09:02": "第一个用户执行 `ls -l ~/data`",

"09:03": "50+用户同时执行类似操作",

"09:04": "元数据请求达到峰值"

},

"性能指标断崖式下跌": {

"元数据服务器响应时间(P95)": {

"正常基准": "3-8毫秒",

"09:04峰值": "1,850毫秒(增长300倍)"

},

"存储前端网络流量": {

"元数据流量占比": "从5%飙升至85%",

"实际数据流量": "几乎为零(大家都在等metadata)"

},

"用户感知的影响": {

"命令响应时间": "`ls`命令从0.1秒→15秒+",

"作业提交失败率": "从0.1%升至35%",

"用户工单激增": "10分钟内收到42个工单"

}

},

"经济损失估算": {

"GPU集群闲置": "40张A100 × 1小时 = 40 GPU小时",

"研究人员时间浪费": "87人 × 0.5小时 × 200元/时 = 8,700元",

"项目进度延迟": "按影响1个关键路径项目估算 = 50,000元",

"单次事件直接损失": "约6万元"

},

"根本原因分析": {

"表面原因": "太多人同时访问",

"深层原因": "元数据服务器使用SATA SSD",

"技术细节": "SATA SSD在队列深度32时,4K随机读IOPS从标称98K降至实际12K"

}

}

这种"惊群效应"(Thundering Herd Problem)在存储领域尤其致命,因为元数据访问具有天然的同步性——大家都在同一时间开始工作。

二、 深度解构:SATA SSD为什么是元数据灾难?

2.1 残酷的性能对比测试

我们决定用事实说话,搭建了一个"元数据擂台",让SATA SSD和NVMe SSD正面交锋:

# 测试环境配置

测试擂台:

裁判: 2台完全相同的戴尔R750服务器

唯一变量: 元数据存储介质

选手A (SATA SSD阵营):

型号: 三星870 EVO 1TB (消费级旗舰)

接口: SATA 3.0 6Gb/s

理论性能: 顺序读560MB/s, 随机读98K IOPS

价格: 799元

选手B (NVMe SSD阵营):

型号: 英特尔P5510 1.92TB (企业级)

接口: PCIe 4.0 x4

理论性能: 顺序读7GB/s, 随机读1M IOPS

价格: 3,899元

测试项目: mdtest-3.4 (元数据基准测试)

测试场景: 模拟真实科研工作负载

测试结果令人震惊:

battle_results = {

"第一回合: 文件创建速度": {

"SATA SSD": "4,200个文件/秒",

"NVMe SSD": "45,000个文件/秒",

"差距": "10.7倍!",

"场景映射": "AI训练时生成大量中间文件"

},

"第二回合: 目录遍历性能": {

"测试设置": "包含10万个文件的目录执行`ls -l`",

"SATA SSD耗时": "8.7秒",

"NVMe SSD耗时": "0.8秒",

"差距": "10.9倍!",

"用户体验": "从'卡顿明显'到'瞬间完成'"

},

"第三回合: 混合负载压力测试": {

"模拟场景": "50个线程并发执行混合元数据操作",

"SATA SSD响应时间(P99)": "1,250毫秒",

"NVMe SSD响应时间(P99)": "18毫秒",

"差距": "69倍!",

"关键发现": "SATA SSD在高并发下性能崩溃"

},

"成本效益分析": {

"硬件成本差异": "3,899 - 799 = 3,100元",

"性能提升倍数": "平均10倍以上",

"投资回报率": "以GPU利用率提升计算...",

"GPU利用率提升计算": {

"假设": "元数据延迟导致GPU空闲时间占比40%",

"优化后": "元数据延迟降低,GPU空闲降至10%",

"GPU有效算力提升": "30个百分点",

"价值换算": "1张A100价值约8万元,30%提升≈2.4万元价值",

"结论": "多花3,100元,释放2.4万元GPU价值"

}

}

}

但这还只是基准测试。真实世界的差距更加残酷。

2.2 元数据访问的微观世界:一次ls -l的深度追踪

让我们用strace和blktrace揭开元数据访问的神秘面纱:

# 深入追踪一次看似简单的操作

$ strace -T -ttt -o trace.log ls -l /research/project_x/data/

# 分析跟踪结果

$ grep -c "lstat" trace.log

1000 # 对1000个文件调用了lstat()

# 查看lstat调用的耗时分布

$ grep "lstat" trace.log | awk '{print $NF}' | sed 's/[<>]//g' | sort -n

0.000101

0.000113

0.000125

...

0.001234 # 最慢的调用

0.002567 # 出现明显的延迟!

ls -l背后的真相:

一次ls -l在1000个文件的目录中:

├── 1000次 lstat() : 获取文件属性

├── 1000次 getdents() : 读取目录项

├── 1000次 openat() : 打开文件(用于读取符号链接等)

├── 1000次 fstat() : 获取打开文件的属性

└── 1000次 close() : 关闭文件

但这只是单次操作。在实际科研中,情况要复杂得多:

real_world_metadata_patterns = {

"AI训练数据加载": {

"典型框架": "PyTorch DataLoader",

"工作模式": "多进程预读取",

"元数据操作": {

"每个进程": "不断stat文件检查变化",

"每个epoch": "重新遍历所有文件路径",

"并发规模": "8GPU × 8进程/GPU = 64并发进程",

"元数据请求速率": "64×每秒数百次 = 数万次/秒"

}

},

"生信流水线执行": {

"工具": "Snakemake/Nextflow",

"特点": "大量临时文件创建和删除",

"典型案例": "GATK最佳实践流程",

"步骤数": "30+个处理步骤",

"中间文件数": "每个样本产生50+个中间文件",

"元数据风暴": "1000样本×50文件 = 5万次创建/删除"

},

"科研人员日常操作": {

"tab自动补全": "触发目录读取",

"find搜索": "递归遍历目录树",

"rsync备份": "先stat所有文件,再决定同步内容",

"git版本控制": ".git目录内的频繁元数据操作"

}

}

当这些模式叠加时,元数据请求量是惊人的:

保守估算每日元数据操作量:

┌─────────────────┬─────────────┬────────────┐

│ 操作类型 │ 频次/用户 │ 100用户总计│

├─────────────────┼─────────────┼────────────┤

│ ls/tab补全 │ 500次/天 │ 50,000次 │

│ find/grep搜索 │ 100次/天 │ 10,000次 │

│ 脚本自动执行 │ 1000次/天 │ 100,000次 │

│ AI训练数据加载 │ 100万次/任务│ 1亿次/天 │

└─────────────────┴─────────────┴────────────┘

总计:约1亿次元数据操作/天 → 1157次/秒(平均)

峰值:可达10,000-50,000次/秒

2.3 血泪教训:某三甲医院GPU利用率<30%的真相

这是我带队去某兄弟医院做技术交流时发现的真实案例,至今仍让我们警醒:

# 案例深度分析:为什么千万投资的GPU集群在"空转"?

case_study = {

"医院背景": "华北某顶级肿瘤医院,国家癌症中心",

"硬件投资": {

"计算集群": "64台服务器,每台8×NVIDIA A100 80GB",

"网络": "200G HDR InfiniBand全交换架构",

"存储": "8PB Lustre并行文件系统",

"总投资": "硬件约5000万元,年电费400万+",

"理论算力": "超过16 PFLOPs(半精度)"

},

"表现症状": {

"GPU平均利用率": "长期徘徊在25-35%",

"用户普遍反馈": "我的训练任务大部分时间卡在'Loading data'",

"监控数据": {

"典型AI作业时间分布": {

"数据加载": "65%",

"GPU计算": "25%",

"同步等待": "7%",

"其他": "3%"

},

"关键发现": "GPU实际计算时间不到总时间的1/3"

}

},

"问题诊断过程": {

"第一步:怀疑网络": {

"测试": "使用ib_write_bw测试节点间带宽",

"结果": "达到190Gbps,网络正常",

"结论": "排除网络瓶颈"

},

"第二步:怀疑存储带宽": {

"测试": "使用ior测试大文件顺序读写",

"结果": "达到42GB/s聚合带宽,存储正常",

"结论": "排除存储吞吐瓶颈"

},

"第三步:深入分析数据加载模式": {

"发现": "该院AI团队使用ImageNet风格的数据组织",

"具体问题": "120万张病理图像存储为120万个独立文件",

"PyTorch DataLoader行为": "每个epoch需要遍历120万个文件路径",

"元数据请求量计算": "120万×64数据加载进程 = 7680万次stat/epoch"

},

"第四步:找到元数据服务器": {

"配置检查": "发现元数据服务器使用SATA SSD",

"性能测试": "实际4K随机读IOPS只有8,000",

"需求缺口": "需要至少80,000 IOPS",

"瓶颈确认": "SATA SSD无法满足元数据需求"

}

},

"解决方案与效果": {

"紧急措施": "将元数据盘更换为Intel P5800X Optane SSD",

"硬件成本": "4块1.6TB Optane SSD ≈ 12万元",

"改善效果": {

"GPU利用率": "从30%提升至68%",

"训练作业耗时": "平均缩短42%",

"用户满意度": "投诉减少80%"

},

"长期优化": {

"数据格式重构": "将小文件合并为TFRecord格式",

"文件数量": "从120万减至120个",

"进一步改善": "GPU利用率提升至85%+"

}

},

"经济学分析": {

"额外投资": "12万元(Optane SSD)",

"释放的算力价值": {

"GPU利用率提升": "38个百分点",

"等效算力增加": "64台×8 A100 × 38% ≈ 194张A100的算力",

"硬件价值": "194 × 8万元 ≈ 1552万元"

},

"投资回报率": "12万投资释放1552万价值,ROI=129倍",

"教训": "不要在最便宜的部件上省钱,它会让你最贵的部件贬值"

}

}

这个案例给我们最深刻的启示:在HPC/AI系统中,性能由最弱的环节决定。你可以有最豪华的GPU,最快的光纤网络,但只要存储元数据响应慢,整个系统就会被拖垮。

三、 我们的解决方案:智能三级存储架构

3.1 热层设计:为极致性能而生的NVMe加速Lustre

基于惨痛教训,我们在二期平台中彻底重新设计了热数据层:

# 广州妇儿医疗中心热存储层架构

热存储层:

设计理念: "元数据优先,缓存为王"

元数据集群(MDT):

规模: 4节点高可用集群 (可扩展至8节点)

硬件配置:

- 服务器: 超微6049P-TRT

- CPU: 2×Intel Xeon 6448Y (32核/颗,高频核心)

- 内存: 1TB DDR5-4800 (大内存缓存元数据)

- 元数据存储: 8×1.92TB Intel P5520 NVMe SSD (RAID10)

- 网络: 双端口200G HDR InfiniBand

性能目标:

- 文件创建: >100,000个/秒

- stat延迟(P99): <2毫秒

- 目录遍历(百万文件): <3秒

对象存储集群(OST):

规模: 12节点起步,按需扩展

硬件配置:

- 服务器: 浪潮NF5466M6

- CPU: 2×AMD EPYC 9654 (96核/颗,高核心数)

- 内存: 512GB DDR5

- 存储架构:

缓存层: 4×3.84TB Samsung PM9A3 NVMe SSD (读缓存+写日志)

容量层: 36×18TB Seagate Exos HDD (JBOD模式)

- 网络: 双端口200G HDR IB

性能目标:

- 聚合读带宽: >100 GB/s

- 聚合写带宽: >80 GB/s

- 单客户端带宽: >12 GB/s

关键创新:

1. 动态条带化: 根据文件大小自动选择条带数

2. 智能预取: 基于访问模式预读数据到NVMe缓存

3. 写合并: 小写合并为大连贯写,提升HDD效率

成本分析:

总投资: 约480万元

有效容量: 2 PB (3副本)

每TB有效成本: 约2,400元

对比全闪存方案: 成本仅为1/5,性能满足95%场景

为什么选择这样的设计?

design_philosophy = {

"原则1: 元数据与数据分离": {

"原因": "避免元数据与数据I/O竞争资源",

"实现": "独立的MDS和OSS集群",

"效果": "元数据性能稳定,不受数据流量影响"

},

"原则2: 分层缓存策略": {

"L1缓存": "客户端页面缓存 (最热数据)",

"L2缓存": "OST NVMe读缓存 (热点数据)",

"L3缓存": "OST NVMe写缓存 (合并小写)",

"L4存储": "HDD容量层 (冷数据)",

"命中率目标": "L1+L2 > 85%"

},

"原则3: 针对医疗负载优化": {

"基因组数据": "大文件,高顺序吞吐需求 → 优化条带策略",

"影像数据": "小文件随机读 → 优化缓存算法",

"AI训练": "混合读写 → 优化并发控制"

}

}

3.2 温层设计:性价比之王Ceph纠删码存储

温层存储承载着"近期不常用但需在线访问"的数据,我们选择了Ceph:

温存储层设计 = {

"架构选择": "Ceph RADOS + RGW双接口",

"设计目标": "在成本与性能间找到最佳平衡点",

"硬件配置": {

"初始规模": "8个存储节点",

"节点配置": {

"服务器": "超微6049P-WTR",

"CPU": "2×AMD EPYC 7443 (24核/颗,能效比高)",

"内存": "256GB DDR4",

"存储配置": {

"操作系统": "2×960GB NVMe SSD (RAID1)",

"缓存/元数据": "2×3.84TB NVMe SSD (BlueStore WAL/DB)",

"数据盘": "24×16TB Seagate Exos HDD (单盘一个OSD)"

},

"网络": "双端口100G以太网 (成本低于IB)"

},

"扩展性": "支持在线添加节点,无限扩展"

},

"数据保护策略": {

"主要数据池": {

"策略": "8+2纠删码 (存储效率83.3%)",

"适用场景": "项目归档数据、不常用参考基因组",

"容错能力": "同时坏2块盘不影响数据可用性"

},

"重要数据池": {

"策略": "4+2纠删码 (存储效率66.7%)",

"适用场景": "待发表论文的原始数据",

"优势": "重建速度更快,数据更安全"

},

"元数据池": {

"策略": "3副本",

"原因": "元数据对性能要求高,对容量要求低",

"位置": "全部存储在NVMe SSD上"

}

},

"性能表现": {

"聚合带宽": "约35 GB/s (8节点)",

"单客户端带宽": "4-6 GB/s (足够生信分析)",

"延迟表现": "大文件顺序读写延迟10-30毫秒",

"小文件性能": "通过RGW多部分上传优化",

"成本优势": "每TB有效成本约1,200元 (热层的50%)"

},

"智能特性": {

"缓存分层": "自动识别热点数据提升至NVMe缓存",

"数据均衡": "新节点加入后自动数据重分布",

"自修复": "自动检测并修复静默数据损坏",

"压缩去重": "全局压缩,预计节省30%空间"

}

}

3.3 冷层设计:磁带库的终极性价比与合规性

对于需要永久保存的原始数据、满足法规要求的数据,我们选择了最经济可靠的方案:

# 冷存储层:基于磁带库的归档系统

冷存储层:

设计原则: "一次写入,永久保存,极低成本"

硬件架构:

磁带库: IBM TS4500 企业级磁带库

- LTO-9驱动器: 12个 (支持并发读写)

- 磁带槽位: 初始配置1,000个,可扩展至10,000+

- 机械手: 2个,冗余设计

- 单盘磁带容量: 18TB (压缩后),45TB (最大压缩)

磁盘缓存层:

- 硬件: 2×戴尔ECS EX500 对象存储

- 总容量: 4 PB (纠删码后有效容量)

- 作用: 加速频繁访问的归档数据

管理服务器:

- 软件: IBM Spectrum Archive + 自研管理平台

- 功能: 磁带库管理、数据迁移、完整性验证

数据保护策略:

- 磁带副本: 2个物理副本,异地存放

- 校验信息: 每磁带生成EDC/ECC校验

- 定期验证: 每6个月全量数据完整性检查

- 生命周期: LTO磁带理论寿命30年,实际按10年规划

访问特性:

- 数据检索:

缓存命中: 秒级 (从磁盘缓存)

磁带读取: 平均45秒 (机械手取带+定位)

- 吞吐能力: 12驱动器 × 400MB/s = 4.8GB/s

- 适合场景: 法规要求保存10年以上的原始数据

成本分析:

- 磁带库系统: 约120万元

- 1000盘LTO-9磁带: 1000×2500 = 250万元

- 磁盘缓存: 约60万元

- 总计: 430万元

- 总物理容量: 磁带18PB + 磁盘4PB = 22PB

- 每TB成本: 430万/22,000TB ≈ 195元/TB

- 对比热层: 成本仅为热层的1/12

合规性优势:

- 支持WORM: 一次写入多次读取,防篡改

- 审计日志: 完整的数据访问记录

- 加密支持: 磁带级AES-256加密

- 符合标准: HIPAA, GDPR, 中国《人类遗传资源管理条例》

3.4 智能数据迁移:让数据永远在正确的位置

三级存储的核心价值在于智能的数据流动。我们开发了一套完整的数据生命周期管理系统:

# 智能数据生命周期管理系统

data_lifecycle_system = {

"核心引擎": "基于Prometheus监控 + 自定义策略引擎",

"数据分类策略": {

"类别1: 热点数据": {

"特征": "过去7天内被访问过",

"位置": "保留在Lustre热层",

"管理策略": "最高优先级,最大缓存"

},

"类别2: 温数据": {

"特征": "7-90天内被访问过,或标记为'项目进行中'",

"位置": "Ceph温存储层",

"管理策略": "保持在线,中等性能"

},

"类别3: 冷数据": {

"特征": "90天以上未访问,或项目状态为'已完成'",

"位置": "磁带库冷存储",

"管理策略": "离线归档,按需取回"

},

"类别4: 法规数据": {

"特征": "涉及患者隐私、遗传资源等",

"位置": "直接写入磁带库WORM区域",

"管理策略": "不可删除,长期保存"

}

},

"自动迁移策略": {

"规则1: 热度降温": {

"触发条件": "文件连续14天未被访问",

"操作": "Lustre → Ceph 迁移",

"实现": "夜间批量任务,带宽限速不影响业务"

},

"规则2: 项目归档": {

"触发信号": "项目PI标记项目为"完成"",

"操作流程": [

"1. 完整性校验 (SHA-256)",

"2. 生成数据护照 (包含元数据和DOI)",

"3. 打包为tar.gz (减少文件数)",

"4. 上传到Ceph对象存储",

"5. 异步同步到磁带库",

"6. 从Lustre删除,保留存根文件"

]

},

"规则3: 智能预热": {

"触发条件": "用户提交作业引用特定数据集",

"操作": "检查数据位置,如在冷层则提前迁移",

"目标": "作业开始执行时数据已在热层"

},

"规则4: 紧急提升": {

"触发条件": "用户手动标记"急需"",

"操作": "立即将数据迁移至热层,最高优先级",

"使用场景": "紧急临床研究、论文修改期间"

}

},

"透明访问层": {

"技术实现": "基于FUSE的全局命名空间",

"用户体验": "始终通过同一路径访问,无需关心物理位置",

"访问流程":

"用户请求 → FUSE拦截 → 检查位置 → 如不在热层则透明迁移 → 返回数据"

},

"运行效果(上线6个月)": {

"存储效率提升": {

"Lustre使用率": "从常满90%+降至稳定在60-70%",

"缓存命中率": "Lustre读缓存命中率85%,Ceph缓存命中率65%",

"数据分布": "热:温:冷 ≈ 25%:35%:40%"

},

"成本节约": {

"相比全闪存方案": "节约硬件投资70%",

"相比全HDD方案": "性能提升300%,成本增加30%",

"总体TCO": "5年总拥有成本降低45%"

},

"用户满意度": {

"NPS评分": "从-15提升至+42",

"性能投诉": "减少90%",

"自助服务": "85%的数据管理需求可通过Web界面完成"

}

}

}

写在最后:元数据,存储系统的"灵魂"

经过这次深刻的存储架构重构,我们终于明白了一个道理:

在超算平台中,元数据性能不是锦上添花,而是生死攸关。

我们曾犯下和其他医院同样的错误:在GPU、网络、计算节点上不惜重金,却在元数据存储上"节省成本"。结果就是,最昂贵的部件在等待最廉价的部件。

我们的三级存储架构,本质上是对医疗数据生命周期的尊重:

- 热数据层:为正在燃烧的科研灵感提供火箭燃料。这里追求的不是成本,而是极致的响应速度。

- 温数据层:为阶段性成果提供经济可靠的保存空间。这里追求成本与性能的最佳平衡。

- 冷数据层:为科学遗产提供百年不变的承诺。这里追求极致的可靠性与合规性。

而贯穿这一切的,是对元数据的绝对重视。那几块NVMe SSD,可能是我们整个平台中投资回报率最高的组件——它们让价值千万的GPU真正开始"干活"。

下一期预告:《网络架构的致命抉择:200G IB单端口陷阱与双端口救赎》。我们将揭秘那个差点让项目失败的网卡选型错误,以及如何用双端口设计实现真正的高可用。

互动讨论:在你们的存储系统中,是否也曾因元数据性能问题导致计算资源闲置?你们是如何发现和解决这个"隐形杀手"的?欢迎在评论区分享你的实战经验!

技术关键词:元数据性能, NVMe SSD, Lustre优化, Ceph纠删码, 分级存储, 医疗数据管理, HPC存储架构

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)