大模型技术发展全景图:从符号主义到多模态智能的演进之路

本文系统梳理了大模型技术发展历程,从1950年代符号主义开始,经历统计机器学习、神经网络革命,到2017年Transformer架构突破,再到预训练范式确立、规模扩张与多模态融合。文章详细分析了架构演进逻辑、训练技术突破及能力跃迁轨迹,并探讨当前挑战与未来方向,为理解大模型技术发展提供了全面视角。

本文系统梳理了大模型技术发展历程,从1950年代符号主义开始,经历统计机器学习、神经网络革命,到2017年Transformer架构突破,再到预训练范式确立、规模扩张与多模态融合。文章详细分析了架构演进逻辑、训练技术突破及能力跃迁轨迹,并探讨当前挑战与未来方向,为理解大模型技术发展提供了全面视角。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

一、史前时代:理论奠基与早期探索(1950s-2017)

1. 符号主义与规则系统(1950s-1980s)

- 核心思想:基于人类语言规则编写程序,如ELIZA(1966,模拟心理治疗师)、SHRDLU(1970,积木世界推理)

- 局限:手工规则难以覆盖复杂语言现象,扩展性差,无法处理歧义与语境变化

2. 统计机器学习时代(1990s-2010s)

- 技术突破:n-gram模型、隐马尔可夫模型(HMM)、条件随机场(CRF)

- 代表成果:统计机器翻译、文本分类与情感分析

- 局限:依赖人工特征工程,长距离依赖建模能力弱,语义理解不足

3. 神经网络与词嵌入革命(2013-2017)

- Word2Vec(2013,Google):首次证明无监督词向量可有效捕获语义关系,开启分布式表示时代

- GloVe(2014,斯坦福):基于全局词频统计的词嵌入方法,提升语义表示质量

- Seq2Seq(2014,Google):编码器-解码器架构,解决机器翻译等序列转换问题

- 注意力机制(2014,Bahdanau):缓解长序列信息丢失问题,为后续Transformer奠定基础

- ELMo(2018,艾伦AI):上下文相关词嵌入,打破静态词向量局限

二、Transformer革命:现代大模型技术基石(2017)

Google团队在NeurIPS发表《Attention Is All You Need》,提出Transformer架构,彻底改变NLP发展轨迹:

| 核心创新 | 技术突破 | 价值意义 |

| 自注意力机制 | 并行计算,全局依赖建模,O(n²)复杂度 | 解决RNN/LSTM串行计算瓶颈,提升长文本处理能力 |

| 多头注意力 | 多维度语义表示,捕捉不同类型依赖关系 | 增强模型对复杂语义的理解能力 |

| 位置编码 | 注入序列位置信息,弥补无循环结构缺陷 | 让模型感知词序,维持语言结构理解 |

| 残差连接+层归一化 | 缓解梯度消失,加速训练,提升模型深度 | 支持构建更深层网络(如GPT-3的96层) |

| 前馈神经网络 | 非线性变换,增强特征表达能力 | 为注意力输出添加复杂非线性映射 |

Transformer摒弃了RNN/LSTM的串行计算模式,实现序列数据的并行处理,为模型规模指数级增长提供了技术基础。

三、预训练范式确立:大模型的诞生(2018-2020)

2018年成为大模型发展的分水岭,三大架构分支从Transformer演化而来,形成技术路线分化:

1. 三大核心架构分支

| 架构类型 | 代表模型 | 核心特点 | 适用场景 |

| Encoder-only (编码器) | BERT(2018)、RoBERTa、ALBERT | 双向注意力,掩码语言建模(MLM) | 文本理解、分类、问答、实体识别 |

| Decoder-only (解码器) | GPT系列(2018-至今)、LLaMA、Mistral | 自回归生成,单向注意力 | 文本生成、对话、代码生成 |

| Encoder-Decoder (编解码) | T5(2019)、BART、UL2、Gemini | 双向理解+生成,统一文本到文本框架 | 机器翻译、摘要、文本编辑 |

2. 关键里程碑模型

- GPT-1(2018,OpenAI):首个生成式预训练Transformer,1.17亿参数,展示自回归语言模型潜力

- BERT(2018,Google):双向预训练,在11项NLP任务中刷新SOTA,开创“预训练+微调”范式

- GPT-2(2019,OpenAI):15亿参数,展示零样本学习能力,无需特定任务微调即可执行多种任务

- GPT-3(2020,OpenAI):1750亿参数,规模跃迁带来涌现能力(推理、代码、翻译等),推动Prompt工程兴起

- T5(2019,Google):统一文本到文本框架,将所有NLP任务转化为文本生成,增强模型通用性

3. 训练技术突破

- 自监督学习:预训练阶段无需人工标注,利用海量无标签数据(如掩码语言建模、下一个token预测)

- 预训练-微调范式:两阶段训练降低任务适配成本,提升模型迁移能力

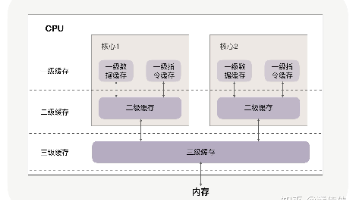

- 模型并行与数据并行:解决超大模型训练的内存与计算瓶颈,支持千亿级参数模型训练

四、规模扩张与能力跃迁:从理解到生成(2021-2022)

1. 模型规模军备竞赛

- PaLM(2022,Google):5400亿参数,多语言能力与复杂推理突破

- GPT-3.5系列(2022,OpenAI):通过RLHF优化,对话能力大幅提升,为ChatGPT奠定基础

- LLaMA(2023,Meta):开源生态兴起,7B/13B/33B/65B参数版本,降低大模型使用门槛

2. 训练技术创新

- LoRA(2021):低秩适配技术,仅训练少量参数(约0.1%)即可适配特定任务,大幅降低微调成本

- RLHF(2022,OpenAI):人类反馈强化学习,三阶段训练流程(预训练→SFT→RLHF),提升模型对齐人类价值观能力

- 监督微调(SFT):用高质量问答数据教模型像助手一样说话

- 奖励模型训练(RM):训练模型评估回答质量

- 强化学习优化(PPO):基于奖励信号优化模型输出

3. 能力突破

- 上下文学习(ICL):通过示例演示完成任务,无需参数更新

- 思维链(CoT):引导模型生成推理步骤,提升复杂问题解决能力

- 代码生成:如Codex(2021),在代码语料上训练,实现自然语言到代码转换

五、多模态融合与智能体崛起(2023-2025)

1. 多模态大模型时代

- GPT-4(2023,OpenAI):支持文本、图像输入,多模态理解与生成能力

- Gemini(2023,Google):原生多模态,支持文本、图像、音频、视频,实时交互能力

- SAM(2023,Meta):分割一切模型,视觉基础模型与语言模型融合

2. 训练技术演进

- DPO(2023):直接偏好优化,跳过奖励模型训练,降低RLHF复杂度与成本,训练效率提升约50%

- RLVR(2025):可验证奖励强化学习,在数学、编程等可自动验证环境中训练,提升模型追求真理能力,而非仅讨好人类

- MoE(混合专家):如Switch Transformer、Mixtral,稀疏激活机制,在保持参数规模的同时降低计算成本,提升训练效率

3. 应用形态革新

- 智能体(Agent):大模型+工具调用+记忆系统,如AutoGPT、GPT-4 Plugins,可自主完成复杂任务

- 长上下文处理:GPT-4 Turbo支持128k上下文窗口,Claude 3支持200k+,提升信息检索与多文档分析能力

- 行业大模型:金融、医疗、法律等垂直领域定制,如 BloombergGPT、Med-PaLM 2

六、技术路径核心逻辑与关键转变

1. 模型架构演进逻辑

- 从串行计算到并行计算(Transformer核心突破)

- 从单一任务到通用任务(预训练范式)

- 从稠密模型到稀疏模型(MoE提升效率)

- 从文本到多模态(感知能力扩展)

2. 训练技术演进路径

- 从高成本全量更新到低成本参数高效微调

- 从仅关注能力到兼顾能力与对齐人类价值观(RLHF/DPO)

- 从依赖人类反馈到结合自动验证机制(RLVR)

3. 核心能力跃迁轨迹

| 阶段 | 关键能力 | 代表模型 | 技术驱动 |

| 基础理解 | 语义表示、词法句法分析 | Word2Vec、ELMo | 分布式表示学习 |

| 文本生成 | 连贯文本、故事创作 | GPT-1/2、BART | 自回归生成+Transformer |

| 上下文学习 | 零样本/少样本、指令跟随 | GPT-3、T5 | 规模效应+提示工程 |

| 复杂推理 | 思维链、数学/编程 | PaLM、GPT-4 | 超大参数+多任务训练 |

| 多模态交互 | 跨模态理解与生成 | GPT-4V、Gemini | 多模态编码器+统一表示 |

| 自主决策 | 工具调用、任务规划 | AgentGPT、GPT-4 Plugins | 智能体架构+外部工具集成 |

七、当前挑战与未来方向(2025+)

1. 核心挑战

- 效率瓶颈:训练成本高(顶级模型单次训练耗资数亿美元),推理能耗大

- 能力边界:幻觉问题(生成虚假信息)、推理深度有限、长程依赖建模困难

- 安全与伦理:偏见、毒性、隐私泄露、滥用风险

- 可解释性:黑盒模型难以解释决策过程

2. 未来技术路径探索

- 效率革命:

- 模型压缩(蒸馏、量化)与硬件优化(专用AI芯片)

- 稀疏计算与MoE架构普及,提升算力利用率

- 高效训练算法(如DeepSeek-R1的低成本高性能方案)

- 能力深化:

- 推理能力增强(数学、逻辑、编程等)

- 记忆系统优化(长上下文+外部知识库)

- 自主学习能力(模型自我改进与知识更新)

- 安全对齐:

- Constitutional AI(宪法AI):用规则体系引导模型行为

- 可验证输出:结合外部工具验证模型结论,减少幻觉

- 透明化与可解释性技术发展

- 生态扩展:

- 开源与闭源协同发展,降低行业准入门槛

- 垂直领域定制化(行业大模型)

- 边缘部署(轻量化模型适配终端设备)

八、总结:技术路径全景图

大模型技术路径是一场算力、算法、数据三要素协同进化的革命,核心里程碑包括:

- 2017年Transformer架构奠定基础

- 2018年BERT/GPT-1确立预训练范式

- 2020年GPT-3展示规模效应与涌现能力

- 2022年RLHF提升模型对齐能力

- 2023年GPT-4/Gemini开启多模态时代

- 2025年RLVR/DPO推动效率与真理导向训练

未来技术路径将围绕效率提升、能力深化、安全对齐、生态扩展四大方向发展,最终目标是构建通用人工智能,实现更安全、高效、可解释的智能系统,赋能千行百业。

读者福利:倘若大家对大模型感兴趣,那么这套大模型学习资料一定对你有用。

针对0基础小白:

如果你是零基础小白,快速入门大模型是可行的。

大模型学习流程较短,学习内容全面,需要理论与实践结合

学习计划和方向能根据资料进行归纳总结

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

这里我们能提供零基础学习书籍和视频。作为最快捷也是最有效的方式之一,跟着老师的思路,由浅入深,从理论到实操,其实大模型并不难。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献80条内容

已为社区贡献80条内容

所有评论(0)