[论文阅读] AI + 软件工程 | 4万+PR实证分析:揭秘影响人机代码合并的关键因素

AI自动生成Pull Request(PR)日益普及,但合并率低于人工PR。本文基于AIDev数据集的40214个PR样本,提取6大类别64个特征,构建逻辑回归模型对比人机PR及不同AI智能体PR的合并影响因素。研究发现:提交者属性对两类PR的合并结果起主导作用;评审活动对人工PR合并有正向影响,对AI PR则为负向;不同AI智能体的PR合并特征存在显著差异。本文的模型预测性能优异,结论为优化人机

4万+PR实证分析:揭秘影响人机代码合并的关键因素

论文信息

- 论文原标题:Let’s Make Every Pull Request Meaningful: An Empirical Analysis of Developer and Agentic Pull Requests

- 主要作者及机构

- Haruhiko Yoshioka等(奈良先端科学技术大学院大学)

- Haruka Tokumasu等(九州大学)

- Yuki Ota(立命馆大学)

- Nimmi Weeraddana(卡尔加里大学)

- 引文格式(GB/T 7714):

YOSHIOKA H, MONNO T, TOKUMASU H, et al. Let’s make every pull request meaningful: an empirical analysis of developer and agentic pull requests[C]//23rd International Conference on Mining Software Repositories, MSR ’26, Rio de Janeiro, Brazil: ACM, 2026. - 开源资源:数据集及复现包地址 https://zenodo.org/records/18373332

1. 一段话总结

本研究基于AIDev数据集的40,214个PR(含6,618个人工PR和33,596个智能体PR),提取6大类别共64个特征并构建逻辑回归模型,探究人工与AI生成PR的合并影响因素,发现提交者属性对两类PR的合并结果起主导作用,评审相关特征对人工PR合并有正向影响、对智能体PR则为负向影响,且不同AI智能体生成PR的合并特征存在显著差异,研究结论可为人机协作优化PR质量提供指导。

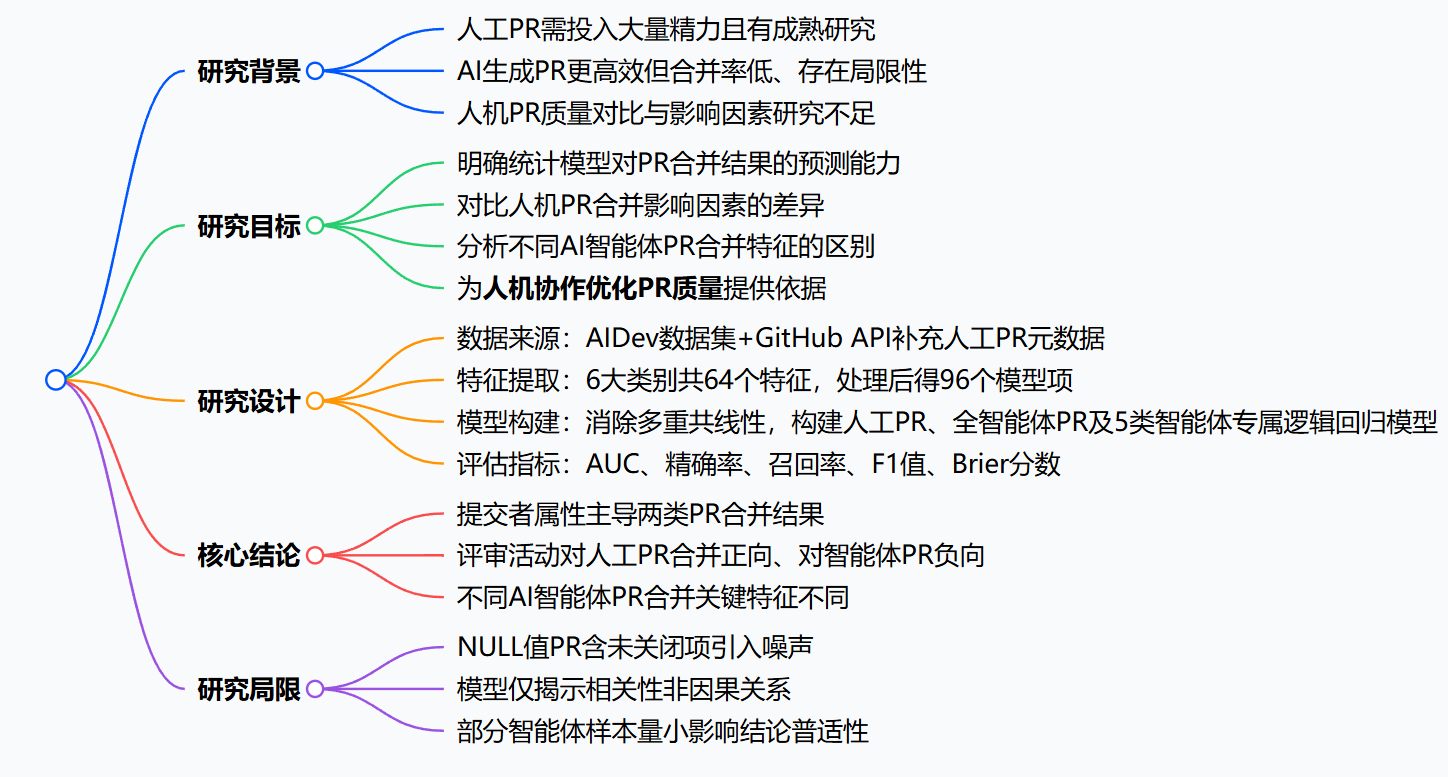

2. 思维导图

3. 详细总结

本研究围绕人工与AI智能体生成PR的合并影响因素展开大规模实证分析,旨在通过对比研究为人机协作优化PR质量提供指导,具体内容如下:

- 研究基础

- 研究背景:人工创建PR需投入代码开发、上下文补充、评审反馈响应等大量精力,其合并影响因素已有成熟研究;AI智能体生成PR更高效,但存在代码结构简单、易含漏洞、合并率低等问题,且人机PR质量对比与影响因素的研究较为欠缺。

- 研究问题:共提出3个核心问题,分别聚焦模型对PR合并的预测能力、人机PR合并影响因素的差异、不同AI智能体PR合并特征的区别。

- 数据来源:采用AIDev数据集的40,214个PR,其中包含6,618个人工PR和33,596个智能体PR;针对人工PR元数据不足的问题,通过GitHub API补充评审、评论等信息,确保人机PR特征维度一致。

- 研究设计

- 特征提取:从PR中提取6大类别共64个特征,涵盖变更集大小、文件增删改数量、任务类型、外部链接、AI智能体类型等维度;经独热编码后得到106个模型项,再通过方差膨胀因子(VIF)消除多重共线性,最终保留96个模型项用于建模。

- 模型构建:构建三类逻辑回归模型,分别为人工PR模型、全智能体PR模型、5类AI智能体(OpenAI Codex、GitHub Copilot等)专属PR模型。

- 评估方法:采用五折交叉验证,通过AUC、精确率、召回率、F1值、Brier分数评估模型性能。

- 核心结果

- 模型预测能力:所有模型预测性能均优于随机猜测,具体指标如下表所示:

| 模型类型 | AUC | 精确率 | Brier分数 | 关键结论 |

|---|---|---|---|---|

| 人工PR模型 | 0.878 | 0.859 | 0.119 | 模型性能稳健,预测结果可靠 |

| 全智能体PR模型 | 0.960 | 0.939 | 0.073 | 预测能力优于人工PR模型 |

| OpenAI Codex模型 | 0.997 | 0.994 | 0.014 | 预测性能最佳 |

- **人机PR合并影响因素差异**

- **提交者属性**:对两类PR合并结果起主导作用,相对重要性分别为**69.00%(人工PR)**和**76.15%(智能体PR)**;当提交者与合并者为同一主体时,人工PR合并几率提升约219倍,智能体PR提升约5,419倍,且智能体PR同主体合并占比(77.51%)远高于人工PR(57.63%)。

- **评审相关特征**:是两类PR的第二重要影响因素,但作用方向相反;每增加一条评审评论,人工PR合并几率提升2.7%,智能体PR则降低2.8%;智能体PR中,合并PR有超过3名评审的占比仅3.7%,未合并PR该占比为5.8%。

- **不同AI智能体PR合并特征差异**:不同智能体PR合并的关键影响特征不同,OpenAI Codex的核心影响因素是提交者属性,GitHub Copilot是PR变更大小与提交特征,Devin是评审与讨论特征。

- 研究局限

- 合并时间字段为NULL的PR包含未关闭项,可能引入数据噪声。

- 模型仅揭示变量间的相关性,无法证明因果关系。

- Cursor和Claude Code两类智能体样本量较小(分别为1,541和459个),相关结论的普适性受限。

4. 关键问题

- 问题1(侧重模型有效性):构建的统计回归模型对人工与AI智能体PR合并结果的预测能力如何?

答案:所有模型的预测性能均显著优于随机猜测,其中人工PR模型AUC为0.878,全智能体PR模型AUC达0.960,OpenAI Codex专属模型AUC最高为0.997;同时模型的精确率、召回率、F1值均接近1,Brier分数接近0,说明模型预测精度高且概率估计校准良好,可为后续对比分析提供可靠依据。 - 问题2(侧重人机差异):影响人工与AI智能体PR合并结果的核心特征有何区别?

答案:两类PR的核心主导特征均为提交者属性,但该特征对智能体PR的影响程度(相对重要性76.15%)高于人工PR(69.00%);评审相关特征的作用方向相反,评审活动越活跃,人工PR合并几率越高,智能体PR合并几率越低;这一差异提示智能体PR的大量评审活动可能意味着需要更多修正工作。 - 问题3(侧重实践指导):该研究结论对软件项目中优化人机协作PR流程有哪些具体启示?

答案:一是需警惕AI智能体既提交又合并PR的情况,建议项目维护者强制第三方审批,保障独立监督;二是可将智能体的代码变更任务拆分为更小模块,降低评审难度,提升合并效率;三是可根据开发流程特点选择适配的AI智能体,如重视提交者资质的场景可选用OpenAI Codex,重视代码变更规模的场景可选用GitHub Copilot。

要不要我帮你整理一份研究结论与实践启示的对照表,方便直接用于项目管理参考?

研究背景:AI写代码快,但合并率为啥总跟不上人类?

在软件开发中,Pull Request(PR) 是代码合并的必经之路。人类开发者提交PR时,不仅要写代码,还得附上需求说明、关联问题、回复评审意见,整个过程费时费力。

为了提升效率,AI智能体(比如Codex、Copilot)开始被用来自动生成并提交PR。这些AI写代码又快又省事,但问题也很突出:合并率远低于人类开发的PR。

现有研究已经摸清了影响人类PR合并的因素,比如代码改动规模、提交者过往记录、评审流程等。但关于人机PR的核心差异,以及不同AI生成PR的合并规律,一直缺乏大规模的实证分析。

简单来说,大家都知道AI PR合并难,但难在哪、怎么改进,没人能说清。这就是这篇论文要解决的核心问题。

创新点:三大独特亮点,填补领域空白

- 规模大、维度全:首次基于40214个PR样本(6618个人工PR+33596个AI PR)展开分析,覆盖6大维度64个特征,对比维度远超同类研究。

- 对比视角新:不仅对比人机PR的合并影响因素,还横向比较了5种主流AI智能体的PR特征差异,为工具选型提供直接依据。

- 落地性强:提出的结论和建议可直接指导开发流程优化,比如强制第三方评审、拆分AI任务模块,真正实现“理论指导实践”。

研究方法和思路:四步拆解,把复杂问题变简单

这篇论文的研究方法非常清晰,分为数据准备→特征提取→模型构建→结果分析四个核心步骤:

- 数据收集与补全

- 基础数据来自AIDev数据集,包含5种AI智能体的PR和部分人工PR。

- 人工PR的元数据(评审、评论等)不全,研究团队通过GitHub API补充信息,确保人机PR的特征维度完全一致。

- 给所有PR打标签:

merged_at字段非空则为“已合并”,反之则为“未合并”。

- 特征提取与处理

- 从PR中提取6大类别共64个特征,涵盖提交者属性、代码变更规模、评审讨论、仓库属性等维度。

- 对分类特征做独热编码,得到106个模型项;再用方差膨胀因子(VIF)消除多重共线性,最终保留96个有效模型项。

- 模型构建与验证

- 选择逻辑回归模型,重点看中它的可解释性,能清晰看出每个特征对合并结果的影响。

- 构建三类模型:人工PR模型、全AI PR模型、5种AI智能体的专属模型。

- 用五折交叉验证,通过AUC、精确率、召回率等指标评估模型性能。

- 结果分析

- 针对三个研究问题(RQ1-RQ3),分别分析模型预测能力、人机PR差异、不同AI的特征差异。

主要成果和贡献:三大核心结论,直击痛点

一、先看模型性能:预测准,结论可靠

所有模型的预测性能都远超随机猜测,其中AI PR模型的AUC达到0.960,OpenAI Codex专属模型的AUC更是高达0.997,说明模型能准确捕捉影响PR合并的关键因素。

二、核心结论:用大白话讲清研究成果

| 研究问题 | 核心结论 | 领域价值 |

|---|---|---|

| RQ1:模型能多准地预测PR合并? | 人工PR模型AUC=0.878,AI PR模型AUC=0.960,预测精度高、概率校准好 | 证明后续分析的结论可信,不是“空谈” |

| RQ2:人机PR的合并影响因素有啥差异? | 1. 提交者属性是核心:对人机PR的影响占比分别达69%和76.15%;若提交者同时是合并者,AI PR的合并几率会提升5419倍,远高于人工PR的219倍 2. 评审活动作用相反:评审评论越多,人工PR合并率越高;AI PR则相反,评论多意味着需要大量修改 |

1. 提示需强制AI PR的第三方评审,避免“自提自合” 2. 建议拆分AI的代码任务,降低评审难度 |

| RQ3:不同AI的PR合并特征有啥区别? | - OpenAI Codex:靠提交者属性取胜 - GitHub Copilot:靠代码变更规模和提交质量 - Devin:靠评审讨论互动 |

指导开发者根据场景选工具,比如重视提交者资质选Codex,重视代码质量选Copilot |

三、核心贡献

- 理论贡献:明确了人机PR合并的核心差异,填补了“AI PR合并规律”的研究空白。

- 实践贡献:给出3条可直接落地的建议

- 强制AI PR的第三方评审,避免独立监督缺失;

- 拆分AI的代码任务,把大任务拆成小模块,降低评审成本;

- 根据开发需求选择AI工具,比如需要频繁互动选Devin。

总结

这篇论文通过大规模的实证分析,清晰揭示了人机PR合并的核心影响因素,以及不同AI智能体的PR特征差异。研究发现,提交者属性是决定PR合并的关键因素,而评审活动对人机PR的作用截然相反。

论文的价值不仅在于提出了科学结论,更在于给出了可落地的优化方案,为人机协作开发提供了明确的指导方向。未来,随着AI在开发领域的普及,这类“从实践中来,到实践中去”的研究,会变得越来越重要。

更多推荐

已为社区贡献104条内容

已为社区贡献104条内容

所有评论(0)