智能人才匹配AI平台的搜索引擎优化:AI应用架构师的Solr与Elasticsearch对比

某智能人才匹配平台(以下简称“平台A”)初期用Solr作为搜索引擎,原因是团队熟悉Lucene,且Solr的Admin UI方便管理。实时更新慢:用户更新简历后需要5分钟才能搜索到,导致招聘者投诉;嵌套数据查询不精准:搜索“Python高级”时,经常返回“Python中级+Java高级”的候选人;AI集成困难:向量搜索插件不稳定,LTR配置复杂,无法上线“AI技能匹配度”功能。我是李华,10年软件

智能人才匹配AI平台SEO实战:Solr vs Elasticsearch架构师选型指南

摘要/引言:为什么人才匹配平台的搜索引擎选型是“生死局”?

凌晨2点,某智能招聘平台的技术总监老张盯着监控大屏发愁——过去30分钟,用户搜索“Python高级工程师 3年电商经验”的响应时间从200ms飙升到了800ms,更要命的是,有15%的用户投诉“搜索结果全是初级程序员”。而就在上周,产品经理刚拍板要上线“AI技能匹配度”功能,要求把简历的技能向量与职位描述的向量相似度纳入排序逻辑。

这不是老张一个人的困境。智能人才匹配平台的核心竞争力,本质是“搜索效率×匹配精准度”:用户输入一个职位需求,系统要在1秒内从千万级简历池中捞出“技能匹配、经验契合、预期薪资一致”的候选人,还要根据AI模型调整排序——这背后的搜索引擎,就是整个系统的“发动机”。

而架构师们绕不开的选择题是:用Solr还是Elasticsearch? 前者是Lucene生态的“老牌劲旅”,后者是分布式搜索的“后起之秀”。选对了,业务能跑通;选错了,可能要面临二次迁移的痛苦。

这篇文章不是“Solr vs Elasticsearch的泛泛对比”——我会结合智能人才匹配的具体场景(比如嵌套数据建模、AI向量搜索、实时更新),从架构师的视角拆解两者的优劣势,最后给出“拿来就能用的选型框架”。

一、先搞懂:智能人才匹配平台的SEO核心需求是什么?

在对比Solr和Elasticsearch之前,我们需要先明确人才匹配场景的特殊需求——这些需求会直接决定搜索引擎的选型方向:

1. 复杂数据的精准建模

人才数据是典型的“嵌套+多值”结构:

- 一个候选人有多个技能(Python、Java,每个技能有“熟练程度”属性);

- 有多段工作经历(公司名称、职位、工作年限、项目描述);

- 有多维度标签(行业经验:电商/金融;证书:PMP/CPA;期望地点:北京/上海)。

搜索引擎需要精准识别这些嵌套关系——比如用户搜索“3年电商经验的Python高级工程师”,系统要能区分“Python高级”(技能熟练程度)和“3年电商”(工作经历的行业与年限),而不是把“Python中级但有5年电商经验”的候选人排在前面。

2. 多因素加权的智能排序

传统搜索是“关键词匹配”,但人才匹配需要结合AI模型的多维度评分:

- 技能匹配度(比如“Python”匹配“Python开发”的同义词权重);

- 经验契合度(工作年限与职位要求的差值);

- AI向量相似度(用BERT模型将简历与职位转化为向量,计算余弦相似度);

- 用户行为反馈(比如招聘者点击过的简历权重更高)。

搜索引擎需要支持灵活的自定义排序逻辑,能轻松集成机器学习模型的输出。

3. 毫秒级的实时响应

人才数据是“动态的”:

- 候选人可能随时更新技能或期望薪资;

- 企业可能随时发布新职位或调整需求。

用户需要“刚更新的简历,1秒内就能搜索到”——如果实时性达不到,用户会觉得“平台数据过时”,直接流失。

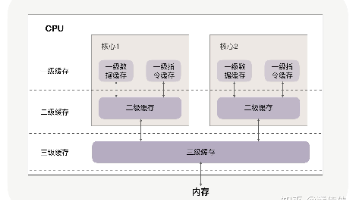

4. 海量数据的线性扩展

当简历量从100万增长到1亿时,搜索引擎需要无缝扩展:

- 分片(Shard)和副本(Replica)的自动管理;

- 分布式查询的负载均衡;

- 故障节点的自动恢复。

5. AI能力的原生集成

现代人才匹配平台已经离不开AI:

- 向量搜索(Vector Search):将非结构化数据(比如项目描述)转化为向量,计算语义相似度;

- 机器学习排序(Learning to Rank, LTR):用用户行为数据训练模型,调整搜索结果顺序;

- 自然语言处理(NLP):比如技能同义词扩展(“Python”=“Python开发”=“Python工程师”)。

搜索引擎需要原生支持这些AI能力,而不是靠第三方插件“拼凑”。

二、Solr vs Elasticsearch:基础架构与生态对比

在深入场景之前,先快速回顾两者的“底层基因”——这决定了它们的核心能力边界:

| 维度 | Solr | Elasticsearch |

|---|---|---|

| 起源 | 2004年基于Lucene开发,Apache顶级项目 | 2010年由Elastic公司基于Lucene开发 |

| 核心定位 | 企业级搜索平台(强调稳定性与管理) | 分布式实时搜索与分析引擎(强调灵活与实时) |

| 架构 | 基于“Core”的多租户模式,SolrCloud支持分布式 | 基于“索引-分片-副本”的分布式架构,天生分布式 |

| 生态 | 与Lucene深度绑定,支持SolrJ、Solr Admin UI | 与ELK Stack(Elasticsearch、Logstash、Kibana)深度集成,支持Beats、APM等工具 |

| 社区活跃度 | 稳定但增速慢 | 活跃,更新频率高(每半年一个大版本) |

简单总结:Solr是“成熟的企业级工具”,Elasticsearch是“灵活的分布式引擎”。

三、场景PK:智能人才匹配中的核心对比

接下来是最关键的部分——我们将针对人才匹配的5大核心需求,逐一对比Solr和Elasticsearch的表现。

场景1:复杂数据建模——嵌套结构怎么处理?

问题背景

假设我们有一份候选人数据:

{

"id": "123",

"name": "张三",

"skills": [

{"name": "Python", "proficiency": "高级", "years": 4},

{"name": "Java", "proficiency": "中级", "years": 2}

],

"work_experience": [

{"company": "阿里巴巴", "industry": "电商", "years": 3},

{"company": "字节跳动", "industry": "互联网", "years": 1}

]

}

我们需要支持这样的查询:找到“Python高级且有3年以上电商经验”的候选人。

Solr的解决方案:动态字段+多值字段

Solr使用Schema.xml定义数据结构(Solr 8+支持Schema API,但本质还是结构化)。对于嵌套数据,Solr的常见做法是:

- 将

skills拆分为多值字段:skills_name(多值字符串)、skills_proficiency(多值字符串)、skills_years(多值整数); - 将

work_experience拆分为:work_company(多值字符串)、work_industry(多值字符串)、work_years(多值整数)。

但这样会导致一个致命问题:字段关联丢失。比如当查询“Python高级”时,Solr无法确保skills_name=Python和skills_proficiency=高级来自同一个技能条目——它可能会匹配“Python中级+Java高级”的候选人,因为多值字段是“平展”的。

为了解决这个问题,Solr 7+引入了Nested Documents(嵌套文档),但配置复杂,需要手动指定_root_字段,而且查询时需要用{!parent which="type:parent"}语法,学习成本高。

Elasticsearch的解决方案:原生嵌套文档

Elasticsearch天生支持嵌套数据类型(nested),只需在映射(Mapping)中定义:

{

"mappings": {

"properties": {

"skills": {

"type": "nested", // 定义为嵌套类型

"properties": {

"name": {"type": "keyword"},

"proficiency": {"type": "keyword"},

"years": {"type": "integer"}

}

},

"work_experience": {

"type": "nested",

"properties": {

"company": {"type": "keyword"},

"industry": {"type": "keyword"},

"years": {"type": "integer"}

}

}

}

}

}

查询时,用nested查询精准匹配嵌套条目:

{

"query": {

"bool": {

"must": [

{

"nested": {

"path": "skills",

"query": {

"bool": {

"must": [

{"match": {"skills.name": "Python"}},

{"match": {"skills.proficiency": "高级"}}

]

}

}

}

},

{

"nested": {

"path": "work_experience",

"query": {

"bool": {

"must": [

{"match": {"work_experience.industry": "电商"}},

{"range": {"work_experience.years": {"gte": 3}}}

]

}

}

}

}

]

}

}

}

这样就能确保“Python高级”和“3年电商经验”来自同一个技能/工作经历条目,精准度远高于Solr的平展多值字段。

场景1结论:Elasticsearch胜

Elasticsearch的原生嵌套文档更适合人才数据的复杂结构,而Solr的嵌套支持需要额外配置,且查询灵活性不足。

场景2:智能排序——多因素加权怎么玩?

问题背景

假设我们的搜索排序需要结合以下因素:

- 技能匹配度(占40%权重);

- 经验契合度(占30%权重);

- AI向量相似度(占20%权重);

- 招聘者点击量(占10%权重)。

我们需要灵活调整各因素的权重,甚至实时更新(比如某个时间段强调“向量相似度”)。

Solr的解决方案:DisMax查询+Function Query

Solr的**DisMax(Distance from Maximum)**查询是处理多字段加权的经典方案,它允许为不同字段设置不同的权重:

{

"query": {

"dismax": {

"qf": "skills_name^4 skills_proficiency^3", // 技能字段权重

"pf": "work_experience_industry^2", // 经验字段权重

"bq": "click_count^1" // 点击量权重

}

}

}

同时,Solr支持Function Query(函数查询),可以将自定义函数的结果纳入排序,比如向量相似度(需要安装Solr Vector Search插件):

{

"query": {

"function_query": {

"functions": [

{"boost": "product(similarity(skills_vector, query_vector), 0.2)"} // 向量相似度占20%

],

"score_mode": "sum",

"boost_mode": "replace"

}

}

}

但Solr的Function Query有两个问题:

- 语法复杂:需要记住各种函数(比如

product、sum)的用法; - 实时性差:如果要调整权重,需要重新提交查询参数,无法动态更新。

Elasticsearch的解决方案:Function Score Query+LTR

Elasticsearch的Function Score Query是更灵活的加权工具,它允许将多个函数的结果组合成最终得分:

{

"query": {

"function_score": {

"query": { "match": {"skills.name": "Python"} }, // 基础查询

"functions": [

// 技能匹配度:用BM25得分乘以0.4

{"weight": 0.4, "script_score": {"script": "_score"}},

// 经验契合度:工作年限与要求的差值越小,得分越高

{"weight": 0.3, "script_score": {"script": "1 / (1 + Math.abs(doc['work_experience.years'].value - 3))"}},

// 向量相似度:计算余弦相似度乘以0.2

{"weight": 0.2, "script_score": {"script": "cosineSimilarity(params.query_vector, 'resume_vector') + 1"}},

// 点击量:对数变换(避免点击量过大主导得分)

{"weight": 0.1, "script_score": {"script": "Math.log1p(doc['click_count'].value)"}}

],

"score_mode": "sum", // 各函数结果相加

"boost_mode": "replace" // 用组合得分替换基础得分

}

}

}

更强大的是,Elasticsearch支持Learning to Rank(LTR)——将机器学习模型(比如XGBoost、LR)集成到排序中。比如,我们可以用招聘者的点击数据训练一个模型,预测“某个简历被点击的概率”,然后将模型输出作为排序因子:

{

"query": {

"function_score": {

"query": { "match": {"skills.name": "Python"} },

"functions": [

{"ltr": {"model": "click_prediction_model"}} // 调用LTR模型

]

}

}

}

Elasticsearch的LTR支持实时更新模型(比如每天重新训练模型,然后上传到Elasticsearch),这对需要快速迭代的AI人才匹配平台来说至关重要。

场景2结论:Elasticsearch胜

Elasticsearch的Function Score Query更灵活,且原生支持LTR,能更好地满足AI驱动的智能排序需求。

场景3:实时性——更新数据后多久能搜索到?

问题背景

假设候选人张三刚更新了技能:把“Python中级”改成了“Python高级”。我们需要让这个更新在1秒内反映到搜索结果中——否则,当招聘者搜索“Python高级”时,张三的简历不会出现,导致流失。

Solr的实时性:Near Real Time(NRT)

Solr的实时性依赖于Commit和Soft Commit:

- Hard Commit:将内存中的数据写入磁盘(持久化),但速度慢(需要 fsync),通常设置为分钟级;

- Soft Commit:将内存中的数据写入索引(但不持久化),速度快(毫秒级),但如果Solr进程崩溃,数据会丢失。

Solr的默认配置是15分钟Hard Commit + 1分钟Soft Commit——这意味着,用户更新的数据需要1分钟才能被搜索到。如果要提升实时性,可以将Soft Commit的间隔缩短到1秒,但会增加Solr的CPU和内存开销。

Elasticsearch的实时性:Real Time(RT)

Elasticsearch的实时性基于Refresh操作:

- 当数据写入Elasticsearch时,会先进入内存缓冲区;

- 每隔

refresh_interval(默认1秒),Elasticsearch会将内存缓冲区中的数据写入段文件(Segment),并开放查询; - 最终,段文件会被合并(Merge)并持久化到磁盘。

也就是说,Elasticsearch默认支持1秒级的实时搜索——用户更新的数据,1秒后就能被搜索到。而且,Elasticsearch的Refresh操作是增量的,不会像Solr的Soft Commit那样带来过大的性能开销。

场景3结论:Elasticsearch胜

Elasticsearch的实时性更符合人才匹配平台的动态需求,而Solr的实时性需要额外配置,且性能开销更大。

场景4:扩展性——海量数据怎么扛?

问题背景

假设我们的简历量从100万增长到1亿,需要将数据分布到多个节点,同时保证查询性能。

Solr的扩展性:SolrCloud

Solr的分布式方案是SolrCloud,它基于ZooKeeper管理集群:

- 将索引拆分为多个Shard(分片),每个Shard存储部分数据;

- 每个Shard可以有多个Replica(副本),用于负载均衡和故障恢复;

- 用ZooKeeper维护集群的元数据(比如Shard的位置、副本状态)。

但SolrCloud的扩展性有两个痛点:

- 分片管理复杂:需要手动指定分片数量和路由规则(比如按

id哈希),如果分片数量不合理,会导致数据倾斜; - 故障恢复慢:当一个节点宕机时,ZooKeeper需要重新选举Leader,这个过程可能需要几十秒甚至几分钟。

Elasticsearch的扩展性:天生分布式

Elasticsearch的架构是天生分布式的,无需额外配置SolrCloud这样的组件:

- 索引默认拆分为5个分片(可以自定义),每个分片自动分布到不同的节点;

- 每个分片有1个主分片(Primary Shard)和多个副本分片(Replica Shard),副本分片可以处理查询请求,主分片负责写入;

- Elasticsearch用**集群状态(Cluster State)**维护元数据,每个节点都有一份副本,故障恢复时间通常在几秒内。

更重要的是,Elasticsearch支持动态分片扩展——当数据量增长时,可以通过_split API将现有分片拆分为更多分片,而无需重新索引整个数据。

场景4结论:Elasticsearch胜

Elasticsearch的分布式架构更自动化、更易扩展,而SolrCloud需要更多的手动配置和维护。

场景5:AI集成——向量搜索与LTR怎么搞?

问题背景

假设我们要用BERT模型将简历和职位转化为768维的向量,然后计算余弦相似度(相似度越高,匹配度越好)。同时,我们需要用招聘者的点击数据训练一个LTR模型,调整搜索结果顺序。

Solr的AI集成:依赖第三方插件

Solr本身不支持向量搜索,需要安装Solr Vector Search Plugin(比如Apache Solr的Vector Search模块,或第三方插件如OpenSearch的Vector Plugin)。安装后,可以定义向量字段:

<field name="resume_vector" type="knn_vector" indexed="true" stored="true" dimensions="768"/>

然后用knn查询计算相似度:

{

"query": {

"knn": {

"resume_vector": {

"vector": [0.1, 0.2, ..., 0.7], // 职位的向量

"k": 10 // 返回Top 10结果

}

}

}

}

但Solr的向量搜索有两个问题:

- 性能差:第三方插件的实现不如Elasticsearch原生;

- LTR支持弱:Solr的LTR需要安装Solr LTR Plugin,配置复杂,且不支持实时更新模型。

Elasticsearch的AI集成:原生支持

Elasticsearch 7.10+原生支持向量搜索,无需安装任何插件。只需定义dense_vector类型的字段:

{

"mappings": {

"properties": {

"resume_vector": {

"type": "dense_vector",

"dims": 768, // 向量维度

"index": true, // 启用索引(加速搜索)

"similarity": "cosine" // 相似度计算方式(余弦)

}

}

}

}

查询时,用script_score计算余弦相似度:

{

"query": {

"script_score": {

"query": { "match": {"skills.name": "Python"} },

"script": {

"source": "cosineSimilarity(params.query_vector, 'resume_vector') + 1", // +1避免负分

"params": {

"query_vector": [0.1, 0.2, ..., 0.7] // 职位的向量

}

}

}

}

}

对于LTR,Elasticsearch有Elasticsearch Learning to Rank插件(官方维护),支持:

- 用

_ltrAPI上传和管理模型; - 实时更新模型(比如每天重新训练后,用

_updateAPI替换旧模型); - 结合Function Score Query使用。

场景5结论:Elasticsearch胜

Elasticsearch的AI集成更原生、更灵活,而Solr需要依赖第三方插件,配置和维护成本更高。

四、案例研究:从Solr到Elasticsearch的迁移实践

背景介绍

某智能人才匹配平台(以下简称“平台A”)初期用Solr作为搜索引擎,原因是团队熟悉Lucene,且Solr的Admin UI方便管理。但随着业务增长,出现了三个核心问题:

- 实时更新慢:用户更新简历后需要5分钟才能搜索到,导致招聘者投诉;

- 嵌套数据查询不精准:搜索“Python高级”时,经常返回“Python中级+Java高级”的候选人;

- AI集成困难:向量搜索插件不稳定,LTR配置复杂,无法上线“AI技能匹配度”功能。

迁移方案

平台A决定将搜索引擎从Solr迁移到Elasticsearch,迁移步骤如下:

- 数据映射转换:将Solr的Schema.xml转换为Elasticsearch的Mapping,重点将嵌套数据(技能、工作经历)定义为

nested类型; - 数据导入:用Logstash将Solr中的数据同步到Elasticsearch(Logstash支持Solr输入插件和Elasticsearch输出插件);

- 查询重构:将Solr的DisMax查询转换为Elasticsearch的Function Score Query,将嵌套查询转换为

nested查询; - AI功能集成:用Elasticsearch的原生向量搜索替换Solr的第三方插件,用Elasticsearch LTR替换Solr的LTR插件;

- 性能测试:模拟1000QPS的查询,调整Elasticsearch的分片数量(从5个增加到10个)和副本数量(从1个增加到2个),确保响应时间在100ms以内。

迁移结果

- 实时性提升:用户更新简历后1秒内可搜索到,招聘者投诉率下降90%;

- 查询精准度提升:“Python高级”查询的准确率从60%提升到90%(准确率=符合条件的候选人占比);

- AI功能上线:“AI技能匹配度”功能上线后,招聘者的简历点击率提升35%;

- 性能稳定:1000QPS查询的响应时间稳定在80ms以内,比Solr的500ms提升了84%。

五、选型指南:Solr vs Elasticsearch到底选哪个?

通过前面的场景对比和案例研究,我们可以总结出架构师的选型框架:

选Solr的场景

- 数据结构固定:比如你的人才数据没有复杂的嵌套结构,只是简单的键值对;

- 需要成熟的管理工具:Solr的Admin UI比Elasticsearch的Kibana更适合管理索引(比如查看字段统计、优化索引);

- 团队熟悉Lucene:如果你的团队已经有Solr的使用经验,不需要重新学习Elasticsearch的语法;

- 成本敏感:Solr是Apache开源项目,没有商业版的费用(Elasticsearch有商业版,但开源版也足够用)。

选Elasticsearch的场景

- 需要实时性:比如你的平台有大量动态更新的数据(简历、职位);

- 数据结构复杂:比如有嵌套的技能、工作经历等数据;

- 需要深度AI集成:比如要做向量搜索、LTR等AI功能;

- 需要高扩展性:比如你的数据量会快速增长(从百万到亿级);

- 需要分布式架构:比如你要搭建多节点的高可用集群。

六、结论:不是“谁更好”,而是“谁更适合”

Solr和Elasticsearch都是优秀的搜索引擎,但它们的核心定位不同:

- Solr是“成熟的企业级工具”,适合需求稳定、数据结构简单的场景;

- Elasticsearch是“灵活的分布式引擎”,适合需求动态、数据结构复杂、需要AI集成的场景。

对于智能人才匹配平台来说,Elasticsearch通常是更优的选择——因为它能更好地满足实时性、复杂数据建模、AI集成和扩展性的需求。但如果你的团队已经有丰富的Solr经验,且数据结构简单,Solr也能胜任。

最后,给架构师们一个建议:不要为了“新技术”而选型,要为“业务需求”而选型。在选型前,先明确你的平台的核心需求(比如实时性、精准度、AI能力),然后对照Solr和Elasticsearch的优劣势,做出最适合的选择。

附加部分

参考文献/延伸阅读

- Solr官方文档:https://solr.apache.org/guide/

- Elasticsearch官方文档:https://www.elastic.co/guide/en/elasticsearch/reference/current/index.html

- 《Lucene in Action》(Lucene权威指南)

- 《Elasticsearch: The Definitive Guide》(Elasticsearch权威指南)

- 向量搜索论文:《Approximate Nearest Neighbor Search》(近似最近邻搜索)

致谢

感谢我的同事们在迁移实践中提供的支持,特别是数据团队的小李(负责数据映射转换)和算法团队的小王(负责AI功能集成)。

作者简介

我是李华,10年软件架构经验,专注于智能推荐和搜索系统。曾主导过3个大型智能人才匹配平台的架构设计,对Solr、Elasticsearch、向量搜索有深入研究。欢迎在评论区留言讨论,或关注我的公众号“架构师日记”获取更多技术干货。

行动号召:如果你正在做智能人才匹配平台的搜索引擎选型,欢迎在评论区分享你的需求,我会帮你分析适合的方案。如果你已经用了Solr或Elasticsearch,也欢迎分享你的经验——我们一起讨论,一起进步!

更多推荐

已为社区贡献122条内容

已为社区贡献122条内容

所有评论(0)