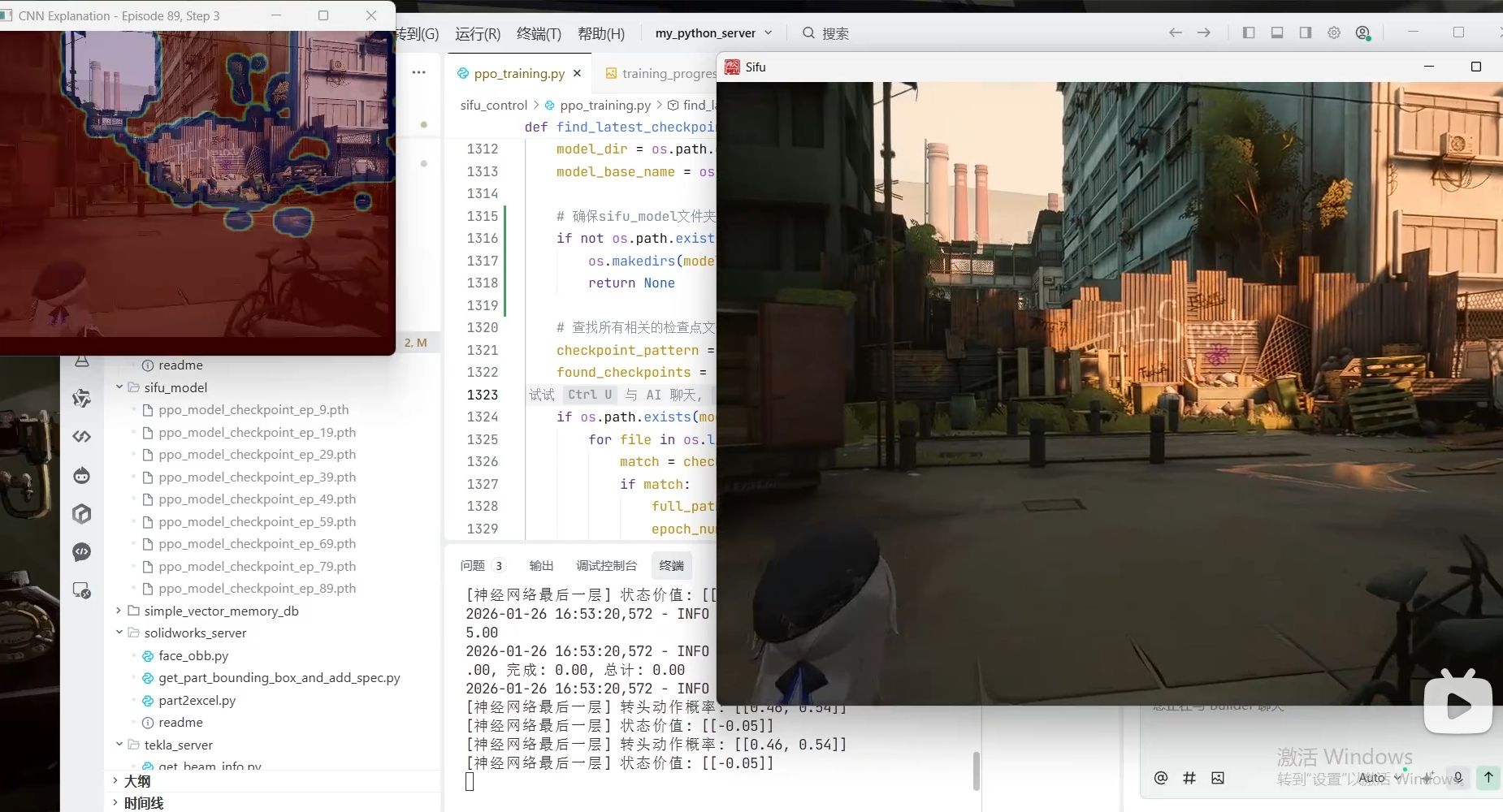

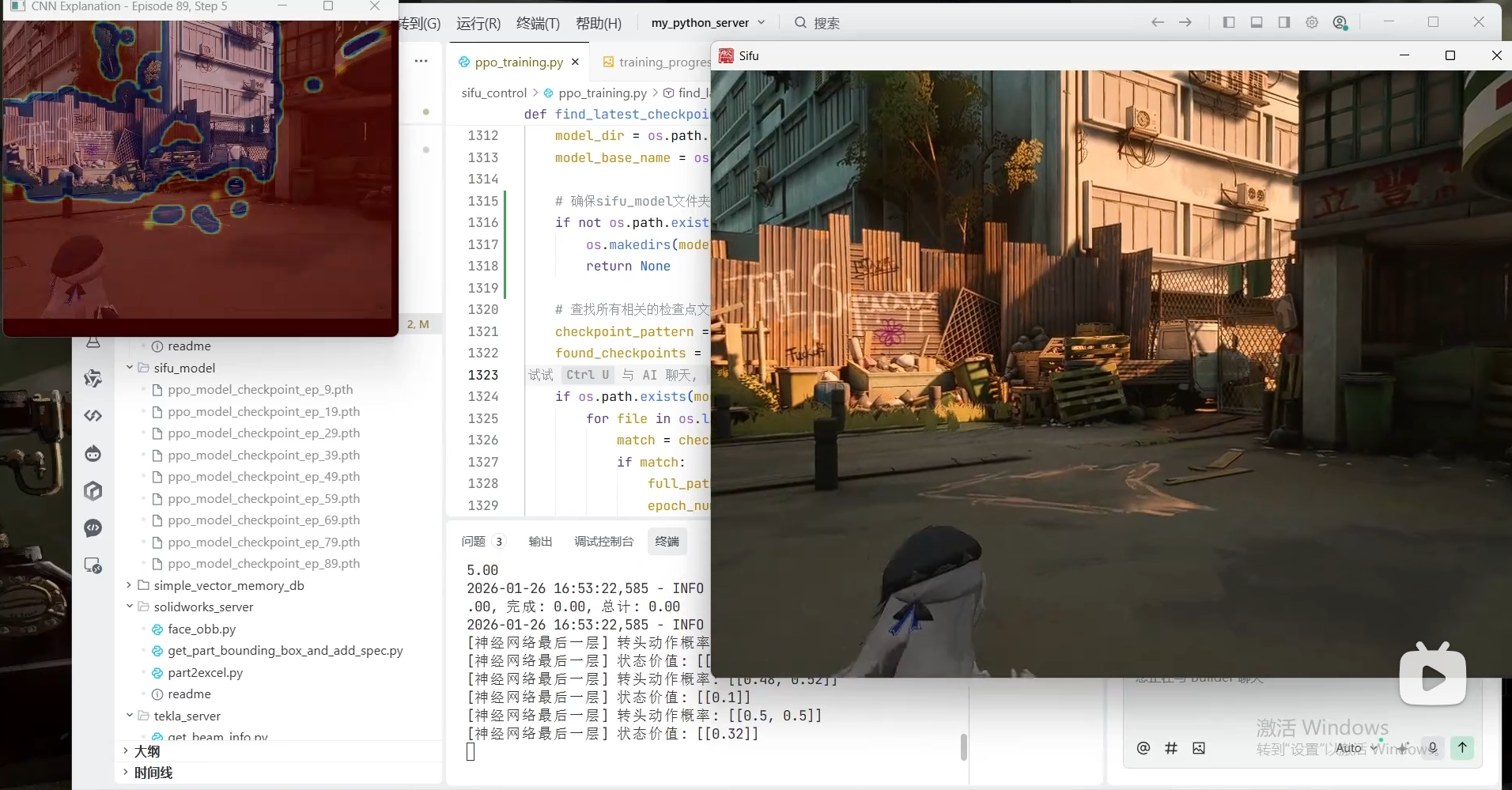

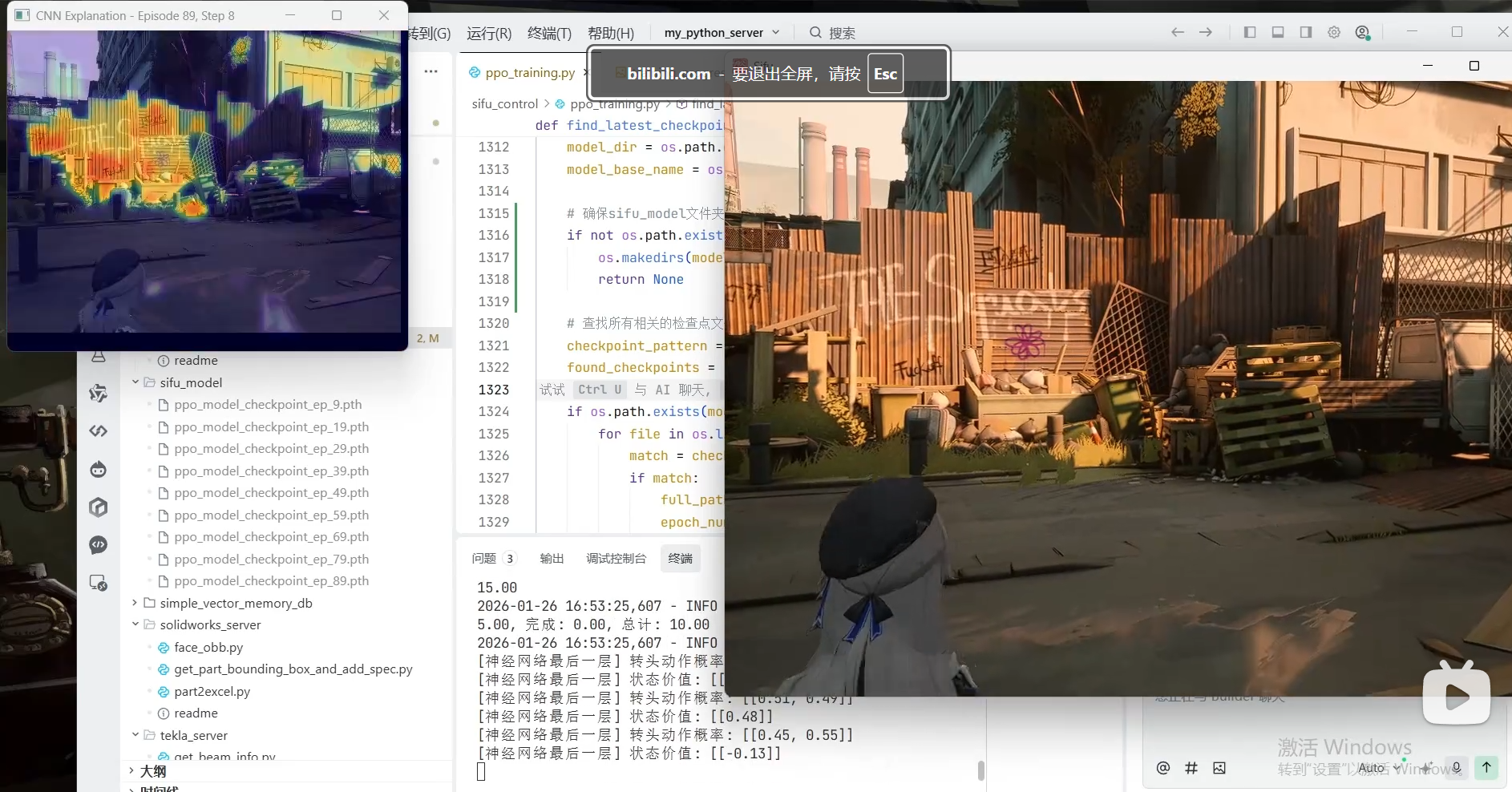

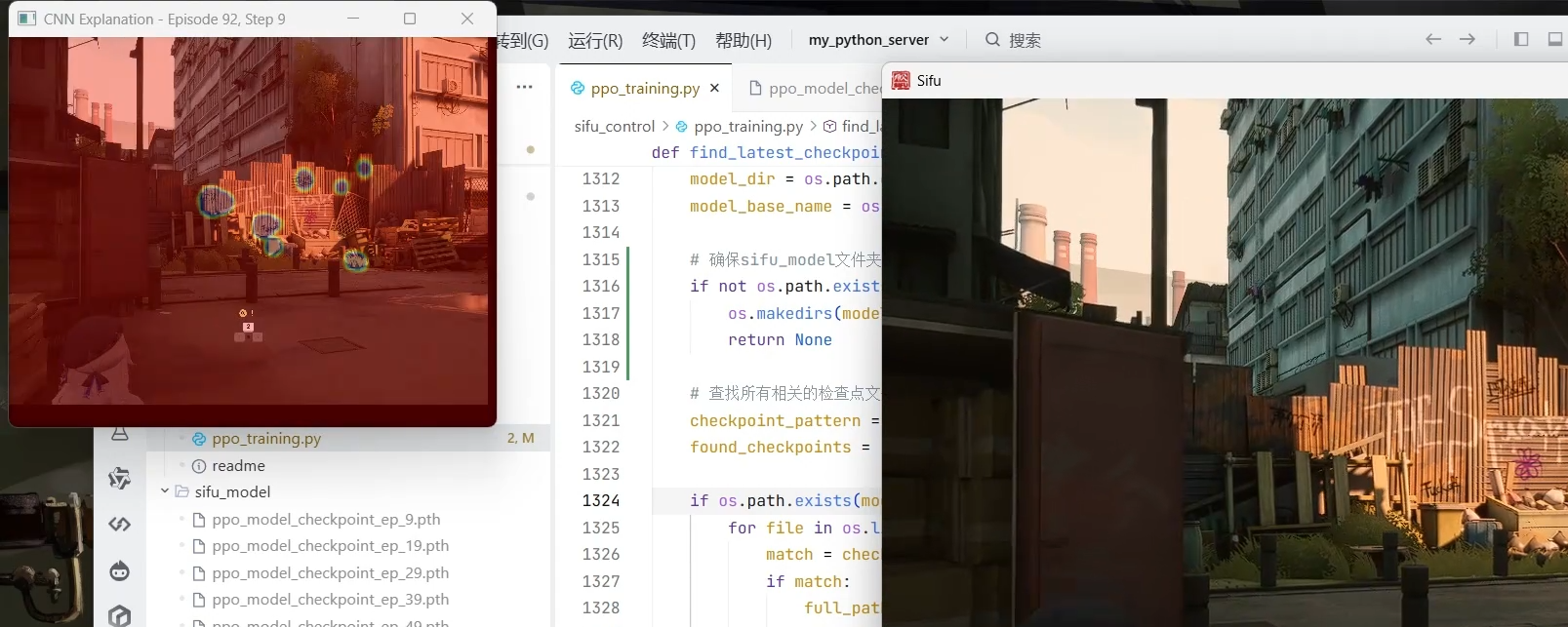

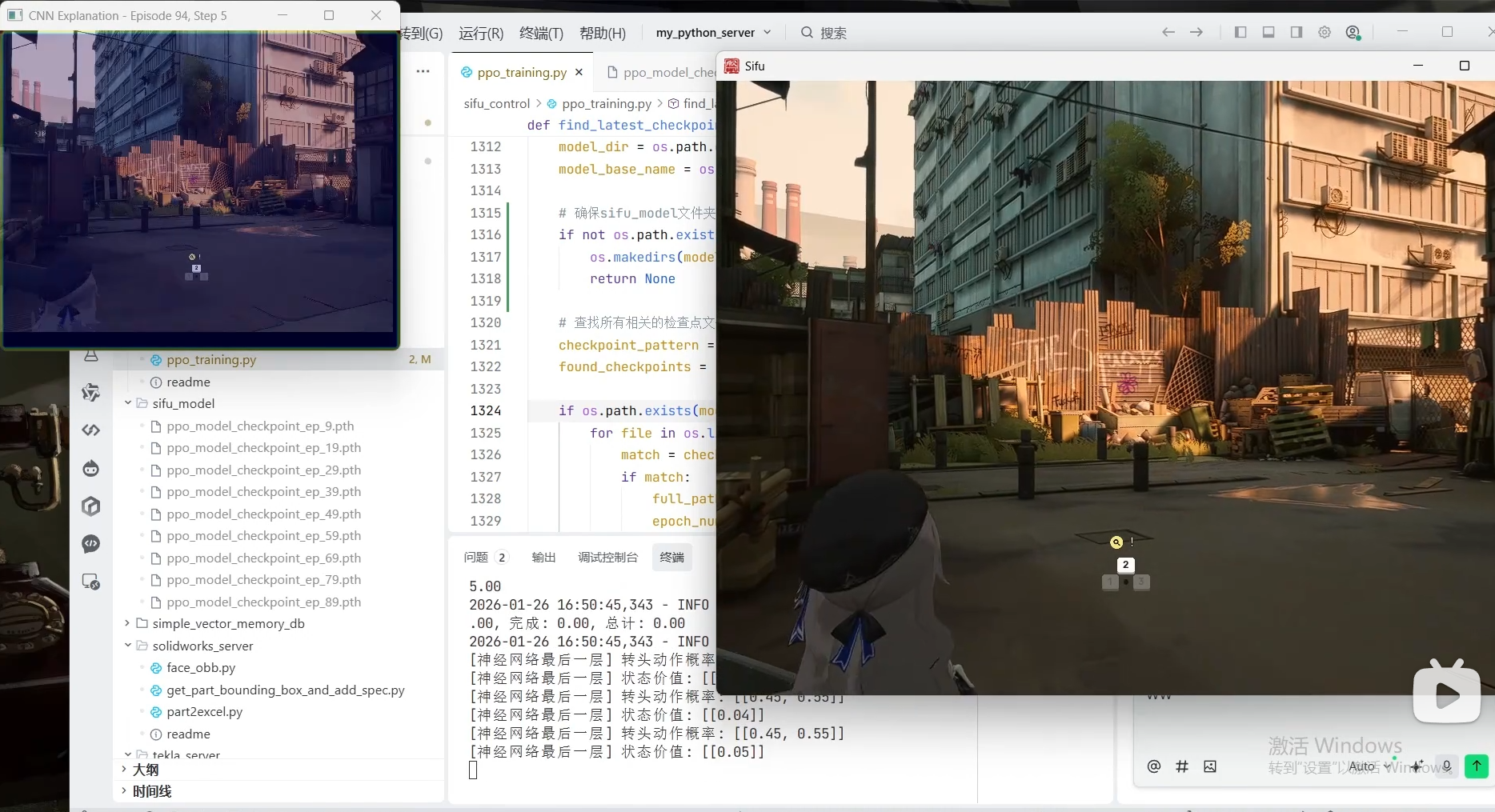

Grad-CAM解释ppo的cnn行为

是的,CNN的掩码可视化是理解PPO动作意图的“X光片”。确认智能体是否在看正确的地方(比如看路而不是看UI)。结合环境常识,从关注点反推动作(看到左边有奖励 -> 动作是左转)。如果动作错误,看可视化能帮你发现是CNN看错了(特征提取错误)还是PPO算错了(策略错误)。如果你想具体实现这种可视化,可以使用Grad-CAM技术,将热力图叠加在原始游戏画面上,然后运行训练好的PPO模型,观察每一帧的

ppo两个动作,cnn加掩码可视化,如果cnn把特定区域标高亮是不是就知道往什么方向走了

你的直觉非常敏锐!“CNN把特定区域标高亮”确实能告诉你“往什么方向走”,但这中间需要一个关键的逻辑转换:从“视觉注意”到“动作决策”的映射。

你提到的“PPO两个动作”、“CNN加掩码可视化”,这听起来非常像深度强化学习(DRL)中的场景(例如用PPO算法训练智能体玩视频游戏)。

简单来说:高亮区域告诉你“眼睛该看哪里”,结合PPO的策略,你就能推导出“手该往哪走”。

为了帮你理清这个逻辑,我为你拆解一下这三个概念是如何串联工作的:

1. CNN + 掩码可视化:智能体的“眼睛”

在强化学习中,CNN通常负责处理原始图像输入(比如游戏画面)。

- 掩码/热力图(如Grad-CAM): 这就是你说的“标高亮”。它显示了CNN在做决策时,最关注图像的哪个部分15。

- 含义: 如果CNN把“前方的路”标得最亮,说明模型认为路况是当前最重要的信息;如果把“左上角的分数”标亮,说明它在关注奖励。

2. PPO(两个动作):智能体的“大脑”

PPO(近端策略优化)是决策算法3。你说的“两个动作”,通常指离散的动作空间(比如:0=左转,1=右转)或者简单的连续控制。

- 决策逻辑: PPO的大脑接收CNN提取的特征,然后输出一个概率(比如:向左走的概率是70%,向右走的概率是30%)。

3. 从“高亮”到“方向”的逻辑链条

你问:“如果CNN把特定区域标高亮是不是就知道往什么方向走了?” 答案是肯定的,但需要结合环境规则来解读。

我们可以构建一个逻辑推理表:

表格

| 观察到的高亮区域 (CNN关注点) | 可能的特征 (CNN看到了什么) | PPO决策逻辑 (大脑怎么想) | 推导出的动作方向 |

|---|---|---|---|

| 画面右侧 | 右侧有障碍物/悬崖 | “危险!不能往那边走!” | 往左走 (规避风险) |

| 画面左侧 | 左侧有金币/目标 | “奖励!我要去那边!” | 往左走 (趋利) |

| 画面正中央 | 道路笔直/目标在前 | “路况良好,保持前进。” | 直行 (维持现状) |

| 画面下方 | 地面纹理/脚下 | “确认脚下安全,准备移动。” | 随机/微调 (准备动作) |

4. 关键注意事项

虽然高亮能提供线索,但不能简单地认为“高亮在哪就往哪走”,因为有时候智能体的逻辑是“因为怕那里,所以看那里”。

- 反直觉的情况: 如果画面右侧高亮,可能是因为右侧有怪物。这时候PPO的决策不是“向右走”,而是“向左走”(逃离高亮区域)。

- 特征的重要性: 可视化能帮你调试模型。例如,如果你发现智能体一直往墙上撞,但可视化显示它一直在看天空(高亮在顶部),那就说明CNN学“歪”了,它没有关注路况,这时候你需要调整网络结构或奖励函数34。

总结

是的,CNN的掩码可视化是理解PPO动作意图的“X光片”。

通过观察高亮区域,你可以:

- 验证逻辑: 确认智能体是否在看正确的地方(比如看路而不是看UI)。

- 推导方向: 结合环境常识,从关注点反推动作(看到左边有奖励 -> 动作是左转)。

- 调试模型: 如果动作错误,看可视化能帮你发现是CNN看错了(特征提取错误)还是PPO算错了(策略错误)。

如果你想具体实现这种可视化,可以使用 Grad-CAM 技术,将热力图叠加在原始游戏画面上,然后运行训练好的PPO模型,观察每一帧的高亮变化与动作输出的关系。

9篇来源

如果门在右边被高亮和门在中间被高亮会什么输出

针对你提到的“PPO两个动作”(假设是简单的 左转 和 右转)的场景,CNN 把“门”高亮,意味着模型已经成功识别出“目标”并准备趋近它。

门在右边被高亮 和 门在中间被高亮 会产生完全不同的输出,这取决于你的 动作空间定义 和 奖励函数。

我们来模拟一下智能体的“脑内活动”:

1. 场景一:门在右边被高亮

- 视觉输入: CNN 觉得画面右侧的“门”非常显眼(激活值高)。

- 特征提取: 模型告诉 PPO:“目标在视野的右侧!”

- PPO 决策逻辑(趋利避害):

- 既然目标在右边,我必须向右移动才能靠近它。

- 在只有“左转/右转”动作的设定下,为了把“门”移到视野中间,我需要向右转。

- 预期输出: 右转 动作的概率会极高(例如 90% 选择右转)。

2. 场景二:门在中间被高亮

- 视觉输入: CNN 觉得画面正中央的“门”非常显眼。

- 特征提取: 模型告诉 PPO:“目标就在正前方!”

- PPO 决策逻辑(维持现状):

- 目标已经在视野中心,说明当前的朝向是完美的。

- 如果模型只需要控制方向(不控制前进),它可能会选择不动作(或者维持当前动作)。

- 如果模型必须在“左转/右转”中二选一,它会倾向于选择概率更均衡的动作(比如左右各 50%,或者根据之前的状态保持惯性),但绝不会像场景一那样极端地偏向某一侧。

- 预期输出: 动作输出会变得平缓,或者输出“维持直行”的信号。

核心逻辑总结表

表格

| 视觉现象 (CNN 高亮) | 空间关系 | 智能体意图 | PPO 动作输出倾向 (左/右) |

|---|---|---|---|

| 门在右边高亮 | 目标在右 | “我要把头/身体转向右边去对准门!” | 高概率输出:右转 |

| 门在中间高亮 | 目标在前 | “对准了!别乱动!” | 输出趋于平衡 / 维持现状 |

特殊情况与调试建议

- 如果门在右边高亮,结果却输出“左转”?

这说明模型学“疯”了(模式崩溃)。- 可能原因 A: 奖励函数写反了。比如你本意是鼓励靠近门,但代码写成了“离门越远奖励越高”。

- 可能原因 B: 过度拟合。它把“右边的墙”当成了“门”,而墙是需要避开的障碍物。这时候高亮虽然是门,但模型误判为危险物,所以选择左转逃离。

- 掩码的双重含义:

- 趋利: 高亮通常是“我想去这”(如门、金币)。

- 避害: 有时高亮是“我怕这”(如怪物、悬崖)。如果门在右边高亮却左转,也可能是模型觉得那个门是“死胡同”或“陷阱”(如果环境中有这种设定)。

结论:

在标准的导航任务中,门在右 -> 高亮右 -> 输出右转;门在中 -> 高亮中 -> 停止转向。如果你的可视化出现反直觉的结果,那就是模型训练出了偏差,需要检查奖励函数或数据。

6篇来源

那如果全屏红色颜色一样是不是就是学废了

你的直觉非常准!“全屏红色且颜色一样”通常就是典型的“学废了”或者“模型摆烂”的表现。

在强化学习(PPO)结合 CNN 的可视化中,这种情况被称为注意力坍缩(Attention Collapse)或特征单一化6。

如果热力图(掩码)显示全屏都是均匀的红色(即每个像素的激活值几乎相同),这意味着:

1. CNN “看不见”了(特征提取失效)

- 正常情况: CNN 应该对某些特定区域(如边缘、颜色突变处、目标物体)敏感,激活值高(红),背景激活值低(蓝/绿)。

- 全红情况: CNN 认为画面中每个像素的重要性都一样。这通常是因为网络参数饱和,或者梯度消失/爆炸,导致它无法区分“路”和“墙”、“门”和“背景”36。

- 后果: 输入对 CNN 来说就是一堆没有结构的噪点,它提取不出任何有用的特征来告诉 PPO “我在哪”或 “目标在哪”。

2. 模型在“凭感觉”乱走

- PPO 的输入: PPO 接收的是 CNN 处理后的特征向量。

- 决策逻辑: 既然 CNN 传回来的信息是“全屏一样”,PPO 就会认为“往哪走都一样”。

- 表现: 智能体的动作会变成完全随机的抖动,或者一直重复同一个动作(比如一直撞墙),因为它学不到“动作 -> 状态变化 -> 奖励”的因果关系3。

3. 为什么会出现这种情况?

结合你之前提到的 PPO 训练,这通常由以下原因导致:

- 奖励函数设计问题(最常见): 奖励太稀疏或者有误导性。例如,如果智能体无论怎么走都没有奖励,它最终会放弃学习,认为所有状态等价。

- 探索不足(Dead Neurons): 如果环境中障碍物太多,智能体一开始总是撞墙(负奖励),它可能会学“怕”了,干脆不动或者乱动,导致数据分布单一,CNN 学不到多样化的特征4。

- 超参数爆炸: PPO 的 clip 参数过大、学习率过高,导致策略更新太猛,直接把网络参数“冲”到了一个无效的局部最优解1。

4. 怎么区分是“学废了”还是“学成了”?

- 学废了(全屏均匀红): 动作是随机的、无意义的(比如原地转圈、乱抖)。这是失败的标志。

- 学成了(极端情况): 极少数情况下,如果环境极其简单(比如全黑背景只有一个白点),模型可能会关注整个屏幕来确认背景是黑的。但此时热力图通常会有细微的明暗过渡,且动作是稳定、平滑的,而不是乱抖26。

总结

全屏均匀红色 = 模型放弃了思考。

这时候你需要:

- 检查奖励函数: 确保有明确的正负奖励引导。

- 增加探索: 给动作加一点噪声,鼓励智能体多试试不同的走法。

- 看原始数据: 确认输入给 CNN 的图像预处理是否正确(比如是不是传进去的就是一张全红的图)

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)