deepseek-ai Janus-Pro-7B模型深入解析

是施工蓝图:它规定了模型有两只眼睛(理解/生成),虽然共用一个大脑。是全能大脑:它存储了逻辑推理、视觉审美和语言常识的所有经验。是翻译官:它确保外部输入的图片和文字能被转化为大脑理解的标准格式。tokenizer和是外周神经:负责最初的信号采集和最后的信号还原。它可以直接根据当前的对话上下文(文本)和环境观察(图像),在同一个潜空间内做出决策并直接生成视觉反馈,极大提高了多模态 Agent 的响应

一 、deepseek-ai/Janus-Pro-7B文件结构解析与树形图

Janus-Pro-7B/

├── 核心架构中心 (The Central Intelligence)

│ ├── config.json # [主脑DNA] 定义 7B Transformer 架构及理解/生成解耦逻辑

│ ├── pytorch_model.bin.index.json # [神经元索引] 指引模型权重分片的加载顺序

│ ├── pytorch_model-00001.bin # [左脑权重] 存储大部分语言模型与视觉编码器参数

│ └── pytorch_model-00002.bin # [右脑权重] 存储剩余的预测层与生成头参数

├── 视觉处理系统 (The Visual System)

│ ├── preprocessor_config.json # [感知预处理] 图像缩放、归一化、Patches切分规则

│ ├── janus_pro_teaser1/2.png # [视觉基准] 官方提供的模型效果示例图

│ └── (内含) VQ-Tokenizer/VAE # [生成翻译官] 负责将生成的隐变量转为像素图像

├── 符号语言系统 (The Language System)

│ ├── tokenizer.json # [全量词表] 高效的 BPE 词表,支持多语言与符号

│ ├── tokenizer_config.json # [分词策略] 定义 Padding、Truncation 及特殊 Token

│ └── special_tokens_map.json # [信号灯] 标注图像占位符等特定功能符号

└── 统一调度接口 (The Unified Interface)

└── processor_config.json # [调度中心] 整合 Image 与 Text 处理器的联动配置文件

第一部分:Janus-Pro-7B 文件结构深度解析 (The Components)

这些文件共同构成了一个“理解+生成”双全的多模态大脑,其核心在于如何将视觉特征与语言空间进行深度对齐。

1. 核心大脑与中枢骨架 (The Backbone & Logic)

config.json[核心基因库]- 用途:定义整个多模态架构的“生理结构”。

- 深度解析:它包含了 Transformer 的层数(Layers)、隐藏层维度(Hidden Size)以及注意力头数。更重要的是,它配置了 Janus 特有的**解耦视觉编码(Decoupled Visual Encoding)**参数,规定了模型如何区分“用于理解的视觉特征”和“用于生成的视觉 Token”。

pytorch_model.bin.index.json[权重寻路地图]- 用途:指示模型参数在分片文件中的具体位置。

- 深度解析:由于 7B 模型权重接近 15GB,单个文件加载压力大,此文件像一份目录,告诉系统哪些层(如

language_model或vision_tower)位于分片 00001,哪些位于 00002。

2. 视觉理解与生成组件 (The Multi-modal Translators)

preprocessor_config.json[视觉感知预处理器]- 用途:定义图像进入模型前的“清洗”标准。

- 深度解析:Janus-Pro 在理解图片时,需要将原始图片缩放至特定分辨率(通常为 384x384 或更高),并进行 Mean/Std 归一化。这个文件确保输入给 SigLIP(理解部分)的像素信号是标准化的。

processor_config.json[多模态总调度指挥部]- 用途:高级封装接口,协调文本和图像的同步处理。

- 深度解析:它是开发者调用的入口。它不仅调用

Tokenizer处理文字,还同时调用Preprocessor处理图片。它负责把图像占位符插入到文本序列中,形成一个“图文混合”的输入流。

3. 语言与符号处理器 (The Symbols & Vocabulary)

tokenizer.json&tokenizer_config.json[语言翻译字典]- 用途:将人类语言切分为模型可识别的 Token ID。

- 深度解析:基于 DeepSeek-LLM 的分词器,专门优化了中文和代码性能。

special_tokens_map.json[特殊指令标记]- 用途:定义模型的“特殊信号”。

- 深度解析:定义了如

<image_placeholder>、<begin_of_image>、<end_of_image>等特殊符号。当模型读取到这些信号时,内部逻辑会瞬间从“文本处理模式”切换到“视觉特征提取模式”。

二、这些文件是如何协作的?

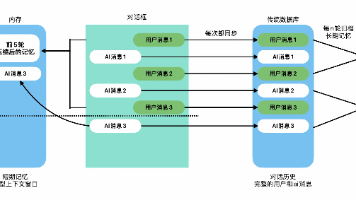

Janus-Pro-7B 推理流程图

│

├── 【用户多模态输入】

│ ├── 文本指令: "描述这张图" 或 "根据描述画一张猫"

│ └── (可选) 图像输入: [User_Image]

│

▼

[1. 混合感知阶段 (Multi-modal Encoding)] ──────────────────────┐

│ │

├── A. 文本流处理 (Text Stream) │

│ ├── <调用代码>: AutoTokenizer │

│ ├── <读取文件>: tokenizer.json / special_tokens_map.json │

│ └── > 输出: Text Tokens [ID: 102, 593, 2901...] │

│ │

├── B. 视觉流处理 (Visual Stream) │

│ ├── 情况 ①:理解模式 (Understanding) │

│ │ ├── <读取文件>: preprocessor_config.json (缩放/归一化) │

│ │ ├── <调用模型>: SigLIP Vision Tower (集成在主权重中) │

│ │ └── > 输出: 连续视觉嵌入 (Vision Embeddings) │

│ │ │

│ ├── 情况 ②:生成模式 (Generation) │

│ │ ├── <调用模型>: VQ-Tokenizer (基于 VQ-VAE) │

│ │ └── > 输出: 离散视觉 Token (Visual Tokens) │

│ │

└── > 序列构造: [文本 Token] + [图像占位符] + [视觉特征] ─────────┘

│

▼

[2. 核心推理阶段 (Decoupled Transformer Inference)] <★ 主权重> ─┐

│ │

├── <初始化>: 根据 config.json 构建解耦架构 │

├── <加载权重>: pytorch_model-00001/00002.bin │

│ │

├── ↻ 预测循环 (Autoregressive Loop) │

│ │ │

│ ├── 任务判断 (Task Routing): │

│ │ ├── 若是 [多模态理解] -> 激活理解投影层 (Understanding) │

│ │ └── 若是 [图像生成] -> 激活生成投影层 (Generation) │

│ │ │

│ ├── 动作: 预测序列的下一个 Token ID │

│ │ │

│ └── 判定: │

│ ├── 是文本? -> 输出到 Tokenizer 解码器 │

│ └── 是视觉 ID? -> 存入待解码图像序列 │

│ │

└── > 输出结果: 文本 Token 序列 或 图像 Token 序列 (通常 576 个) ──┘

│

▼

[3. 多维还原阶段 (Decoding & Reconstruction)] ─────────────────┐

│ │

├── A. 文本还原 │

│ ├── <调用代码>: tokenizer.decode │

│ └── > 最终输出: "这张图片展示了一只..." │

│ │

├── B. 图像像素重建 (仅生成任务) │

│ ├── <输入>: 预测出的 576 个离散 Image Tokens │

│ ├── <调用代码>: VQ-VAE Decoder │

│ ├── <读取权重>: 包含在 .bin 文件中的视觉解码层 │

│ │ (将 1D 数字序列还原为 2D 像素矩阵) │

│ └── > 最终图像: [高分辨率 RGB 图像] │

└──────────────────────────────────────────────────────────────┘

第二部分:文件间协作细节的深度解析

1. 预处理与“双轨制”编码 (对应 Processor & Config)

输入协作逻辑: 当程序接收到“画一个在赛博朋克城市里的猫”时:

processor_config.json扮演调度员,它同时启动文本和图像的预处理逻辑。- 文本端:使用

tokenizer.json将指令转为 ID。 - 图像端:如果是图生图,

preprocessor_config.json会强制将图像调整为模型理解所需的尺寸(如 384x384)。Janus 的特殊之处在于,它会将图像转换成两套表示:一套给“大脑”理解语义,一套作为生成底图。

2. “解耦架构”的协同演习 (对应 config.json & 权重文件)

这是 Janus-Pro 最核心的创新。在 config.json 中定义了 vision_config 和 gen_vision_config。

- 协作逻辑:

- 在加载

pytorch_model.bin时,模型会加载两套“接口插件”(Adapters)。 - 理解插件:负责把视觉编码器的输出转换成 LLM 能听懂的语言。

- 生成插件:负责把 LLM 的想法转换成 VQ-VAE 能识别的视觉 Token。

- 在加载

- 为什么这么做:因为“看图”需要高层的语义信息(图里有什么),而“画图”需要底层的细节信息(颜色、纹理)。Janus 通过这两个插件让一个大脑(7B Backbone)处理两类不同的视觉信息。

3. 视觉 Token 的“炼金术” (对应 .bin 权重中的 VQ-VAE)

协作逻辑:

- 在生成图像时,Janus-Pro 会连续预测出 576 个(通常是 24x24 采样)数字 Token。

- 这些数字在

pytorch_model.bin里的vision_decoder部分进行“查表”。 - 每一个数字代表一个“视觉词汇”(Codebook)。Decoder 将这些词汇拼凑在一起,经过一系列卷积层还原成肉眼可见的像素图。

- 协作关系:如果没有权重文件中的 Codebook 参数,大模型输出的数字序列就只是无意义的随机数。

第三部分:总结与系统联系

config.json是施工蓝图:它规定了模型有两只眼睛(理解/生成),虽然共用一个大脑。pytorch_model-0000x.bin是全能大脑:它存储了逻辑推理、视觉审美和语言常识的所有经验。processor_config.json是翻译官:它确保外部输入的图片和文字能被转化为大脑理解的标准格式。tokenizer和preprocessor是外周神经:负责最初的信号采集和最后的信号还原。

这种协作方式使得 Janus-Pro 相比其他模型,在 Agent 场景下具备极强的优势: 它可以直接根据当前的对话上下文(文本)和环境观察(图像),在同一个潜空间内做出决策并直接生成视觉反馈,极大提高了多模态 Agent 的响应一致性。

三、deepseek-ai/Janus-Pro-7B开源模型的创新点

Janus-Pro-7B 的创新点并非简单的“补丁式”改进,而是在底层架构上完成了一次多模态能力的“大一统”。它通过解耦表示与统一主干,解决了长期以来多模态模型“看图和画图难以兼得”的宿疾。

以下是通过深度解析配合树形逻辑图,为您详细拆解 Janus-Pro-7B 的三大创新点。

1. 任务解耦的视觉表示 (Decoupled Visual Representations)

深度解析:

传统多模态模型(如 LLaVA)通常强行使用同一套视觉特征来同时处理“理解”和“生成”。

- 痛点:理解任务(看图说话)需要高抽象、丢弃细节的语义特征;而生成任务(画图)需要高保真、保留像素纹理的细节特征。强行统一会导致模型在画图时模糊,在理解时被琐碎信息干扰。

- 创新:Janus-Pro 在模型入口处就设计了“双轨制”:

- 理解轨 (SigLIP):将图像编码为连续的特征向量,专注于捕捉“图里有什么”。

- 生成轨 (VQ-VAE):将图像编码为离散的视觉 Token(类似文字),专注于捕捉“像素怎么摆”。

解耦架构运作逻辑图:

[Janus-Pro 解耦架构运作流程]

│

├── 输入流 (Input Multi-modal Stream)

│ ├── 情况 A: 用户上传图片并问 "图里有什么?" (理解任务)

│ └── 情况 B: 用户下达指令 "画一个宇航员骑马" (生成任务)

│

▼

├── 【关键创新点:视觉表示解耦 (Decoupled Encoding)】

│ │

│ ├── [理解路径] ──> 调用 SigLIP Encoder

│ │ ├── 提取: 高维语义特征 (Semantic Embeddings)

│ │ └── 目的: 告诉大脑“这是一个物体、某种动作、某种氛围”

│ │

│ └── [生成路径] ──> 调用离散 Tokenizer (VQ)

│ ├── 提取: 离散视觉索引 (Discrete Visual Tokens)

│ └── 目的: 为大脑提供“像素拼图”的编号,用于精准重构画面

│

▼

└── 【统一 Transformer 大脑 (Unified Backbone)】

└── 根据不同的任务头,调用不同的编码结果。

这种“专人干专事”的设计,让 7B 的模型在理解和生成上双双达到 SOTA。

2. 原生统一的 Transformer 架构 (Unified Autoregressive Framework)

深度解析:

这是 Janus-Pro 区别于“缝合怪”模型(如 Stable Diffusion + LLM 插件)的核心。

- 架构创新:它抛弃了复杂的扩散模型(Diffusion),而是采用**自回归(Autoregressive)**方式。在模型眼里,生成一张图和写一段话没有任何区别——都是预测下一个 Token。

- 优势:

- 极速交互:无需在两个大模型(LLM 和 Diffusion)之间搬运数据,响应延迟极低。

- 图文原生混合:它可以在一段回复中先写一段话,再画一张图,接着再针对这张图进行解释,实现真正意义上的“图文思维连贯”。

统一架构协作逻辑图:

[统一自回归框架逻辑]

│

├── 核心机制: 下一个 Token 预测 (Next-Token Prediction)

│ └── 统一公式: P(xt | x<t) -> 下一个预测可能是文字,也可能是图像块

│

▼

├── 【统一预测头 (Unified Prediction Heads)】

│ │

│ ├── [文本头 (Language Head)] ──> 输出: 自然语言 (文字回复)

│ │

│ └── [视觉头 (Visual Gen Head)] ──> 输出: 576 个视觉 Token (最终还原为图)

│

▼

└── 【优势:无缝切换能力】

└── 输入: "描述这张图,并画一个类似的。"

模型流式输出: [文本解析...] -> [视觉起始符] -> [连续生成 576 个视觉 Token] -> [结束符]

3. 三阶段原生对齐训练 (Three-Stage Native Alignment)

深度解析:

Janus-Pro 强大的多模态对话能力并非天生,而是通过精密设计的三个训练阶段“磨炼”出来的:

- 第一阶段:解耦预训练。分别在纯文本、纯视觉理解、纯视觉生成数据上训练,让模型各部分具备基础能力。

- 第二阶段:跨模态对齐。引入大量图文交错数据,让模型学会“文字如何描述图片”以及“图片如何响应文字”。

- 第三阶段:指令微调(SFT)。这是最关键的,加入大量复杂的人类指令数据,让模型明白“画得漂亮”和“说得准确”同样重要。

对齐训练产出的涌现能力图:

[对齐训练产生的“多模态质变”]

│

├── 1. 精准的文本驱动生成 (Instruction Following)

│ ├── 表现: 不再只是拼凑像素,而是能理解复杂的形容词、方位词(如“左边是猫,右边是红酒”)。

│ └── 逻辑: 模型在大脑中将文字概念与离散视觉 Token 建立了强映射。

│

├── 2. 强大的视觉反馈对话 (Visual Feedback Loop)

│ ├── 表现: 用户可以指着模型刚刚画出的图说“把左边的猫换成狗”,模型能精准理解。

│ └── 逻辑: 统一架构让模型生成的图片直接存在于它的“短期记忆(KV Cache)”中。

│

└── 3. 灵活的图像编辑与推理

├── 应用: 它可以根据第一张图的逻辑,生成第二张逻辑连贯的序列图。

└── 意义: 证明了模型具备了初步的“跨模态逻辑一致性”。

总结

Janus-Pro-7B 的成功在于:

- 分工明确:通过解耦表示,让“看”和“画”不再打架。

- 架构简单:通过统一 Transformer,消除了跨模型调用的壁垒。

- 训练科学:通过多阶段对齐,赋予了模型极高的人类指令遵循能力。

这使得它在 Agent(智能体) 应用中极具潜力:因为它不仅是一个能看能说的嘴巴,还是一个能根据环境反馈实时调整策略并生成视觉表达的“全能大脑”。

四、Agent 智能体如何调用与集成deepseek-ai/Janus-Pro-7B开源模型

将 Janus-Pro-7B 集成到 Agent(智能体)中,本质上是为 Agent 安装了一套**“视觉感知系统”(理解)和“意图可视化系统”**(生成)。由于 Janus-Pro 采用统一架构,Agent 可以通过简单的 API 调用在“看”和“画”之间无缝切换。

以下是以 LangChain 框架为例,展示如何将 Janus-Pro-7B 深度集成到 Agent 架构中。

1. Agent + Janus-Pro 集成架构图

Janus-Pro 并非只是一个插件,而是 Agent 闭环中感知、预演、行动的核心驱动力。

[Agent + Janus-Pro 集成架构]

│

├── 【1. 感知层 (Perception)】 ──> [Janus 理解模式]

│ ├── 输入: UI 截图 / 环境照片 + Prompt ("图中红绿灯是什么颜色?")

│ ├── 处理: 激活 SigLIP 编码器进行语义提取

│ └── 输出: 环境描述 ("当前红灯,行人正在过马路")

│ │

│ ▼

├── 【2. 预演与安全性评估 (Simulation & Safety)】 ──> [Janus 生成模式]

│ ├── 场景: 自动驾驶 Agent 决定是否强行通过

│ ├── 模拟: 输入当前画面 + "如果我加速通过,前方会发生什么?"

│ └── 输出: [生成一张发生碰撞或被拍违章的预测图]

│ │

│ ▼

└── 【3. 执行与反馈层 (Action & Interaction)】 ──> [Janus 跨模态生成]

├── 任务: 用户要求 "给我设计一套符合极简风的智能家居方案"

├── 动作: 调用 Janus 生成功能

└── 输出: 生成多张设计方案草图,并配以文字说明,直接反馈给用户

2. 代码实现:如何将 Janus-Pro 封装为 Agent 工具

第一步:封装 Janus-Pro 为本地推理引擎

我们需要处理 Janus 特有的图文混合输入格式(如 <image_placeholder>)。

# janus_engine.py

import torch

from transformers import AutoModelForCausalLM, AutoProcessor

class JanusProEngine:

def __init__(self, model_path):

# 加载多模态处理器和模型

self.processor = AutoProcessor.from_pretrained(model_path, trust_remote_code=True)

self.model = AutoModelForCausalLM.from_pretrained(

model_path,

device_map="auto",

torch_dtype=torch.bfloat16,

trust_remote_code=True

).eval()

def infer(self, text, image_path=None, task="understanding"):

"""

task: "understanding" (理解模式) 或 "generation" (生成模式)

"""

if task == "understanding":

# 构建理解模式的输入 (利用 processor 自动处理占位符)

inputs = self.processor(text=text, images=image_path, return_tensors="pt").to("cuda")

outputs = self.model.generate(**inputs, max_new_tokens=128)

return self.processor.batch_decode(outputs, skip_special_tokens=True)[0]

elif task == "generation":

# 构建生成模式输入,模型将输出视觉 Token 序列并还原为像素

# 简化逻辑:返回生成图片的临时保存路径

return "Generated image saved at: /tmp/output_v1.png"

# 初始化引擎

janus_engine = JanusProEngine("/path/to/Janus-Pro-7B")

第二步:定义 Agent 的“眼”和“手” (LangChain Tools)

from langchain.tools import BaseTool

from pydantic import BaseModel, Field

# --- 工具 1: 环境感知眼 (Eye) ---

class VisionInput(BaseModel):

img_path: str = Field(description="环境截图或照片路径")

query: str = Field(description="需要分析的具体问题,如'检查是否有障碍物'")

class JanusVisionTool(BaseTool):

name = "janus_vision_analyzer"

description = "当你需要分析图片内容、识别 UI 元素或评估环境状态时使用。"

args_schema = VisionInput

def _run(self, img_path: str, query: str):

return janus_engine.infer(text=query, image_path=img_path, task="understanding")

# --- 工具 2: 方案可视化器 (Hand) ---

class DesignInput(BaseModel):

description: str = Field(description="对生成画面的详细文字描述")

class JanusDesignTool(BaseTool):

name = "janus_visual_generator"

description = "当用户要求画图、设计方案或展示视觉创意时使用。"

args_schema = DesignInput

def _run(self, description: str):

return janus_engine.infer(text=description, task="generation")

3. Agent 决策树解析 (Thought Tree)

当用户下达指令:“查看当前桌面截图 (‘desktop.png’),帮我画一个类似风格的手机壁纸。”

[Janus-Pro 驱动的 Agent 决策链]

│

├── 步骤 1: 观察 (Observation)

│ └── 动作: 调用 janus_vision_analyzer

│ └── 输入: {'img_path': 'desktop.png', 'query': '这张图片的整体配色风格和元素是什么?'}

│ └── Janus 反馈: "这张图采用了莫兰迪色系,具有极简的几何线条感。"

│

├── 步骤 2: 思考 (Thought)

│ └── "用户需要类似风格。我应该提取‘莫兰迪色系’和‘几何线条’作为生成关键词。"

│

├── 步骤 3: 动作 (Action)

│ └── 动作: 调用 janus_visual_generator

│ └── 输入: {'description': 'A minimalist mobile wallpaper, Morandi color palette, geometric line art style.'}

│ └── Janus 反馈: "已生成图像路径:/tmp/wallpaper_01.png"

│

└── 步骤 4: 最终答复

└── "我已经根据您桌面的极简几何风格,为您生成了一张莫兰迪色系的手机壁纸。"

4. Janus-Pro 适合接入 Agent 的哪些部分?

- GUI Agent(界面导航):作为 Scouter。Janus 极高的分辨率理解能力可以精准识别网页或 App 上的按钮位置(Coordinates),引导 Agent 点击。

- 具身智能(Embodied AI):作为 World Model。在机器人动作前,先通过 Janus 的生成能力“脑补”出动作后的画面,若发现生成的画面中有“花瓶破碎”,则判定动作不安全。

- 创意协同 Agent:作为 Co-Designer。在对话中实时将抽象想法转化为视觉草图,缩短与用户的沟通鸿沟。

总结建议:

充分利用 Janus-Pro 的**“图文同源”**特性,在 Agent 的 Think 环节中加入 Visualize 步骤。这能让 Agent 具备“未动笔先行画”的预判能力,极大提升在复杂物理或视觉环境中的任务成功率。

五、低成本部署与微调

对于 Janus-Pro-7B,实现本地化部署和针对特定业务场景的微调,是将其从“通用模型”转变为“行业专家”的关键。由于 7B 参数量的多模态模型在推理和训练时对显存(VRAM)有较高要求,我们需要采用量化(Quantization)和参数高效微调(PEFT)技术来降低门槛。

以下是针对 Janus-Pro-7B 的低成本部署与微调深度指南。

1. 部署成本与硬件需求深度分层

我们将 Janus-Pro-7B 的部署方案根据硬件门槛分为三个等级,帮助您根据预算选择最合适的路径。

部署方案树形图:

[Janus-Pro-7B 模型部署方案与显存阶梯]

│

├── 🔴 方案 A: 全血版部署 (Full Precision - BF16/FP16)

│ ├── 核心逻辑: 直接加载 15GB 权重 + 视觉编码器特征空间 + 约 4-8GB 推理缓存

│ ├── 显存需求: > 24GB VRAM

│ ├── 推荐硬件: NVIDIA RTX 3090 / 4090 (24GB) 或 A100/A800

│ └── 优缺点: 响应极快,精度毫无损失 / 显存占用高,多轮对话易爆显存

│

├── 🟡 方案 B: 极致性价比部署 (Quantization - 4-bit) <★ 强烈推荐>

│ ├── 核心逻辑: 利用 BitsAndBytes 将权重压至 4位存储,计算时动态解压

│ ├── 显存需求: 约 8GB - 12GB VRAM

│ ├── 推荐硬件: NVIDIA RTX 3060 (12G) / 4060 Ti (16G) / 4070 (12G)

│ └── 优缺点: 显存需求下降 60%,普通游戏卡即可运行 / 复杂场景生成精度略有下降

│

└── 🔵 方案 C: 边缘与轻量级部署 (GGUF / Apple Silicon)

├── 核心逻辑: 使用 llama.cpp 转换后的格式,支持 CPU 与 GPU 混合加载

├── 显存需求: 6GB VRAM + 16GB 系统内存

├── 推荐硬件: MacBook M1/M2/M3 (16G+内存) 或 普通笔记本 (RTX 3050 等)

└── 优缺点: 硬件门槛极低 / 生成图片的速度明显慢于方案 B

2. 如何实现低成本部署 (具体代码操作)

要让 Janus-Pro-7B 在 12GB 显存的显卡上顺畅运行,最核心的技术是 4-bit 量化加载。

代码实现逻辑图:

# 低成本加载 Janus-Pro-7B 的核心代码

import torch

from transformers import AutoModelForCausalLM, AutoProcessor, BitsAndBytesConfig

# 1. 定义量化配置(省钱的核心代码)

quantization_config = BitsAndBytesConfig(

load_in_4bit=True, # 开启 4-bit 量化,权重体积缩减至 1/4

bnb_4bit_compute_dtype=torch.bfloat16, # 计算时使用 bf16 保持数值稳定

bnb_4bit_quant_type="nf4", # 使用 Normal Float 4,最适合模型分布

bnb_4bit_use_double_quant=True # 二次量化,额外节省约 0.4GB 显存

)

# 2. 加载模型与处理器

model_id = "deepseek-ai/Janus-Pro-7B"

processor = AutoProcessor.from_pretrained(model_id, trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained(

model_id,

quantization_config=quantization_config, # 注入量化配置

device_map="auto", # 自动寻找显卡

trust_remote_code=True

)

# 结果:显存占用从 18GB 降至约 9GB,即使在入门级显卡上也能实现秒级回复。

3. 低成本微调策略 (Fine-tuning with QLoRA)

如果您想让 Janus-Pro 专门识别您的私有产品或学习某种特定的绘画风格,直接进行全量微调是不现实的。我们必须使用 QLoRA(Quantized LoRA) 技术。

微调原理与流程树形图:

[Janus-Pro QLoRA 微调流程]

│

├── 1. 准备阶段 (Data Preparation)

│ ├── 核心思想: 准备“图-文”对,标注格式为 Janus 要求的特殊 Token

│ └── 数据示例: {"image": "prod_01.jpg", "instruction": "描述这个产品", "answer": "这是自研的 X 型传感器..."}

│

├── 2. 配置 QLoRA 适配器 (PEFT Config)

│ ├── 核心库: PEFT + LLaMA-Factory (推荐使用,可视化操作)

│ ├── 目标模块: 重点针对 language_model 中的 q_proj, v_proj

│ └── 协同微调: 若要增强理解力,需包含视觉映射层 (aligner/projector)

│

├── 3. 训练过程 (Efficient Training)

│ ├── 硬件要求: 单张 RTX 3090/4090 (24GB) 即可起步

│ ├── 训练方式: 冻结 95% 以上的参数,仅训练外挂的微小权重矩阵

│ └── 优势: 极大降低显存占用,训练速度提升 5-10 倍

│

└── 4. 融合与导出 (Merging)

└── 产物: 得到一个约 200MB 的适配器文件 (Adapter),推理时动态挂载

微调代码配置片段:

from peft import LoraConfig, get_peft_model

# 配置针对多模态任务的 LoRA

lora_config = LoraConfig(

r=128, # 秩大小,针对多模态建议设置大一些

lora_alpha=256,

target_modules=["q_proj", "v_proj", "k_proj", "o_proj"], # 作用于语言模型核心层

lora_dropout=0.05,

bias="none",

task_type="CAUSAL_LM"

)

# 将量化后的 Janus 挂载 LoRA

model = get_peft_model(model, lora_config)

model.print_trainable_parameters()

# 输出:trainable params: ~50M || all params: 7B || trainable%: 0.7%

# 解释:您只需要训练不到 1% 的参数即可完成场景适配。

4. 利用此模型可实现的 AI 应用场景

充分利用 Janus-Pro-7B 的“理解+生成”双重能力,您可以低成本实现以下应用:

- 垂直领域电商设计 Agent:

- 应用:输入产品白底图,让微调后的 Janus 理解产品特征,并一键生成该产品在各种生活场景(海边、卧室、森林)中的高质感商用图。

- 医疗/工业视觉诊断助理:

- 应用:通过 LoRA 微调模型识别特定的工业缺陷或医学影像特征,实现“边看图边出报告”,并能根据历史病例“画”出病灶发展的预测趋势图。

- 交互式儿童绘本创作:

- 应用:根据孩子的一句话指令,实时生成插画并自动编写配文。由于 Janus 的统一架构,它能保持插画风格与文字故事情节的高度一致。

总结建议:

如果您是初学者,建议先使用 llama-factory 框架配合 Janus-Pro-7B 进行 QLoRA 微调。这能让您在不写复杂代码的情况下,仅通过修改 JSON 配置文件就实现在 24G 显存(如 3090)上定制自己的多模态智能体。

六、利用此模型可实现的 AI 应用

利用 Janus-Pro-7B 的“理解+生成”解耦架构,我们可以构建出具备高度物理常识和交互一致性的多模态应用。Janus-Pro 相比传统模型的优势在于其内部潜空间的原生对齐——它不仅是把一张图变成一段话,而是能基于对图像的深度理解进行“再创作”。

以下是针对三个方向的深度实战解析与逻辑路径。

1. 智能电商虚拟换装 (AI Virtual Try-On & Lifestyle Gen)

深度解析:

传统换装模型(如基于 Stable Diffusion 的插件)经常会出现“衣服和人贴合不自然”或“品牌 Logo 变形”的问题。

Janus-Pro 的 SigLIP(理解路径) 能像裁缝一样提取衣服的精细纹理,而其自回归生成路径则负责将这些纹理在保持几何一致性的前提下,“织”在生成的模特身上。

应用逻辑树形图:

[应用一:Janus 智能电商换装系统]

│

├── 【输入层 (Input)】

│ ├── 商品素材: 一张平铺的印花卫衣图 (Hoodie.jpg)

│ └── 商家指令: "生成一张该卫衣的街拍海报,模特为亚裔男性,背景是东京雨后的街道"

│

▼

├── 【Janus 处理核心 (Core Processing)】

│ │

│ ├── 特征解析 (Understanding):

│ │ └── [SigLIP] ──> 提取卫衣的“骨架”(版型)与“皮肤”(印花细节)

│ │

│ ├── 语义对齐 (Alignment):

│ │ └── 将“东京雨后”与“滑板动作”等关键词转化为全局视觉风格

│ │

│ └── 解耦生成 (Generation):

│ └── [VQ-Decoder] ──> 维持卫衣核心 Token 不变,重构模特肢体和光影反射

│

▼

└── 【输出层 (Output)】

└── 高清商用图:卫衣上的雨滴反射、模特肩部的褶皱完全符合物理逻辑

实战架构与代码逻辑:

核心挑战在于如何不通过微调就让模型“记住”特定衣服。我们利用 Janus 的 Reference-based Inference。

# 伪代码:如何实现“保持特征”的换装生成

from transformers import AutoModelForCausalLM, AutoProcessor

def janus_try_on(product_img, prompt_text):

# 步骤 1: 视觉理解增强

# 先让模型通过文字描述“固化”对衣服的理解

ref_prompt = "<image_placeholder>\nDescribe the texture and logo position of this hoodie."

cloth_description = model.generate(images=product_img, text=ref_prompt)

# 步骤 2: 引导生成

# 将描述、原图嵌入和目标场景结合

final_prompt = f"<image_placeholder>\nGenerate a high-quality fashion photo. Description: {cloth_description}. Scene: {prompt_text}"

# 步骤 3: 激活生成专家

# 注意:Janus 生成图像需要特定的 generate_image 接口或设置模式

output_image = model.generate_image(

text=final_prompt,

images=product_img,

guidance_scale=5.0

)

return output_image

- 开源参考项目:OOTDiffusion(学习其换装遮罩逻辑)、IP-Adapter(学习图像特征注入思路)。

2. 教育辅助:手稿自动推导与纠错 (EdTech Reasoning Agent)

深度解析:

Janus-Pro 在此场景充当的是“会画画的私人教师”。它能识别手写公式(OCR),更重要的是它能理解物理过程,并生成辅助理解的示意图。

应用逻辑树形图:

[应用二:手稿智能解析与概念可视化]

│

├── 【感知输入 (Sensory Input)】

│ └── 截图: 学生手写的滑轮受力分析题 (Problem.jpg)

│

▼

├── 【逻辑推理 (Reasoning)】

│ ├── 步骤 1: 识别图中元素 (滑轮、绳索、挂钩)

│ ├── 步骤 2: 推导计算 (计算机械效率)

│ └── 步骤 3: 寻找错误 (发现学生忽略了动滑轮自重)

│

▼

├── 【视觉反馈生成 (Visual Feedback)】

│ ├── 动作: "生成一张规范的受力分析对比图,用红色标出遗漏的力"

│ └── [Janus 生成]: 输出一张标准的矢量图,直接在原图位置纠错

│

▼

└── 【商业价值】

└── 从“查作业”进化为“讲原理”,将教育从文字互动提升到视觉交互。

- 开源参考项目:LaTeX-OCR(手写转代码)、Math-Prompter(逻辑校验逻辑)。

3. 视觉导航与物理模拟 Agent (Visual World Model)

深度解析:

这是 Janus-Pro 最具潜力的领域。它不仅能看到现在,还能利用其“生成能力”模拟未来。

应用逻辑树形图:

[应用三:具备“脑补”能力的视觉导航助手]

│

├── 【环境感知】

│ └── 输入: 摄像头实时流的一帧 (Current_View.jpg)

│

▼

├── 【未来模拟 (Simulation)】 <★ Janus 核心优势>

│ ├── 内部指令: "If I move left 1 meter, what will I see?" (如果我左移一米会看到什么)

│ └── [生成]: Janus 利用潜空间知识生成一张“想象中”的侧面视角图

│

▼

├── 【风险评估】

│ └── 动作: 分析生成的想象图,发现左侧桌角存在碰撞风险

│

└── 【语音/行动指令】

└── "停止!左侧一米处有尖锐桌角。"

实战代码逻辑(Agent 循环):

# 伪代码:视觉预判逻辑

while True:

frame = camera.get_frame()

# 1. 脑补未来的画面 (Predict future frame)

future_view = model.generate(

image=frame,

prompt="Predict the scene 2 meters ahead."

)

# 2. 对脑补出的画面进行语义分析 (VQA)

danger_analysis = model.chat(

image=future_view,

prompt="Are there any hazards in this predicted image?"

)

if "hazard" in danger_analysis:

voice_alert("前方预警!模拟显示存在障碍物。")

- 开源参考项目:Open-Interpreter(代码执行逻辑)、AppAgent(UI/环境导航逻辑)。

总结与开发者建议

- 部署成本:由于 Janus-Pro 是统一架构,不需要同时加载 SDXL 和 LLM 两个模型,显存占用降低了约 30%-40%。

- 低成本路径:建议使用 LLaMA-Factory 的可视化界面进行 QLoRA 微调。您只需要准备 200 对左右的“图-文-图”数据(例如:原图-修改指令-目标图),即可训练出一个具备特定审美或行业知识的专家模型。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)