从4K到100W!LLM上下文暴增,RAG技术凉凉?程序员必读AI技术趋势【内附CAG黑科技】

文章探讨了大模型上下文窗口从4096到100万Token的发展历程,分析长上下文LLM与RAG技术的优劣。尽管上下文窗口大幅扩展,但RAG在成本效益和特定领域知识检索方面仍具优势。研究表明,将两者结合可提高效率,CAG技术通过预加载知识替代实时检索提供低延迟、高准确率解决方案。最终结论是两者结合将重新定义检索格式,各自发挥不可替代作用。

从OpenAI发布chatGPT-3.5至今,在扩展LLM的上下文窗口上取得了巨大进展。GPT-3.5-turbo的上下文窗口大小为4096个Token → GPT-4的上下文窗口为8192个Token → Calude2的Token数量达到10w → Llama 3.1的Token是12.8wToken → Gemini达到了100w个Token。

上下文窗口获得了极大的扩展,也引出了一个关于RAG的问题,对于超长上下文的LLM来说,RAG是否还有存在的价值?

核心差异

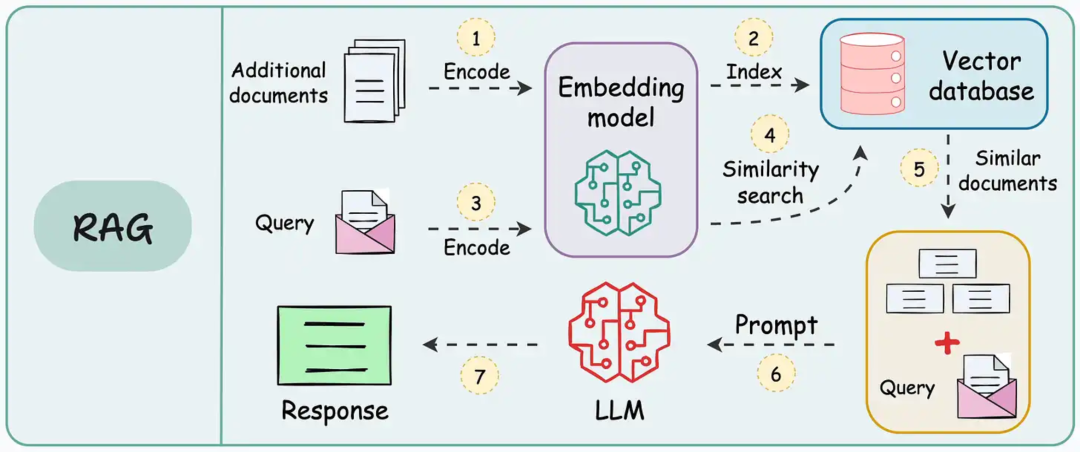

- RAG:RAG从外部来源检索相关信息。

- 长上下文:直接在上下文窗口中处理大量输入。

虽然长上下文LLM可以囊括整个文档并执行跨段落的多跳推理,但RAG更擅长处理大规模、成本效益的检索任务。

关键见解

- 成本效益:使用长上下文LLM处理每个请求,20w到100w个Token的成本可能高达20美元,使得RAG对应许多应用程序来说是更经济实惠的选择。

- 特定领域知识:RAG在需要精确、精心整理的细分领域检索方面表现优于长上下文。

- 互补整合:大多数RAG Pipline失败的原因是检索效果差,而检索效果差又源于分块处理不当。大概RAG与长上下文LLM相结合可以提高检索和处理效率,从而有可能消除分块处理或分块召回的必要性。

前沿论文

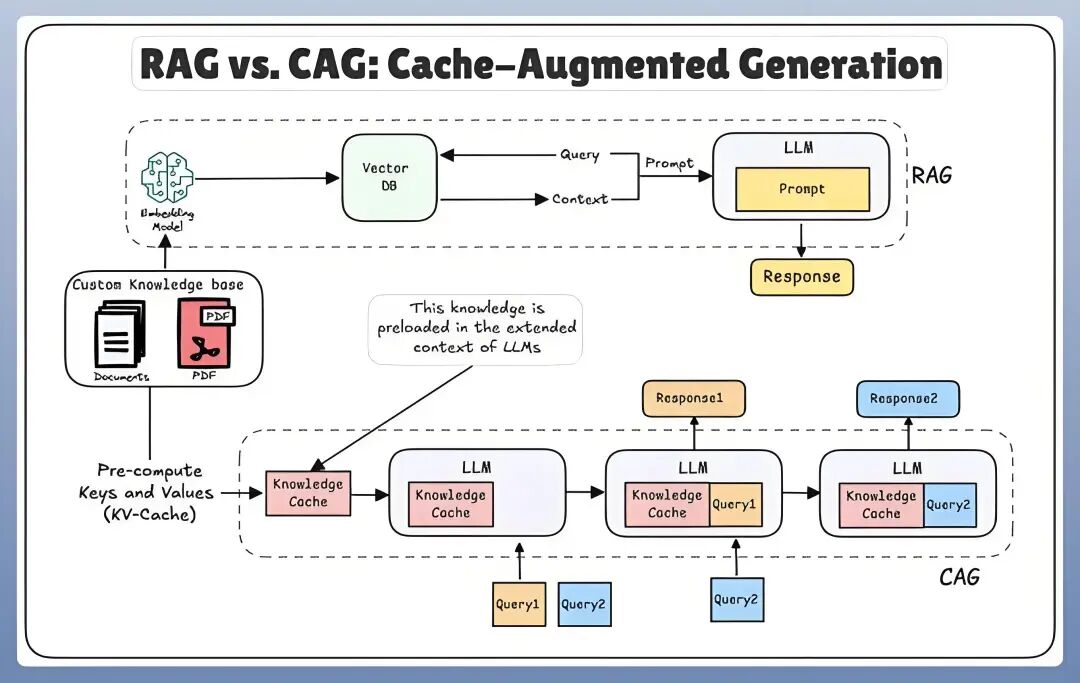

CAG(缓存增强生成)核心思想是在LLM扩展的上下文中,用预加载的知识取代实时文档检索。这种方案通过避免检索错误和延迟,确保生成速度快、更准确、更一致的文档,更多细节请看原文:https://arxiv.org/pdf/2412.15605v1。

CAG的主要优势:

- 延迟极低:所有数据均已预加载,因此无需等待检索。

- 减少错误:预先计算的值可避免排名或文档选择错误。

- 架构简单:无需单独的检索器,只需要加载缓存即可。

- 更快的推理速度:一旦缓存,响应速度将得到极大的提升。

- 更高的准确率:预先处理统一、完整的上下文会提高准率。

CAG的主要局限:

- 对动态数据缺乏灵活性。

- 会受到LLM上下文长度的限制。

学AI大模型的正确顺序,千万不要搞错了

🤔2026年AI风口已来!各行各业的AI渗透肉眼可见,超多公司要么转型做AI相关产品,要么高薪挖AI技术人才,机遇直接摆在眼前!

有往AI方向发展,或者本身有后端编程基础的朋友,直接冲AI大模型应用开发转岗超合适!

就算暂时不打算转岗,了解大模型、RAG、Prompt、Agent这些热门概念,能上手做简单项目,也绝对是求职加分王🔋

📝给大家整理了超全最新的AI大模型应用开发学习清单和资料,手把手帮你快速入门!👇👇

学习路线:

✅大模型基础认知—大模型核心原理、发展历程、主流模型(GPT、文心一言等)特点解析

✅核心技术模块—RAG检索增强生成、Prompt工程实战、Agent智能体开发逻辑

✅开发基础能力—Python进阶、API接口调用、大模型开发框架(LangChain等)实操

✅应用场景开发—智能问答系统、企业知识库、AIGC内容生成工具、行业定制化大模型应用

✅项目落地流程—需求拆解、技术选型、模型调优、测试上线、运维迭代

✅面试求职冲刺—岗位JD解析、简历AI项目包装、高频面试题汇总、模拟面经

以上6大模块,看似清晰好上手,实则每个部分都有扎实的核心内容需要吃透!

我把大模型的学习全流程已经整理📚好了!抓住AI时代风口,轻松解锁职业新可能,希望大家都能把握机遇,实现薪资/职业跃迁~

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献618条内容

已为社区贡献618条内容

所有评论(0)