智启山海,交互无界——云知声山海·知音 2.0 重磅发布

答案是云知声独创的 “山海·Atlas”智算一体基座,将通用多模态大模型底座与Atlas基础架构深度整合,既是专业智能体的基础,也是感知AI中枢的根基——将传统的ASR、TTS和全双工能力,有效整合到端到端大模型中,做到传统模块级联无法实现的极致交互体验和效率。随着智能体时代到来,云知声在“山海·Atlas”通用智算基座持续演进基础上,年前实现了“山海·知医”5.0医疗大模型升级,今天迎来了“山海

随着智能体时代到来,云知声在“山海·Atlas”通用智算基座持续演进基础上,年前实现了“山海·知医”5.0医疗大模型升级,今天迎来了“山海·知音”2.0的重磅发布,正在完成“一基两翼”技术战略升级的能力拼图。

“山海·知音”大模型 2.0——依托“山海·Atlas”的多模态、跨语言基座能力,让“山海·知医”等垂直专业智能体,惠及千家万户——听懂专业与乡音、聊出亲情与温度、极致机敏反应,是本次升级的三大能力进化。

听懂专业与乡音——ASR全景升级

此次模型ASR能力在公开测试集和自有全场景测试集中,均显现了领先的语音识别能力,在评测中实现了从通用到极端全面的领先水平,超过了国内主流的开源和闭源语音大模型,达到业界最高水平。特别是在高难度的复杂噪音与方言口音场景下,相比主流ASR模型性能提升了2.5%至3.6%,在复杂背景音环境下识别准确率更是在业内首次突破90%。

公开测试集

自有测试集

案例展示1:高噪环境下精准识别——商场购物

真实的语音识别环境中,还经常会面临专业术语识别不清、逻辑混乱等挑战。作为此次升级中最大的亮点,即模型“能够听得懂专业话”,它可结合上下文和行业术语,听懂专业场景中的每一个术语与指令,识别精度提升 30%。“它不是在‘听字’,而是在‘理解事’”。

例如在汽车4S店试驾场景中,当销售提及“方向盘”相关描述时,即使上下文未明确出现“半幅方向盘”,模型仍能通过逻辑推理准确识别。

案例展示2:上下文理解——汽车4S店试驾

而在严肃的医疗场景,模型能显式注入“依帕司他”“二甲双胍”等术语进行定向增强,确保识别结果更精准。

案例展示3:专业知识库——医疗对话录音转写

同时,模型支持30余种中文方言及14种国际语言的识别转写,无论是晦涩的粤语、闽南语、上海话,还是英、日、韩、法、德、泰等国际语言,均能实现精准转写。更进一步,模型还能融合讲义等视觉语义,构建“视听融合”闭环交互,进一步提升识别结果。

案例展示4:多方言语种混切——商务会议

聊出亲情与温度——TTS声动进化

如果说ASR能力是“耳朵”,那么TTS能力便是“嘴巴”。山海·知音-TTS以“高度拟人+创意多元”为核心,让语音合成兼具真实感与创造力,使科技更有温度。

它目前支持12种方言(粤语、四川话、上海话全拿下)+ 10种外语,清嗓、笑声、呼吸声都自然还原,甚至能切换 12种普通话风格,温柔、干练、亲切随你选。“科技不该高高在上,而该用你最舒服的方式说话。”

案例展示5:细腻情感表达——AI电商直播

山海·知音2.0-TTS合成文本

高兴:“家人们!下一个品!魔法保温杯!矮油厉害啦!倒进去的开水,只要60秒!一分钟的时间,就变55度温泉水!再倒杯冰美式进去,半小时还是透心凉!哎浅尝一下!”

咳嗽:“咳咳…对、对不起啊…太激动了呛到了…”

沉稳:“呃,等一下等一下等一下…这个杯底怎么在漏水啊?不是吧刚开播就翻车?我打开看下啊,害,是我刚才试用的时候把密封圈给碰歪了。啊没事,调一下,真金不怕火炼啊!这就没问题啦!”

大声:“哎,但是家人们福利来了啊!品牌方刚说了:看过刚才翻车的各位,只要您下单,立享三年只换不修!上链接!”

目前模型已支持粤语、四川话、上海话等12种方言,以及日语、韩语、泰语等10种外语。可实现跨方言、跨语种、跨情感的组合生成,针对小语种的语音韵律也进行了专项优化——如日语的“促音”、泰语的“声调变化”,合成自然度接近母语使用者。

案例展示6:多语种、方言支持——文旅宣传

山海·知音2.0-TTS合成文本

这就是上海,等你来解锁更多精彩。

此外,还支持一句话声音复刻以及播客级长文本合成,赋能有声内容创作与互动娱乐。

案例展示7:一句话声音复刻——视频配音

结合样音1的音色与样音2的情感特征,生成目标文本的音频

山海·知音2.0-TTS合成文本

什么?还要我等三十分钟?一天有多少个三十分钟?这天都快黑了,谁爱等谁等。

案例展示8:音色复刻——儿童伴读

山海·知音2.0-TTS合成文本

在远离城市灯火的地方,有一处“静语森林”。这里的树叶会在傍晚唱起轻柔的摇篮曲,溪水会随着月光流淌出银色的旋律。在森林最深处住着一只名叫小绒的松鼠,她有一个特别的身份——她是这片森林的星光编织师。

案例展示9:播客级长文本合成——播客

山海·知音2.0-TTS合成文本

A:哎,你有没有注意到,长大后我们学到的那些最关键的生存技能,其实根本不是学校里教的那些东西?

B:呵,你是说…职场摸鱼?

A:呵呵,太肤浅了!呵!其实是“如何体面地结束一场你不想继续的对话”。这可是门艺术啊!

B:对对对!我最懂这种感受!

A:从电梯里被话痨同事拦住,到家庭聚会上应付催婚的亲戚…

B:哦——!我知道了!还有就是,接到那些讨厌的推销电话时,如何不让对方觉得你是个坏人,却又能干脆利落地把它挂掉!

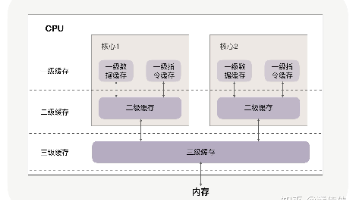

基于大模型的语音合成通常采用流匹配(Flow Matching)将大语言模型预测的语音Token转换为梅尔谱,再通过神经声码器(Neural Vocoder)重建为最终语音。但该方案普遍存在延迟较高的问题。业界常通过流匹配分段处理来降低延迟,但效果有限,且容易牺牲音质。

为实现真正高质量、低延迟的流式语音生成,云知声创新性地设计了基于纯因果注意力机制的流匹配模块,并与神经声码器进行联合优化,构建出端到端的纯流式推理架构。该方案在不损失合成质量的前提下,显著降低系统延迟——在低并发场景下,首包延迟已压缩至90毫秒以内,达到业界领先的实时交互水平。

因果注意力机制

极致机敏反应——端到端全双工交互

真正的智能交互,在于“理解语境、感受情绪、自然回应”。端到端模型实现流畅全双工面临的核心挑战是:需在流式收声时同步完成理解、决策与生成,并在任意打断瞬间保持对话状态连贯。山海·知音2.0基于端到端交互大脑攻克了这一难题,将全双工能力提升至新高度。

支持随时打断、即时接话、连贯追问,就像和一个真正聪明的朋友聊天,行云流水,毫无卡顿。“这不是问答,是对话。”

案例展示10:端到端全双工交互——与山海大模型对话

背后是谁在支撑这一切?

答案是云知声独创的 “山海·Atlas”智算一体基座,将通用多模态大模型底座与Atlas基础架构深度整合,既是专业智能体的基础,也是感知AI中枢的根基——将传统的ASR、TTS和全双工能力,有效整合到端到端大模型中,做到传统模块级联无法实现的极致交互体验和效率。

智起山海,知音万物

从手术室到乡间小路,从驾驶舱到老人床头,云知声相信:真正的智能,不是炫技,而是融入生活。

山海·知音 2.0,让 AI 不再“人工智障”,而是听得清、说得真、懂人心的伙伴。

这一次,AI 终于学会好好说话了。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)