多协议融合架构:一站式高性能MCP服务框架的设计与实现

本文提出了一种支持多协议的高性能MCP服务框架,通过分层架构设计实现协议与业务逻辑的彻底解耦。该框架同时支持Stdio、StreamableHttpless和SSE三种通信协议,采用异步非阻塞架构提升处理性能,并提供统一的上下文管理和服务生命周期管理。核心设计包括:1)业务逻辑与通信协议分离;2)全异步处理架构;3)跨协议的会话状态共享;4)模块化扩展能力。该方案解决了传统MCP框架在多场景适配中

在大模型生态与分布式系统深度融合的当下,MCP(Model Context Protocol,模型上下文协议)作为衔接模型推理、业务逻辑与终端交互的核心通信协议,其服务框架的场景适配能力成为技术落地的关键。MCP的核心价值在于上下文感知的会话式通信,而实际业务中,不同部署环境、交互终端对通信协议的要求存在显著差异:本地开发调试需要轻量的进程间通信方式,内网高吞吐服务调用追求低延迟的纯流式传输,Web前端与云服务交互则依赖标准化的HTTP长连接推送。

传统MCP服务框架多采用单协议绑定设计,开发人员需为不同场景适配不同的通信层代码,不仅造成业务逻辑与协议实现高度耦合,还大幅提升了框架的开发、维护与扩展成本。同时,随着云原生、边缘计算的普及,MCP服务需要在云端集群、边缘设备、本地单机等多环境无缝部署,对协议的兼容性、框架的轻量性提出了更高要求。

基于此,本文提出一款同时支持Stdio、StreamableHttpless、SSE三种协议的高性能MCP服务框架,通过协议与业务彻底解耦的分层架构、异步非阻塞的核心处理模型、统一的服务生命周期与上下文管理,实现单框架适配多场景的MCP通信需求。该框架既保留了各协议的原生优势,又解决了传统框架的耦合痛点,同时具备云原生、边缘计算的前瞻性扩展能力,为MCP生态的规模化落地提供了通用的通信层解决方案。

一、MCP服务框架的核心设计理念

本框架的设计围绕MCP协议的上下文原生特性与多场景适配需求展开,摒弃了传统框架“业务随协议定制”的思路,以“一次开发,多协议适配”为核心目标,确立了五大核心设计理念,为框架的高性能、可扩展、易维护奠定基础。

1.1 协议与业务彻底解耦

这是框架的核心设计原则,将MCP核心业务逻辑与通信协议实现拆分为两个完全独立的层级:业务逻辑层仅关注MCP协议的上下文管理、请求解析、响应生成等核心能力,不涉及任何通信层的细节;协议实现层则专注于不同协议的通信规则、数据收发、连接管理,通过统一的接口调用业务逻辑层,实现“业务代码零修改,新增协议仅需实现通信层”。

1.2 异步非阻塞的全链路处理

针对流式通信、长连接交互等MCP典型场景,框架基于Python asyncio 实现全异步非阻塞架构,从协议的连接建立、数据读写,到业务逻辑的请求处理,均采用协程机制,避免了传统同步架构的线程阻塞、资源竞争问题,大幅提升框架的高并发处理能力,适配高吞吐、长连接的MCP服务需求。

1.3 MCP原生的统一上下文管理

上下文是MCP协议的灵魂,框架为所有协议提供全局统一的上下文管理模块,实现会话状态的跨协议共享、历史交互的持久化、多会话的隔离管理。无论终端通过哪种协议发起请求,都能基于同一个会话上下文实现连续的交互,保证MCP协议的核心特性不随通信方式改变。

1.4 优雅的服务生命周期管理

框架提供单入口的统一管理能力,支持所有协议服务的一键启动、优雅停止,同时实现了服务的异常监控、资源自动释放、连接优雅关闭。当框架收到停止指令时,会先终止新连接的建立,再处理完已建立连接的剩余请求,最后释放所有资源,避免数据丢失或连接异常。

1.5 模块化的可扩展设计

框架的所有模块均采用插件化的注册机制:核心业务逻辑层提供可扩展的接口,支持自定义请求解析、响应生成、上下文存储;协议实现层为新增协议预留标准化的实现模板,只需实现指定的启动、停止、数据处理接口,即可快速集成到框架中;同时,框架的基础设施层支持与第三方组件的无缝集成,为后续的云原生、可观测性建设提供扩展入口。

二、框架整体架构设计

本框架采用四层分层架构设计,从下到上依次为基础设施层、核心协议层、业务逻辑层、框架管理层,各层级之间通过标准化的接口交互,层内模块高内聚,层间低耦合,既保证了框架的稳定性,又提升了扩展能力。整体架构如下:

┌───────────────────────── 框架管理层 ─────────────────────────┐

│ 统一启动/停止、服务生命周期管理、异常监控、资源管理 │

└───────────────────────────┬─────────────────────────────────┘

│

┌───────────────────────── 业务逻辑层 ─────────────────────────┐

│ MCP核心处理:上下文管理、请求解析、响应生成、会话隔离 │

└───────────────────────────┬─────────────────────────────────┘

│

┌───────────────────────── 核心协议层 ─────────────────────────┐

│ ┌──────────┐ ┌────────────────────┐ ┌──────────┐ │

│ │ Stdio │ │ StreamableHttpless │ │ SSE │ │

│ │ 协议服务 │ │ 协议服务 │ │ 协议服务 │ │

│ └──────────┘ └────────────────────┘ └──────────┘ │

└───────────────────────────┬─────────────────────────────────┘

│

┌───────────────────────── 基础设施层 ─────────────────────────┐

│ 异步IO:asyncio | Web框架:FastAPI | 服务运行:uvicorn | 网络:socket │

└─────────────────────────────────────────────────────────────┘

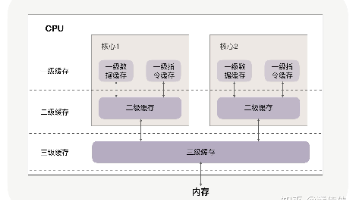

2.1 基础设施层

框架的底层技术支撑,封装了与语言、第三方工具相关的基础能力,对上层模块提供标准化的接口,屏蔽底层实现细节。核心组件包括:

- asyncio:Python原生的异步IO框架,为全框架提供协程运行环境、事件循环、异步网络通信能力,是框架高并发的核心基础;

- FastAPI:轻量高性能的Web框架,为SSE协议提供HTTP服务基础,支持标准化的SSE响应格式、请求路由管理;

- uvicorn:ASGI协议的服务器实现,为FastAPI提供生产级的运行环境,支持高并发的HTTP长连接;

- 原生Socket:为StreamableHttpless协议提供纯TCP网络通信能力,实现无HTTP封装的流式数据传输。

基础设施层的设计原则是通用化、可替换,例如可将FastAPI替换为Sanic,将uvicorn替换为gunicorn,不影响上层模块的正常运行。

2.2 核心协议层

框架的通信层核心,实现了Stdio、StreamableHttpless、SSE三种协议的服务端逻辑,是框架对接不同终端的桥梁。该层的每个协议服务均为独立模块,具备启动、停止、数据收发、连接管理四大核心能力,且所有协议服务通过统一的接口调用业务逻辑层,保证了协议层与业务层的解耦。

三种协议服务各自保留原生特性,适配不同的业务场景,且共享框架的异步IO环境与上下文管理能力,实现了“多协议并行运行,单上下文统一管理”。

2.3 业务逻辑层

框架的MCP核心能力层,是所有协议服务的统一处理入口,专注于MCP协议的业务逻辑实现,与通信协议完全无关。该层的核心是MCP业务逻辑引擎,提供了上下文管理、请求解析、响应生成、会话隔离、历史记录管理等MCP协议的原生能力,同时对外提供标准化的请求处理接口,所有协议服务只需调用该接口,即可完成从“请求接收”到“响应生成”的全流程处理。

业务逻辑层是框架的业务扩展核心,开发人员可根据实际需求,自定义请求解析规则、响应生成逻辑、上下文存储方式(如内存、Redis、数据库),无需修改任何协议层代码。

2.4 框架管理层

框架的总控中心,实现了对所有模块的统一管理,是框架的唯一运行入口。该层的核心能力包括:

- 统一初始化:完成基础设施层、核心协议层、业务逻辑层的模块初始化,实现各层之间的接口绑定;

- 统一生命周期管理:提供

start_all、stop_all方法,实现所有协议服务的一键启动、优雅停止; - 异常监控与处理:对各协议服务、业务逻辑层的异常进行统一捕获、日志记录,保证框架的稳定性;

- 资源统一管理:对框架的协程、网络连接、文件句柄等资源进行统一管理,避免资源泄漏。

框架管理层的设计,让开发人员与运维人员无需关注各模块的独立运行细节,只需通过一个入口即可实现框架的全生命周期管理,大幅降低了框架的使用成本。

三、核心模块的详细实现

本框架基于Python实现(兼顾开发效率与异步生态成熟度),以下将从业务逻辑层、核心协议层、框架管理层三个核心层级,详细讲解各模块的实现思路、核心代码与设计细节,同时保留各协议的原生特性与MCP的上下文核心能力。

3.1 业务逻辑层:MCP核心业务逻辑引擎

业务逻辑层的核心是MCPBusinessLogic类,该类实现了MCP协议的上下文原生管理与通用请求处理,是所有协议服务的统一处理入口,其设计的核心是通用性、可扩展、上下文感知。

3.1.1 核心属性与初始化

该类的核心属性是上下文字典,用于维护单个会话的状态、历史交互记录,同时支持多会话的隔离管理(通过会话ID区分)。核心初始化代码如下:

import asyncio

from typing import Dict, List, Optional

class MCPBusinessLogic:

"""MCP核心业务逻辑引擎,与协议层完全解耦"""

def __init__(self):

# 全局会话管理:key为session_id,value为会话上下文

self.global_sessions: Dict[str, Dict] = {}

# 默认会话ID(适配单会话场景)

self.default_session_id = "default_mcp_session_001"

# 初始化默认会话上下文

self._init_session(self.default_session_id)

def _init_session(self, session_id: str) -> None:

"""初始化单个会话的上下文,MCP核心特性"""

if session_id not in self.global_sessions:

self.global_sessions[session_id] = {

"session_id": session_id, # 会话唯一标识

"create_time": asyncio.get_event_loop().time(), # 会话创建时间

"interact_history": [], # 交互历史记录(请求+响应)

"context_state": {}, # 自定义上下文状态(可扩展,如模型参数、业务状态)

"last_interact_time": asyncio.get_event_loop().time() # 最后交互时间

}

其中,context_state为自定义扩展字段,开发人员可根据实际需求添加任意业务相关的状态信息,如大模型的温度参数、对话的角色设定、业务的流程状态等,实现MCP上下文的灵活扩展。

3.1.2 核心方法:请求处理与上下文更新

该类对外提供统一的异步请求处理接口process_request,所有协议服务均通过调用该方法完成请求处理,该方法的核心逻辑包括:会话校验、请求解析、上下文更新、响应生成、历史记录存储,同时保留了自定义扩展的入口。核心代码如下:

async def process_request(self, request: str, session_id: Optional[str] = None) -> str:

"""

MCP统一请求处理接口

:param request: 终端发起的MCP请求文本

:param session_id: 会话ID,默认为默认会话

:return: MCP响应文本

"""

# 会话校验,无则初始化

session_id = session_id or self.default_session_id

self._init_session(session_id)

session_context = self.global_sessions[session_id]

# 更新最后交互时间

session_context["last_interact_time"] = asyncio.get_event_loop().time()

# 1. 请求解析(可扩展:如解析MCP指令、参数、业务标识)

parsed_request = self._parse_request(request)

# 2. 上下文感知的响应生成(MCP核心,可替换为实际业务逻辑,如调用大模型、业务接口)

response = self._generate_response(parsed_request, session_context)

# 3. 更新交互历史与上下文状态(MCP上下文持久化)

self._update_context(session_context, parsed_request, response)

# 4. 返回标准化响应

return f"[MCP-Session:{session_id}] {response}"

def _parse_request(self, request: str) -> str:

"""请求解析(可扩展:如正则解析、JSON解析、MCP指令解析)"""

# 示例:简单清洗,可替换为实际解析逻辑

return request.strip()

def _generate_response(self, parsed_request: str, session_context: Dict) -> str:

"""响应生成(可扩展:如调用大模型、业务逻辑、规则引擎)"""

# 示例:上下文感知的响应,基于交互历史生成

interact_count = len(session_context["interact_history"]) // 2

return f"Received request (count:{interact_count+1}): {parsed_request.upper()}"

def _update_context(self, session_context: Dict, request: str, response: str) -> None:

"""更新上下文与交互历史(MCP核心)"""

session_context["interact_history"].append(f"Request: {request}")

session_context["interact_history"].append(f"Response: {response}")

# 可扩展:更新自定义上下文状态,如根据请求修改模型参数

# session_context["context_state"]["temperature"] = 0.7

该方法的设计原则是异步化、可扩展,所有私有方法(_parse_request、_generate_response、_update_context)均可根据实际业务需求重写,例如将_generate_response替换为调用大模型的推理接口,将_parse_request替换为解析MCP标准化的指令格式,实现框架与实际业务的无缝对接。

3.1.3 扩展方法:会话管理

为了适配多会话场景,该类还提供了会话的增删改查、超时清理等扩展方法,实现MCP多会话的精细化管理,核心代码如下:

def get_session(self, session_id: str) -> Optional[Dict]:

"""获取指定会话的上下文"""

return self.global_sessions.get(session_id)

def delete_session(self, session_id: str) -> bool:

"""删除指定会话,释放资源"""

if session_id in self.global_sessions and session_id != self.default_session_id:

del self.global_sessions[session_id]

return True

return False

async def clear_timeout_sessions(self, timeout: int = 3600) -> None:

"""清理超时无交互的会话(异步定时任务,可由框架管理层启动)"""

current_time = asyncio.get_event_loop().time()

timeout_sessions = [

sid for sid, ctx in self.global_sessions.items()

if sid != self.default_session_id and (current_time - ctx["last_interact_time"]) > timeout

]

for sid in timeout_sessions:

self.delete_session(sid)

print(f"Cleaned {len(timeout_sessions)} timeout MCP sessions")

通过该方法,框架可实现会话的自动超时清理,避免因大量无效会话导致的内存泄漏,提升框架的资源利用率。

3.2 核心协议层:三大协议服务的实现

核心协议层实现了Stdio、StreamableHttpless、SSE三种协议的服务端逻辑,每个协议服务均为独立的异步类,具备启动、停止、数据收发、连接管理四大核心能力,且所有协议服务均通过调用MCPBusinessLogic的process_request方法处理请求,实现了与业务层的完全解耦。

以下将详细讲解每种协议服务的设计思路、核心实现、场景适配,同时保留各协议的原生特性。

3.2.1 Stdio协议服务:轻量进程间通信

设计思路:Stdio协议基于标准输入/输出(stdin/stdout) 实现进程间通信,是最轻量的通信方式,无需网络连接,适用于本地开发调试、容器内进程交互、单机单实例的MCP服务调用。本框架的Stdio服务采用异步读写方式,避免了传统同步读写的阻塞问题,同时支持通过输入指令实现服务的手动退出。

核心实现:StdioService类,核心代码如下:

import sys

class StdioService:

"""Stdio协议MCP服务:轻量进程间通信"""

def __init__(self, business_logic: MCPBusinessLogic):

self.bl = business_logic # 绑定业务逻辑引擎

self.running = False # 服务运行状态

async def start(self):

"""启动Stdio服务,异步读写stdin/stdout"""

self.running = True

print(f"[StdioMCP] 服务已启动 | 场景:本地调试/进程间通信 | 退出指令:exit")

while self.running:

# 异步读取标准输入(避免阻塞事件循环)

input_data = await asyncio.to_thread(sys.stdin.readline)

if not input_data:

continue

input_data = input_data.strip()

# 退出指令处理

if input_data == "exit":

self.running = False

break

# 调用MCP业务逻辑引擎处理请求

response = await self.bl.process_request(input_data)

# 异步输出到标准输出

await asyncio.to_thread(print, f"[StdioResponse] {response}")

async def stop(self):

"""优雅停止Stdio服务"""

self.running = False

print(f"[StdioMCP] 服务已优雅停止")

关键设计细节:

- 使用

asyncio.to_thread实现标准输入/输出的异步操作,避免同步读写阻塞框架的事件循环,保证其他协议服务的正常运行; - 提供专属退出指令

exit,实现服务的手动优雅停止; - 直接绑定业务逻辑引擎,通过统一接口

process_request处理请求,无任何额外的协议解析逻辑,保留Stdio的轻量性。

场景适配:本地开发调试MCP服务、容器内MCP进程与其他进程的通信、单机单实例的轻量MCP服务调用。

3.2.2 StreamableHttpless协议服务:纯TCP低延迟流式通信

设计思路:StreamableHttpless协议基于纯TCP Socket实现流式数据传输,无任何HTTP封装,是低延迟、高吞吐的通信方式,适用于内网高吞吐MCP服务调用、边缘设备与网关的通信、对延迟敏感的分布式MCP服务。本框架的StreamableHttpless服务采用异步TCP网络通信,支持多客户端并发连接,同时实现了按行分割的流式数据解析(可扩展为自定义二进制帧格式),保证了数据传输的高效性与灵活性。

核心实现:StreamableHttplessService类,核心代码如下:

class StreamableHttplessService:

"""StreamableHttpless协议MCP服务:纯TCP低延迟流式通信"""

def __init__(self, business_logic: MCPBusinessLogic, host: str = "0.0.0.0", port: int = 9000):

self.bl = business_logic # 绑定业务逻辑引擎

self.host = host # 服务监听地址

self.port = port # 服务监听端口

self.running = False # 服务运行状态

self.server: Optional[asyncio.Server] = None # TCP服务器实例

async def handle_client(self, reader: asyncio.StreamReader, writer: asyncio.StreamWriter):

"""处理单个TCP客户端连接(异步,支持多客户端并发)"""

# 获取客户端地址

client_addr = writer.get_extra_info('peername')

print(f"[HttplessMCP] 客户端连接 | 地址:{client_addr} | 协议:纯TCP流式")

try:

while self.running:

# 异步流式读取数据(按行分割,可扩展为自定义帧格式)

data = await reader.readline()

if not data: # 客户端断开连接

break

# 解码请求数据

request = data.decode('utf-8').strip()

if request == "exit": # 客户端退出指令

break

# 调用MCP业务逻辑引擎处理请求

response = await self.bl.process_request(request)

# 异步流式返回响应(添加换行符,作为客户端解析分隔符)

writer.write(f"{response}\n".encode('utf-8'))

await writer.drain() # 确保数据发送完成

except Exception as e:

print(f"[HttplessMCP] 客户端异常 | 地址:{client_addr} | 错误:{str(e)}")

finally:

# 优雅关闭客户端连接

writer.close()

await writer.wait_closed()

print(f"[HttplessMCP] 客户端断开 | 地址:{client_addr}")

async def start(self):

"""启动纯TCP流式服务,监听指定地址端口"""

self.running = True

# 启动异步TCP服务器

self.server = await asyncio.start_server(self.handle_client, self.host, self.port)

print(f"[HttplessMCP] 服务已启动 | 地址:tcp://{self.host}:{self.port} | 场景:内网高吞吐/边缘通信")

# 持续监听客户端连接

await self.server.serve_forever()

async def stop(self):

"""优雅停止纯TCP流式服务"""

self.running = False

if self.server:

# 关闭TCP服务器,停止接收新连接

self.server.close()

await self.server.wait_closed()

print(f"[HttplessMCP] 服务已优雅停止 | 地址:tcp://{self.host}:{self.port}")

关键设计细节:

- 使用

asyncio.start_server实现异步TCP服务器,支持多客户端并发连接,每个客户端连接由独立的协程处理,无线程阻塞; - 采用按行分割的流式数据解析,通过

\n作为数据分隔符,简化客户端解析逻辑,同时支持扩展为自定义二进制帧格式(如添加数据长度、校验位),提升数据传输的可靠性; - 实现了客户端连接的优雅管理,包括连接异常捕获、连接关闭后的资源释放,避免因客户端异常导致的服务崩溃;

- 监听

0.0.0.0地址,支持内网所有设备的访问,适配边缘设备、内网服务的通信需求。

场景适配:内网高吞吐MCP服务调用、边缘智能设备与云端网关的MCP通信、对延迟敏感的分布式MCP服务、工业物联网设备的MCP数据交互。

3.2.3 SSE协议服务:HTTP标准化长连接推送

设计思路:SSE(Server-Sent Events,服务器推送事件)是基于HTTP协议的标准化长连接推送方式,服务端主动向客户端推送数据,客户端通过标准的EventSource接口接收数据,适用于Web前端与MCP服务的实时交互、云服务的长连接推送、浏览器端的会话式MCP调用。本框架的SSE服务基于FastAPI+uvicorn实现,兼容HTTP标准与SSE协议格式,同时支持心跳检测、断线重连的扩展能力,保证长连接的稳定性。

核心实现:SSEService类,核心代码如下:

from fastapi import FastAPI

from fastapi.responses import StreamingResponse

import uvicorn

from typing import AsyncGenerator

class SSEService:

"""SSE协议MCP服务:HTTP标准化长连接推送"""

def __init__(self, business_logic: MCPBusinessLogic, host: str = "0.0.0.0", port: int = 8000):

self.bl = business_logic # 绑定业务逻辑引擎

self.host = host # 服务监听地址

self.port = port # 服务监听端口

self.running = False # 服务运行状态

self.app = FastAPI() # FastAPI实例

self.server: Optional[uvicorn.Server] = None # uvicorn服务器实例

# 注册SSE路由

self._register_routes()

def _register_routes(self):

"""注册SSE协议路由,标准化HTTP接口"""

@self.app.get("/mcp/sse", summary="MCP SSE长连接推送接口")

async def mcp_sse(session_id: Optional[str] = None) -> StreamingResponse:

"""

MCP SSE标准化接口

:param session_id: 会话ID,可选,默认为默认会话

:return: SSE流式响应

"""

async def event_generator() -> AsyncGenerator[str, None]:

"""SSE事件生成器,按SSE标准格式推送数据"""

count = 0

while self.running:

try:

# 方式1:模拟客户端请求(可扩展为从HTTP Body/参数获取实际请求)

# 方式2:对接业务消息队列,实现被动推送(如模型推理结果、业务状态变化)

request = f"SSE Real-Time Request {count}"

# 调用MCP业务逻辑引擎处理请求

response = await self.bl.process_request(request, session_id=session_id)

# 按SSE标准格式生成响应(data: 内容\n\n,支持event、id字段扩展)

yield f"data: {response}\n\n"

count += 1

# 模拟推送间隔(可根据实际业务调整,或实现被动推送)

await asyncio.sleep(1)

except Exception as e:

yield f"data: [SSE Error] {str(e)}\n\n"

await asyncio.sleep(1)

# 返回SSE流式响应,设置媒体类型为text/event-stream

return StreamingResponse(

event_generator(),

media_type="text/event-stream",

headers={

"Cache-Control": "no-cache",

"Connection": "keep-alive",

"Access-Control-Allow-Origin": "*" # 跨域支持,适配Web前端

}

)

async def start(self):

"""启动SSE服务,基于FastAPI+uvicorn实现生产级HTTP服务"""

self.running = True

# 配置uvicorn服务器

config = uvicorn.Config(

self.app,

host=self.host,

port=self.port,

log_level="info"

)

self.server = uvicorn.Server(config)

print(f"[SSEMCP] 服务已启动 | 地址:http://{self.host}:{self.port}/mcp/sse | 场景:Web前端/云服务长连接")

# 启动uvicorn服务器

await self.server.serve()

async def stop(self):

"""优雅停止SSE服务"""

self.running = False

if self.server:

# 优雅关闭uvicorn服务器

await self.server.shutdown()

print(f"[SSEMCP] 服务已优雅停止 | 地址:http://{self.host}:{self.port}/mcp/sse")

关键设计细节:

- 基于FastAPI实现标准化的HTTP接口,路由为

/mcp/sse,支持通过URL参数传递会话ID,实现多会话的隔离管理; - 严格遵循SSE协议标准格式,以

data: 内容\n\n为基础响应格式,支持event(事件类型)、id(事件ID)等字段的扩展,兼容所有客户端的EventSource接口; - 配置跨域支持(

Access-Control-Allow-Origin: *),适配Web前端的跨域请求需求,无需客户端额外配置; - 采用异步事件生成器实现流式推送,支持主动推送(如定时请求处理)与被动推送(如对接消息队列,接收业务事件后推送)的扩展;

- 基于uvicorn实现生产级的HTTP服务器运行环境,支持高并发的HTTP长连接,满足云服务、Web前端的访问需求。

场景适配:Web前端与MCP服务的实时会话交互、云MCP服务的长连接推送、浏览器端的大模型对话交互、云平台对终端的实时状态推送。

3.3 框架管理层:统一全生命周期管理

框架管理层的核心是MCPFramework类,作为框架的唯一运行入口,实现了对业务逻辑引擎、三大协议服务的统一初始化、启动、停止、异常监控,同时支持定时任务的启动(如会话超时清理),核心代码如下:

class MCPFramework:

"""MCP多协议服务框架总控类:统一全生命周期管理"""

def __init__(self):

# 1. 初始化MCP核心业务逻辑引擎

self.business_logic = MCPBusinessLogic()

# 2. 初始化三大协议服务,绑定业务逻辑引擎

self.stdio_service = StdioService(self.business_logic)

self.httpless_service = StreamableHttplessService(self.business_logic)

self.sse_service = SSEService(self.business_logic)

# 3. 存储所有协议服务的异步任务

self.service_tasks: List[asyncio.Task] = []

# 4. 初始化定时任务(如会话超时清理)

self.timer_tasks: List[asyncio.Task] = []

async def _start_timer_tasks(self):

"""启动框架定时任务"""

# 启动会话超时清理任务,每30分钟执行一次

async def clear_timeout_sessions_loop():

while True:

await self.business_logic.clear_timeout_sessions(timeout=3600)

await asyncio.sleep(1800)

self.timer_tasks.append(asyncio.create_task(clear_timeout_sessions_loop()))

print(f"[MCPFramework] 定时任务已启动 | 会话超时清理:30分钟/次")

async def start_all(self):

"""启动所有协议服务与定时任务"""

try:

# 1. 启动定时任务

await self._start_timer_tasks()

# 2. 创建并启动三大协议服务的异步任务

self.service_tasks = [

asyncio.create_task(self.stdio_service.start()),

asyncio.create_task(self.httpless_service.start()),

asyncio.create_task(self.sse_service.start())

]

print(f"[MCPFramework] 所有协议服务已启动 | Stdio/SSE/StreamableHttpless")

# 3. 等待所有服务任务完成(或被停止)

await asyncio.gather(*self.service_tasks, return_exceptions=True)

except Exception as e:

print(f"[MCPFramework] 服务启动失败 | 错误:{str(e)}")

await self.stop_all()

async def stop_all(self):

"""优雅停止所有协议服务、定时任务,释放所有资源"""

print(f"[MCPFramework] 开始优雅停止所有服务...")

# 1. 停止所有协议服务

await self.stdio_service.stop()

await self.httpless_service.stop()

await self.sse_service.stop()

# 2. 取消所有协议服务任务

for task in self.service_tasks:

if not task.done():

task.cancel()

# 3. 取消所有定时任务

for task in self.timer_tasks:

if not task.done():

task.cancel()

# 4. 等待所有任务取消完成

await asyncio.gather(*self.service_tasks, *self.timer_tasks, return_exceptions=True)

print(f"[MCPFramework] 所有服务已优雅停止 | 所有资源已释放")

# 框架运行入口

if __name__ == "__main__":

framework = MCPFramework()

try:

# 启动框架

asyncio.run(framework.start_all())

except KeyboardInterrupt:

# 捕获Ctrl+C,优雅停止框架

asyncio.run(framework.stop_all())

print(f"[MCPFramework] 框架已正常退出")

核心设计价值:

- 单入口运行:开发人员只需运行该类的

start_all方法,即可启动所有协议服务与定时任务,无需关注各服务的独立启动细节; - 优雅停止:捕获

Ctrl+C等退出信号,先停止所有服务,再取消所有异步任务,最后释放所有资源,避免数据丢失、连接异常、资源泄漏; - 定时任务集成:支持框架级的定时任务启动,为会话超时清理、监控数据上报、日志轮转等运维需求提供扩展入口;

- 异常容错:在服务启动过程中捕获异常,自动调用

stop_all方法停止所有服务,保证框架的稳定性。

四、框架的核心特性与优势

相较于传统的单协议MCP服务框架,本框架通过多协议融合、业务与协议解耦、异步高并发的设计,实现了场景适配性、开发效率、运行性能的全面提升,其核心特性与优势可总结为六大点:

4.1 多协议无缝融合,一站式适配全场景

框架同时支持Stdio、StreamableHttpless、SSE三种协议,各协议服务并行运行、独立管理,且共享同一套MCP业务逻辑引擎与上下文管理能力,实现了**“单框架适配全场景”**:

- 本地开发调试:使用Stdio协议,轻量无依赖,无需配置网络;

- 内网高吞吐调用:使用StreamableHttpless协议,无HTTP封装,低延迟高吞吐;

- Web前端交互:使用SSE协议,标准化HTTP接口,兼容所有Web生态。

开发人员无需为不同场景开发不同的MCP框架,大幅降低了框架的开发与维护成本。

4.2 业务与协议彻底解耦,开发效率指数级提升

框架采用分层架构,将MCP核心业务逻辑与通信协议实现完全分离,业务逻辑层仅关注MCP协议的核心能力,协议层仅关注通信规则。这种设计带来两大优势:

- 业务代码一次开发,多协议适配:开发人员只需实现一次MCP业务逻辑,即可通过所有协议服务对外提供能力,无需为不同协议重复编写业务代码;

- 协议扩展零成本:新增协议(如WebSocket、gRPC)时,只需实现协议服务的四大核心能力(启动、停止、数据收发、连接管理),无需修改任何业务逻辑代码,框架的可扩展能力极强。

4.3 全异步非阻塞架构,高并发处理能力突出

框架基于Python asyncio 实现全链路异步非阻塞处理,从网络连接、数据读写到请求处理,均采用协程机制,避免了传统同步架构的线程阻塞、资源竞争问题:

- 支持多客户端并发连接,每个连接由独立的协程处理,无线程数限制;

- 异步IO操作不阻塞事件循环,保证各协议服务的并行高效运行;

- 适配高吞吐、长连接的MCP典型场景,如大模型实时对话、边缘设备持续数据交互。

4.4 MCP原生上下文管理,支持多会话隔离与持久化

框架为MCP协议量身打造了统一的上下文管理模块,实现了上下文的原生支持:

- 支持单会话与多会话的灵活切换,通过会话ID实现多会话的完全隔离;

- 维护会话的交互历史、创建时间、最后交互时间,实现上下文的持久化;

- 提供自定义上下文状态扩展字段,支持业务相关的状态信息存储;

- 实现会话超时自动清理,避免资源泄漏,提升框架的资源利用率。

无论终端通过哪种协议发起请求,都能基于同一个会话上下文实现连续的会话式交互,保证了MCP协议的核心特性。

4.5 统一的服务生命周期管理,运维成本大幅降低

框架提供单入口的全生命周期管理,实现了所有协议服务、定时任务的统一启动、优雅停止、异常监控,运维人员无需关注各服务的独立运行细节:

- 一键启动所有服务与定时任务,简化部署流程;

- 优雅停止所有服务,保证数据不丢失、资源不泄漏;

- 统一的异常监控与日志记录,便于问题排查与定位;

- 支持定时任务的集成,实现会话清理、监控上报等自动化运维。

4.6 高度的模块化与可扩展性,适配业务快速迭代

框架的所有模块均采用插件化的注册机制,各层级之间通过标准化的接口交互,具备高度的模块化与可扩展性:

- 业务逻辑层:支持自定义请求解析、响应生成、上下文存储方式;

- 核心协议层:支持新增协议服务的快速集成,预留标准化的实现模板;

- 基础设施层:支持第三方工具的替换,如FastAPI替换为Sanic,uvicorn替换为gunicorn;

- 框架管理层:支持定时任务、异常处理、日志系统的扩展。

框架可快速适配业务的迭代需求,如从本地调试到云服务部署,从单会话到多会话,从主动推送到被动推送,无需重构框架核心代码。

五、前瞻性扩展与落地实践

本框架的设计不仅满足当前MCP服务的多协议适配需求,还基于云原生、边缘计算、分布式系统的技术发展趋势,预留了丰富的前瞻性扩展入口,同时可快速落地到实际业务场景中。以下将讲解框架的前瞻性扩展方向与典型落地实践案例。

5.1 框架的前瞻性扩展方向

基于框架的模块化与可扩展设计,可从6个方向进行前瞻性扩展,让框架适配更复杂的业务场景与技术趋势:

5.1.1 云原生适配:容器化与K8s集成

云原生是分布式服务的主流部署方式,本框架可快速实现云原生适配:

- 容器化部署:将框架打包为Docker镜像,通过Dockerfile配置依赖与运行命令,实现框架的轻量容器化部署;

- K8s服务集成:将Docker镜像部署到K8s集群,通过Service实现服务发现,通过ConfigMap实现框架配置的动态管理,通过HPA实现服务的自动扩缩容;

- 配置中心集成:集成Nacos、Apollo等配置中心,实现框架配置(如监听端口、会话超时时间、协议开关)的动态更新,无需重启服务。

5.1.2 边缘计算场景优化:轻量部署与低资源占用

边缘计算要求服务具备轻量、低资源、离线运行的特性,本框架可针对边缘计算场景进行优化:

- 轻量化裁剪:根据边缘设备的需求,裁剪不必要的协议服务与模块,如仅保留StreamableHttpless协议服务,降低框架的内存与CPU占用;

- 离线运行支持:将上下文存储到边缘设备的本地磁盘(如SQLite),实现框架的离线运行,无需依赖云端服务;

- 边缘云协同:实现边缘框架与云端框架的上下文同步,通过MQTT协议将边缘设备的交互数据同步到云端,实现边缘云协同的MCP服务体系。

5.1.3 分布式上下文:跨节点会话共享

针对分布式部署场景,框架可实现分布式上下文管理,解决跨节点的会话共享问题:

- 分布式缓存集成:将全局会话上下文存储到Redis、Memcached等分布式缓存中,实现跨节点的会话上下文共享;

- 会话持久化:将会话的交互历史与状态存储到MySQL、MongoDB等数据库中,实现会话的持久化,服务重启后会话状态不丢失;

- 分布式锁:集成Redis分布式锁,解决多节点同时修改同一个会话上下文的并发问题。

5.1.4 协议扩展:新增WebSocket/gRPC协议

框架的核心协议层预留了标准化的协议实现模板,可快速新增WebSocket、gRPC等主流协议:

- WebSocket协议:基于FastAPI实现WebSocket服务,支持双向实时通信,适配Web前端的实时交互需求;

- gRPC协议:基于Protobuf实现标准化的二进制通信,实现更高的传输效率与更强的兼容性,适配分布式服务的调用需求。

新增协议后,框架的场景适配能力将进一步提升,实现“全协议覆盖”。

5.1.5 可观测性建设:日志、监控、链路追踪

可观测性是生产级服务的核心需求,框架可集成主流的可观测性组件,实现日志、监控、链路追踪的一体化建设:

- 日志系统:集成loguru、ELK,实现框架的结构化日志记录、收集、分析;

- 监控系统:集成Prometheus+Grafana,实现框架的指标监控(如连接数、请求数、响应时间、会话数),并提供可视化监控面板;

- 链路追踪:集成SkyWalking、Jaeger,实现框架的分布式链路追踪,便于问题排查与性能优化。

5.1.6 高可用设计:服务集群与故障转移

针对生产环境的高可用需求,框架可实现服务集群与故障转移:

- 服务集群部署:将框架部署为多实例集群,通过Nginx、HAProxy实现负载均衡,提升服务的处理能力与可用性;

- 故障转移:集成Keepalived实现主备切换,当主实例故障时,备实例自动接管服务,保证服务的连续性;

- 熔断与限流:集成Sentinel、Hystrix实现服务的熔断与限流,避免因大量异常请求导致的服务崩溃。

5.2 典型落地实践案例

本框架可快速落地到大模型推理服务、边缘智能设备通信等典型MCP业务场景中,以下将讲解两个落地案例,展示框架的实际应用价值。

5.2.1 案例1:大模型推理的MCP多协议服务

业务场景:某大模型公司需要为客户提供大模型推理的MCP会话服务,客户包括本地开发人员、内网业务系统、Web前端开发者,需要适配不同的访问方式,同时保证会话的上下文连续性。

框架落地:

- 本地开发人员:使用框架的Stdio协议服务,本地运行框架即可调用大模型推理服务,无需配置网络,轻量调试;

- 内网业务系统:使用框架的StreamableHttpless协议服务,通过纯TCP低延迟调用大模型推理服务,满足内网业务系统的高吞吐需求;

- Web前端开发者:使用框架的SSE协议服务,通过HTTP长连接实现Web前端与大模型的实时会话交互,兼容所有浏览器。

落地价值:

- 大模型推理的业务逻辑只需实现一次,即可通过三种协议对外提供服务,开发效率提升60%以上;

- 统一的上下文管理,保证了不同终端的会话连续性,提升了客户体验;

- 全异步架构支持高并发的推理请求,满足业务系统与Web前端的访问需求。

5.2.2 案例2:边缘智能设备的MCP通信服务

业务场景:某物联网公司的边缘智能设备(如智能摄像头、工业传感器)需要与云端网关进行MCP通信,边缘设备需低延迟上报数据,云端网关需实时推送指令给边缘设备,同时开发人员需要本地调试边缘设备的MCP服务。

框架落地:

- 边缘设备:在边缘网关部署框架,仅启用StreamableHttpless协议服务,边缘设备通过纯TCP与网关进行低延迟MCP通信,上报数据并接收指令;

- 云端平台:在云端部署框架,启用SSE协议服务,云端平台通过SSE长连接从网关获取边缘设备的实时数据,并推送指令给网关;

- 开发人员:在边缘网关本地使用框架的Stdio协议服务,本地调试边缘设备的MCP服务,快速定位问题。

落地价值:

- 纯TCP协议的低延迟特性,满足边缘设备的实时通信需求;

- 边缘云协同的MCP服务体系,实现了边缘设备与云端平台的实时数据交互;

- 轻量化的框架设计,适配边缘网关的低资源特性,无需高性能硬件支持。

六、性能优化策略

为了让框架在高并发、高吞吐的场景下保持高性能运行,可从异步IO调优、数据传输优化、连接管理、资源限制四个方面进行性能优化,提升框架的运行效率与资源利用率。

6.1 异步IO调优:事件循环与协程池管理

- 自定义事件循环:使用

uvloop替换Python原生的asyncio事件循环,uvloop基于C实现,性能比原生事件循环提升2-4倍,大幅提升异步IO的处理效率; - 协程池管理:针对CPU密集型的请求处理逻辑(如大模型推理、数据解析),使用

asyncio.ThreadPoolExecutor创建协程池,将CPU密集型任务提交到线程池处理,避免阻塞事件循环; - 事件循环复用:框架所有模块共享同一个事件循环,避免多个事件循环的资源竞争,提升框架的运行效率。

6.2 数据传输优化:二进制帧格式与压缩

- 自定义二进制帧格式:将StreamableHttpless协议的按行分割解析替换为自定义二进制帧格式,如

[数据长度][校验位][数据内容],提升数据传输的可靠性与解析效率; - 数据压缩:在数据传输前,使用gzip、snappy等压缩算法对请求与响应数据进行压缩,降低网络传输的带宽占用,提升传输效率;

- 二进制编码:使用Protobuf、MsgPack等二进制编码方式替换JSON、纯文本,降低数据体积,提升解析效率。

6.3 连接管理:长连接保活与连接池

- TCP长连接保活:为StreamableHttpless协议设置TCP保活参数,如

SO_KEEPALIVE,实现TCP长连接的保活检测,避免因网络波动导致的假死连接; - SSE心跳检测:在SSE协议的推送内容中添加心跳包(如

data: ping\n\n),客户端接收心跳包后反馈,实现SSE长连接的有效性检测,及时关闭无效连接; - 连接池管理:为客户端实现连接池管理,复用已建立的连接,避免频繁的TCP三次握手与四次挥手,提升连接效率。

6.4 资源限制:限流与内存管理

- 请求限流:为各协议服务添加请求限流机制,如基于令牌桶、漏桶算法,限制每秒的请求数,避免因大量请求导致的服务崩溃;

- 最大连接数限制:为StreamableHttpless、SSE协议服务设置最大连接数限制,当连接数达到阈值时,拒绝新的连接请求,保证服务的稳定性;

- 内存管理:优化上下文的存储方式,及时释放无效的上下文数据,避免因大量会话导致的内存泄漏;同时使用内存监控工具(如psutil)监控框架的内存占用,当内存占用达到阈值时,触发会话清理。

七、总结与展望

7.1 总结

本文提出的多协议融合MCP服务框架,通过协议与业务解耦的分层架构、异步非阻塞的核心处理模型、统一的上下文与生命周期管理,实现了Stdio、StreamableHttpless、SSE三种协议的无缝融合,解决了传统MCP框架单协议绑定、场景适配性差、开发维护成本高的痛点。

框架的核心价值在于:一次开发,多协议适配;单框架部署,全场景覆盖,既保留了各协议的原生特性,又保证了MCP协议的上下文核心能力,同时具备高度的可扩展性与前瞻性,可快速适配云原生、边缘计算、分布式系统的技术发展趋势。

在实际业务中,该框架可大幅提升MCP服务的开发效率、运行性能与场景适配能力,为MCP生态的规模化落地提供了通用的通信层解决方案。

7.2 展望

随着大模型、云原生、边缘计算的深度融合,MCP协议作为衔接模型、业务、终端的核心通信协议,其服务框架的发展将朝着全协议覆盖、全场景适配、全生态融合的方向发展。未来,本框架将继续优化与扩展:

- 全协议覆盖:新增WebSocket、gRPC、MQTT等主流协议,实现MCP服务的全协议支持;

- 多语言实现:基于Go、Rust等高性能语言实现框架的核心模块,进一步提升框架的运行性能,满足更高的并发需求;

- MCP生态融合:对接MCP协议的标准化生态,实现与其他MCP服务、工具的无缝集成,打造MCP协议的通用通信框架;

- 智能运维:集成AI运维能力,实现框架的智能监控、智能调优、智能故障排查,提升框架的运维自动化水平。

未来,该框架将成为MCP生态中多协议通信的核心底座,为大模型、物联网、边缘计算等领域的MCP服务落地提供强有力的技术支撑。

更多推荐

已为社区贡献302条内容

已为社区贡献302条内容

所有评论(0)